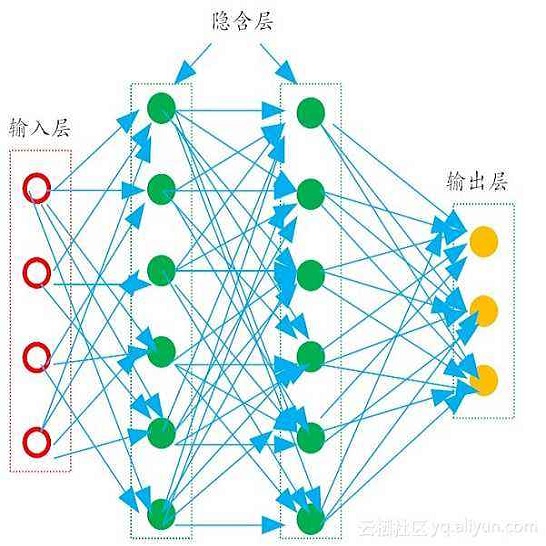

Neural networks (NNs) lack measures of "reliability" estimation that would enable reasoning over their predictions. Despite the vital importance, especially in areas of human well-being and health, state-of-the-art uncertainty estimation techniques are computationally expensive when applied to resource-constrained devices. We propose an efficient framework for predictive uncertainty estimation in NNs deployed on embedded edge systems with no need for fine-tuning or re-training strategies. To meet the energy and latency requirements of these embedded platforms the framework is built from the ground up to provide predictive uncertainty based only on one forward pass and a negligible amount of additional matrix multiplications with theoretically proven correctness. Our aim is to enable already trained deep learning models to generate uncertainty estimates on resource-limited devices at inference time focusing on classification tasks. This framework is founded on theoretical developments casting dropout training as approximate inference in Bayesian NNs. Our layerwise distribution approximation to the convolution layer cascades through the network, providing uncertainty estimates in one single run which ensures minimal overhead, especially compared with uncertainty techniques that require multiple forwards passes and an equal linear rise in energy and latency requirements making them unsuitable in practice. We demonstrate that it yields better performance and flexibility over previous work based on multilayer perceptrons to obtain uncertainty estimates. Our evaluation with mobile applications datasets shows that our approach not only obtains robust and accurate uncertainty estimations but also outperforms state-of-the-art methods in terms of systems performance, reducing energy consumption (up to 28x), keeping the memory overhead at a minimum while still improving accuracy (up to 16%).

翻译:神经网络(NNs)缺乏“可靠性”估算标准,无法对其预测进行推理。尽管这一点至关重要,特别是在人类福祉和健康领域,但最先进的不确定性估算技术在应用于资源限制的装置时计算成本很高。我们建议了一个高效框架,用于在嵌入边缘系统部署的不需微调或再培训战略的无核武器国家预测不确定性估算。为了满足这些嵌入平台的能量和潜伏要求,框架从地面上建立起来,仅根据一个远端通道提供预测性不确定性,并仅提供少量的准确度增增量,且在理论上证明准确无误。我们的目标是让经过训练的深度学习模型产生关于资源限制装置的不确定性估算,在推断时侧重于分类任务。我们提出一个高效框架,将辍学培训作为近似于微调或再培训战略的推导论。我们通过网络提供的层分布近于变压层的近度,在一次运行中提供不确定性估算,确保最低的间接费用,特别是相对于需要多次前向的准确度技术,但在理论上证明准确性增加数据正确无误的增量。 我们的目标是使以往的能量和升序应用中的数据能够显示我们以往的稳定性数据。