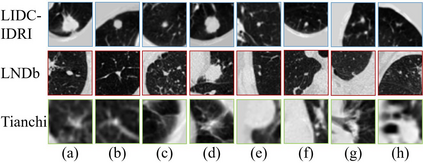

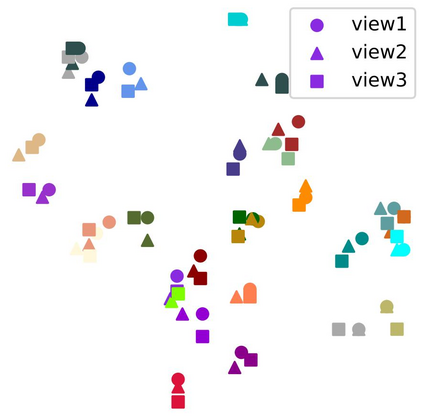

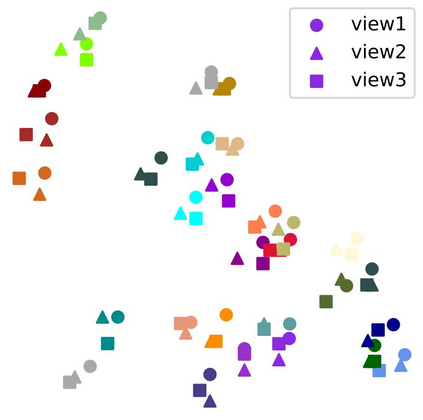

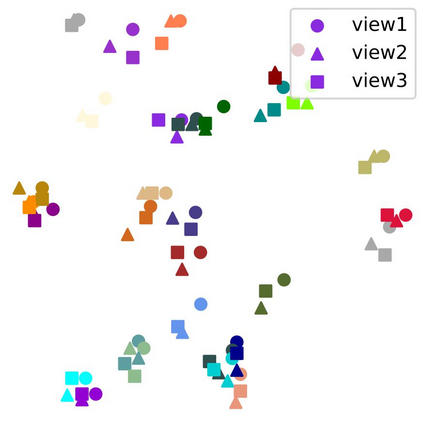

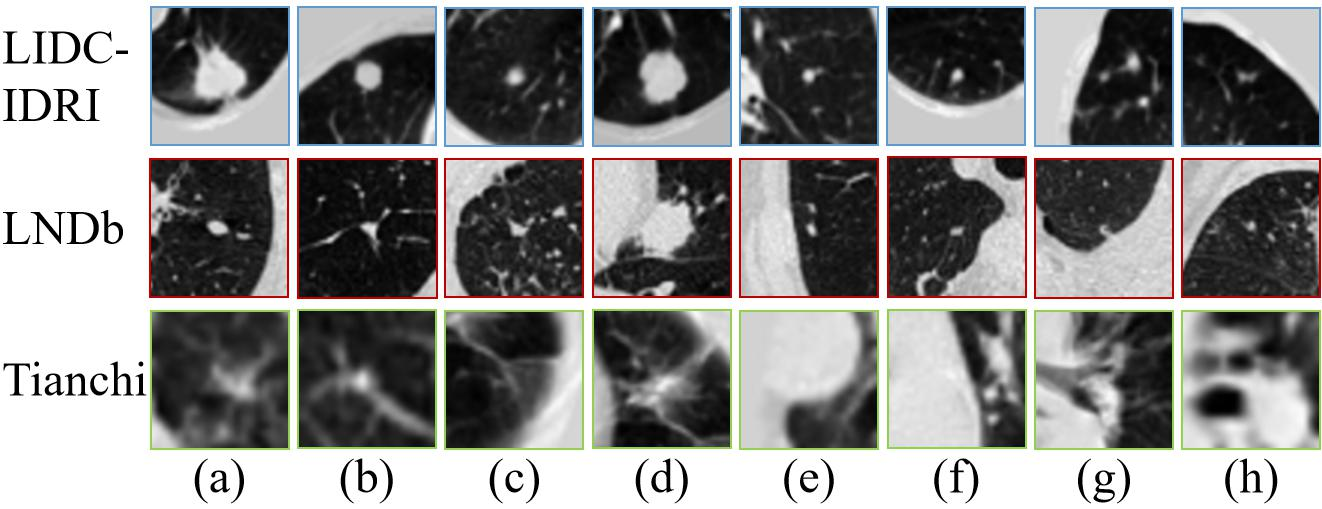

With the renaissance of deep learning, automatic diagnostic systems for computed tomography (CT) have achieved many successful applications. However, they are mostly attributed to careful expert annotations, which are often scarce in practice. This drives our interest to the unsupervised representation learning. Recent studies have shown that self-supervised learning is an effective approach for learning representations, but most of them rely on the empirical design of transformations and pretext tasks. To avoid the subjectivity associated with these methods, we propose the MVCNet, a novel unsupervised three dimensional (3D) representation learning method working in a transformation-free manner. We view each 3D lesion from different orientations to collect multiple two dimensional (2D) views. Then, an embedding function is learned by minimizing a contrastive loss so that the 2D views of the same 3D lesion are aggregated, and the 2D views of different lesions are separated. We evaluate the representations by training a simple classification head upon the embedding layer. Experimental results show that MVCNet achieves state-of-the-art accuracies on the LIDC-IDRI (89.55%), LNDb (77.69%) and TianChi (79.96%) datasets for unsupervised representation learning. When fine-tuned on 10% of the labeled data, the accuracies are comparable to the supervised learning model (89.46% vs. 85.03%, 73.85% vs. 73.44%, 83.56% vs. 83.34% on the three datasets, respectively), indicating the superiority of MVCNet in learning representations with limited annotations. Code is released at: https://github.com/penghuazhai/MVCNet.

翻译:随着深层学习的复兴,计算断层摄影(CT)的自动诊断系统已经取得了许多成功的应用。然而,它们大多归因于谨慎的专家说明,而这种说明在实践中往往很少。这促使我们对未经监督的代表学习感兴趣。最近的研究表明,自我监督的学习是学习表现的一种有效方法,但大多数这种学习依靠的是改造和托辞任务的经验设计。为了避免与这些方法相关的主观性,我们提议采用MVCNet,这是一个新的、不受监督的三维(3D)代表学习方法,以无变方式运作。我们从不同方向看每3D分解,以收集多维(2D)观点。然后,通过尽量减少对比性损失来学习一个嵌入功能,从而将同一3D分辨的2D观点加以汇总,而不同腐蚀性任务则分开。我们通过在嵌入层上训练一个简单的分类头来评价这些表达方式。MVCNet的实验结果显示,在LDC-IDRI(89) 3-69(8955 %) 和 RAND(10D) 学习数据中,L79% 的缩缩缩化数据显示为O。