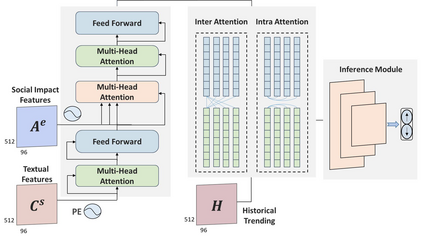

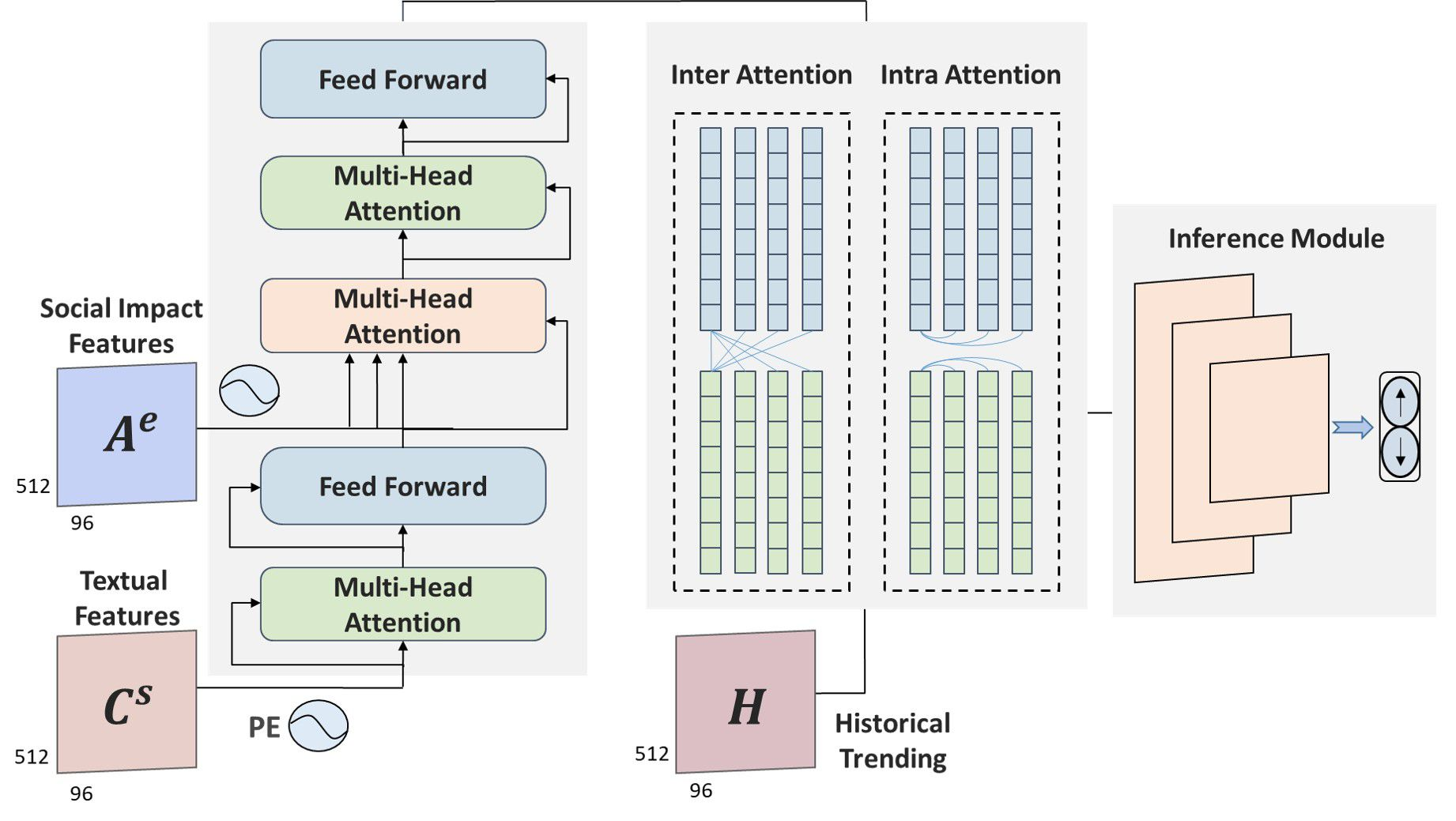

Stock prices move as piece-wise trending fluctuation rather than a purely random walk. Traditionally, the prediction of future stock movements is based on the historical trading record. Nowadays, with the development of social media, many active participants in the market choose to publicize their strategies, which provides a window to glimpse over the whole market's attitude towards future movements by extracting the semantics behind social media. However, social media contains conflicting information and cannot replace historical records completely. In this work, we propose a multi-modality attention network to reduce conflicts and integrate semantic and numeric features to predict future stock movements comprehensively. Specifically, we first extract semantic information from social media and estimate their credibility based on posters' identity and public reputation. Then we incorporate the semantic from online posts and numeric features from historical records to make the trading strategy. Experimental results show that our approach outperforms previous methods by a significant margin in both prediction accuracy (61.20\%) and trading profits (9.13\%). It demonstrates that our method improves the performance of stock movements prediction and informs future research on multi-modality fusion towards stock prediction.

翻译:股价作为零星趋势波动而不是纯粹随机的波动而移动。 传统上,对未来股票流动的预测是基于历史交易记录。 如今,随着社交媒体的发展,许多活跃的市场参与者选择了宣传其战略,这提供了一个窗口,通过提取社交媒体背后的语义来观察整个市场对未来流动的态度。然而,社交媒体含有相互矛盾的信息,不能完全取代历史记录。在这项工作中,我们提议建立一个多模式关注网络,以减少冲突,整合语义和数字特征,以全面预测未来股票流动。具体地说,我们首先从社交媒体提取语义信息,并根据海报的身份和公共声誉来估计其可信度。然后,我们从在线文章和历史记录中引入语义和数字特征,以制定交易战略。实验结果表明,我们的方法在预测准确性(61.20 ⁇ )和贸易利润(9.13 ⁇ )方面都大大优于以往的方法。 它表明,我们的方法可以改进股票流动预测的绩效,并告知未来关于多模式融合对股票预测的研究。