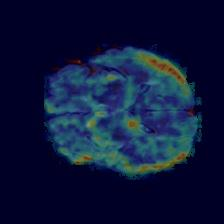

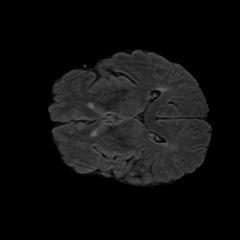

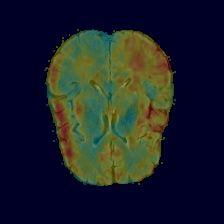

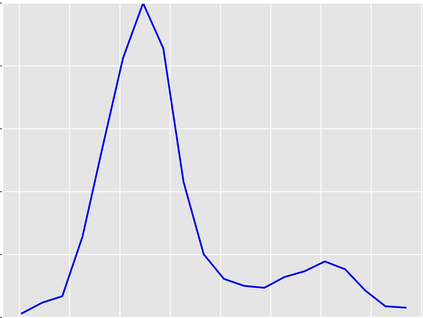

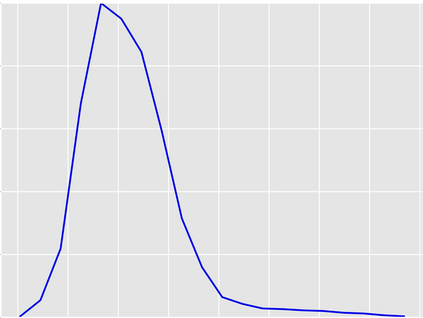

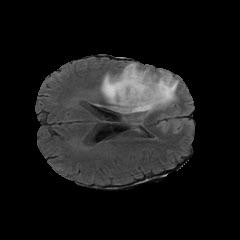

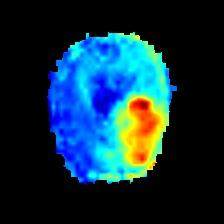

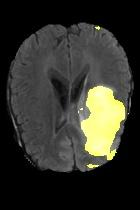

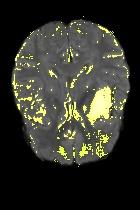

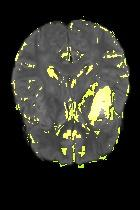

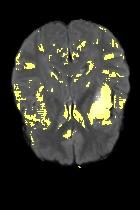

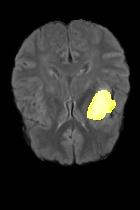

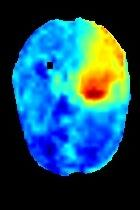

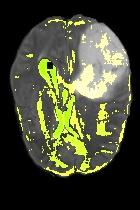

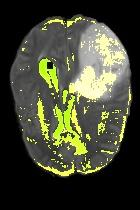

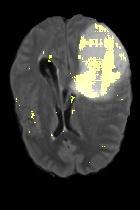

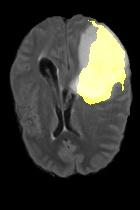

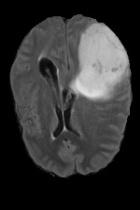

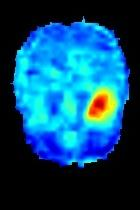

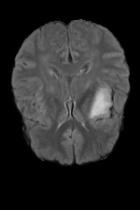

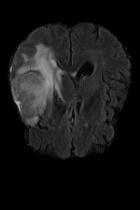

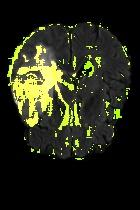

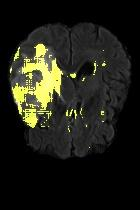

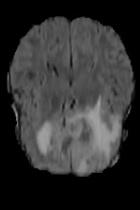

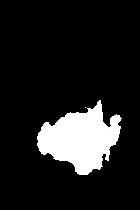

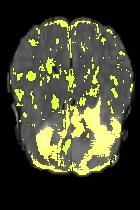

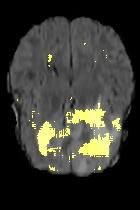

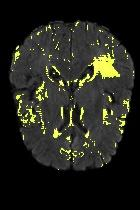

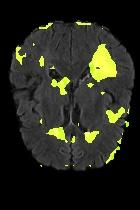

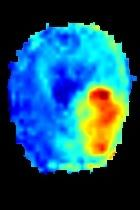

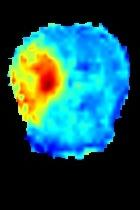

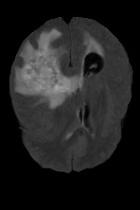

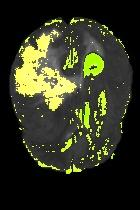

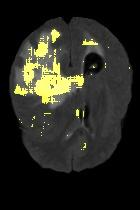

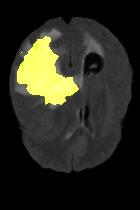

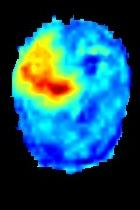

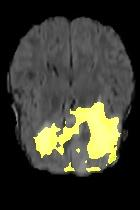

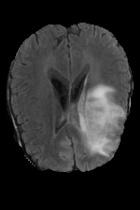

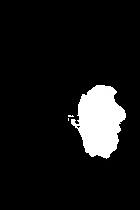

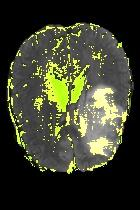

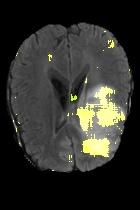

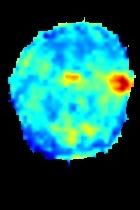

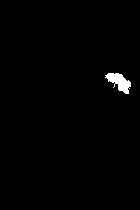

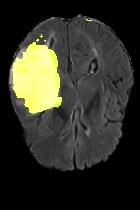

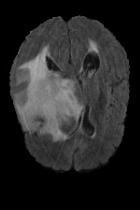

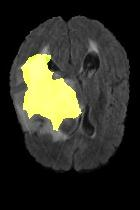

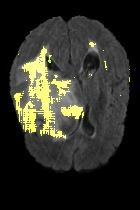

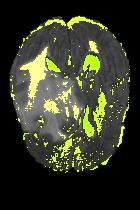

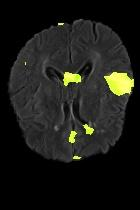

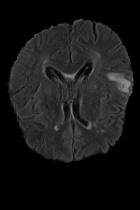

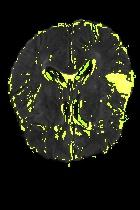

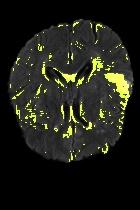

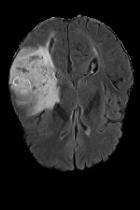

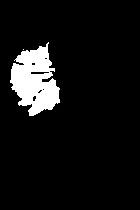

Current unsupervised anomaly localization approaches rely on generative models to learn the distribution of normal images, which is later used to identify potential anomalous regions derived from errors on the reconstructed images. However, a main limitation of nearly all prior literature is the need of employing anomalous images to set a class-specific threshold to locate the anomalies. This limits their usability in realistic scenarios, where only normal data is typically accessible. Despite this major drawback, only a handful of works have addressed this limitation, by integrating supervision on attention maps during training. In this work, we propose a novel formulation that does not require accessing images with abnormalities to define the threshold. Furthermore, and in contrast to very recent work, the proposed constraint is formulated in a more principled manner, leveraging well-known knowledge in constrained optimization. In particular, the equality constraint on the attention maps in prior work is replaced by an inequality constraint, which allows more flexibility. In addition, to address the limitations of penalty-based functions we employ an extension of the popular log-barrier methods to handle the constraint. Comprehensive experiments on the popular BRATS'19 dataset demonstrate that the proposed approach substantially outperforms relevant literature, establishing new state-of-the-art results for unsupervised lesion segmentation.

翻译:目前未受监督的异常本地化方法依靠基因模型来了解正常图像的分布,这些模型后来被用于确定从重建图像错误中得出的潜在异常区域。然而,几乎所有先前文献的主要局限性是,需要使用异常图像来设定一个特定等级的阈值以定位异常。这限制了其在现实情景中的可用性,在现实情景中,只有通常能获取正常数据。尽管存在这一重大缺陷,但只有少数作品通过在培训中整合对关注地图的监督,解决了这一局限性。在这项工作中,我们提议了一种新颖的提法,不要求使用异常图像来界定阈值。此外,与最近的工作相反,拟议的限制是以更加有原则的方式拟订的,在限制优化时利用众所周知的知识。特别是,先前工作中对关注地图的平等性制约被一种不平等性制约所取代,这允许更大的灵活性。此外,为了解决基于惩罚的功能的局限性,我们采用了流行的日志障碍方法来应对这一制约。我们建议对流行的BRATS'19数据设置进行综合实验,这与最近的工作不同,因此,拟议的限制是以更加有原则的方式提出了限制,即拟议的方法大大地超越了相关的分段结果。