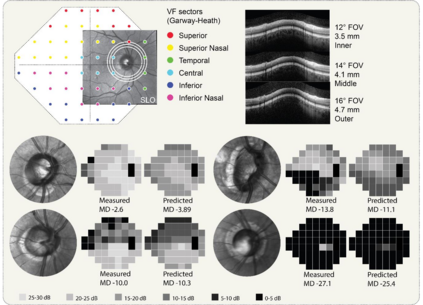

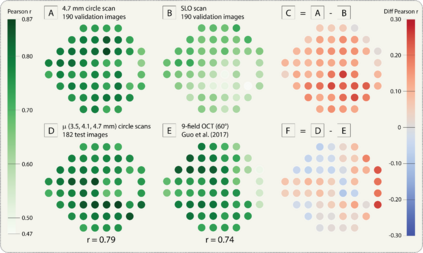

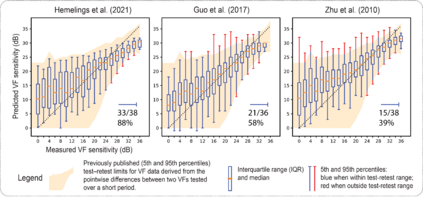

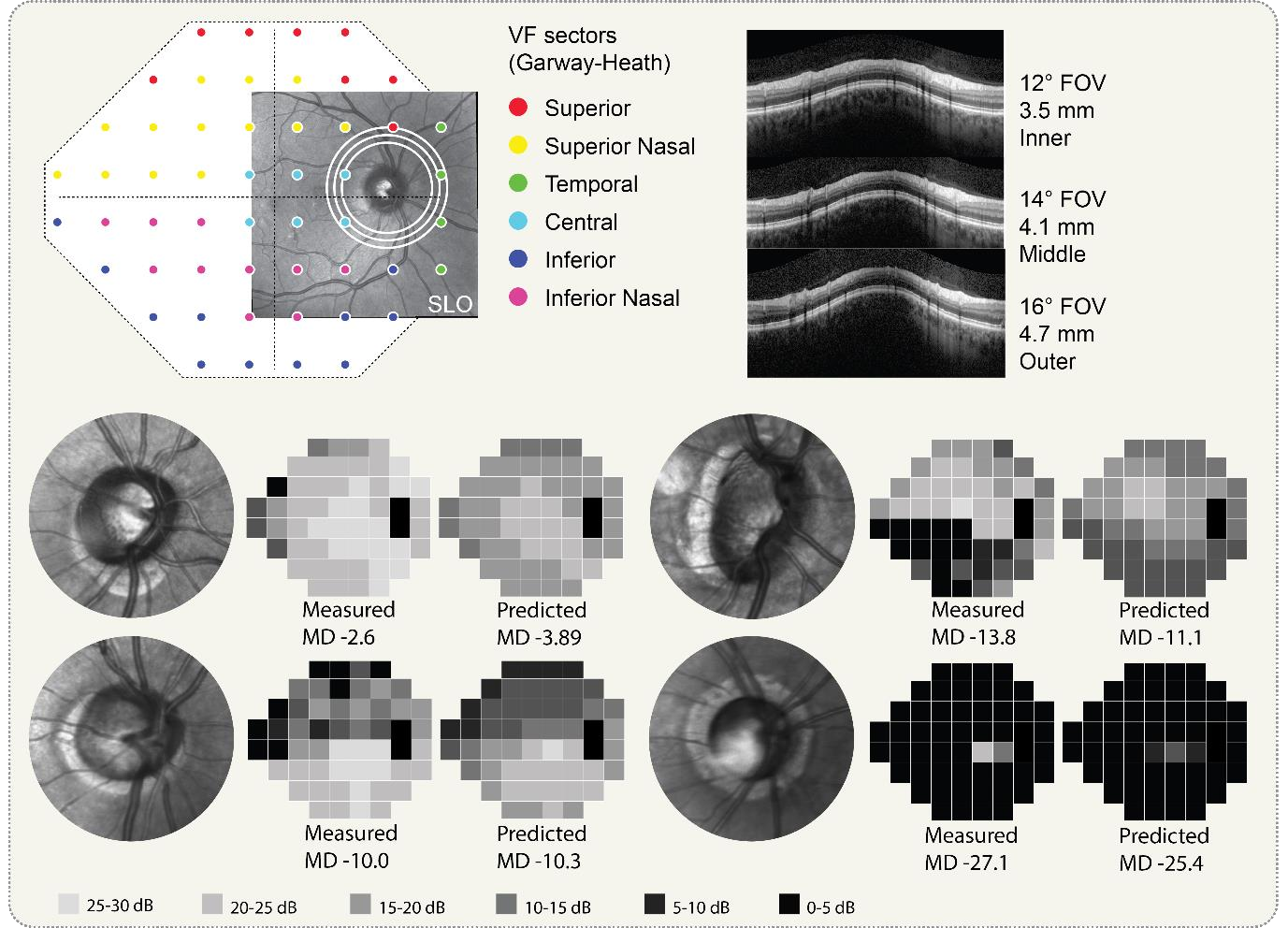

Background/Aims: Standard Automated Perimetry (SAP) is the gold standard to monitor visual field (VF) loss in glaucoma management, but is prone to intra-subject variability. We developed and validated a deep learning (DL) regression model that estimates pointwise and overall VF loss from unsegmented optical coherence tomography (OCT) scans. Methods: Eight DL regression models were trained with various retinal imaging modalities: circumpapillary OCT at 3.5mm, 4.1mm, 4.7mm diameter, and scanning laser ophthalmoscopy (SLO) en face images to estimate mean deviation (MD) and 52 threshold values. This retrospective study used data from patients who underwent a complete glaucoma examination, including a reliable Humphrey Field Analyzer (HFA) 24-2 SITA Standard VF exam and a SPECTRALIS OCT scan using the Glaucoma Module Premium Edition. Results: A total of 1378 matched OCT-VF pairs of 496 patients (863 eyes) were included for training and evaluation of the DL models. Average sample MD was -7.53dB (from -33.8dB to +2.0dB). For 52 VF threshold values estimation, the circumpapillary OCT scan with the largest radius (4.7mm) achieved the best performance among all individual models (Pearson r=0.77, 95% CI=[0.72-0.82]). For MD, prediction averaging of OCT-trained models (3.5mm, 4.1mm, 4.7mm) resulted in a Pearson r of 0.78 [0.73-0.83] on the validation set and comparable performance on the test set (Pearson r=0.79 [0.75-0.82]). Conclusion: DL on unsegmented OCT scans accurately predicts pointwise and mean deviation of 24-2 VF in glaucoma patients. Automated VF from unsegmented OCT could be a solution for patients unable to produce reliable perimetry results.

翻译:背景/ Aims: 标准自动 Perism(SAP) 是用于监测青光眼管理中视觉场(VF)损失的黄金标准, 但容易发生受体内变异。 我们开发并验证了一个深度学习(DL)回归模型,该模型对未分解的光学一致性透析(OCT)扫描过程进行了点度和总体VF损失进行估计。 方法: 8个DL回归模型经过了各种视网膜成像模式的培训: 在3.5毫米、4.1毫米、4.7毫米直径和扫描眼视镜检查(SLO), 以估计平均偏差(MD)和52门槛值。 本次回顾研究使用了接受完整光谱光学测试的病人的数据,包括可靠的汉弗莱(HF)24-2SITA标准VFMMMMMMMMMMMMMM 和SPCT扫描(使用GLT) 模块中总共1378和496个病人的OCT-MDF 直径(863 眼睛) 的直径直径直径直径透,用于对 O.53; 最精确的OMTV2的直径测试模型无法。