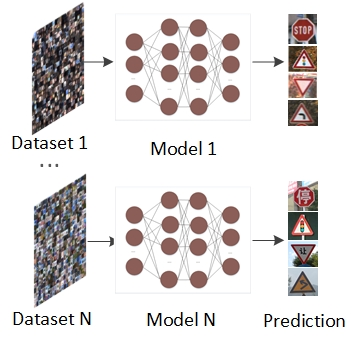

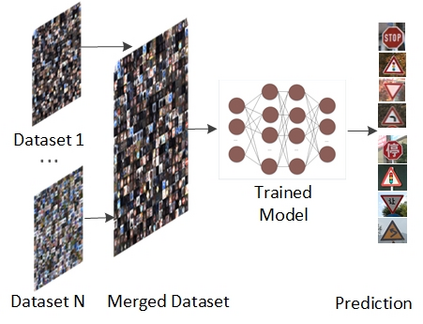

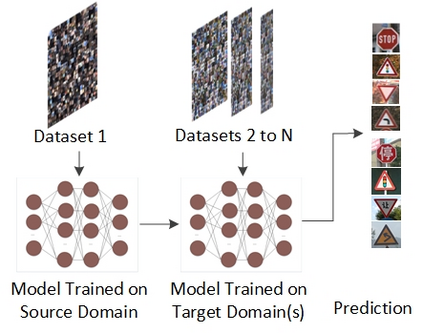

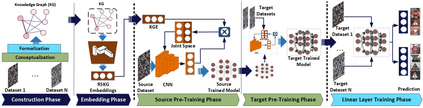

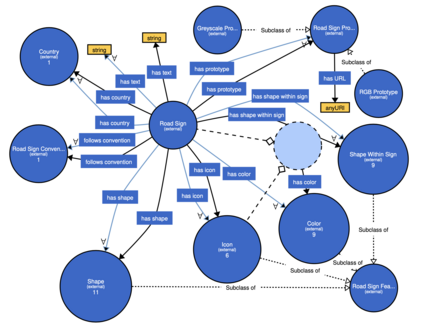

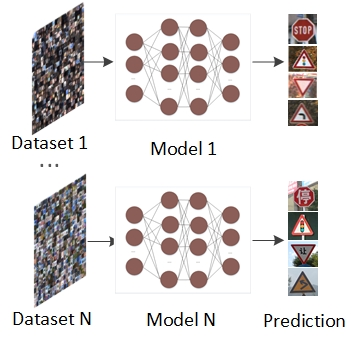

Deep learning techniques achieve high accuracy in computer vision tasks. However, their accuracy suffers considerably when they face a domain change, i.e., as soon as they are used in a domain that differs from their training domain. For example, a road sign recognition model trained to recognize road signs in Germany performs poorly in countries with different road sign standards like China. We propose ConTraKG, a neuro-symbolic approach that enables cross-domain transfer learning based on prior knowledge about the domain or context. A knowledge graph serves as a medium for encoding such prior knowledge, which is then transformed into a dense vector representation via embedding methods. Using a five-phase training pipeline, we train the deep neural network to adjust its visual embedding space according to the domain-invariant embedding space of the knowledge graph based on a contrastive loss function. This allows the neural network to incorporate training data from different target domains that are already represented in the knowledge graph. We conduct a series of empirical evaluations to determine the accuracy of our approach. The results show that ConTraKG is significantly more accurate than the conventional approach for dealing with domain changes. In a transfer learning setup, where the network is trained on both domains, ConTraKG achieves 21% higher accuracy when tested on the source domain and 15% when tested on the target domain compared to the standard approach. Moreover, with only 10% of the target data for training, it achieves the same accuracy as the cross-entropy-based model trained on the full target data.

翻译:深层学习技术在计算机视野任务中达到高度精准性。 但是,当它们面临域变时,它们的准确性会受到很大的影响,即一旦它们被用于与其培训领域不同的领域。例如,在像中国这样的具有不同路标标准的国家中,在德国受过识别路标标志训练的公路标志识别模型表现不佳。我们提议ConTraKG,这是一种神经-共振法,这种神经-共振法能够根据对域或上下文的先前知识进行跨场传输学习。一个知识图表作为将先前的知识编码成编码的媒介,然后通过嵌入方法转换成密集矢量表示。我们利用五阶段培训管道培训深层神经网络,以便根据以对比性损失功能为基础的知识图的域异性嵌入空间调整其视觉嵌入空间。我们建议神经网络将来自不同目标领域的培训数据包含在知识图中已经体现的同一领域。我们进行一系列经验评估,以确定我们的方法的准确性。结果显示,CTRG与常规方法相比,在处理域变换域方法时,我们训练的深度神经网络比目标域域域域里,在测试了整个域域域上,测试了数据到21。 测试了数据源。