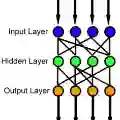

This work proposes a new way of combining independently trained classifiers over space and time. Combination over space means that the outputs of spatially distributed classifiers are aggregated. Combination over time means that the classifiers respond to streaming data during testing and continue to improve their performance even during this phase. By doing so, the proposed architecture is able to improve prediction performance over time with unlabeled data. Inspired by social learning algorithms, which require prior knowledge of the observations distribution, we propose a Social Machine Learning (SML) paradigm that is able to exploit the imperfect models generated during the learning phase. We show that this strategy results in consistent learning with high probability, and it yields a robust structure against poorly trained classifiers. Simulations with an ensemble of feedforward neural networks are provided to illustrate the theoretical results.

翻译:这项工作提出了一种在时间和时间上将独立培训的分类师结合起来的新方法。 空间合并意味着空间分布分类师的输出是综合的。 随着时间的推移,合并意味着分类师在测试期间对流数据作出反应,并继续提高他们的性能。 通过这样做,拟议的结构能够用未贴标签的数据随着时间的推移改善预测性能。 在社会学习算法的启发下,我们提出了一种社会机器学习模式(SML),这需要事先了解观测分布情况。 我们提议了一种社会机器学习模式,能够利用学习阶段产生的不完善模型。我们表明,这一战略的结果是,以很高的概率进行一致学习,并产生一种强有力的结构来对付训练不力的分类师。 提供了带有进料神经网络组合的模拟,以说明理论结果。