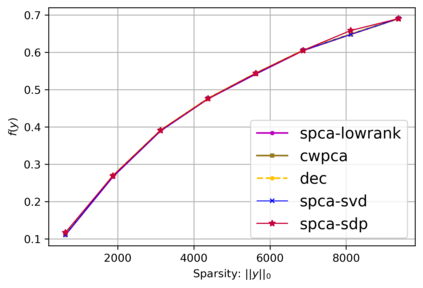

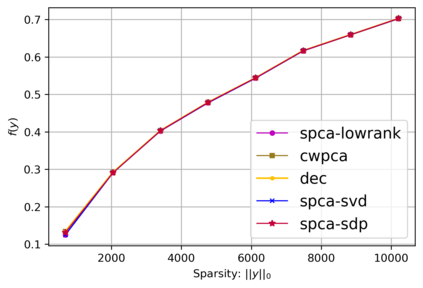

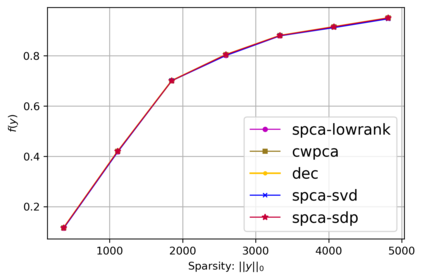

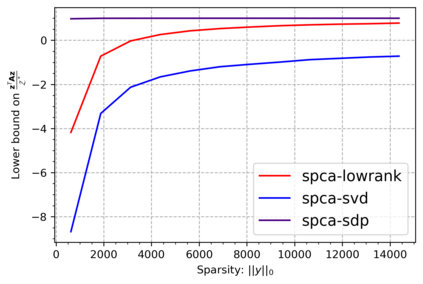

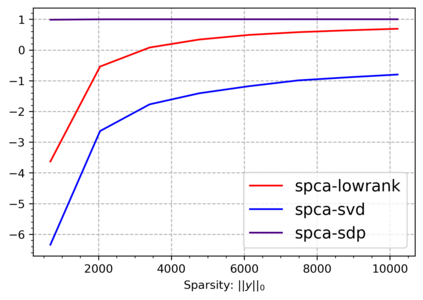

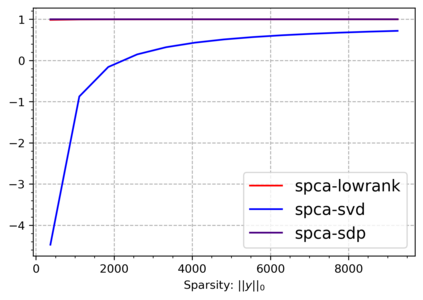

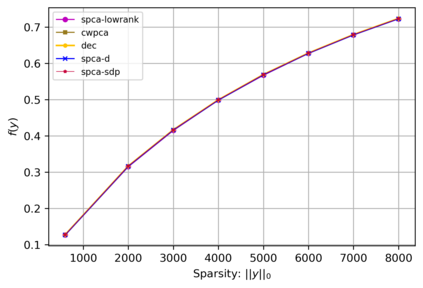

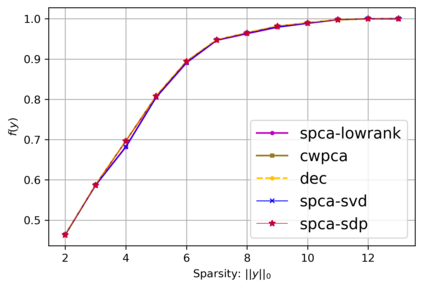

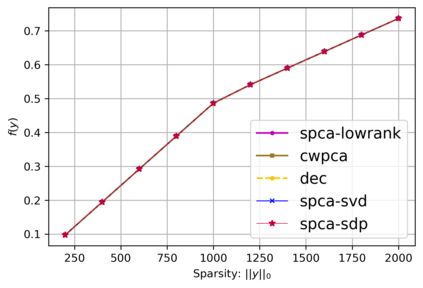

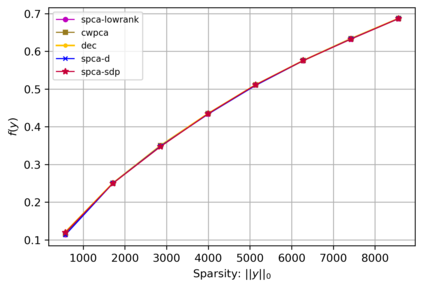

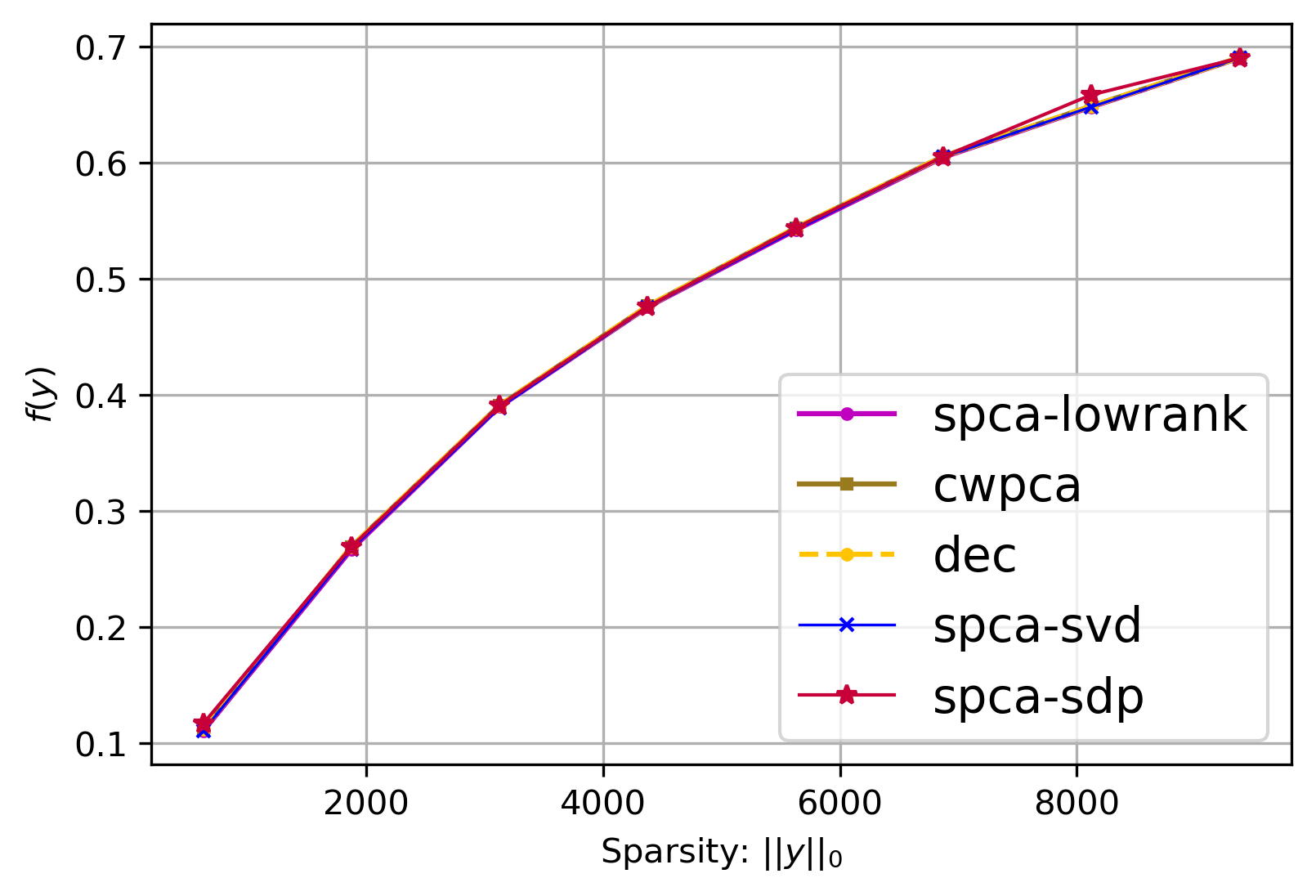

Principal component analysis (PCA) is a widely used dimension reduction technique in machine learning and multivariate statistics. To improve the interpretability of PCA, various approaches to obtain sparse principal direction loadings have been proposed, which are termed Sparse Principal Component Analysis (SPCA). In this paper, we present thresholding as a provably accurate, polynomial time, approximation algorithm for the SPCA problem, without imposing any restrictive assumptions on the input covariance matrix. Our first thresholding algorithm using the Singular Value Decomposition is conceptually simple; is faster than current state-of-the-art; and performs well in practice. On the negative side, our (novel) theoretical bounds do not accurately predict the strong practical performance of this approach. The second algorithm solves a well-known semidefinite programming relaxation and then uses a novel, two step, deterministic thresholding scheme to compute a sparse principal vector. It works very well in practice and, remarkably, this solid practical performance is accurately predicted by our theoretical bounds, which bridge the theory-practice gap better than current state-of-the-art.

翻译:主要组成部分分析(PCA)是机器学习和多变量统计中广泛使用的减少维度技术。为了改进五氯苯甲醚的解释性,提出了获得稀少的主要方向负荷的各种办法,称为“粗化主元构件分析 ” (SPCA) 。在本文中,我们提出阈值,认为是精确、多元时间、SPCA问题的近似算法,对输入共变量矩阵不作任何限制性假设。我们使用“单值分解”的第一个阈值算法在概念上是简单的;比目前工艺水平更快;并在实践中表现良好。在负面方面,我们的(新颖)理论界限并不准确预测这一方法的强劲实际表现。第二种算法解决了众所周知的半确定性半确定性编程松动,然后使用新颖的、两步、决定性的阈值计法来计算稀薄的主要矢量。在实践上非常有效,而且值得注意的是,我们的理论界限准确地预测了这种坚实的实际表现,这弥补了理论实践差距比目前工艺水平要好。