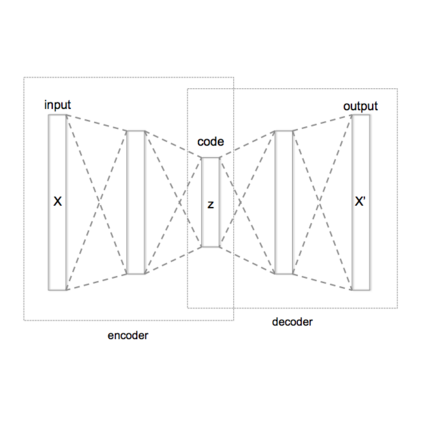

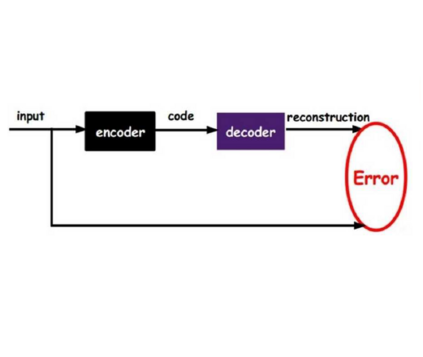

Aiming at exploiting the rich information in user behaviour sequences, sequential recommendation has been widely adopted in real-world recommender systems. However, current methods suffer from the following issues: 1) sparsity of user-item interactions, 2) uncertainty of sequential records, 3) long-tail items. In this paper, we propose to incorporate contrastive learning into the framework of Variational AutoEncoders to address these challenges simultaneously. Firstly, we introduce ContrastELBO, a novel training objective that extends the conventional single-view ELBO to two-view case and theoretically builds a connection between VAE and contrastive learning from a two-view perspective. Then we propose Contrastive Variational AutoEncoder (ContrastVAE in short), a two-branched VAE model with contrastive regularization as an embodiment of ContrastELBO for sequential recommendation. We further introduce two simple yet effective augmentation strategies named model augmentation and variational augmentation to create a second view of a sequence and thus making contrastive learning possible. Experiments on four benchmark datasets demonstrate the effectiveness of ContrastVAE and the proposed augmentation methods. Codes are available at https://github.com/YuWang-1024/ContrastVAE

翻译:为了利用用户行为序列中的丰富信息,在现实世界推荐人系统中广泛采纳了顺序建议,但目前的方法存在下列问题:(1) 用户-项目互动的广度,(2) 顺序记录的不确定性,(3) 长序项目。在本文件中,我们提议将对比式学习纳入变化式自动编码器框架,以同时应对这些挑战。首先,我们引入了一个新颖的培训目标,即将常规的单视ELBO(单视ELBO)扩展为双视案例,并在理论上建立了VAE与从两观角度的对比性学习之间的联系。然后,我们提出了对比性变异自动编码器(简称ConstrVAE),一种双错式VAE模式,将对比式自动编码作为对比式自动编码的体现,以同时应对这些挑战。我们还引入了两个简单而有效的增强战略,称为模式增强和变异性增强,以创造对序列的第二个观点,从而有可能进行对比性学习。关于四个基准数据集的实验展示了 ContrastVAE(简称)和拟议的增强式方法的有效性。