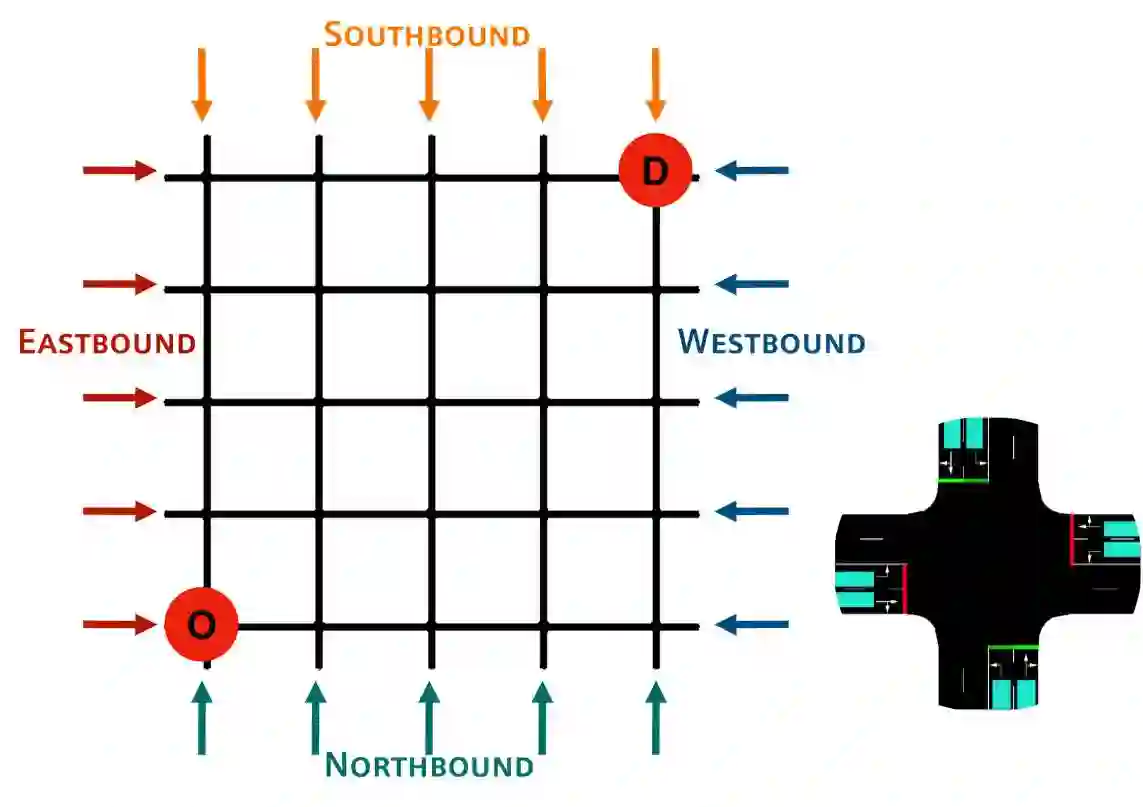

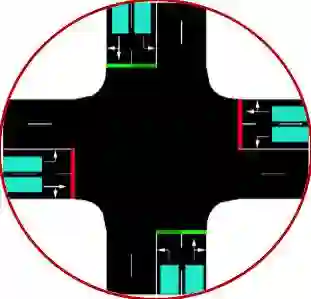

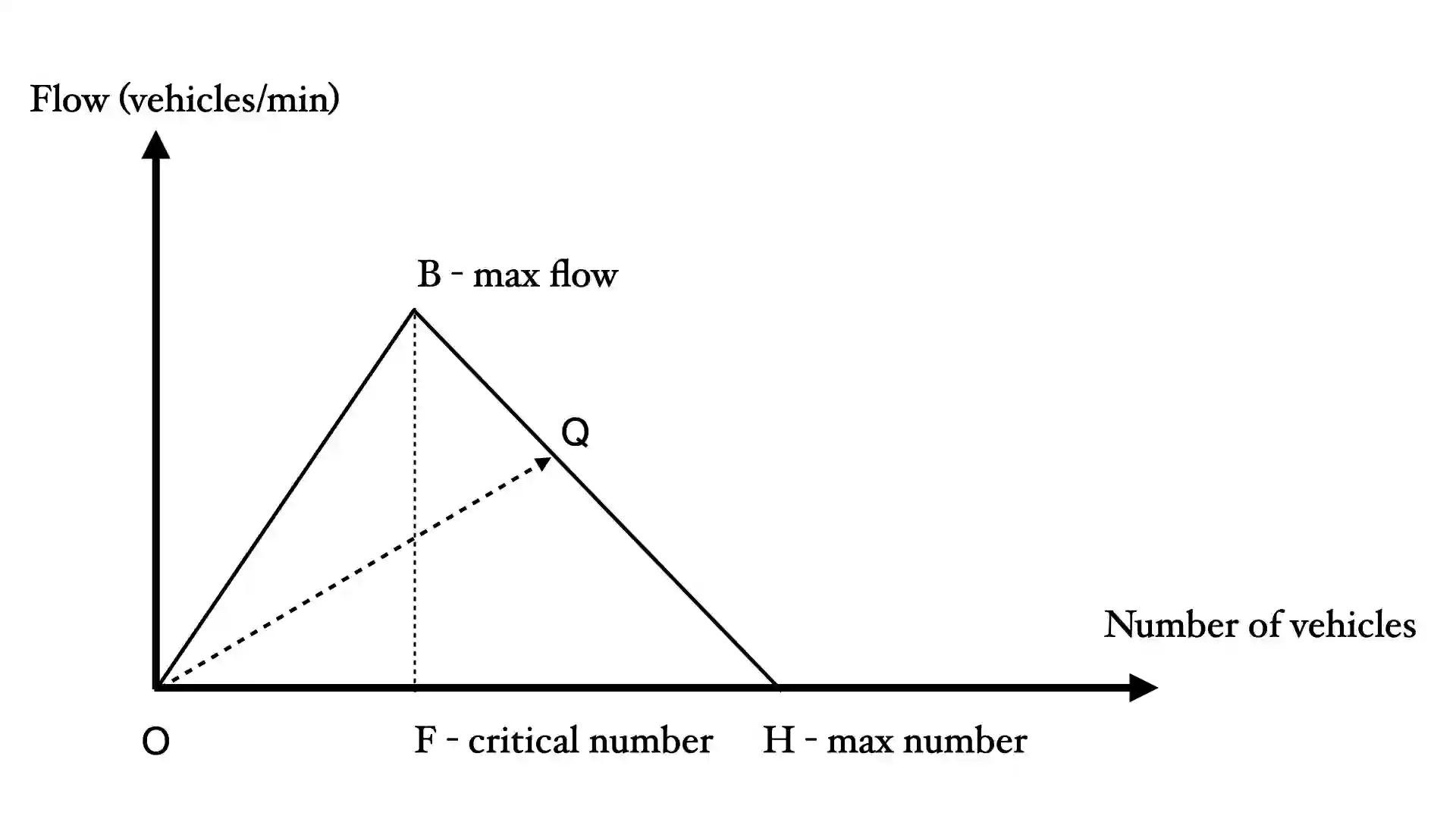

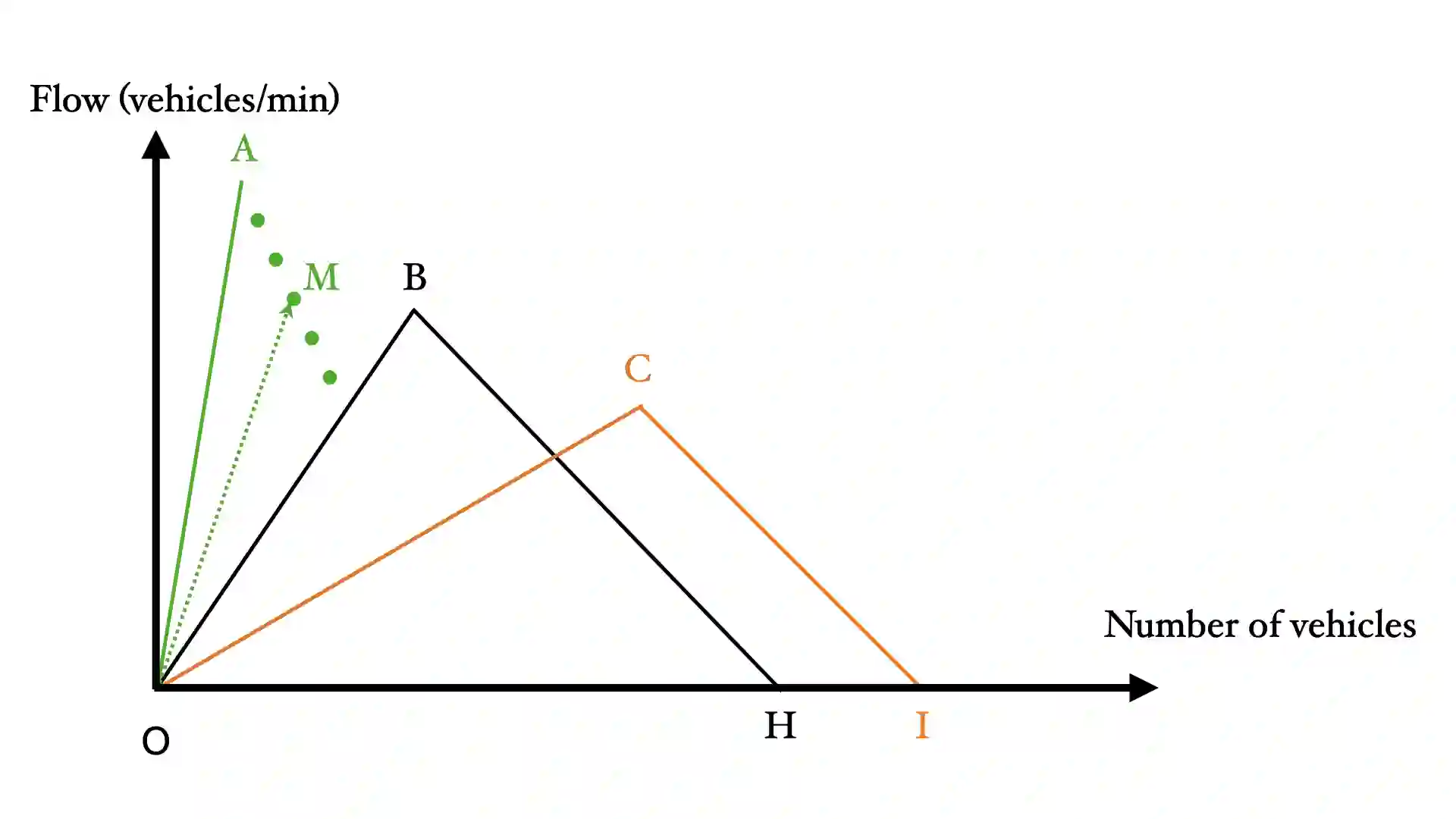

Emergency vehicles (EMVs) play a critical role in a city's response to time-critical events such as medical emergencies and fire outbreaks. The existing approaches to reduce EMV travel time employ route optimization and traffic signal pre-emption without accounting for the coupling between route these two subproblems. As a result, the planned route often becomes suboptimal. In addition, these approaches also do not focus on minimizing disruption to the overall traffic flow. To address these issues, we introduce EMVLight in this paper. This is a decentralized reinforcement learning (RL) framework for simultaneous dynamic routing and traffic signal control. EMVLight extends Dijkstra's algorithm to efficiently update the optimal route for an EMV in real-time as it travels through the traffic network. Consequently, the decentralized RL agents learn network-level cooperative traffic signal phase strategies that reduce EMV travel time and the average travel time of non-EMVs in the network. We have carried out comprehensive experiments with synthetic and real-world maps to demonstrate this benefit. Our results show that EMVLight outperforms benchmark transportation engineering techniques as well as existing RL-based traffic signal control methods.

翻译:应急车辆(EMV)在城市应对医疗紧急事件和火灾爆发等时间紧迫事件方面发挥着关键作用。现有的降低EMV旅行时间的方法采用路线优化和交通信号预设,而没有考虑到这两个子问题之间的交错。因此,计划路线往往不尽善尽美。此外,这些方法也并不侧重于最大限度地减少对整个交通流量的干扰。为了解决这些问题,我们在本文件中引入了EMVLight。这是一个分散化的强化学习框架,用于同时进行动态路由和交通信号控制。EMVLight扩展了Dijkstra的算法,以便有效更新通过交通网络实时运行的EMV的最佳路线。因此,分散式RL代理商学习网络一级的交通信号阶段合作战略,以减少EMV旅行时间和网络中非EMV的平均旅行时间。我们用合成地图和现实世界地图进行了全面实验,以证明这一益处。我们的结果表明,EMVLight超越了现有交通信号控制方法的基准运输工程技术。