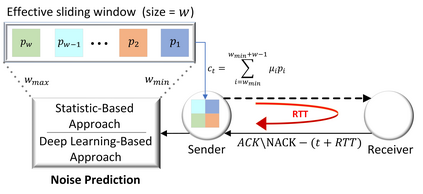

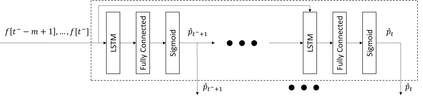

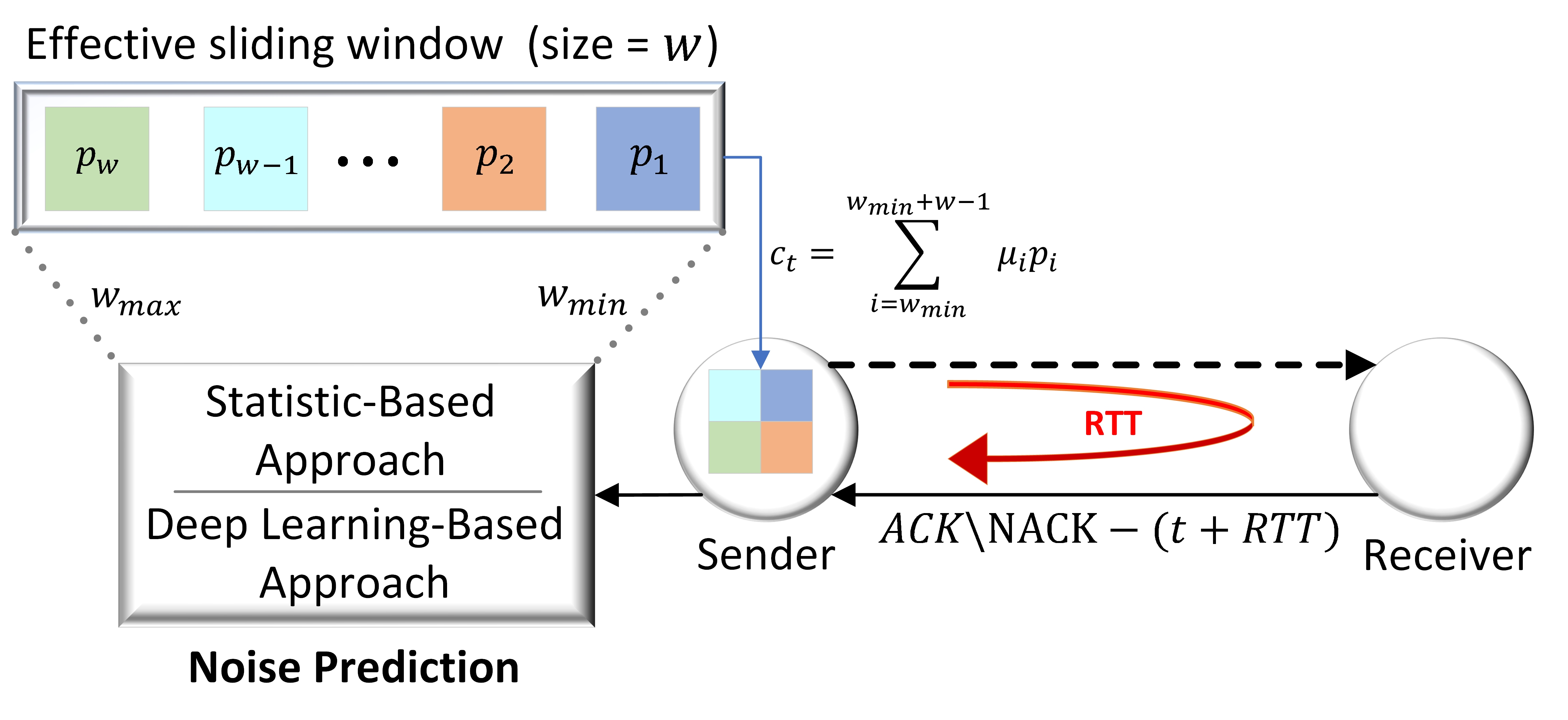

Closing the gap between high data rates and low delay in real-time streaming applications is a major challenge in advanced communication systems. While adaptive network coding schemes have the potential of balancing rate and delay in real-time, they often rely on prediction of the channel behavior. In practice, such prediction is based on delayed feedback, making it difficult to acquire causally, particularly when the underlying channel model is unknown. In this work, we propose a deep learning-based noise prediction (DeepNP) algorithm, which augments the recently proposed adaptive and causal random linear network coding scheme with a dedicated deep neural network, that learns to carry out noise prediction from data. This neural augmentation is utilized to maximize the throughput while minimizing in-order delivery delay of the network coding scheme, and operate in a channel-model-agnostic manner. We numerically show that performance can dramatically increase by the learned prediction of the channel noise rate. In particular, we demonstrate that DeepNP gains up to a factor of four in mean and maximum delay and a factor two in throughput compared with statistic-based network coding approaches.

翻译:在先进通信系统中,一个重大挑战是缩小高数据率和低实时流应用延迟之间的差距。虽然适应性网络编码计划具有实时平衡率和延迟率的潜力,但它们往往依赖对频道行为的预测。在实践中,这种预测是基于延迟反馈的,使得很难从因果上获得,特别是在基本的频道模型未知的情况下。在这项工作中,我们建议采用基于深层次学习的噪音预测(DeepNP)算法,该算法将最近提议的适应性和因果随机线性网络编码计划与专门的深神经网络相加,该算法将学会从数据中进行噪音预测。这种神经扩增法用于最大限度地增加吞吐量,同时尽量减少网络编码计划的顺序交付延误,并以频道模型-无序方式运作。我们从数字上表明,通过对频道噪音率的知情预测,业绩可以大幅提高。特别是,我们表明,DeepNP在平均和最大延迟率方面增加了四个系数,在与基于统计数据的网络编码方法相比,吞吐量方面增加了两个系数。