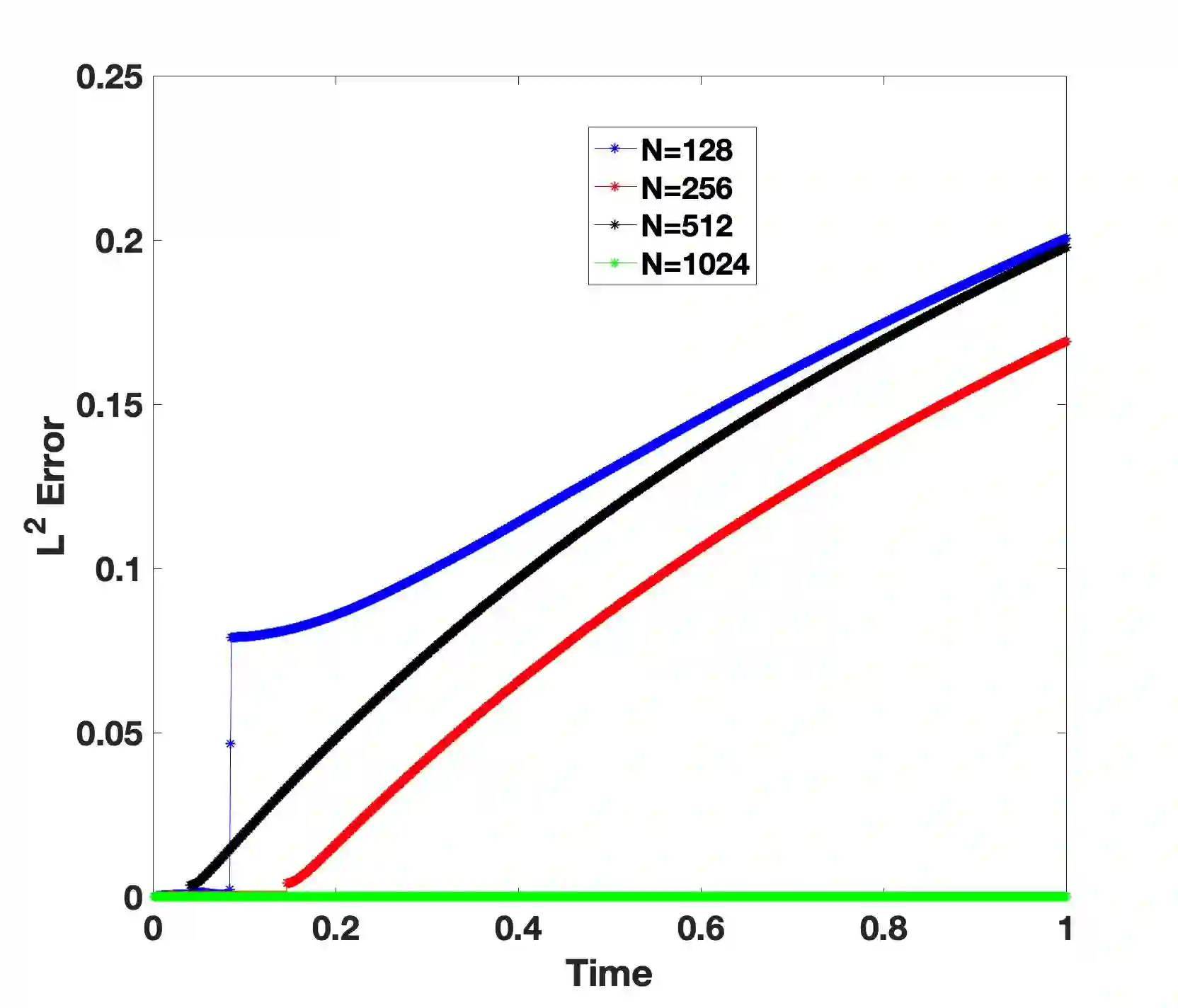

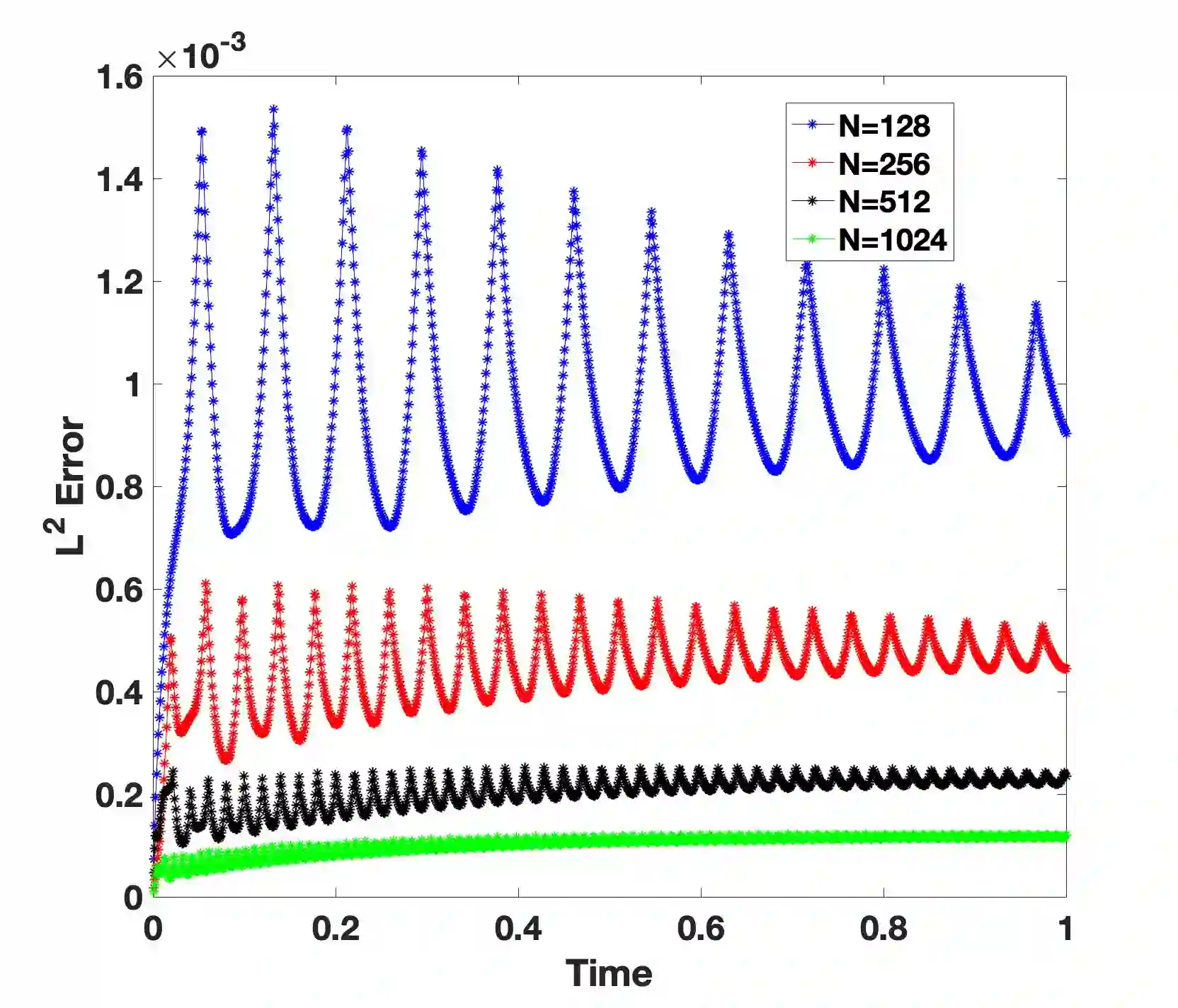

We propose a new Lagrange multiplier approach to construct positivity preserving schemes for parabolic type equations. The new approach is based on expanding a generic spatial discretization, which is not necessarily positivity preserving, by introducing a space-time Lagrange multiplier coupled with Karush-Kuhn-Tucker (KKT) conditions to preserve positivity. The key for an efficient and accurate time discretization of the expanded system is to adopt an operator-splitting or predictor-corrector approach in such a way that (i) the correction step can be implemented with negligible cost, and (ii) it preserves the order of schemes at the prediction step. We establish some stability results under a general setting, and carry out error estimates for first-order versions of our approach and linear parabolic equation. We also present ample numerical results to validate the new approach.

翻译:我们提出一种新的拉格朗乘数法,以构建对抛物线型方程式的正负保护计划,新办法的基础是扩大一般空间分化,而这种分化不一定是积极性保留,方法是采用时空拉格朗乘数,加上Karush-Kuhn-Tucker(KKT)条件,以保持正负性,使扩大的系统有效、准确的时间分解的关键是采取一种操作员分解或预测者-更正办法,其方式是(一) 以微不足道的费用执行纠正步骤,和(二) 在预测步骤保持计划顺序,我们在一般设置下确定一些稳定结果,并对我们办法的第一阶版本和线性抛物线方程式进行误差估计,我们还提出大量的数字结果,以验证新的办法。