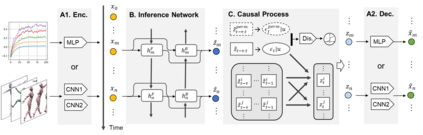

Our goal is to recover time-delayed latent causal variables and identify their relations from measured temporal data. Estimating causally-related latent variables from observations is particularly challenging as the latent variables are not uniquely recoverable in the most general case. In this work, we consider both a nonparametric, nonstationary setting and a parametric setting for the latent processes and propose two provable conditions under which temporally causal latent processes can be identified from their nonlinear mixtures. We propose LEAP, a theoretically-grounded architecture that extends Variational Autoencoders (VAEs) by enforcing our conditions through proper constraints in causal process prior. Experimental results on various data sets demonstrate that temporally causal latent processes are reliably identified from observed variables under different dependency structures and that our approach considerably outperforms baselines that do not leverage history or nonstationarity information. This is one of the first works that successfully recover time-delayed latent processes from nonlinear mixtures without using sparsity or minimality assumptions.

翻译:我们的目标是从测量的时间数据中恢复时间延迟的潜在因果变数,并从测量的时间数据中查明这些变数的关系。从观测中估算与因果相关的潜在变数特别具有挑战性,因为在最一般的情况下,潜在变数并非独特的可回收变量。在这项工作中,我们既考虑非参数性、非静止的设置,也考虑潜在过程的参数设置,并提议两个可辨别的条件,据此可以从非线性混合物中找出时间性因果潜在变数。我们提议LEAP,这是一个理论上基础的结构,通过在因果过程之前的适当限制来实施我们的条件,扩展变异性自动变相器(VAE),以扩大我们的条件。各种数据集的实验结果表明,从不同依赖结构下观测到的变数中可以可靠地识别出时间性因果潜值过程,而且我们的方法大大超出基线,无法利用历史或非稳定性信息。这是在不使用宽度或最小性假设的情况下成功地从非线性混合物中回收时间延迟的潜值潜值过程的第一批工程之一。