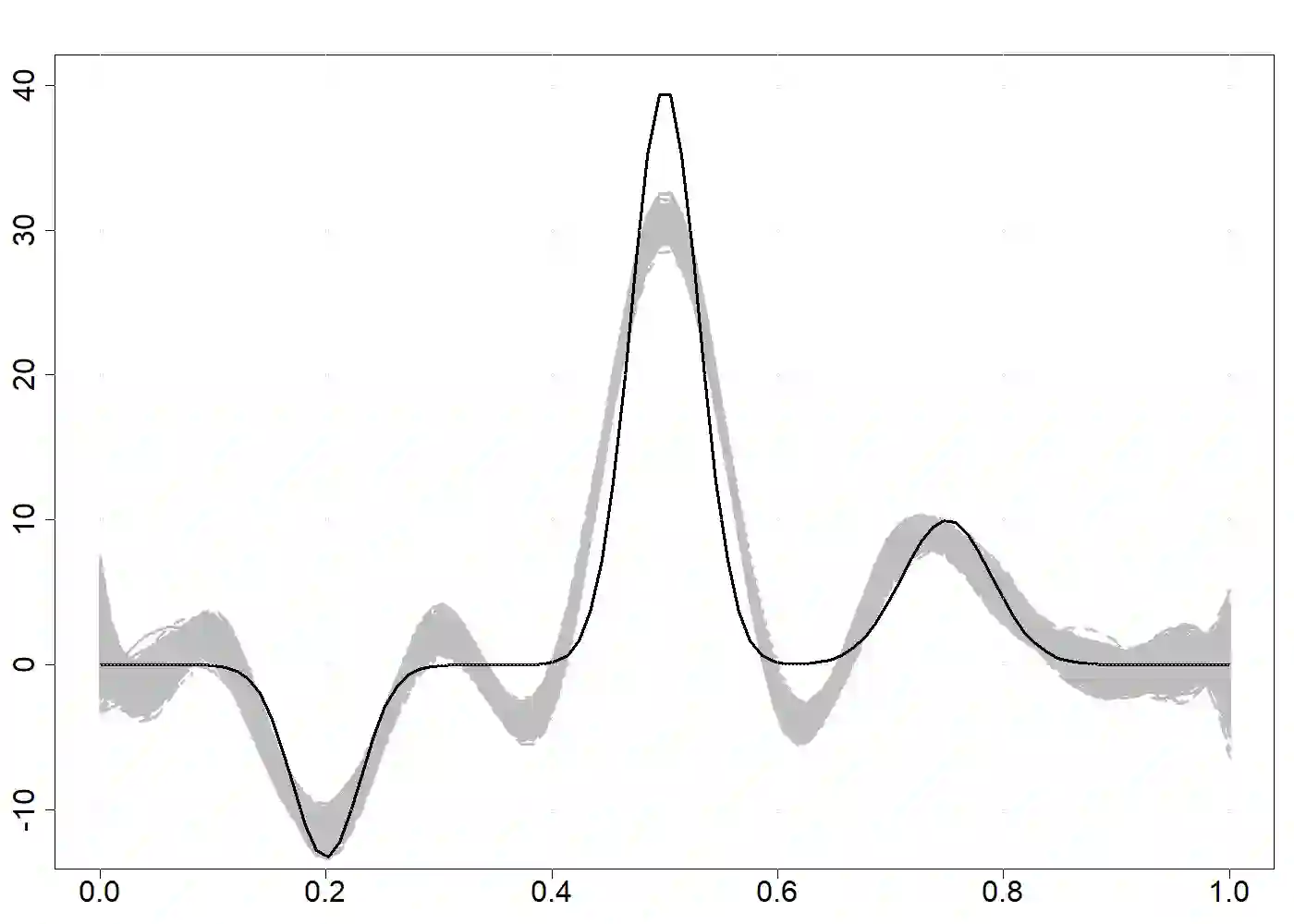

Functional data analysis is a fast evolving branch of statistics. Estimation procedures for the popular functional linear model either suffer from lack of robustness or are computationally burdensome. To address these shortcomings, a flexible family of penalized lower-rank estimators based on a bounded loss function is proposed. The proposed class of estimators is shown to be consistent and can attain high rates of convergence with respect to prediction error under weak regularity conditions. These results can be generalized to higher dimensions under similar assumptions. The finite-sample performance of the proposed family of estimators is investigated by a Monte-Carlo study which shows that these estimators reach high efficiency while offering protection against outliers. The proposed estimators compare favorably to existing approaches robust as well as non-robust alternatives. The good performance of the method is also illustrated on a complex real dataset.

翻译:功能数据分析是一个快速演变的统计分支。对流行功能线性模型的估算程序要么缺乏稳健性,要么在计算上过于繁琐。为了解决这些缺陷,建议建立一个灵活的体系,根据受约束的损失函数,由受处罚的低级别估计者组成,根据受约束的损失函数组成。拟议的估算者类别显示是一致的,在常规性条件薄弱的情况下,在预测错误方面可以达到很高的趋同率。这些结果可以推广到类似假设下的更高层面。蒙特卡洛的一项研究调查了拟议估算者家属的有限抽样表现。该研究显示,这些估算者在提供抵御外部离线的保护的同时,效率很高。拟议的估算者比较现有方法的优劣性以及非紫外线替代方法。该方法的良好表现还体现在一个复杂的真实数据集上。