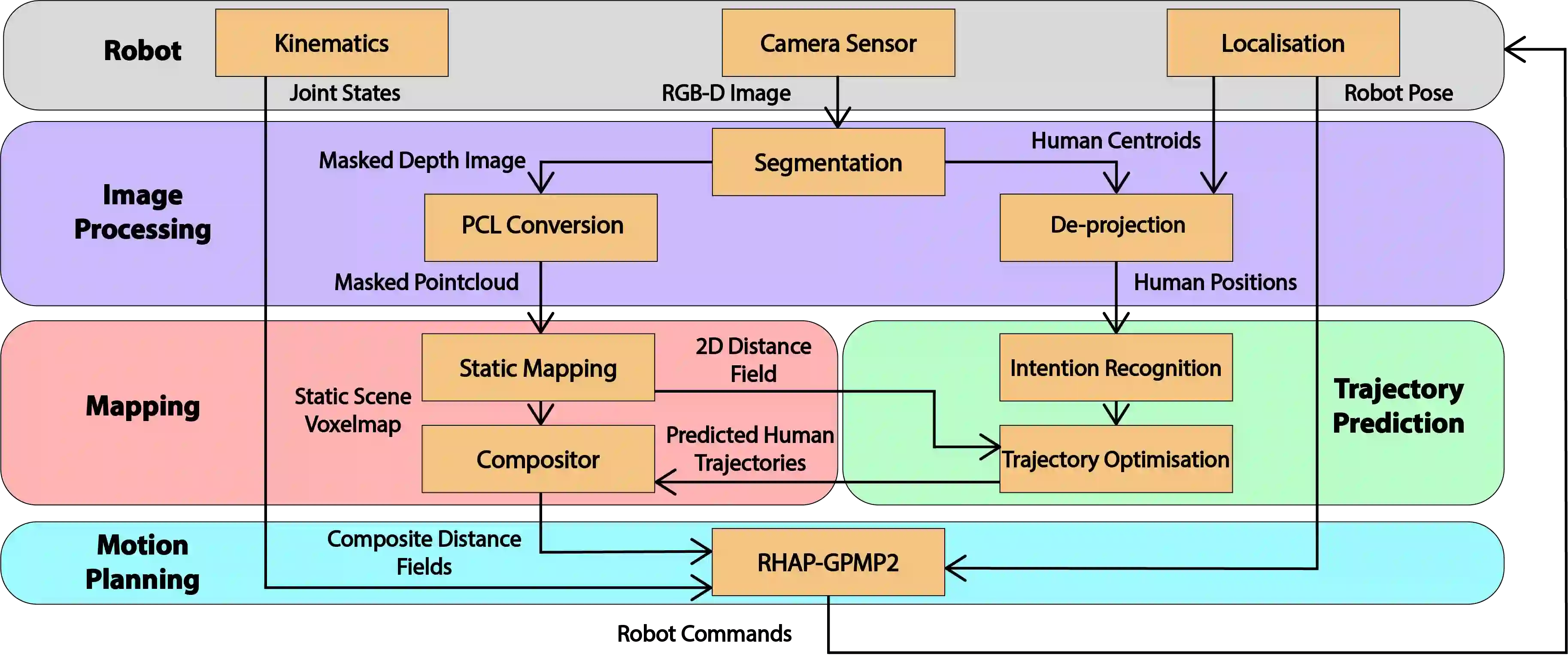

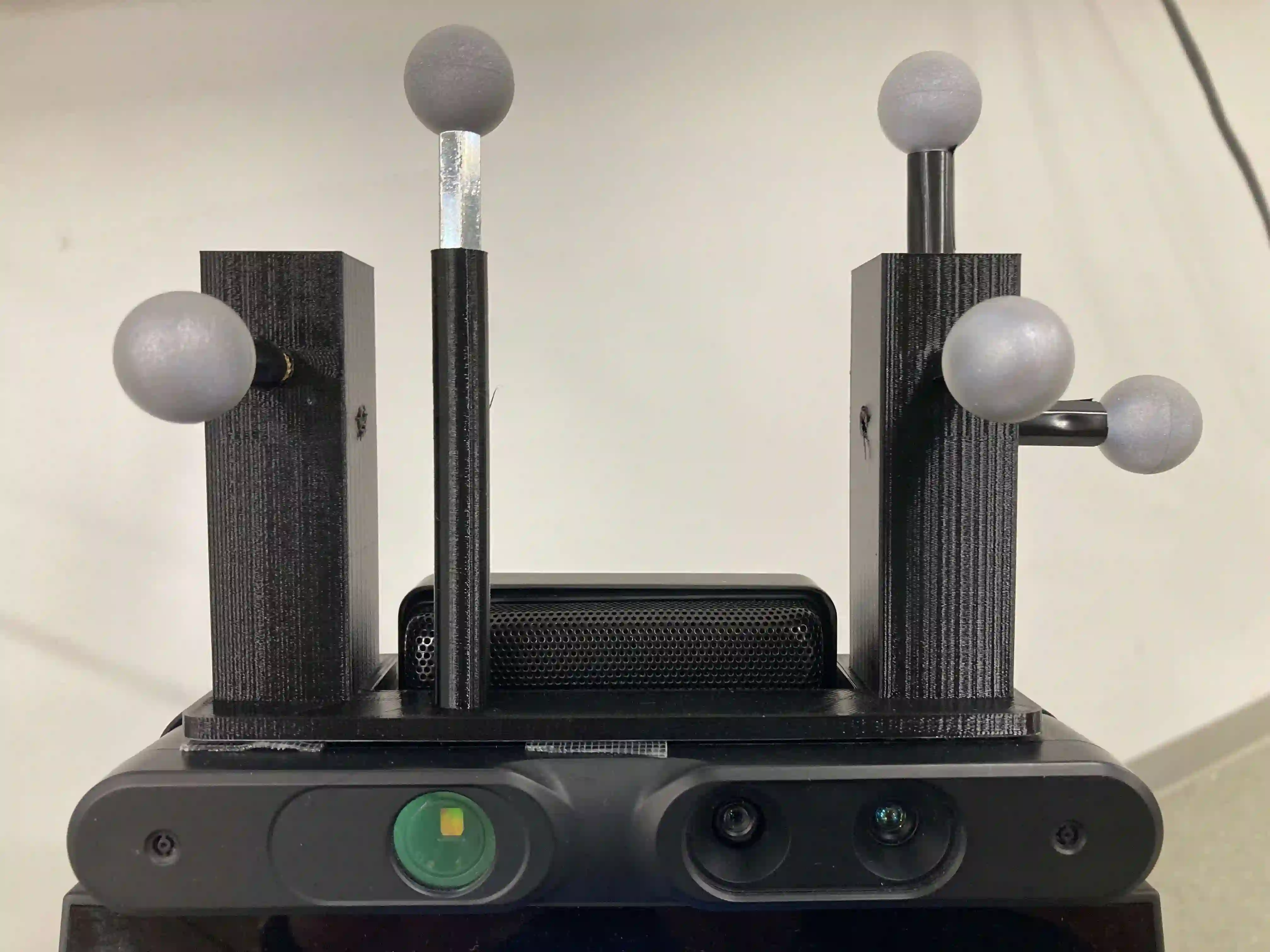

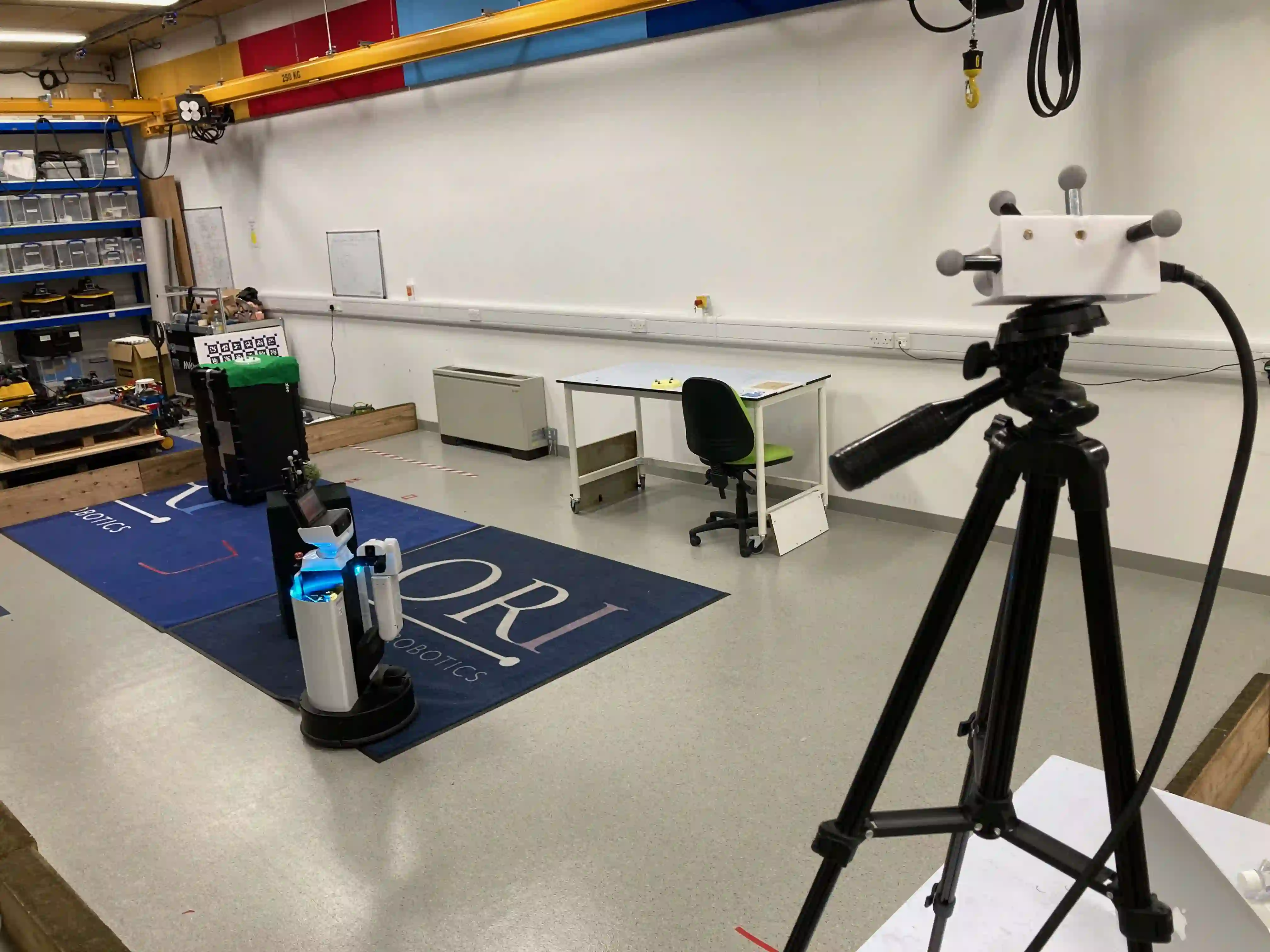

Over the years, the separate fields of motion planning, mapping, and human trajectory prediction have advanced considerably. However, the literature is still sparse in providing practical frameworks that enable mobile manipulators to perform whole-body movements and account for the predicted motion of moving obstacles. Previous optimisation-based motion planning approaches that use distance fields have suffered from the high computational cost required to update the environment representation. We demonstrate that GPU-accelerated predicted composite distance fields significantly reduce the computation time compared to calculating distance fields from scratch. We integrate this technique with a complete motion planning and perception framework that accounts for the predicted motion of humans in dynamic environments, enabling reactive and pre-emptive motion planning that incorporates predicted motions. To achieve this, we propose and implement a novel human trajectory prediction method that combines intention recognition with trajectory optimisation-based motion planning. We validate our resultant framework on a real-world Toyota Human Support Robot (HSR) using live RGB-D sensor data from the onboard camera. In addition to providing analysis on a publicly available dataset, we release the Oxford Indoor Human Motion (Oxford-IHM) dataset and demonstrate state-of-the-art performance in human trajectory prediction. The Oxford-IHM dataset is a human trajectory prediction dataset in which people walk between regions of interest in an indoor environment. Both static and robot-mounted RGB-D cameras observe the people while tracked with a motion-capture system.

翻译:多年来,运动规划、绘图和人类轨迹预测等不同领域都取得了很大进展。然而,文献仍然很少提供实用框架,使移动操纵者能够进行全体运动并解释移动障碍的预测动作。以往使用偏差场的基于优化的运动规划方法由于更新环境代表性所需的高计算成本而受到影响。我们证明,GPU加速预测的复合距离域与从零到零计算距离域的计算时间相比,大大减少了计算时间。我们把这一技术与完整的运动规划和认知框架结合起来,以说明人类在动态环境中的预测动作,从而促成反应性和先发制人的运动规划,并纳入预测动作。为了实现这一目标,我们提议并采用新的人类轨迹预测方法,将意图认识与轨迹优化运动模拟运动规划结合起来。我们利用机上摄像机提供的实时RGB-D传感器数据在现实世界丰田人类支持机器人机器人机器人机器人机器人机器人机器人机器人上,我们除了分析公开提供的数据集外,还发布Oxford Human Ind Humanmotion Humanmotion (Oxford-IHM) 数据集,同时展示了行进轨道预测人对轨道环境的兴趣。