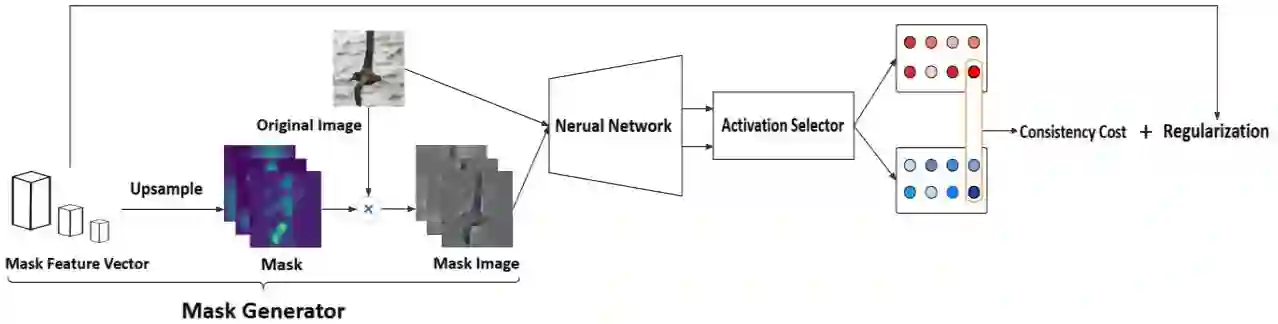

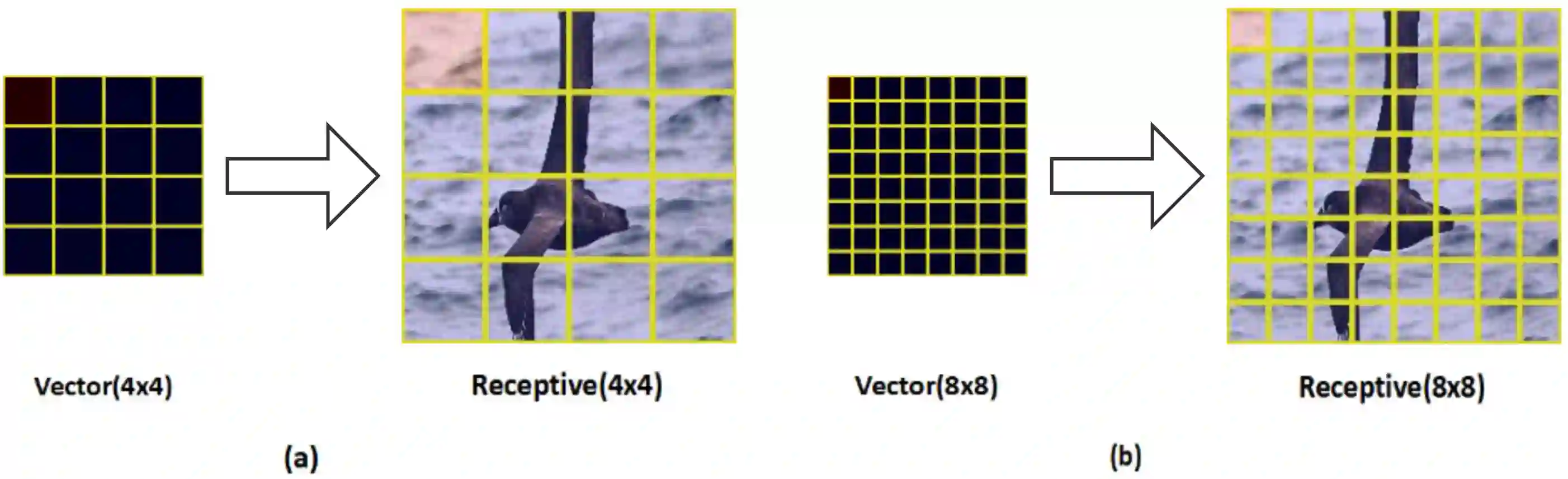

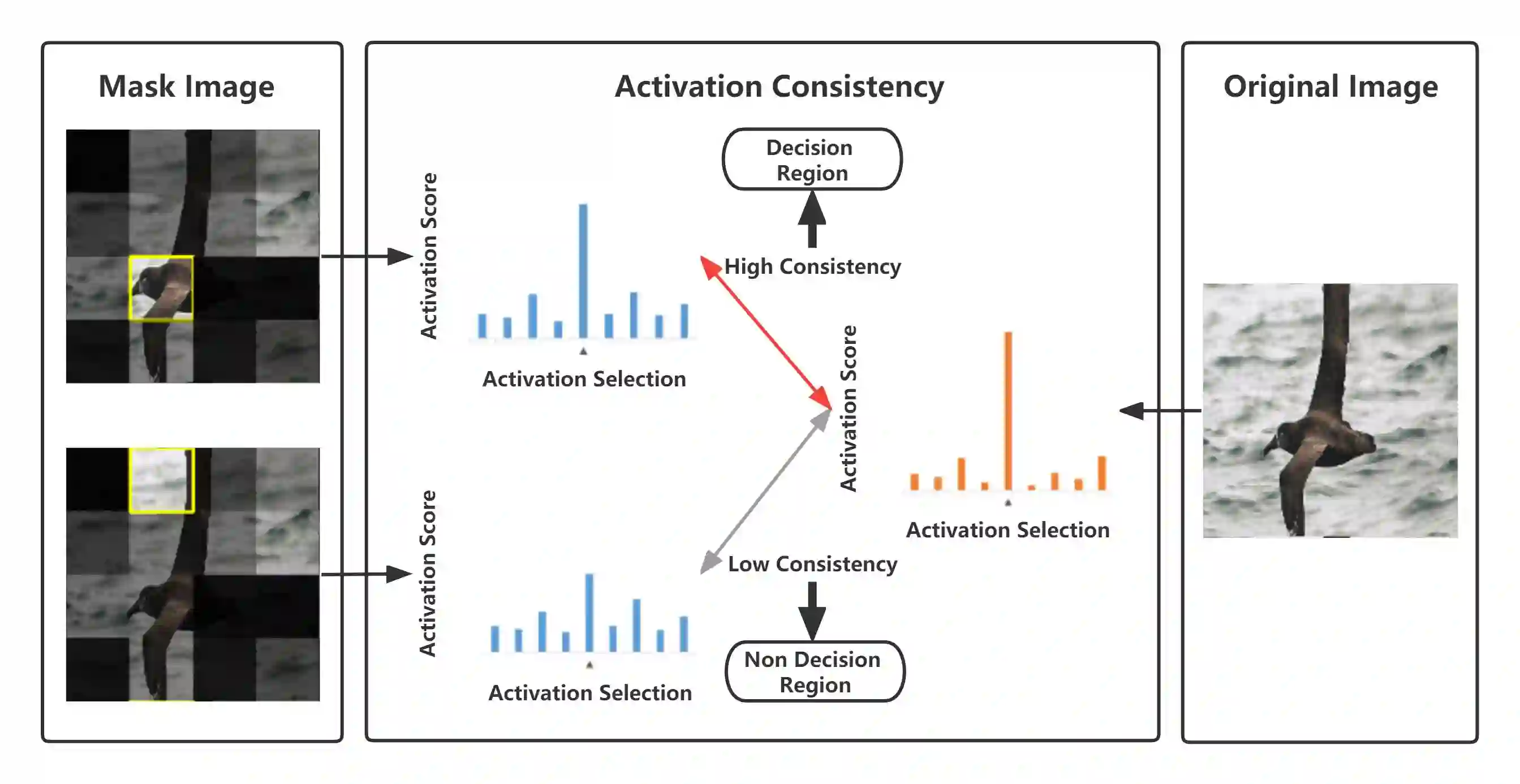

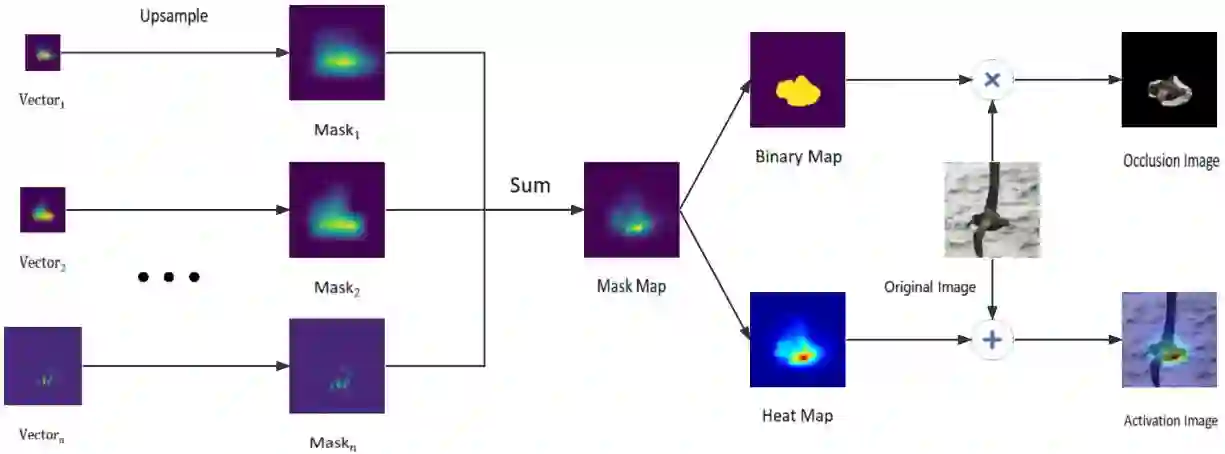

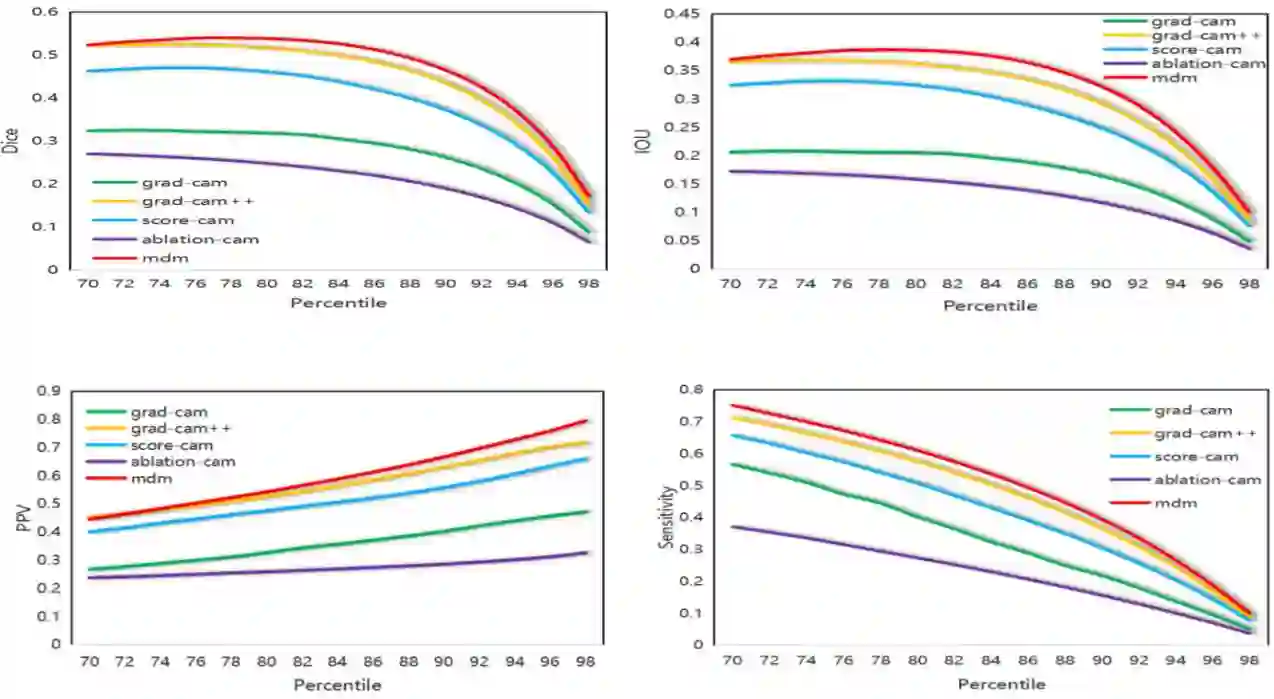

The active region lookup of a neural network tells us which regions the neural network focuses on when making a decision, which gives us a basis for interpretability when the neural network makes a classification decision. We propose an algorithm Multiple Dynamic Mask(MDM), which is a general saliency graph query method with interpretability of the inference process. Its proposal is based on an assumption: when a picture is input to a neural network that has been trained, the activation features related to classification will affect the classification results of the neural network, and the features unrelated to classification will hardly affect the classification results of the network. MDM: A learning-based end-to-end algorithm for finding regions of interest for neural network classification. It has the following advantages: 1. It has the interpretability of the reasoning process. 2. It is universal, it can be used for any neural network and does not depend on the internal structure of the neural network. 3. The search performance is better. Because the algorithm is based on learning to generate masks and has the ability to adapt to different data and networks, the performance is better than the method proposed in the previous paper. For the MDM saliency map search algorithm, we experimentally compared the performance indicators of various saliency map search methods and the MDM with ResNet and DenseNet as the trained neural networks. The search effect performance of the MDM reached the state of the art. We applied the MDM to the interpretable neural network ProtoPNet and XProtoNet, which improved the interpretability of the model and the prototype search performance. We visualize the performance of convolutional neural architecture and Transformer architecture on saliency map search.

翻译:活跃的神经网络区域外观告诉我们神经网络在做出决策时关注哪些区域,这为我们提供了在神经网络做出分类决定时进行解释的基础。我们提议了一个算法多动态Msk(MDM),这是一个具有推理过程可解释性的一般显性图形查询方法。它的建议基于一个假设:当图片是向受过训练的神经网络输入时,与分类有关的激活功能将影响神经网络的分类结果,而与分类无关的特征将几乎不会影响网络的分类结果。MDM:一个基于学习的终端到终端的算法,用于寻找对神经网络分类感兴趣的区域。它具有以下优点:1.它具有推理过程的可解释性能。2.它是普遍的,它可以用于任何神经网络,而不取决于神经网络的内部结构。3. 搜索性能更好。由于该算法以学习生成掩码为基础,并且有能力适应不同数据和网络的分类结果。MDM:一个基于学习的终端到的终端端端到端端到端端的终端的终端算算算法,我们比在前一张纸上所推荐的神经网络的搜索和内质网络的轨道搜索效果。我们用来比较了机器的网络的网络的网络的轨道搜索和SDM.M.M.