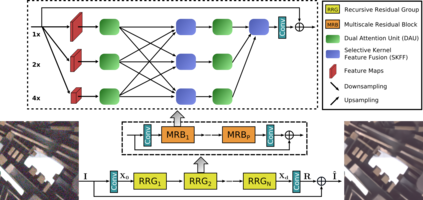

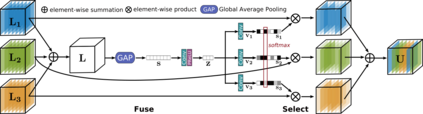

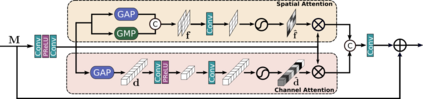

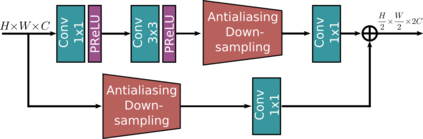

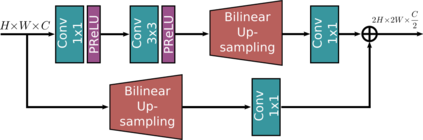

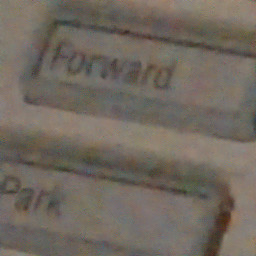

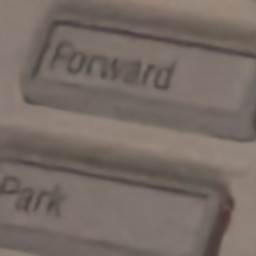

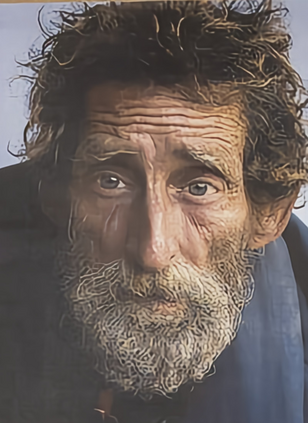

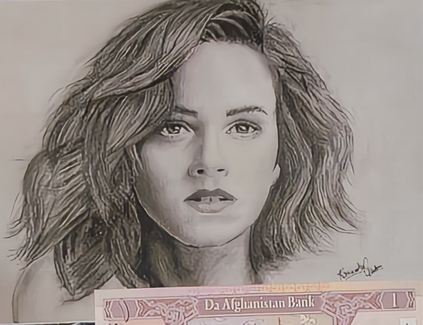

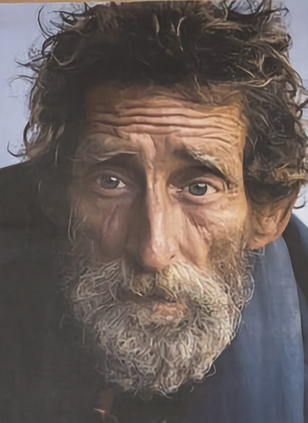

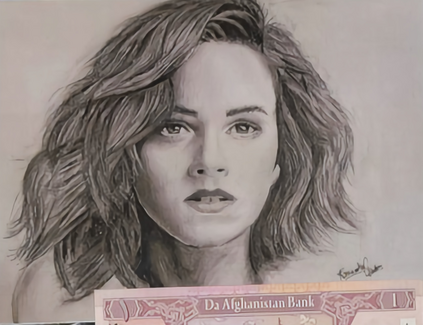

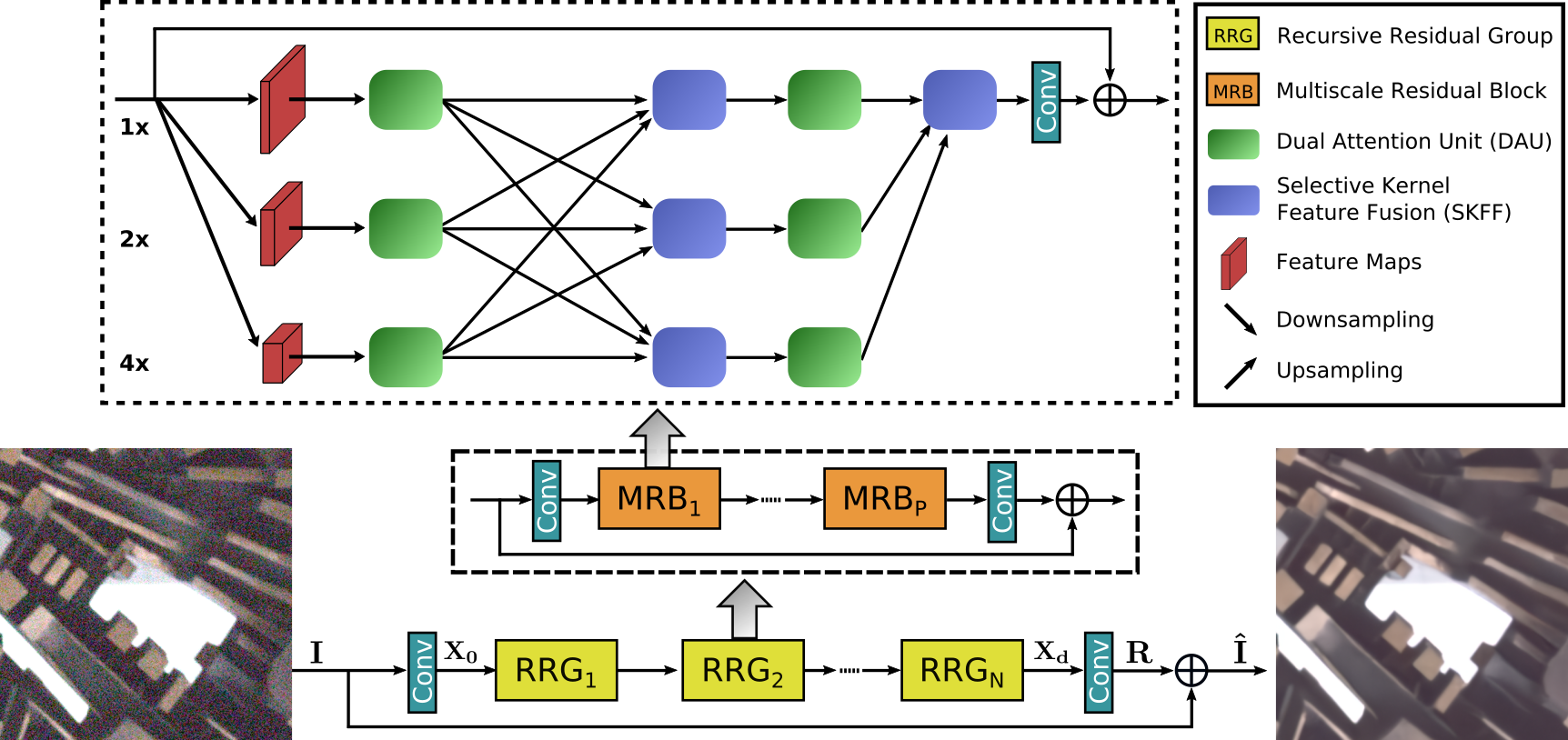

With the goal of recovering high-quality image content from its degraded version, image restoration enjoys numerous applications, such as in surveillance, computational photography, medical imaging, and remote sensing. Recently, convolutional neural networks (CNNs) have achieved dramatic improvements over conventional approaches for image restoration task. Existing CNN-based methods typically operate either on full-resolution or on progressively low-resolution representations. In the former case, spatially precise but contextually less robust results are achieved, while in the latter case, semantically reliable but spatially less accurate outputs are generated. In this paper, we present a novel architecture with the collective goals of maintaining spatially-precise high-resolution representations through the entire network and receiving strong contextual information from the low-resolution representations. The core of our approach is a multi-scale residual block containing several key elements: (a) parallel multi-resolution convolution streams for extracting multi-scale features, (b) information exchange across the multi-resolution streams, (c) spatial and channel attention mechanisms for capturing contextual information, and (d) attention based multi-scale feature aggregation. In a nutshell, our approach learns an enriched set of features that combines contextual information from multiple scales, while simultaneously preserving the high-resolution spatial details. Extensive experiments on five real image benchmark datasets demonstrate that our method, named as MIRNet, achieves state-of-the-art results for a variety of image processing tasks, including image denoising, super-resolution, and image enhancement. The source code and pre-trained models are available at https://github.com/swz30/MIRNet.

翻译:随着从退化版本中恢复高质量图像内容的目标,图像恢复具有许多应用,例如监视、计算摄影、医疗成像和遥感等。最近,超动神经网络(CNNs)在图像恢复任务的传统方法上取得了巨大改进。现有CNN方法通常以完全分辨率或逐步低分辨率表示方式运作。在前一种情况下,取得了空间精确但因地制宜较弱的结果,而在后一种情况下,生成了具有内在可靠性的可靠但空间准确度较低的产出。在本文中,我们展示了一个具有通过整个网络保持空间精度高分辨率表示方式的集体目标的新结构,并且从低分辨率表示方式获得了强有力的背景信息。我们方法的核心是一个多尺度的剩余部分,包含以下几个关键要素:(a)用于提取多尺度特征的平行多分辨率流流,(b)跨多分辨率流的信息交流,(c)用于获取背景信息的空间和频道关注机制,以及(d)基于多尺度特征汇总的注意。在螺旋式网络中,我们的方法的核心部分学习了我们用于高分辨率的图像升级的图像,同时学习了多种图像升级方法,包括了我们图像升级前的图像的图像升级方法。