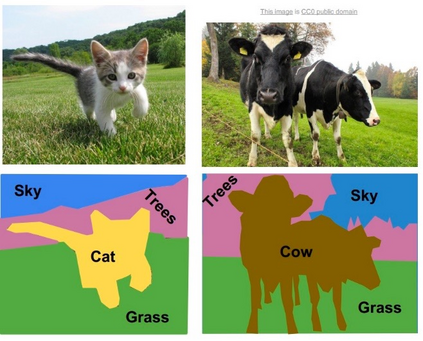

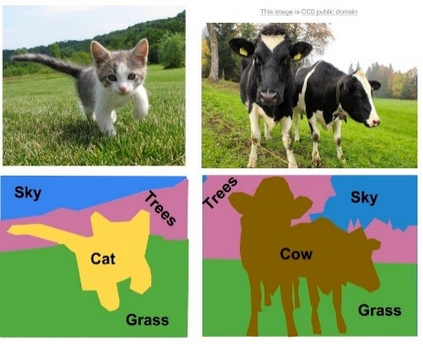

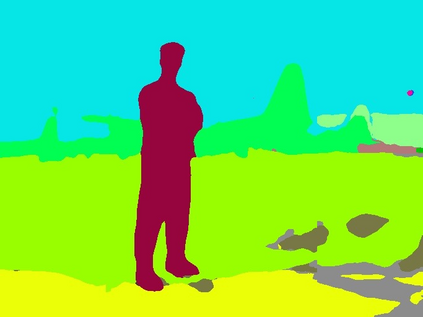

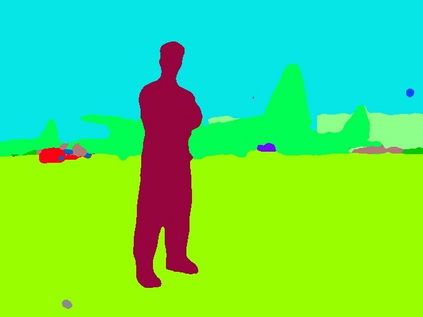

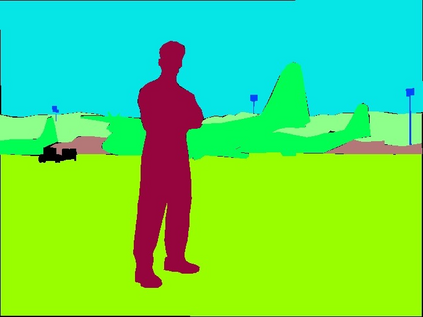

Recent progress has shown that large-scale pre-training using contrastive image-text pairs can be a promising alternative for high-quality visual representation learning from natural language supervision. Benefiting from a broader source of supervision, this new paradigm exhibits impressive transferability to downstream classification tasks and datasets. However, the problem of transferring the knowledge learned from image-text pairs to more complex dense prediction tasks has barely been visited. In this work, we present a new framework for dense prediction by implicitly and explicitly leveraging the pre-trained knowledge from CLIP. Specifically, we convert the original image-text matching problem in CLIP to a pixel-text matching problem and use the pixel-text score maps to guide the learning of dense prediction models. By further using the contextual information from the image to prompt the language model, we are able to facilitate our model to better exploit the pre-trained knowledge. Our method is model-agnostic, which can be applied to arbitrary dense prediction systems and various pre-trained visual backbones including both CLIP models and ImageNet pre-trained models. Extensive experiments demonstrate the superior performance of our methods on semantic segmentation, object detection, and instance segmentation tasks. Code is available at https://github.com/raoyongming/DenseCLIP

翻译:最近的进展表明,使用对比式图像-文本配对进行大规模预培训,可以成为从自然语言监督中进行高质量视觉演示学习的一个很有希望的替代方法。从更广泛的监督来源,这一新范例显示,从图像-文本配对到更下游分类任务和数据集的可转移性令人印象深刻。然而,从图像-文本配对到更复杂密集的预测任务所学知识的转移问题几乎没有到过。在这项工作中,我们提出了一个通过隐含和明确利用CLIP预先培训的知识进行密集预测的新框架。具体地说,我们把CLIP中的原始图像-文本匹配问题转换成像素-文本配对问题,并使用像素-文本评分地图指导密集预测模型的学习。通过进一步利用图像背景信息促进语言模型的推广,我们能够促进我们模型更好地利用经过预先培训的知识。我们的方法是模型-人工智能,可以应用于任意密集的预报系统和经过预先培训的各种视觉骨干,包括CLIP模型和经过预先培训的图像网络模型。广泛的实验展示了我们关于精密化/CLIP断段的方法的优性表现。