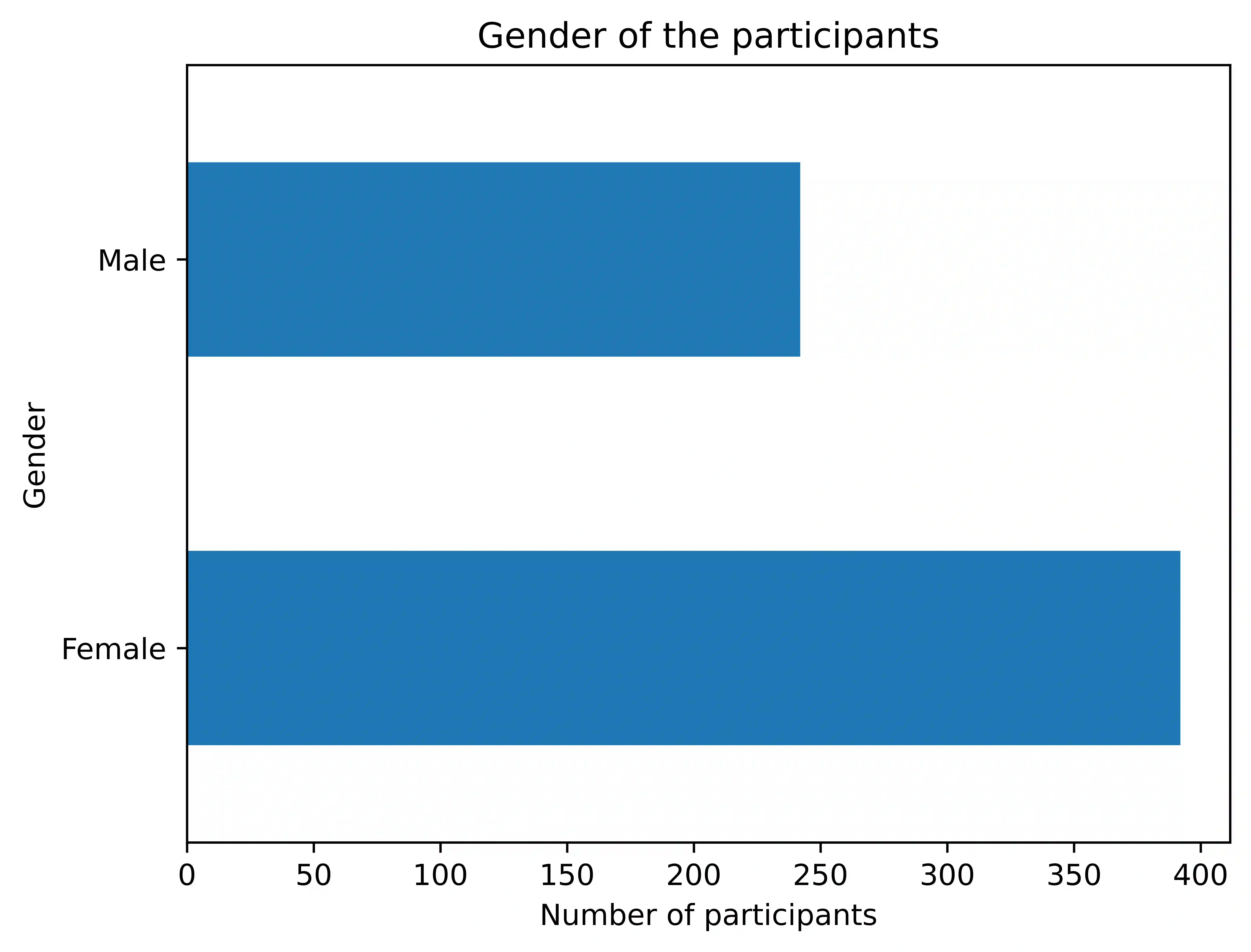

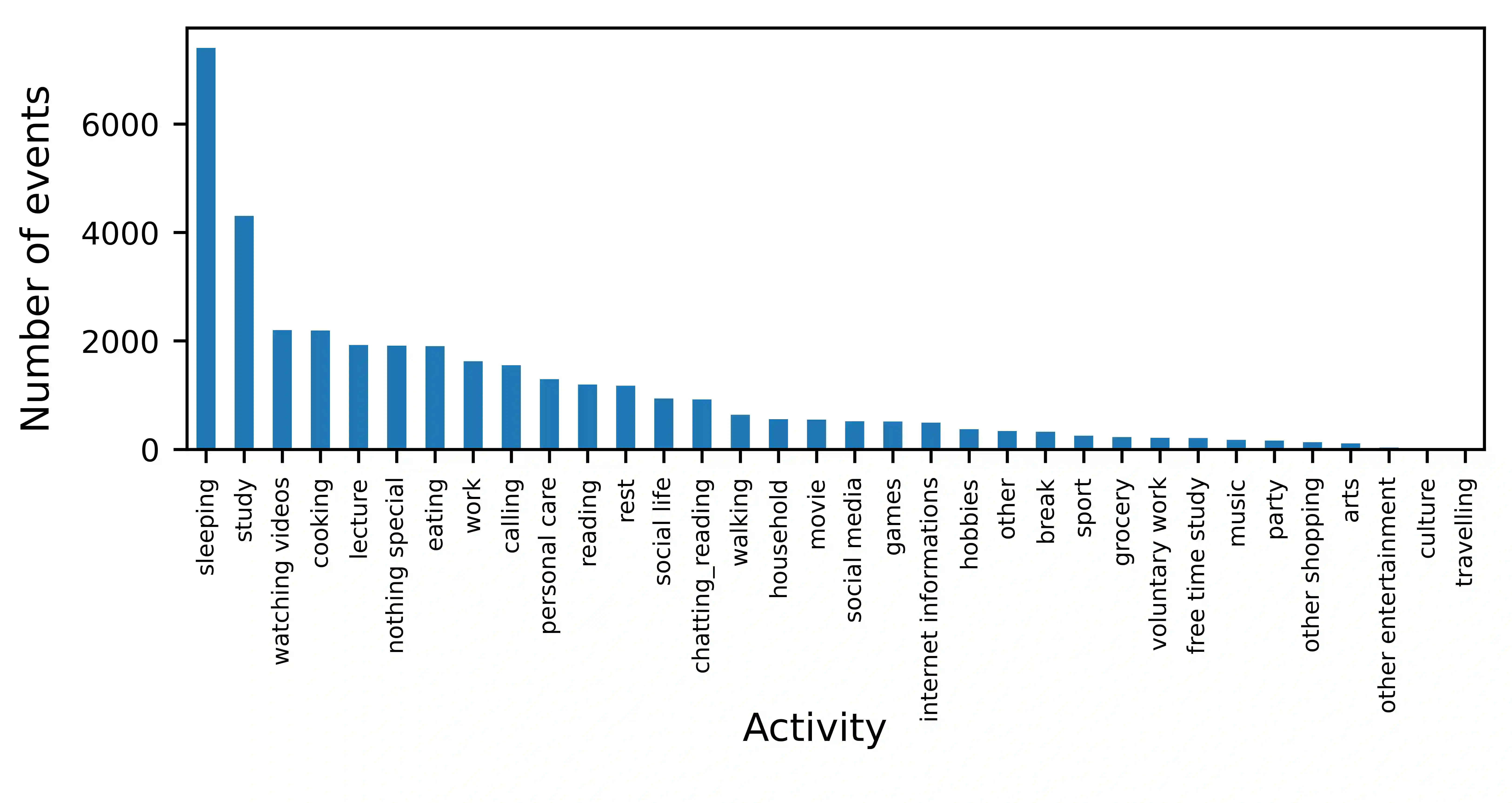

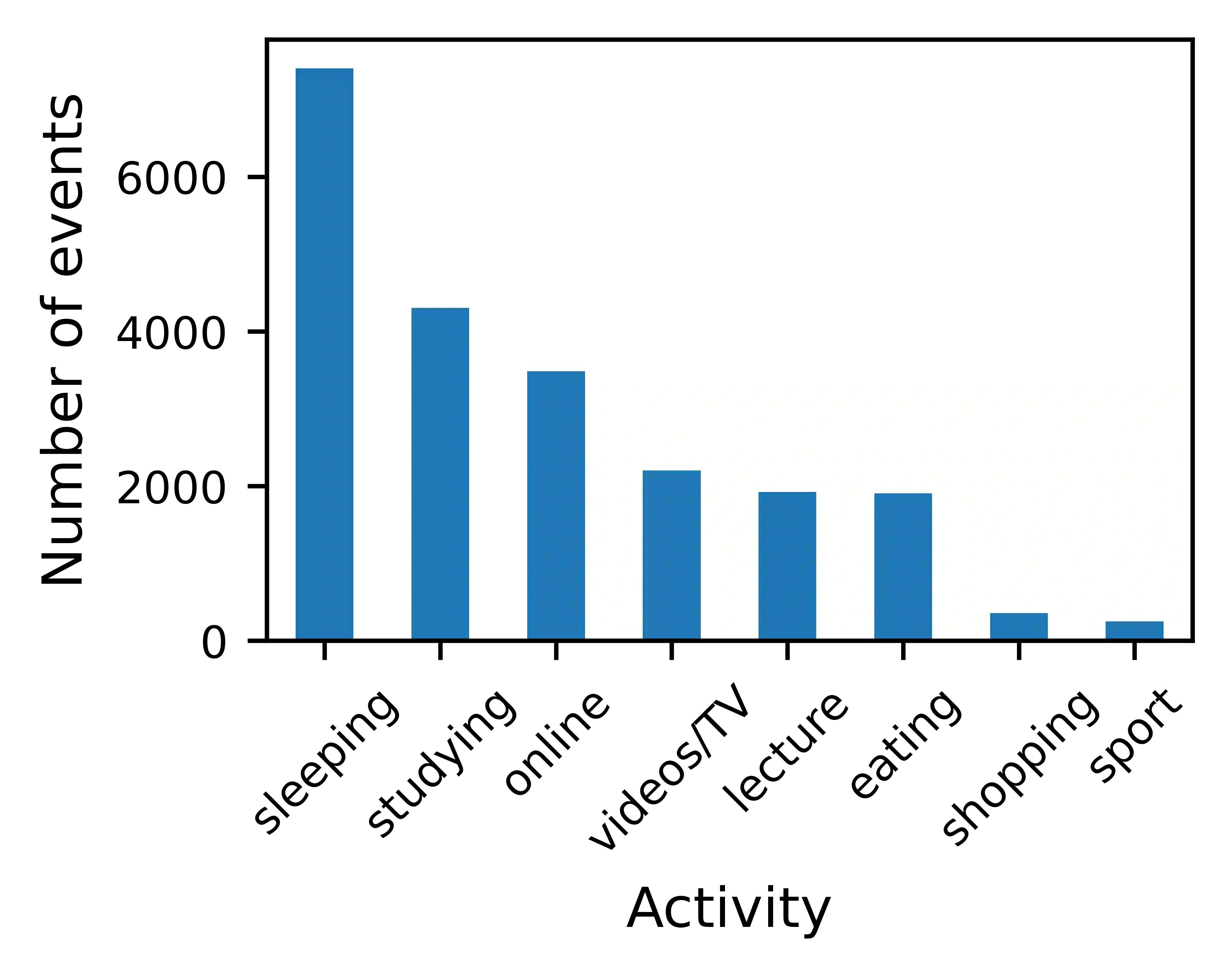

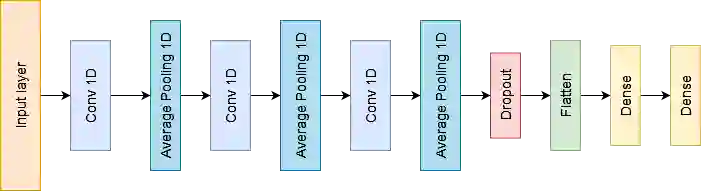

Human Activity Recognition (HAR) enables context-aware user experiences where mobile apps can alter content and interactions depending on user activities. Hence, smartphones have become valuable for HAR as they allow large, and diversified data collection. Although previous work in HAR managed to detect simple activities (i.e., sitting, walking, running) with good accuracy using inertial sensors (i.e., accelerometer), the recognition of complex daily activities remains an open problem, specially in remote work/study settings when people are more sedentary. Moreover, understanding the everyday activities of a person can support the creation of applications that aim to support their well-being. This paper investigates the recognition of complex activities exclusively using smartphone accelerometer data. We used a large smartphone sensing dataset collected from over 600 users in five countries during the pandemic and showed that deep learning-based, binary classification of eight complex activities (sleeping, eating, watching videos, online communication, attending a lecture, sports, shopping, studying) can be achieved with AUROC scores up to 0.76 with partially personalized models. This shows encouraging signs toward assessing complex activities only using phone accelerometer data in the post-pandemic world.

翻译:人类活动认识(HAR) 使用户能够通过移动应用程序根据用户活动改变内容和互动来进行符合实际情况的用户体验到移动应用程序可以改变内容和互动。因此,智能手机随着能够进行大规模和多样化的数据收集,对智能手机变得很有价值。虽然以前在HAR的工作设法利用惯性传感器(即加速计),非常精确地探测了简单活动(即坐坐、行走、跑动),但是对复杂的日常活动的承认仍然是一个开放的问题,特别是在远程工作/学习环境中,当人们更定居时,对复杂的日常活动的承认仍然是一个问题。此外,了解一个人的日常活动可以支持创建旨在支持其福祉的应用程序。本文调查了专门使用智能手机加速计数据对复杂活动的承认情况。我们使用了在大流行病期间从五个国家的600多个用户收集的大型智能手机感测数据集,并表明,对八项复杂活动的深度学习和二元分类(睡眠、吃饭、观看视频、在线通信、参加讲座、体育、购物、学习)可以用部分个人化模型从AUROC最多达0.76分。这显示要评估复杂天体数据的活动的令人鼓舞的迹象。