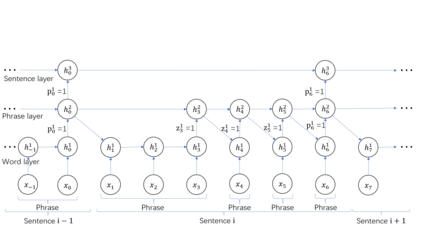

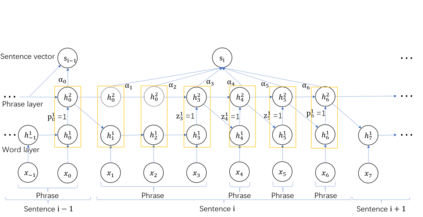

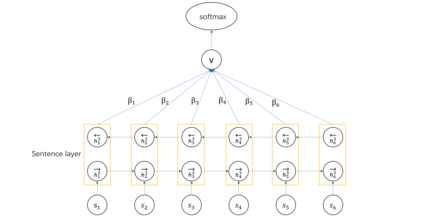

Hierarchical structures exist in both linguistics and Natural Language Processing (NLP) tasks. How to design RNNs to learn hierarchical representations of natural languages remains a long-standing challenge. In this paper, we define two different types of boundaries referred to as static and dynamic boundaries, respectively, and then use them to construct a multi-layer hierarchical structure for document classification tasks. In particular, we focus on a three-layer hierarchical structure with static word- and sentence- layers and a dynamic phrase-layer. LSTM cells and two boundary detectors are used to implement the proposed structure, and the resulting network is called the {\em Recurrent Neural Network with Mixed Hierarchical Structures} (MHS-RNN). We further add three layers of attention mechanisms to the MHS-RNN model. Incorporating attention mechanisms allows our model to use more important content to construct document representation and enhance its performance on document classification tasks. Experiments on five different datasets show that the proposed architecture outperforms previous methods on all the five tasks.

翻译:语言和自然语言处理(NLP)任务都存在等级结构。 如何设计RNN来学习自然语言的等级代表仍然是一项长期的挑战。 在本文件中,我们定义了两种不同的边界类型,分别称为静态和动态边界,然后用它们来构建一个多层次的等级结构,用于文件分类任务。特别是,我们侧重于三层的等级结构,既有静态的单词和句层,也有动态的短语层。 LSTM 细胞和两个边界探测器被用来实施拟议的结构,而由此产生的网络被称为“混合等级结构常态神经网络 ” ( MHS-RNN) 。我们进一步增加了MHS-RNN模式的三层关注机制。整合关注机制使我们的模式能够使用更为重要的内容构建文件代表并提高其在文件分类任务上的绩效。在五个不同的数据集上进行的实验表明,拟议的结构超越了所有五项任务的以往方法。