论文题目: Conversation Structure Modeling Using Masked Hierarchical Transformer

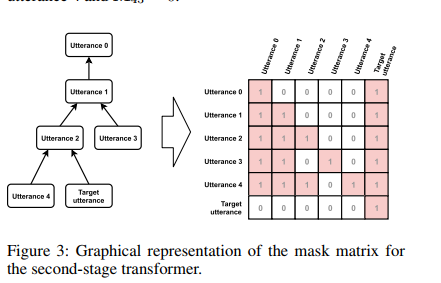

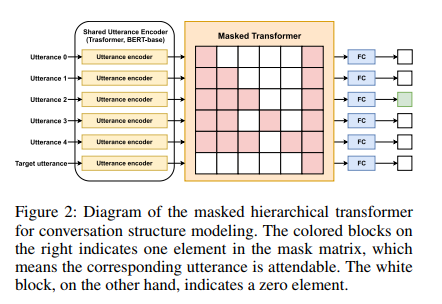

摘要: 对话结构对于理解对话动态的本质以及为许多下游应用程序提供功能(例如对话摘要)很有用。在这项工作中,我们将对话结构建模的问题定义为识别对话中每个话语都对其做出响应。 以前的工作通常会用一组语音来决定一个语音是否是另一个语音的母体。我们认为,整个对话历史是做出准确预测的非常重要的信息来源。因此,我们设计了一种新颖的机制,并利用变换器模型来汇总所有历史以预测话语。我们的实验是在Reddit数据集(Zhang,Culbertson和Paritosh 2017)和Ubuntu IRC数据集(Kummerfeld et al.2019)上进行的。此外,我们还报告了来自Reddit平台的新的更大语料库的实验,并发布了该数据集。

成为VIP会员查看完整内容

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

专知会员服务

64+阅读 · 2020年4月28日

专知会员服务

51+阅读 · 2020年3月7日

专知会员服务

28+阅读 · 2019年11月26日

专知会员服务

48+阅读 · 2019年11月25日

Arxiv

5+阅读 · 2019年1月10日