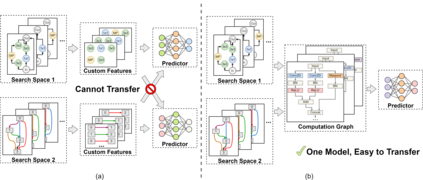

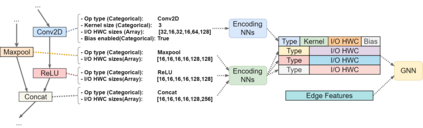

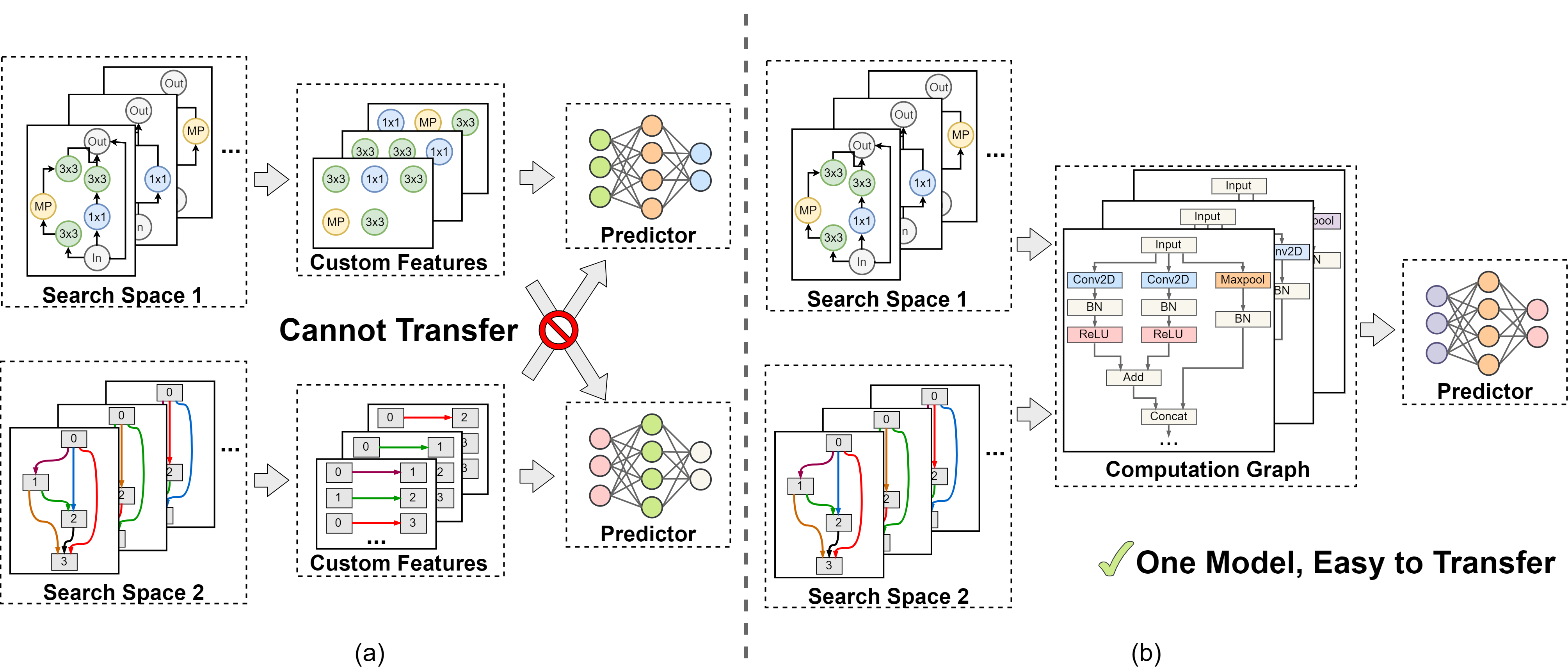

Understanding and modelling the performance of neural architectures is key to Neural Architecture Search (NAS). Performance predictors have seen widespread use in low-cost NAS and achieve high ranking correlations between predicted and ground truth performance in several NAS benchmarks. However, existing predictors are often designed based on network encodings specific to a predefined search space and are therefore not generalizable to other search spaces or new architecture families. In this paper, we propose a general-purpose neural predictor for NAS that can transfer across search spaces, by representing any given candidate Convolutional Neural Network (CNN) with a Computation Graph (CG) that consists of primitive operators. We further combine our CG network representation with Contrastive Learning (CL) and propose a graph representation learning procedure that leverages the structural information of unlabeled architectures from multiple families to train CG embeddings for our performance predictor. Experimental results on NAS-Bench-101, 201 and 301 demonstrate the efficacy of our scheme as we achieve strong positive Spearman Rank Correlation Coefficient (SRCC) on every search space, outperforming several Zero-Cost Proxies, including Synflow and Jacov, which are also generalizable predictors across search spaces. Moreover, when using our proposed general-purpose predictor in an evolutionary neural architecture search algorithm, we can find high-performance architectures on NAS-Bench-101 and find a MobileNetV3 architecture that attains 79.2% top-1 accuracy on ImageNet.

翻译:神经结构的性能理解和建模是神经结构搜索的关键。 性能预测器在低成本的NAS中广泛使用,并在一些NAS基准中实现了预测和地面真实性之间的高等级关联。 但是,现有的预测器往往根据预先定义的搜索空间特有的网络编码设计,因此不能推广到其他搜索空间或新的建筑家庭。在本文中,我们为NAS提议了一个通用神经预测器,可以跨越搜索空间,代表任何候选人的变动神经网络(CNN)和由原始操作者组成的计算图(CG ) 。我们进一步将我们的CG网络代表与对比性学习(CL)相结合,并提议一个图表代表程序,利用多个家庭未标定的建筑的结构信息来培训CG的性能预测。 NAS-Bench-101、201和301的实验结果表明我们的计划效力,因为我们在每一个搜索空间上都取得了强劲的Spearman Rangelational Covalvality (SRCC),在每一个搜索空间上都比数个搜索空间的高级结构,在SQRO-stal-stal-stal- Proview Proview Proview Proview Sqal Proview 时, Proview lax 中, laus