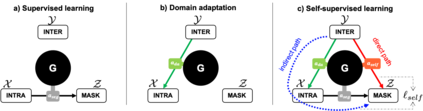

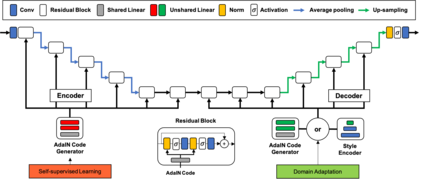

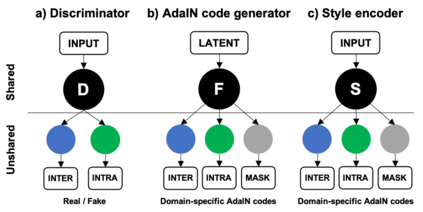

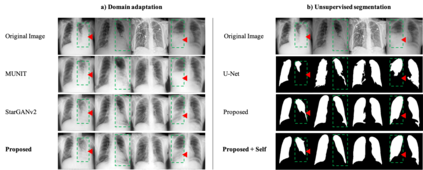

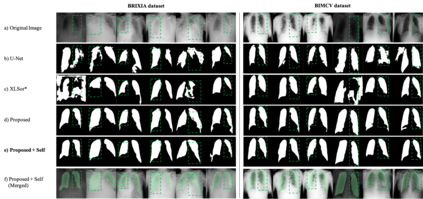

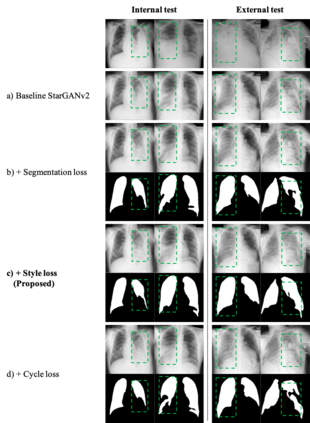

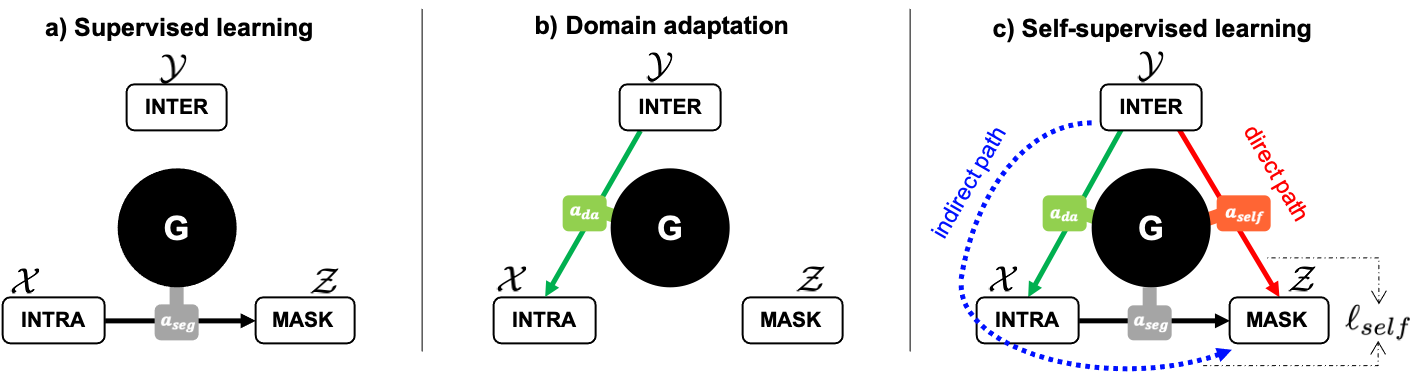

As the segmentation labels are scarce, extensive researches have been conducted to train segmentation networks without labels or with only limited labels. In particular, domain adaptation, self-supervised learning, and teacher-student architecture have been introduced to distill knowledge from various tasks to improve the segmentation performance. However, these approaches appear different from each other, so it is not clear how these seemingly different approaches can be combined for better performance. Inspired by the recent StarGANv2 for multi-domain image translation, here we propose a novel segmentation framework via AdaIN-based knowledge distillation, where a single generator with AdaIN layers is trained along with the AdaIN code generator and style encoder so that the generator can perform both domain adaptation and segmentation. Specifically, our framework is designed to deal with difficult situations in chest X-ray (CXR) segmentation tasks where segmentation masks are only available for normal CXR data, but the trained model should be applied for both normal and abnormal CXR images. Since a single generator is used for abnormal to normal domain conversion and segmentation by simply changing the AdaIN codes, the generator can synergistically learn the common features to improve segmentation performance. Experimental results using CXR data confirm that the trained network can achieve the state-of-the art segmentation performance for both normal and abnormal CXR images.

翻译:由于分解标签很少,因此进行了广泛的研究,以培训没有标签或只有有限标签的分解网络;特别是,引入了领域改造、自监督学习和师生结构,以从各种任务中提取知识,改进分解性能;然而,这些方法似乎不同,因此不清楚如何将这些看起来不同的方法结合起来,以提高性能。受最近StarGANv2的启发,用于多面图像翻译,在此我们提议通过AdaIN知识蒸馏法建立一个新颖的分解框架,对AdaIN层的单一发电机进行与AdaIN代码生成器和样式编码器一起的培训,使发电机既能进行区域调整,又能进行分解性能。具体地说,我们的框架旨在处理胸部X-射线(CXR)分解任务中的难点,只有正常的 CXR 数据,但经过培训的模型应适用于正常和异常的 CXR 图像。由于单个发电机用于正常域转换和分解,只需改变正常的分解功能功能功能功能,即使用AdaX 常规的分解系统,从而确认普通的C-C-C-C-CX 能够将SyalIN 改进普通的分解结果。