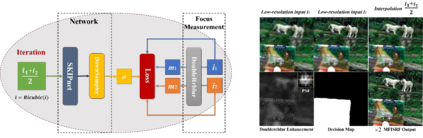

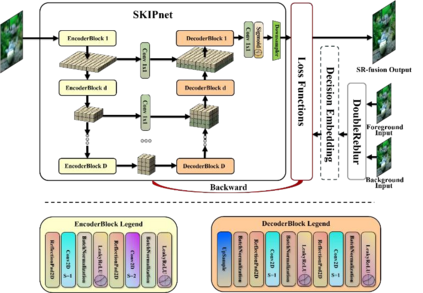

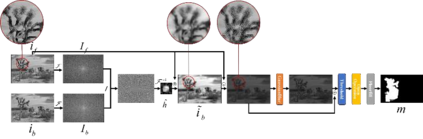

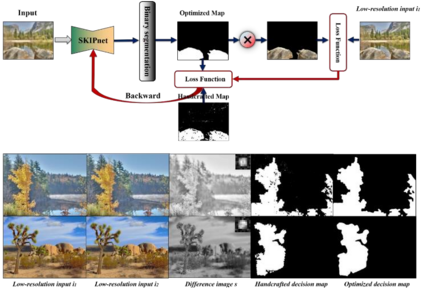

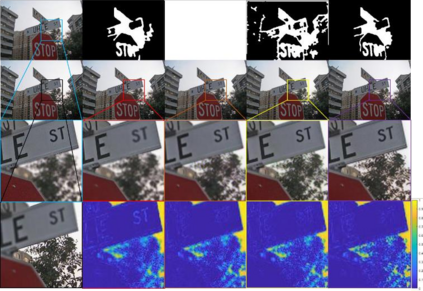

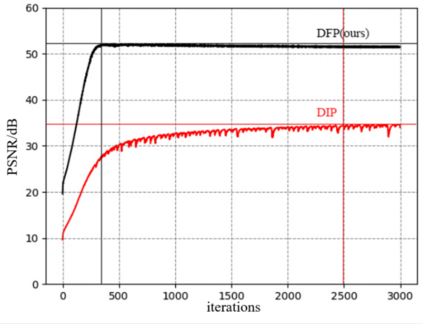

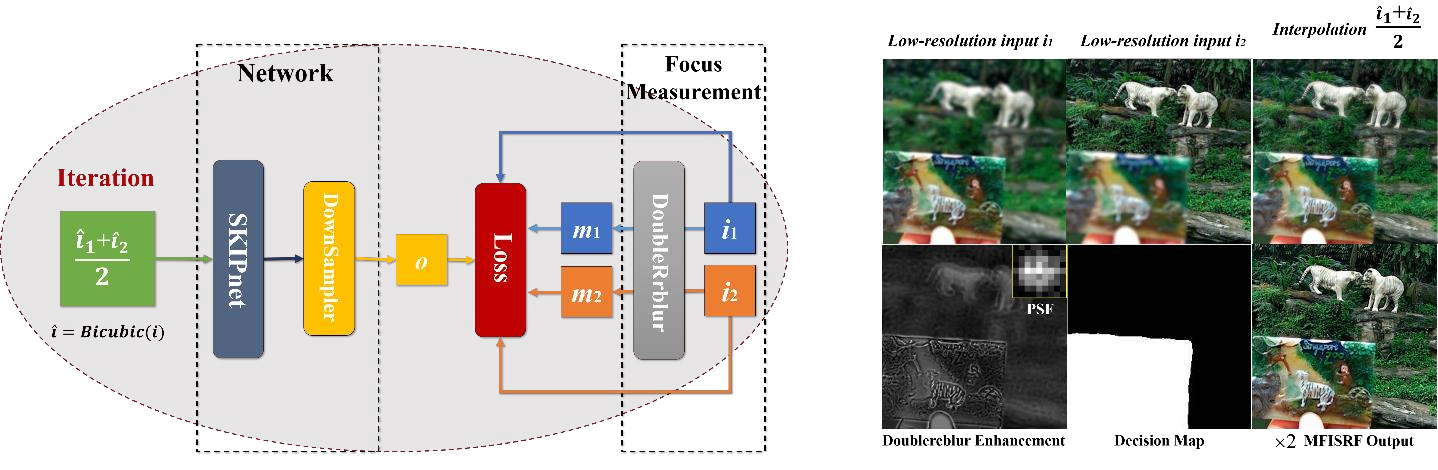

This paper unifies the multi-focus images fusion (MFIF) and blind super resolution (SR) problems as the multi-focus image super resolution fusion (MFISRF) task, and proposes a novel unified dataset-free unsupervised framework named deep fusion prior (DFP) to address such MFISRF task. DFP consists of SKIPnet network, DoubleReblur focus measurement tactic, decision embedding module and loss functions. In particular, DFP can obtain MFISRF only from two low-resolution inputs without any extent dataset; SKIPnet implementing unsupervised learning via deep image prior is an end-to-end generated network acting as the engine of DFP; DoubleReblur is used to determine the primary decision map without learning but based on estimated PSF and Gaussian kernels convolution; decision embedding module optimizes the decision map via learning; and DFP losses composed of content loss, joint gradient loss and gradient limit loss can obtain high-quality MFISRF results robustly. Experiments have proved that our proposed DFP approaches and even outperforms those state-of-art MFIF and SR method combinations. Additionally, DFP is a general framework, thus its networks and focus measurement tactics can be continuously updated to further improve the MFISRF performance. DFP codes are open source and will be available soon at http://github.com/GuYuanjie/DeepFusionPrior.

翻译:本文将多重点图像聚合(MFIF)和盲人超级解析(SR)问题统一为多重点图像超级解析(MFISRF)任务,并提议一个名为深融合(DFP)的新颖、统一的无数据-无监管框架,用于应对MFISRF任务。DFP由SKIPnet网络、双REblur焦点测量策略、决定嵌入模块和损失功能组成。特别是,DFP只能从两个低分辨率输入处获得MFISRF,而无需任何程度的数据集;SKIPnet通过前深层图像进行不受监督的学习是一个端对端生成的网络,作为DFP的引擎;双比布尔用于在没有学习但基于估计PSFFF和Gaussian内核演算法的情况下确定主要决策图;决定嵌入模块通过学习优化决策图;由内容损失、联合梯度损失和梯度限损失组成的DFISRFFF结果将获得高质量的结果。 实验证明,我们提议的DFP方法,甚至超越了DFFS/GFMFS的通用方法。