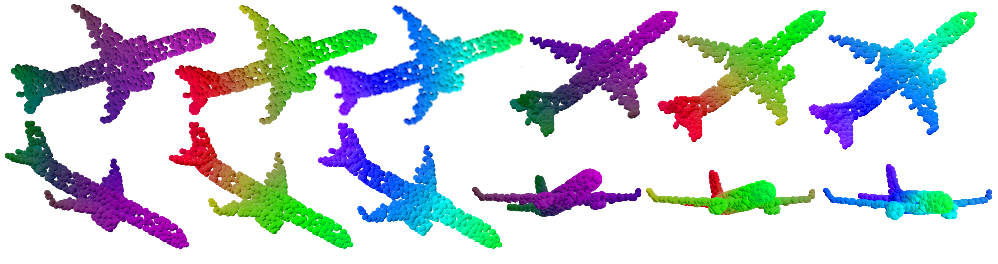

Learning 3D point sets with rotational invariance is an important and challenging problem in machine learning. Through rotational invariant architectures, 3D point cloud neural networks are relieved from requiring a canonical global pose and from exhaustive data augmentation with all possible rotations. In this work, we introduce a rotational invariant neural network by combining recently introduced vector neurons with self-attention layers to build a point cloud vector neuron transformer network (VNT-Net). Vector neurons are known for their simplicity and versatility in representing SO(3) actions and are thereby incorporated in common neural operations. Similarly, Transformer architectures have gained popularity and recently were shown successful for images by applying directly on sequences of image patches and achieving superior performance and convergence. In order to benefit from both worlds, we combine the two structures by mainly showing how to adapt the multi-headed attention layers to comply with vector neurons operations. Through this adaptation attention layers become SO(3) and the overall network becomes rotational invariant. Experiments demonstrate that our network efficiently handles 3D point cloud objects in arbitrary poses. We also show that our network achieves higher accuracy when compared to related state-of-the-art methods and requires less training due to a smaller number of hyperparameters in common classification and segmentation tasks.

翻译:3D 点的学习 3D 点和旋转式神经变换是机器学习中一个重要和具有挑战性的问题。 通过旋转式变换型结构, 3D 点云神经网络不再需要光滑的全球表面, 也不再要求以所有可能的旋转方式全面增加数据。 在这项工作中, 我们引入了旋转式变异性神经网络, 将最近引入的矢量神经元与自我注意层结合起来, 以建立一个点云矢量神经变压网络( VNT-Net ) 。 矢量神经元以它们代表 SO(3) 动作的简单性和多功能而著称, 因而被纳入共同的神经操作。 同样, 变异型结构越来越受欢迎, 并且最近通过直接应用图像修补的顺序, 并实现更高的性能和趋同性, 将两种结构结合起来, 我们主要展示如何调整多点关注层以适应向矢量神经运行。 通过这种调控层成为SO(3) 和整个网络变换式。 实验表明我们的网络以任意姿势对3D点云物体进行了高效处理。 同样处理, 最近显示我们网络的精确度任务比要求更低的分类, 。