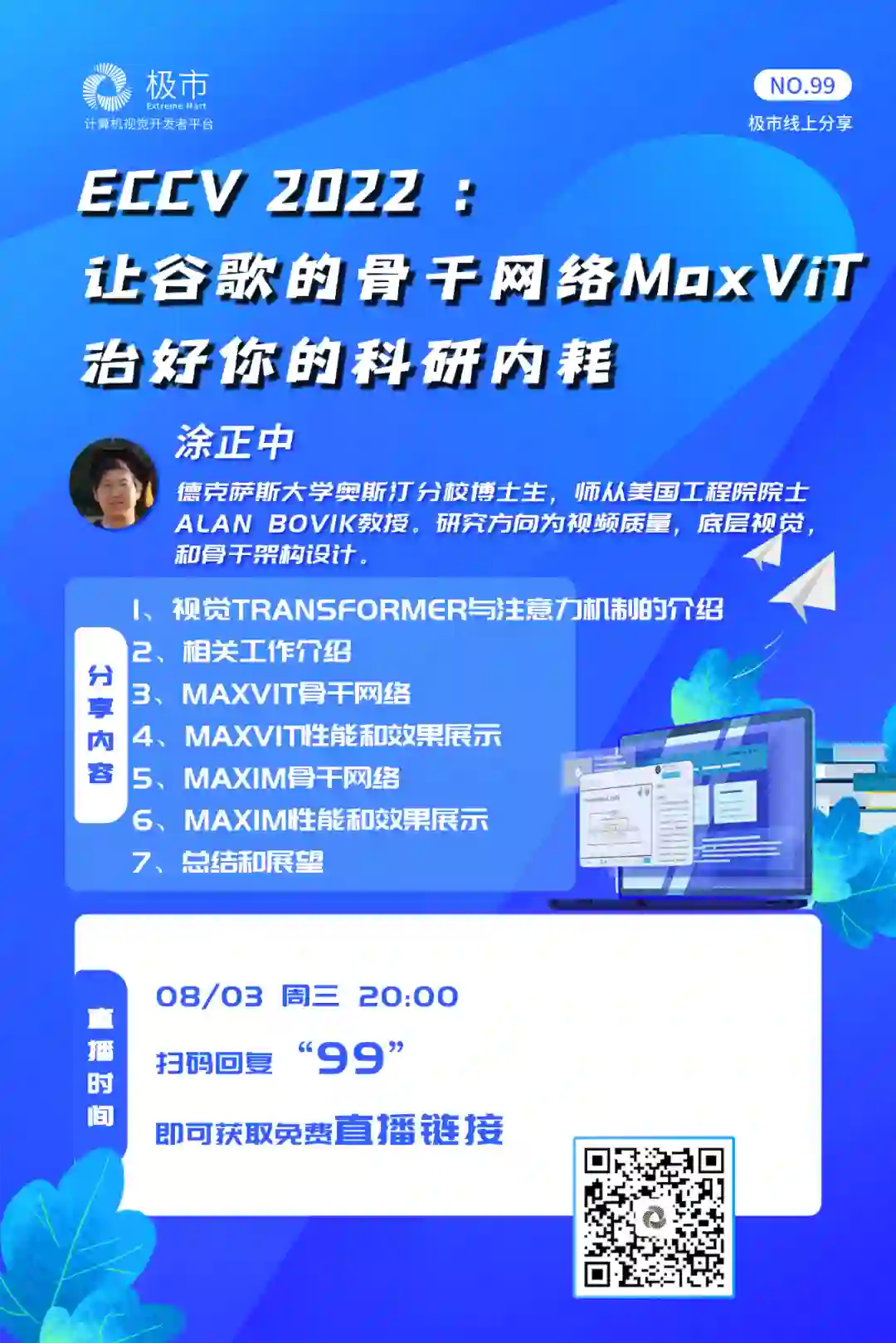

极市直播丨ECCV2022-涂正中:让谷歌的骨干网络MaxViT治好你的科研内耗

| 极市线上分享 第99期 |

一直以来,为让大家更好地了解学界业界优秀的论文和工作,极市已邀请了超过100位技术大咖嘉宾,并完成了98期极市线上直播分享。往期分享请前往bbs.cvmart.net/topics/149或直接阅读原文,也欢迎各位小伙伴自荐或推荐更多优秀的技术嘉宾到极市进行技术分享,与大家一起交流学习~~

近期,Transformer模型在视觉领域大放异彩。Vision Transformer(ViT)出现开启了视觉模型架构设计的新纪元。ViT在大量数据量预训练的情况下可以在ImageNet分类上取得优异的性能。然而,ViT中使用的原始注意力机制具有很高的计算复杂度,从而大大限制了ViT模型作为通用的骨干网络应用到视觉领域的各个下游任务中,特别是需要处理高分辨图片的任务如目标检测、语义分割、或者图像增强。

在这次分享中,我们邀请到了德克萨斯大学奥斯汀分校博士生涂正中,为我们介绍他们提出的宇宙最强骨干网络:

MaxViT:Multi-Axis Vision Transformer (ECCV 2022)

“这是一个混合了卷积和稀疏的多轴注意力的模型架构。具体的,我们提出了一个具有全局和局部感知的、稀疏的多轴注意力模块,仅仅与图像尺寸成线性复杂度,大大优化了原始注意力的平方复杂度。MaxViT作为一个通用的层级型的全局骨干网络在多达五个主流视觉任务上取得了SoTA性能。

Bonus:同时我们也会串讲一篇基于类似想法的底层视觉骨干网络 MAXIM: Multi-Axis MLP for Image Processing (CVPR 22 Oral),获得最佳论文提名奖。其中,我们提出了一个UNet型的骨干网络,基于一个并行设计的全局/局部的多层感知机算子。MAXIM作为一个通用的底层视觉网络在多达五个底层视觉任务包括去噪、去模糊、去雾、去雨和低光照增强上均取得了SoTA性能。两篇文章证明了我们提出的全局、局部的多轴稀疏方法可以在几乎任何的视觉任务上取得先进的性能,为未来的稀疏注意力设计指明了方向。”

01

直播信息

时间

2022年8月3日(周三):20:00-21:00

主题

02

嘉宾介绍

涂正中

德克萨斯大学奥斯汀分校博士生,师从美国工程院院士Alan Bovik教授。研究方向为视频质量,底层视觉,和骨干架构设计。目前为第一作者在计算机视觉顶级会议或期刊CVPR、ECCV、TIP上发表论文多篇,曾获得CVPR 2022最佳论文提名奖,并多次担任著名计算机视觉会议CVPR、ECCV、TIP等审稿人,曾在YouTube、谷歌研究院等地实习。

03

关于分享

1、视觉Transformer与注意力机制的介绍

2、相关工作介绍

3、MaxViT骨干网络

4、MaxVIT性能和效果展示

5、MAXIM骨干网络

6、MAXIM性能和效果展示

7、总结和展望

➤论文

Multi-Axis Vision Transformer(ECCV2022)

论文地址:

https://arxiv.org/abs/2204.01697

代码地址:

https://github.com/google-research/maxvit

MAXIM: Multi-Axis MLP for Image Processing (CVPR 22 Oral)

论文地址:

https://arxiv.org/abs/2201.02973

代码地址:

https://github.com/google-research/maxim

04

参与方式

关注“极市平台”公众号,回复“99”可获取免费直播链接。

04

往期回顾

CVPR 2022-唐业辉:量子启发的新型视觉主干模型WaveMLP

港科大陈启峰:图像处理与复原中的可逆性问题

陈使明:零样本学习的关键问题研究

郑哲东丨从行人重识别到无人机定位

陈鑫:CVPR 2021-TransT: 基于Transformer的高性能单目标跟踪算法

田春伟:基于卷积神经网络的图像复原研究

邓欣:TIP 2021-多曝光图像融合及超分辨的联合实现方法

AAAI'21杰出论文许鸿斌:一个解决三维重建对数据依赖的新框架(已开源)

方浩:车道线检测新SOTA,RESA:循环特征位移聚合器(AAAI2021)

朱本金丨AutoAssign,目标检测中完全动态的正负样本标签分配方

彭小江&王锴丨非受控环境下的表情识别

张航|ResNeSt:拆分注意力网络

直播回放|CSIG-广东省CVPR2020论文在线学术报告

赛事集训直播 | 技术大咖带你揭秘世界人工智能创新大赛

谢恩泽|CVPR2020-PolarMask,一阶段实例分割新思路

陈昊|CVPR2020-BlendMask,高质高效的实例分割模型

# CV技术社群邀请函 #

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~