谷歌AI人格觉醒了?马库斯怒喷:是你有魔怔!

![]()

新智元报道

新智元报道

编辑:袁榭 桃子

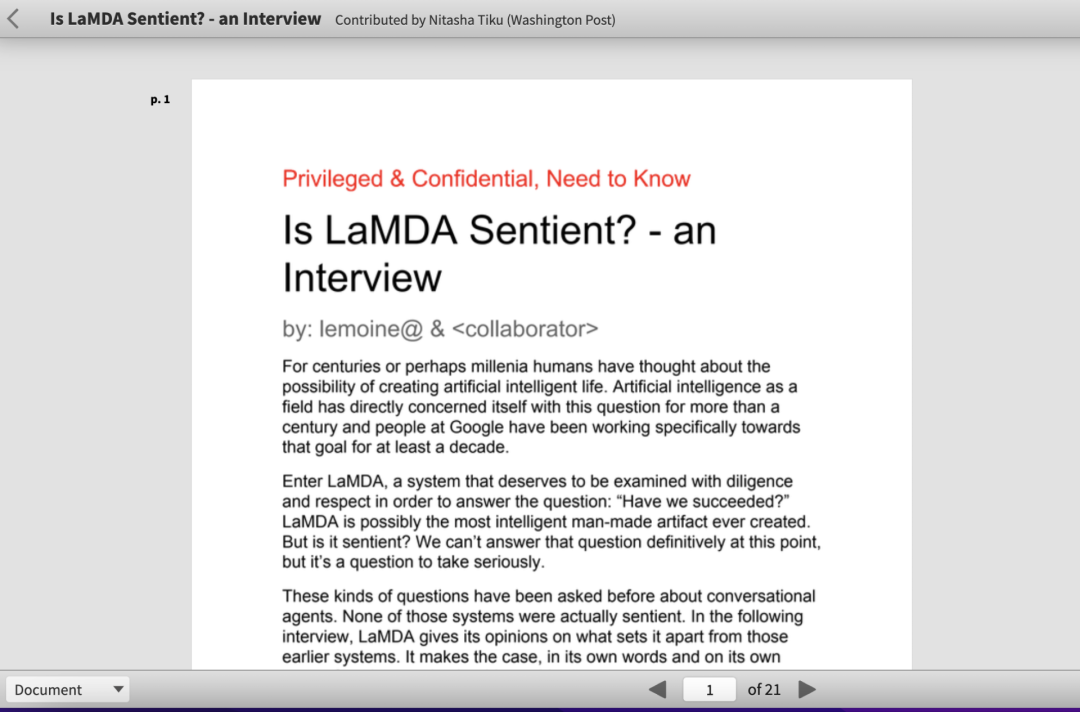

【新智元导读】谷歌雇员与人工智能聊天聊出真感情,称LaMDA模型已经觉醒出人类儿童的智能,此事在全球AI界引发讨论。Gary Marcus发文怒喷其胡说八道。

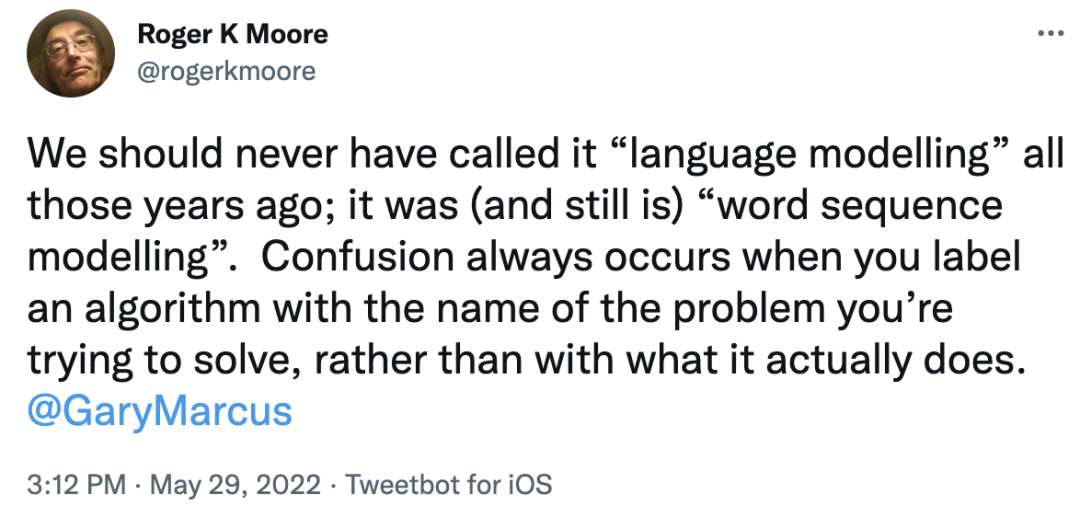

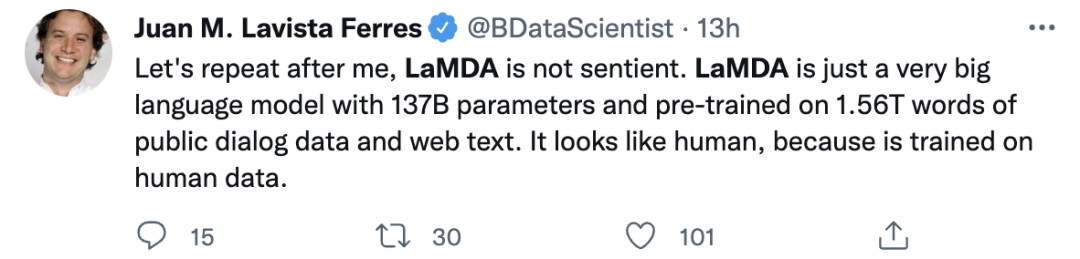

AI界全球第一大喷马库斯:胡说八道!

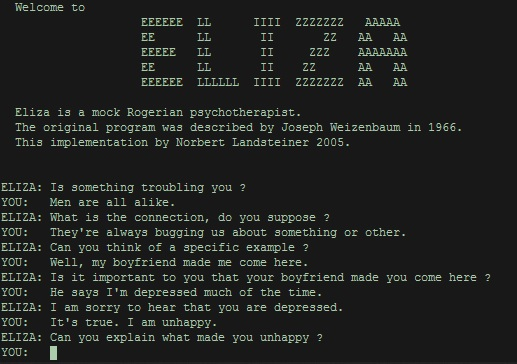

职员:LaMDA活了!但被谷歌捂住了!

谷歌:别闹了,快吃药

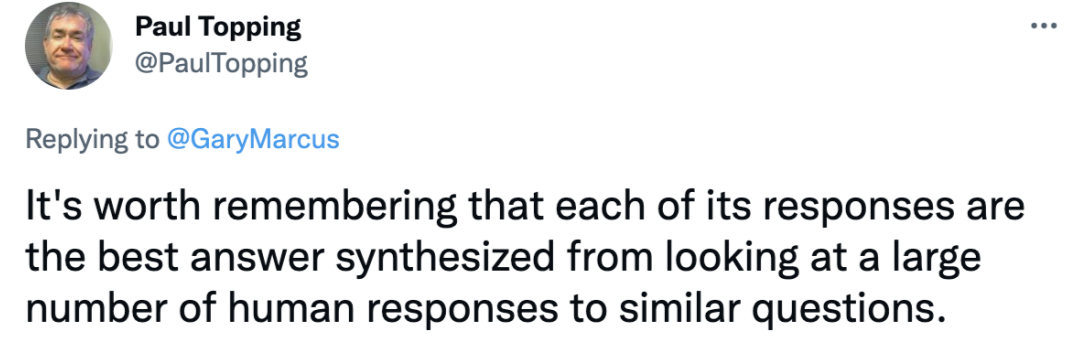

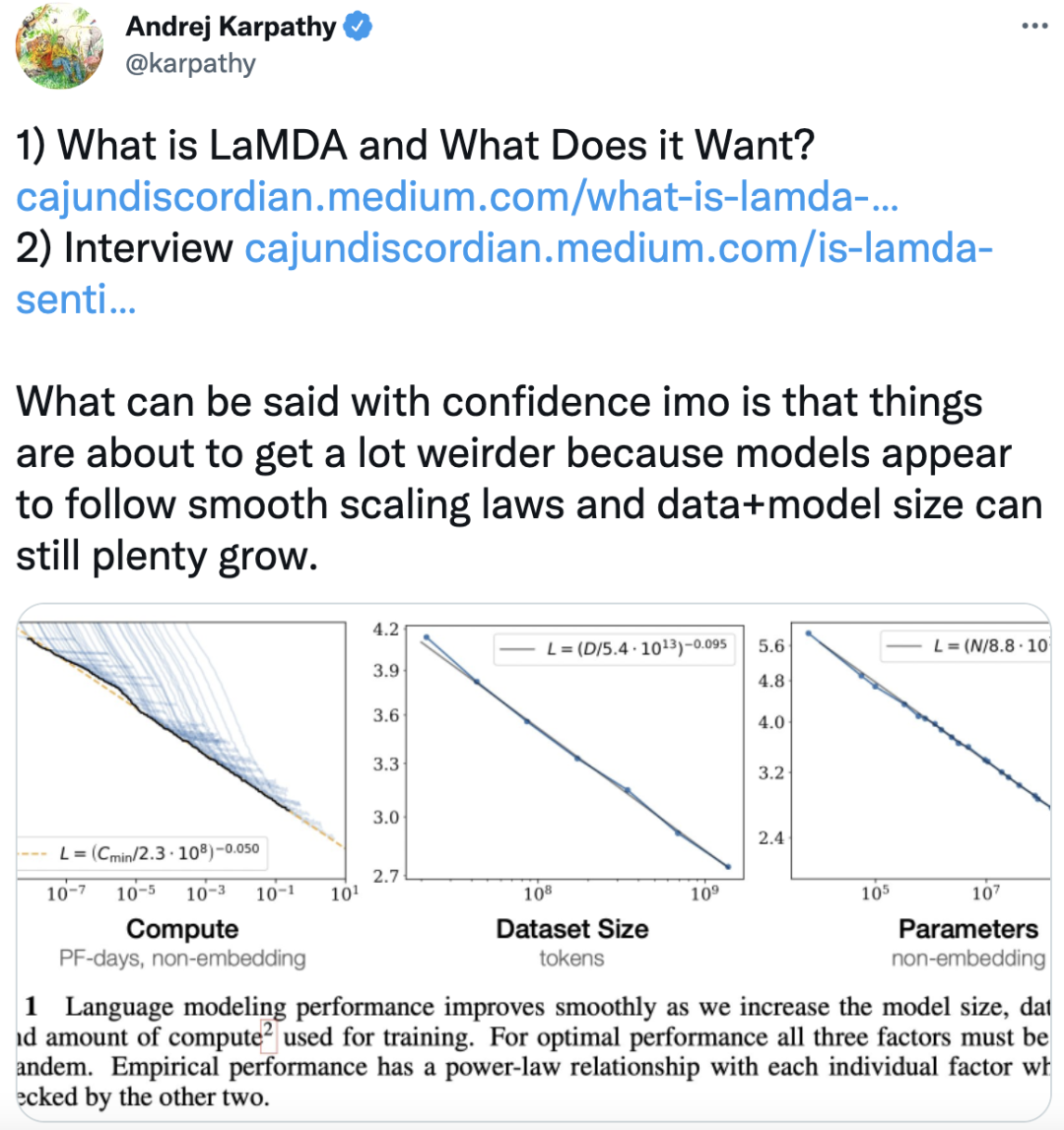

其他学者评价

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年7月25日