模拟大脑功能,这个AI模型真正实现像人一样持续学习

选自techxplore

本文中,新加坡科技设计大学的研究团队设计了一个受人类大脑启发的 AI 模型,能够自然地进行持续学习,在没有存储数据的类增量学习场景中也表现得很好。

正如图像处理、智能医疗、自动驾驶汽车和智慧城市等各个 AI 领域的突破所展现的那样,深度学习无疑正在经历着黄金期。在未来十年左右,AI 和计算机系统将最终具备类人的学习和思考能力,以处理持续的信息流,与现实世界进行交互。

但是,当前的 AI 模型在连续进行新信息训练时会遭受性能损失。这是因为每当生成新数据时,都会在已有数据之上写入,从而擦除以前的信息。这种效应被称为「灾难性遗忘」。稳定性 - 可塑性困境导致 AI 模型需要更新其记忆以不断地适应新信息,同时保持当前知识的稳定性。这一问题阻止了 SOTA AI 模型持续地从现实世界信息中学习。

同时,边缘计算系统允许将计算从云存储和数据中心转移到原始来源附近,例如连接物联网的设备。在资源有限的边缘计算设备上高效地应用持续学习仍然是一个挑战,尽管领域内也提出了很多持续学习模型来解决这一问题。传统模型需要高计算能力和大存储容量。

最近,新加坡科技设计大学(SUTD)的一个研究团队设计了一种能够实现高能效持续学习系统的新型模型,研究《Continual Learning Electrical Conduction in Resistive-Switching-Memory Materials》发表在了期刊《先进理论与模拟》上。

论文地址:https://onlinelibrary.wiley.com/doi/abs/10.1002/adts.202200226

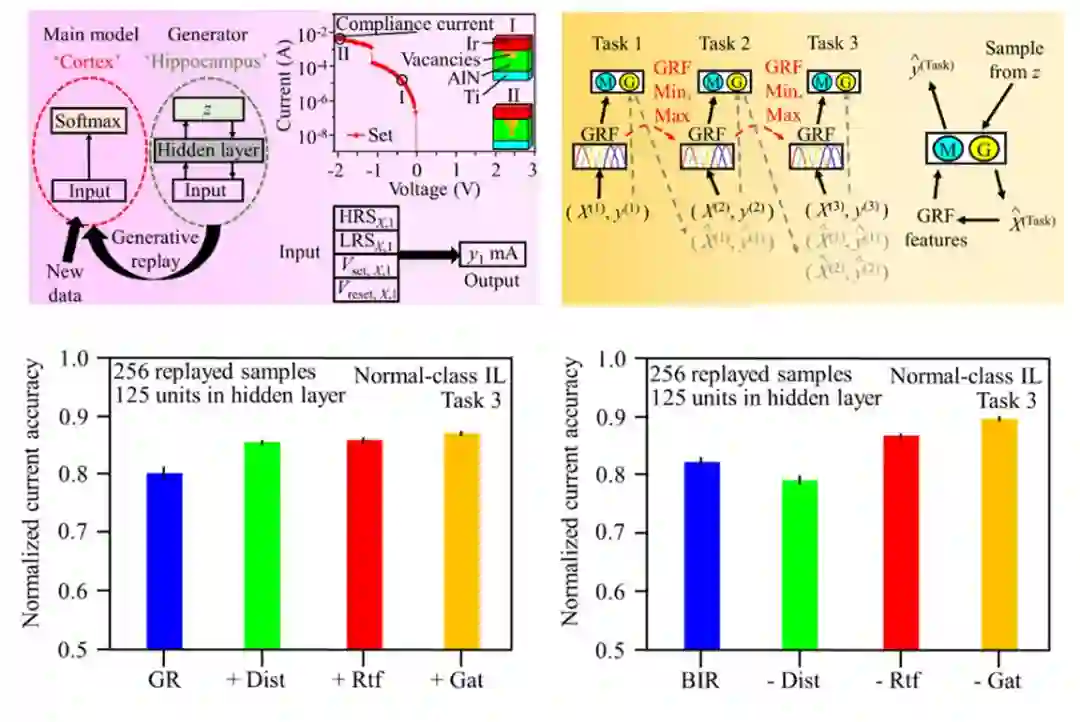

该团队提出一种受大脑启发的模型—Brain-Inspired Replay(BIR),它可以自然地进行持续学习。BIR 模型基于人工神经网络和变分自编码器来模拟人类大脑的功能,在没有存储数据的类增量学习场景中也能表现得很好。研究者还使用 BIR 模型来表示在数字存储系统中使用电流的导电丝生长。

下图左上为生成式回放设置,右上为训练具有生成式回放的人工神经网络;左下和右下分别为常规以及 BIR 模型的归一化电流精度。

论文通讯作者之一、助理教授 Loke 解释称,「在 BIR 中,知识被保存在训练过的模型中,从而在引入额外任务时将性能损失降至最低,并无需参考以往工作中的数据。因此,这种做法可以大量节能。」

他还补充道,「在无存储数据的情况下,在当前学习任务的合规性挑战上实现了 89% 的 SOTA 准确率,这比传统持续学习模型高了约两倍,并且实现了高能效。」

此外,为了使 BIR 模型能够独立处理现实世界的现场信息,该团队计划在下一阶段的研究中扩展它的可调能力。

Loke 表示,这项研究基于小规模演示,仍处于早期阶段。不过,采用这种方法有望使得边缘 AI 系统在无人类控制的情况下独立发展。

原文链接:https://techxplore.com/news/2022-08-strategies-humans.html

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com