编辑:袁榭 好困

【新智元导读】为了克服现下大型神经网络模型一跑就要大量耗电的弊端,德国与瑞士研究者在仿照人脑架构的神经拟态芯片上获得突破,有望以此芯片用当下千分之一的能耗运行未来大型AI。

作为如今最成功的人工智能算法,人工神经网络,可以松散地模拟了人脑中真实神经网络的复杂链接。

于是,神经拟态计算应运而生,这种技术更贴近模仿了人脑的运作机理与物理定律。

然而,由于器件失配难题,模拟神经元的质性会与设计略有不同,且电压和电流水平在不同的神经元之间也有差异。

相比之下,AI算法的训练则是在具有完全一致的数字神经元的计算机上完成的。

因此,实际在神经拟态芯片上运行时,经常会出现「水土不服」的问题。

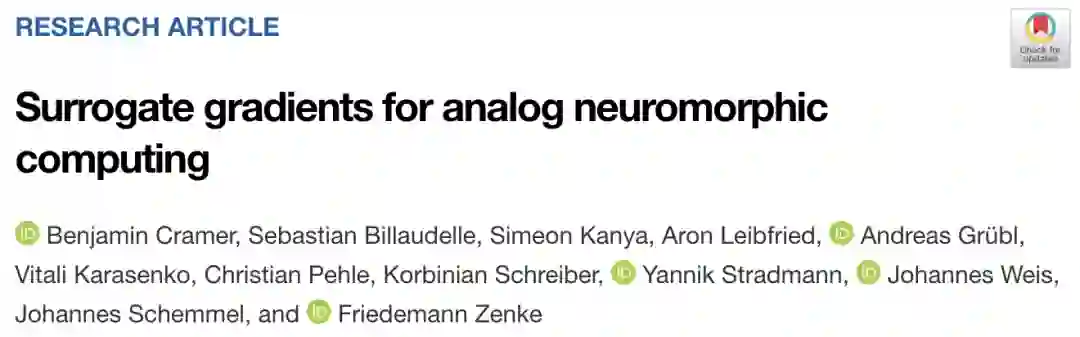

2022年1月在美国国家科学院院刊上发布的一篇论文,揭示了绕过此难题的一种途径。

论文链接:

https://www.pnas.org/content/119/4/e2109194119

由瑞士弗雷德里希米歇尔生物医疗研究所的研究者弗里德曼·曾克,与德国海德堡大学的研究者约翰内斯·希密尔联合组成的团队,在脉冲神经网络这一类型的AI算法上获得新进展。

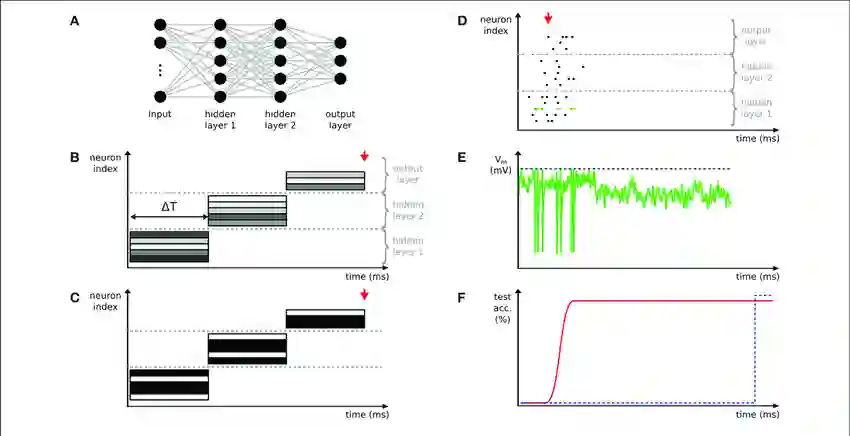

脉冲神经网络使用模仿人脑中的特色脉冲交流讯号,可以在神经拟态芯片上运行,学会如何代偿芯片中的器件失配。

与现有AI运行设备不同,神经拟态计算并不将数据在长间隔距离的CPU与存储卡之间搬运。

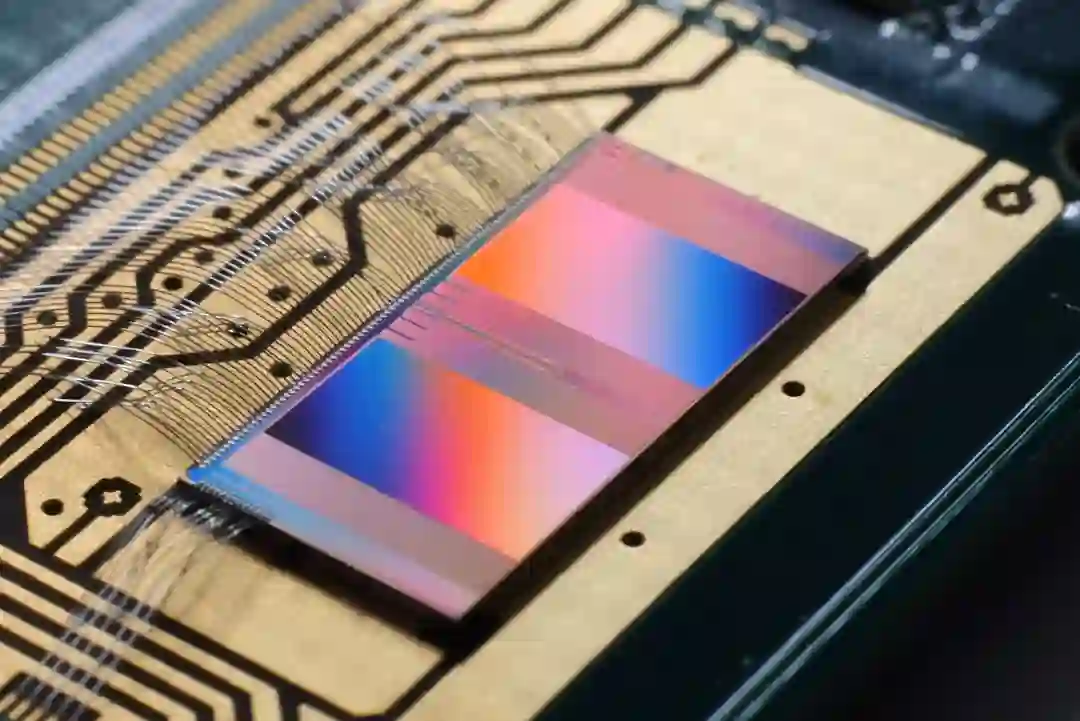

神经拟态芯片设计模仿果冻般人脑的基础架构,将计算单元(神经元)置于存储单元(连接神经元的突触)旁边。

为了让设计更像人脑,研究者将神经拟态芯片结合模拟计算,如此能像真实神经元一样处理持续不断的信号。

这样产出的芯片,与现下依赖处理0与1的二元基础信号的数码计算模式和架构,有显著不同。

以人脑作为设计指南,神经拟态芯片承诺有朝一日终结AI等大数据量运算工作的高耗能。不幸的是,AI算法在神经拟态芯片的模拟版本上运行效果不佳。

这是因为器件失配的缺陷:在生产过程中,芯片里模拟神经元的微型组件大小出现不匹配。

由于单个芯片不足以运行最新的AI训练过程,算法必须在传统计算机上进行预训练。

但之后将算法转输到芯片上时,一旦遇上模拟硬件不匹配的问题,算法就两眼一抹黑了。

基于人脑设计的计算模式是模拟计算而非数码计算,这点差别微妙而关键。

数码计算只能有效呈现人脑脉冲信号的二元性方面:脉冲信号作为一道冲过神经元的电信号,状态具有二元性,要么输出了,要么没输出,这就是0与1的区别。

不过事实上因为人脑细胞中有电压变化,当细胞内电压超过比细胞外电压高到一定程度的特定阈值,就会输出脉冲。

如此一来,脉冲是在一定时段内持续不绝地输出的,而且神经元决定输出脉冲的状态也是持续不绝的,这其实是一种模拟信号的状态。

瑞士苏黎世联邦理工学院的神经拟态工程研究者夏洛特·弗伦克尔说:「模拟态体现了人脑运算模式的核心之美。成功效仿人脑的这一关键方面,将是神经拟态运算的主驱动因素之一。」

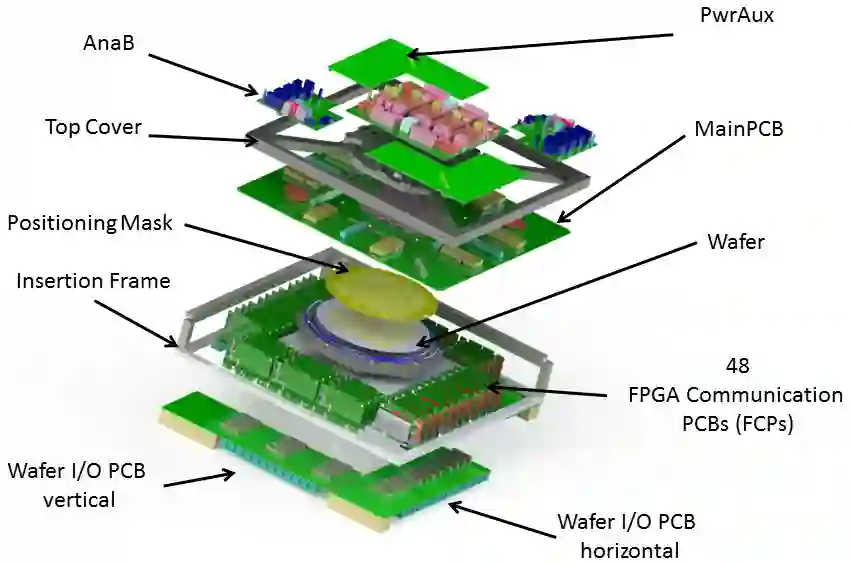

2011年,海德堡大学的一组研究人员开始开发一种既有模拟态又有数码态的神经拟态芯片,为神经科学实验模拟大脑。

此后,团队又发布了新一版的芯片「BrainScaleS-2」,其中每个模拟神经元都模拟了脑细胞的输入-输出电流和电压变化。

不过,由于材质的导电质性不同于真人脑,芯片在速度上要比人脑快1000倍。

在这项新的工作中,通过将芯片纳入算法的训练过程,脉冲神经网络可以学习如何纠正BrainScaleS-2芯片上的电压差别。

为了处理器件失配的问题,团队还专门为脉冲神经网络开发了全新的方法,将芯片用梯度替代法这种学习方法与计算机交互。

梯度替代法通过持续改变神经元之间的连接,来尽量减少神经网络在执行任务中的错误数量(类似于非脉冲神经网络使用的反向传播)。

梯度替代法能够在计算机上的训练过程中纠正芯片的不完善之处。

首先,让脉冲神经网络利用芯片上模拟神经元的不同电压执行一项简单的任务,并将电压的记录发回计算机。

然后,让算法自动学习如何最好地改变其神经元之间的连接,以便仍能与模拟神经元很好地配合,在学习的同时持续更新芯片上的神经元。

最终,当训练完成后,脉冲神经网络就能在芯片上顺利地执行任务了。

研究人员表示,他们的神经网络在语音和视觉任务上,达到了与在计算机上执行任务的顶级脉冲神经网络相同的准确性。

换句话说,该算法准确地了解到它需要做哪些改变来克服器件失配的问题。

苏塞克斯大学的计算神经科学家托马斯·诺沃特尼表示:「这个系统正如预期的那样具有令人印象深刻的能效:运行所消耗的能量比标准处理器少1000倍左右。」

然而,弗伦克尔指出,神经拟态芯片仍然需要在为类似的语音和视觉识别任务而特别优化的硬件面前证明自己。

诺沃特尼也指出,这种方法可能难以扩展到大型的实际任务,因为它仍然需要在计算机和芯片之间来回搬运数据。

团队的终极目标则是让脉冲神经网络可以自始至终地在神经拟态芯片上训练和运行,而不需要借助传统计算机。

不过,设计并生产所需的新一代芯片可能要数年的时间。

瑞士苏黎世弗雷德里希米歇尔生物医疗研究所的神经计算科学家。主研究方向为仿生的脉冲神经网络的学习、记忆、信息处理过程,以及机器学习与神经计算科学的交汇。

德国海德堡大学物理学院专用集成电路实验室主任、电子视觉研究组负责人。研究方向是混合态超大规模集成电路系统的信息处理应用,特别是仿生神经网络模型的模拟应用方向。

参考资料:

https://www.quantamagazine.org/ai-overcomes-stumbling-block-on-brain-inspired-hardware-20220217/

![]()

![]()