堪比当年的LSTM,Transformer引燃机器学习圈:它是万能的

作者|魔王

来源|机器之心

论文:Taming Transformers for High-Resolution Image Synthesis

链接:https://arxiv.org/pdf/2012.09841v1.pdf

论文:TransTrack: Multiple-Object Tracking with Transformer

链接:https://arxiv.org/pdf/2012.15460v1.pdf

论文:Compound Word Transformer: Learning to Compose Full-Song Music over Dynamic Directed Hypergraphs

链接:https://arxiv.org/pdf/2101.02402v1.pdf

论文:Dance Revolution: Long-Term Dance Generation with Music via Curriculum Learning

链接:https://arxiv.org/pdf/2006.06119v5.pdf

论文:Self-Attention Based Context-Aware 3D Object Detection

链接:https://arxiv.org/pdf/2101.02672v1.pdf

论文:PCT: Point Cloud Transformer

链接:https://arxiv.org/pdf/2012.09688v1.pdf

论文:Temporal Fusion Transformers for Interpretable Multi-horizon Time Series Forecasting

链接:https://arxiv.org/pdf/1912.09363v3.pdf

论文:VinVL: Making Visual Representations Matter in Vision-Language Models

链接:https://arxiv.org/pdf/2101.00529v1.pdf

论文:End-to-end Lane Shape Prediction with Transformers

链接:https://arxiv.org/pdf/2011.04233v2.pdf

论文:Deformable DETR: Deformable Transformers for End-to-End Object Detection

链接:https://arxiv.org/pdf/2010.04159v2.pdf

... is All You Need?

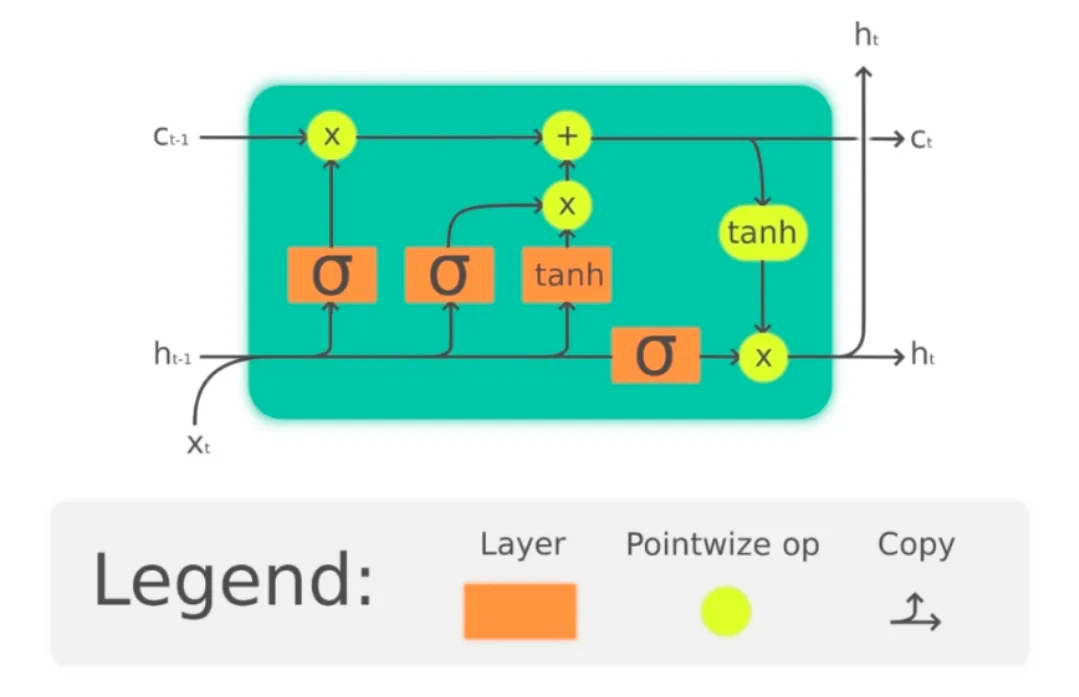

Transformer是新的LSTM吗?

https://paperswithcode.com/newsletter/3

https://twitter.com/hardmaru

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。