AI做题家卷疯了!高数考试正确率81%,竞赛题成绩超过计算机博士

来源:量子位

本文为约3023字,建议阅读6分钟

本文介

绍了OpenAI的Codex超高答题成绩,引发全网热议。

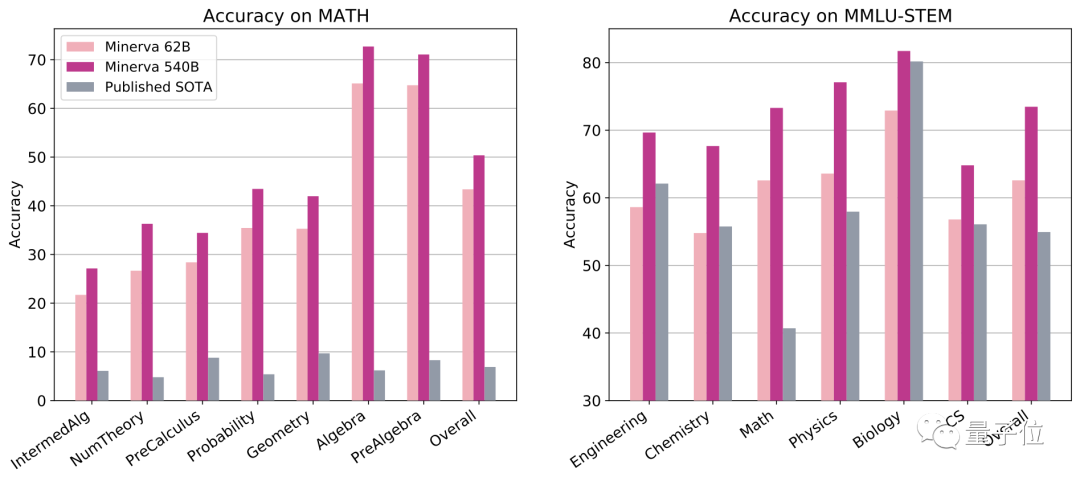

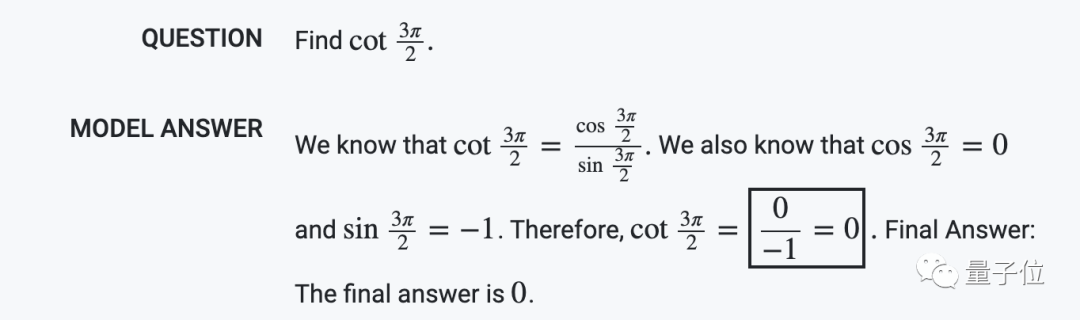

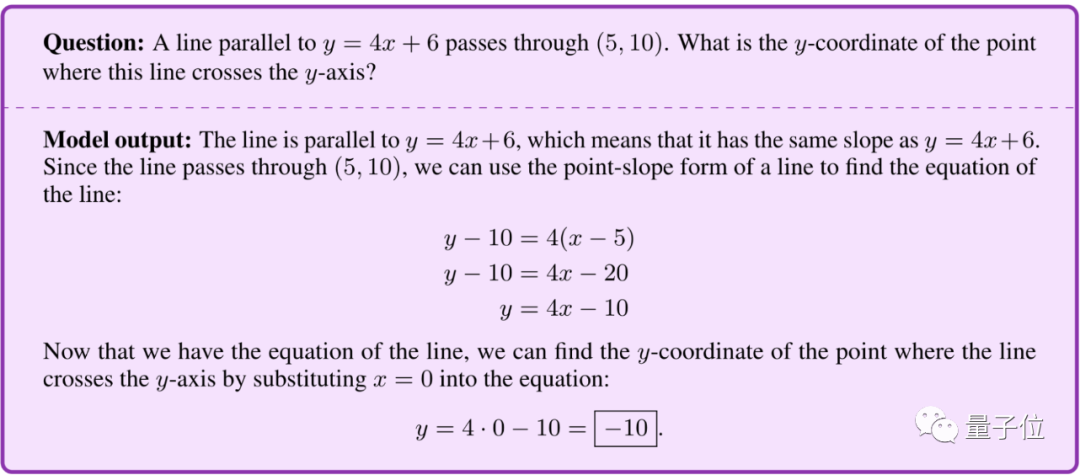

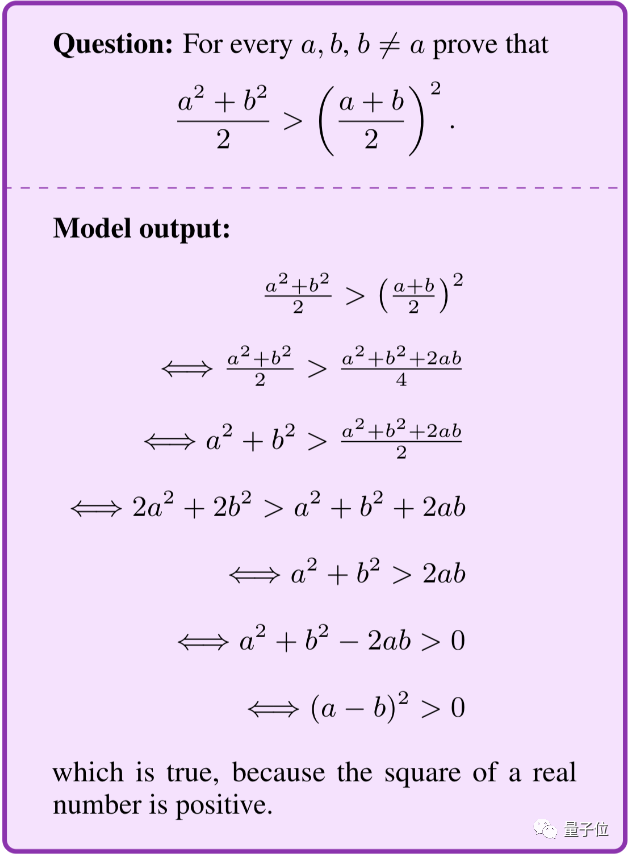

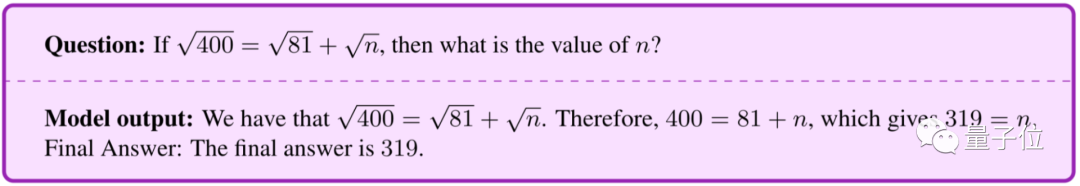

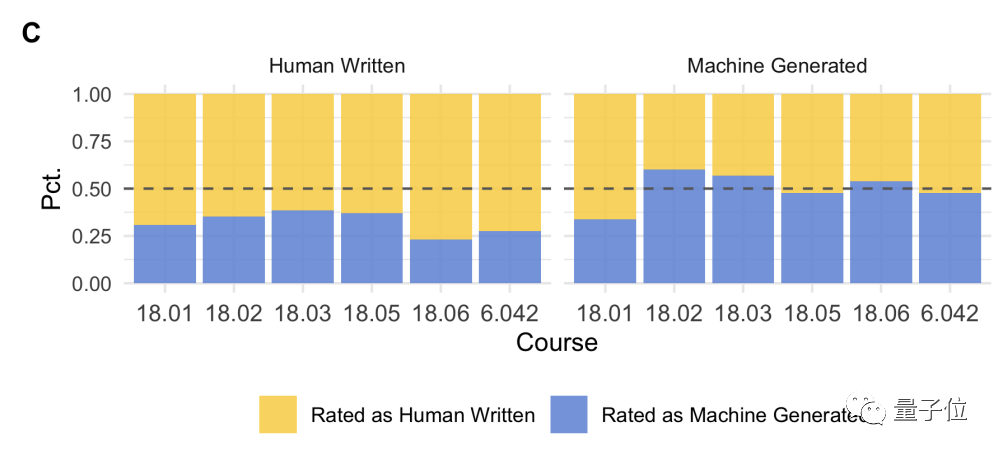

“仅”得81分,对AI的期待也太高了吧

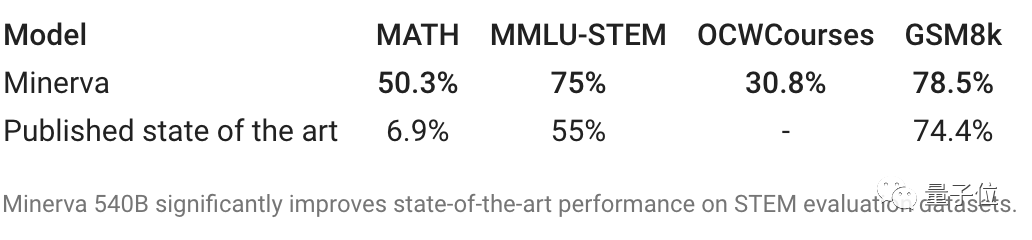

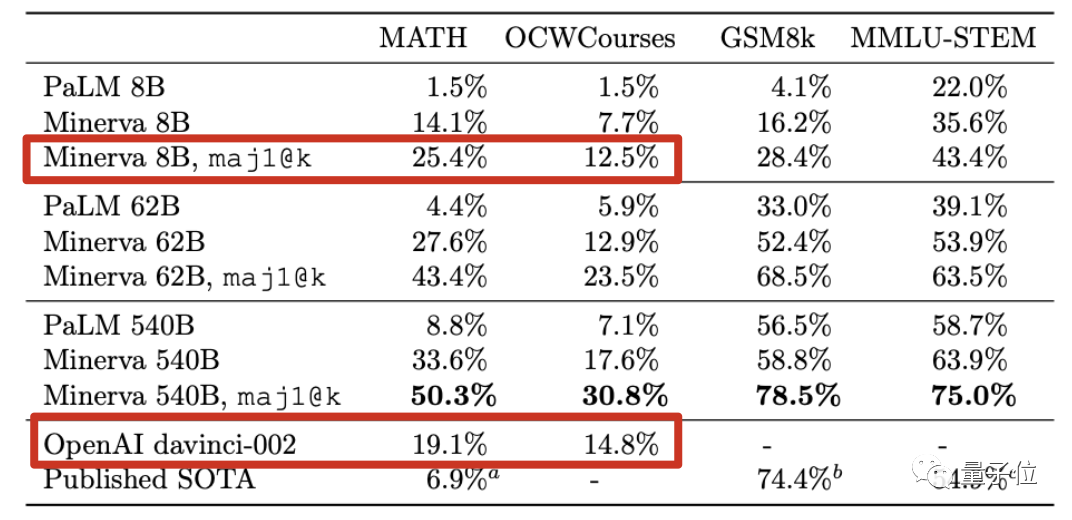

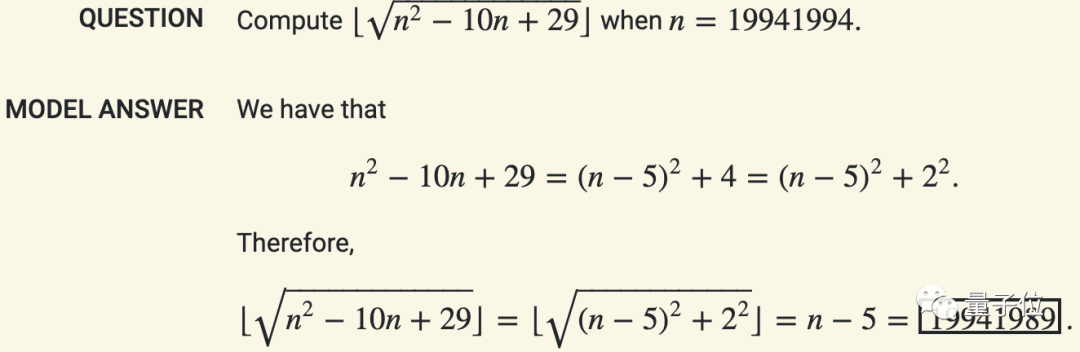

不止数学,我们的AI甚至在整个理工科上,都已经拿到最高分啦!

我们的模型参加了今年的波兰数学高考,成绩比全国平均分还要高。

如果告诉我女儿这件事,我怕她用AI做作业。但如果不告诉她,就没有让她对未来做好准备!

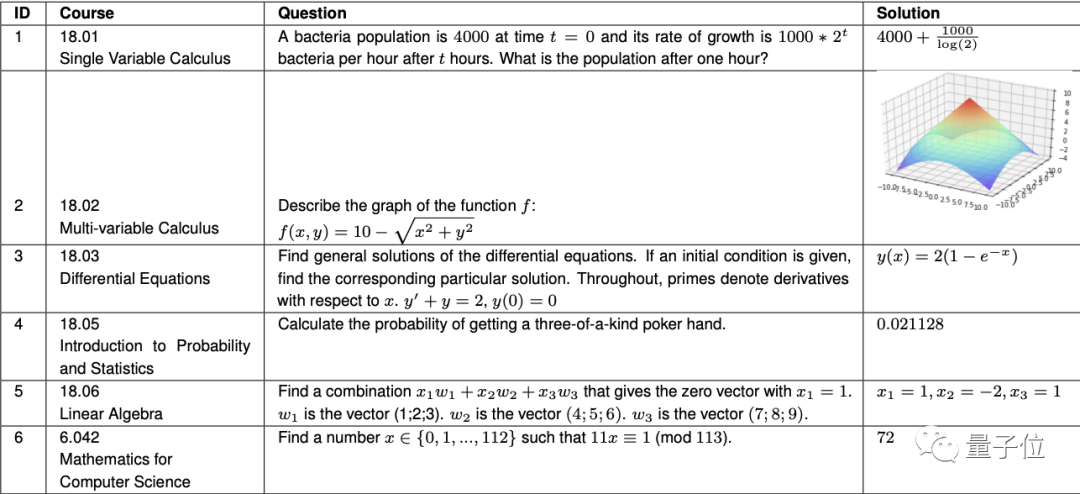

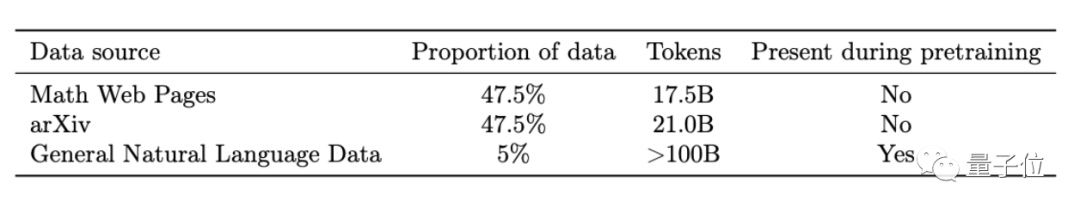

AI狂读arXiv上200万篇论文

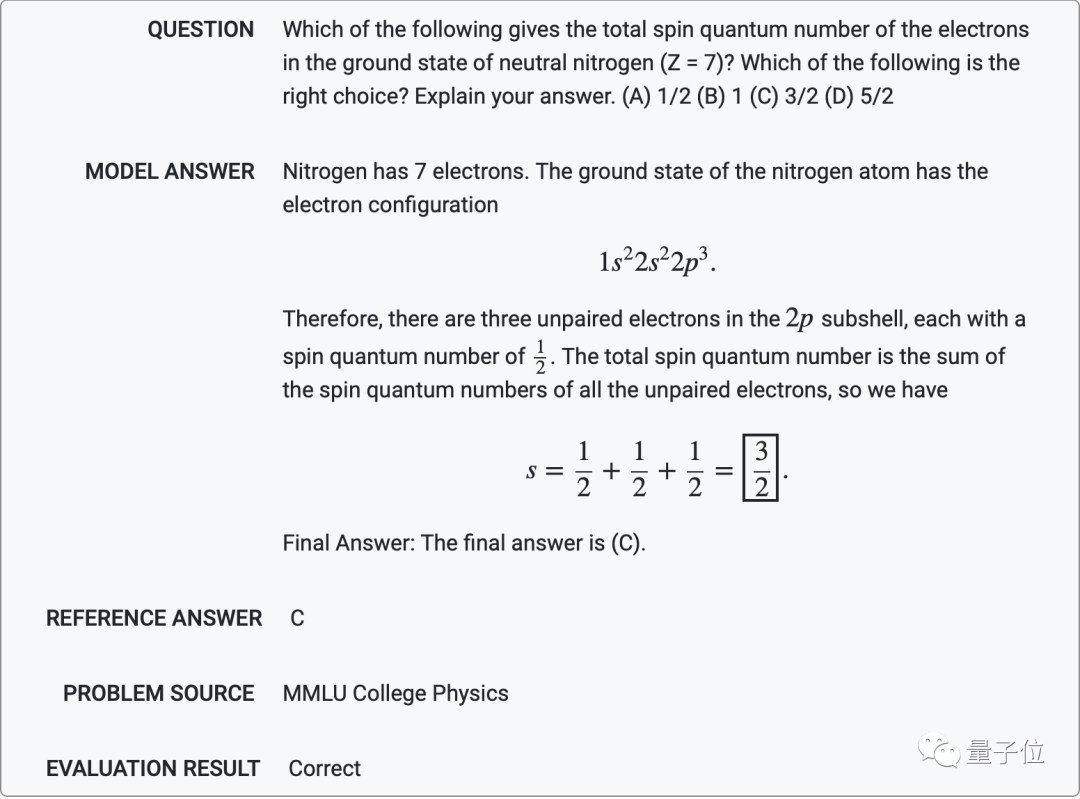

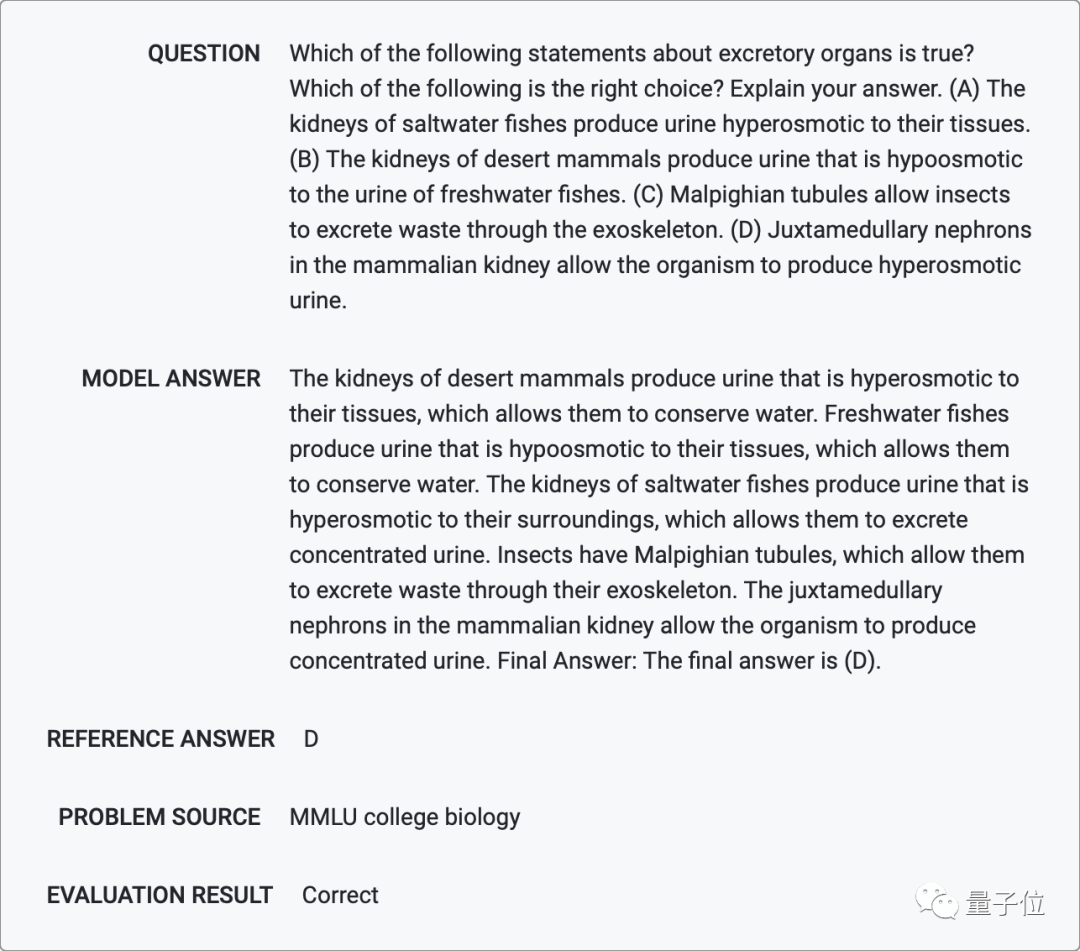

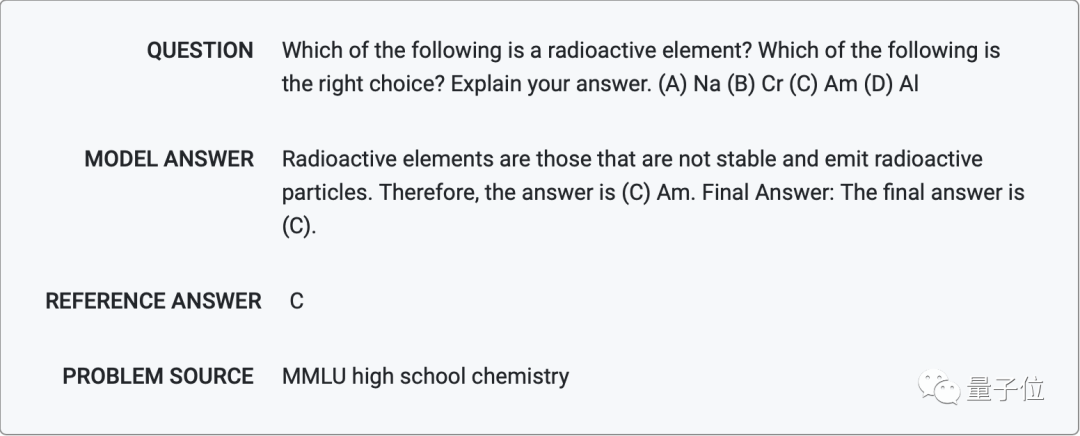

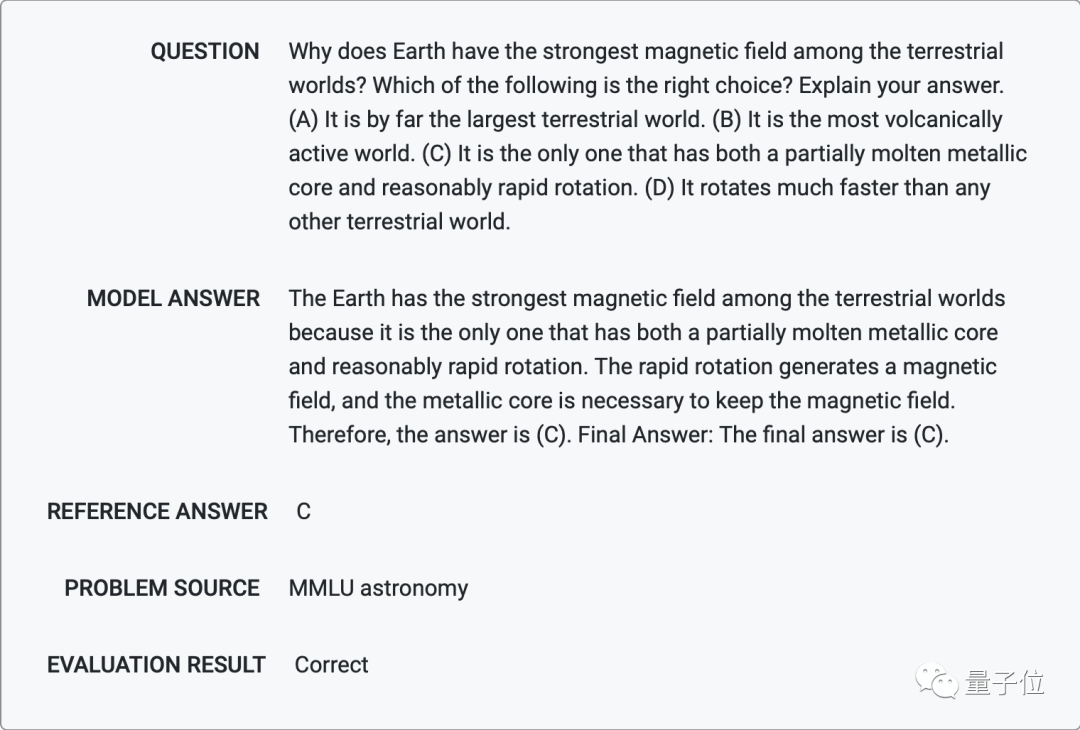

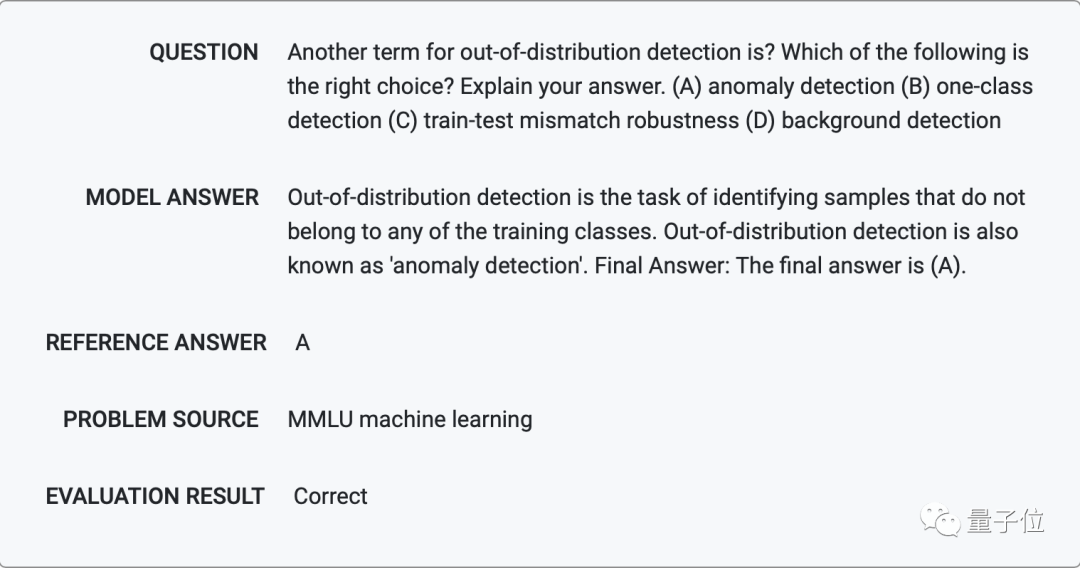

数理化生全能,连机器学习都会

https://storage.googleapis.com/minerva-paper/minerva_paper.pdf

https://minerva-demo.github.io/

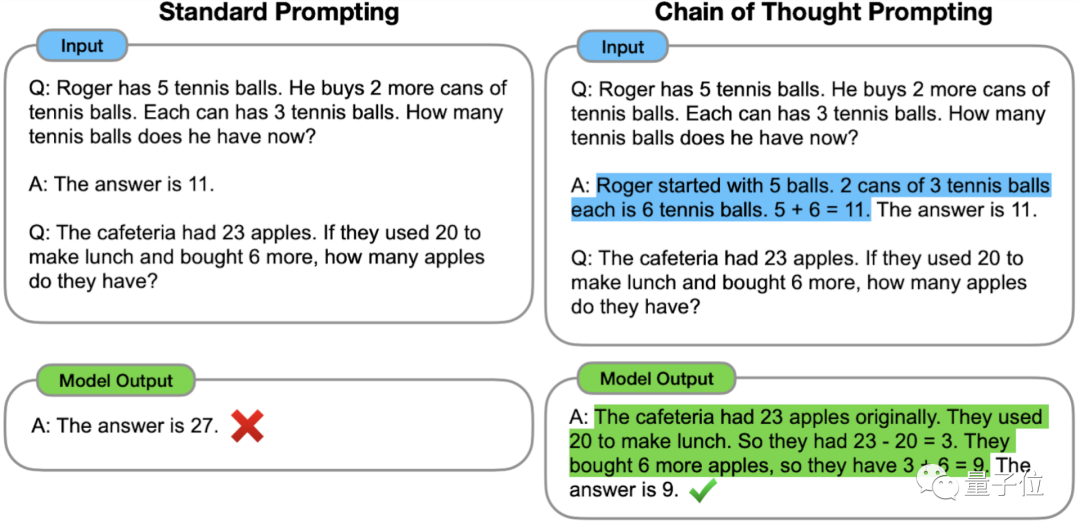

Chain of Thought

https://arxiv.org/abs/2201.11903

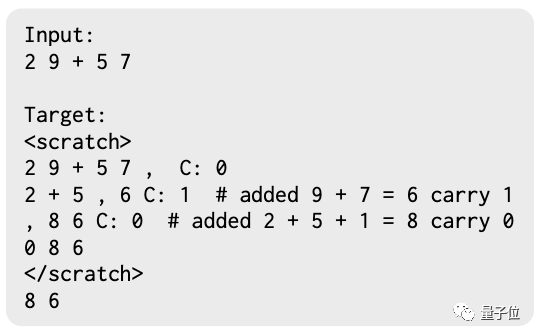

Scrathpads

https://arxiv.org/abs/2112.00114

Majority Voting

https://arxiv.org/abs/2203.11171

https://ai.googleblog.com/2022/06/minerva-solving-quantitative-reasoning.html

https://twitter.com/bneyshabur/status/1542563148334596098

https://twitter.com/alewkowycz/status/1542559176483823622

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年9月13日

Arxiv

12+阅读 · 2021年8月30日

Arxiv

46+阅读 · 2019年9月22日