ICLR 2018接收论文公布—“GANs 之父”Goodfellow四篇论文被接受为Poster Papers。

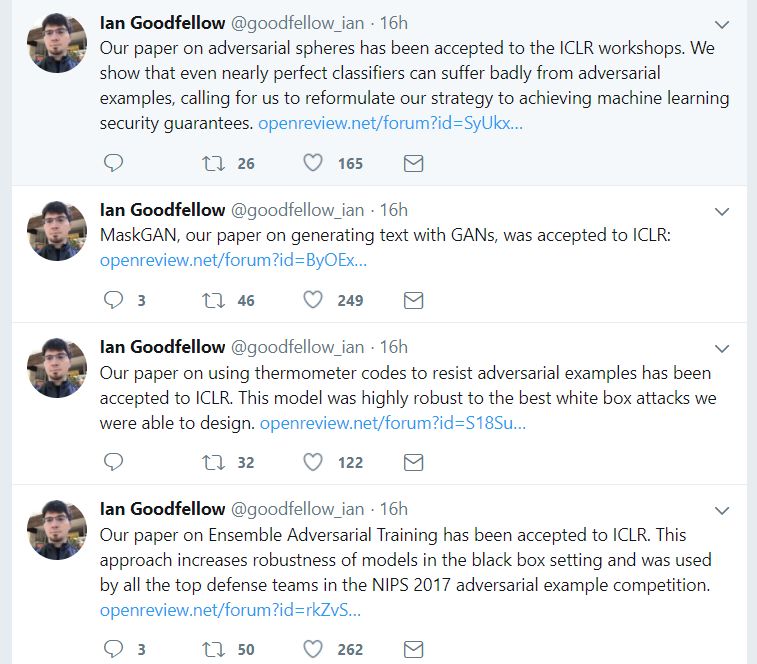

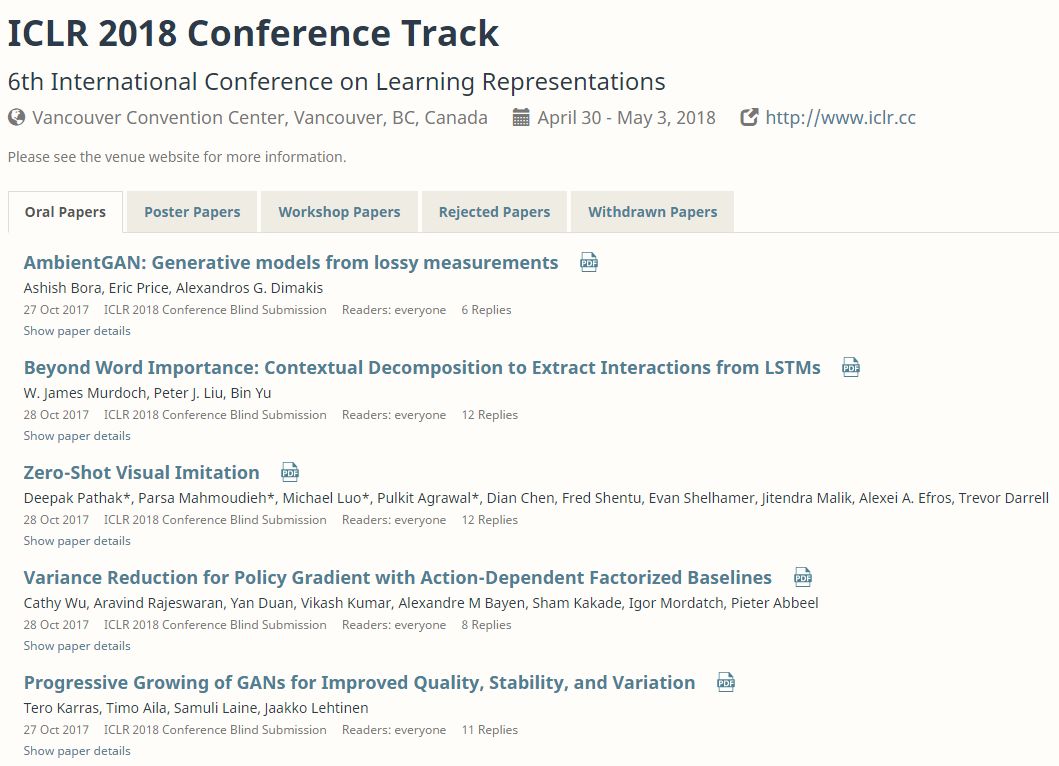

ICLR,全称为「International Conference on Learning Representations」(国际学习表征会议),2013 年才刚刚成立了第一届。这个一年一度的会议虽然今年2017年办到第六届,已经被学术研究者们广泛认可,被认为「深度学习的顶级会议」。今年共接收到了 900多篇有效论文,同比增加一倍去年 11 月,评审结果出炉,ICLR 2018共有23篇论文入围Oral Papers,314篇论文获评Poster Papers,90篇论文被选为Workshop Papers,508篇论文被拒,63篇论文撤回。“GANs 之父”Goodfellow有四篇论文被接受为Poster Papers。

论文接收列表:

https://openreview.net/group?id=ICLR.cc/2018/Conference

接受论文为:

1. Many Paths to Equilibrium: GANs Do Not Need to Decrease a Divergence At Every Step

William Fedus, Mihaela Rosca, Balaji Lakshminarayanan, Andrew M. Dai, Shakir Mohamed, Ian Goodfellow

论文链接:https://openreview.net/pdf?id=ByQpn1ZA-

2. Ensemble Adversarial Training: Attacks and Defenses

Florian Tramèr, Alexey Kurakin, Nicolas Papernot, Ian Goodfellow, Dan Boneh, Patrick McDaniel

论文链接:https://openreview.net/pdf?id=rkZvSe-RZ

3. Thermometer Encoding: One Hot Way To Resist Adversarial Examples

Jacob Buckman, Aurko Roy, Colin Raffel, Ian Goodfellow

论文链接:https://openreview.net/pdf?id=S18Su--CW

4. MaskGAN: Better Text Generation via Filling in the _______

William Fedus, Ian Goodfellow, Andrew M. Dai

论文链接:https://openreview.net/pdf?id=ByOExmWAb

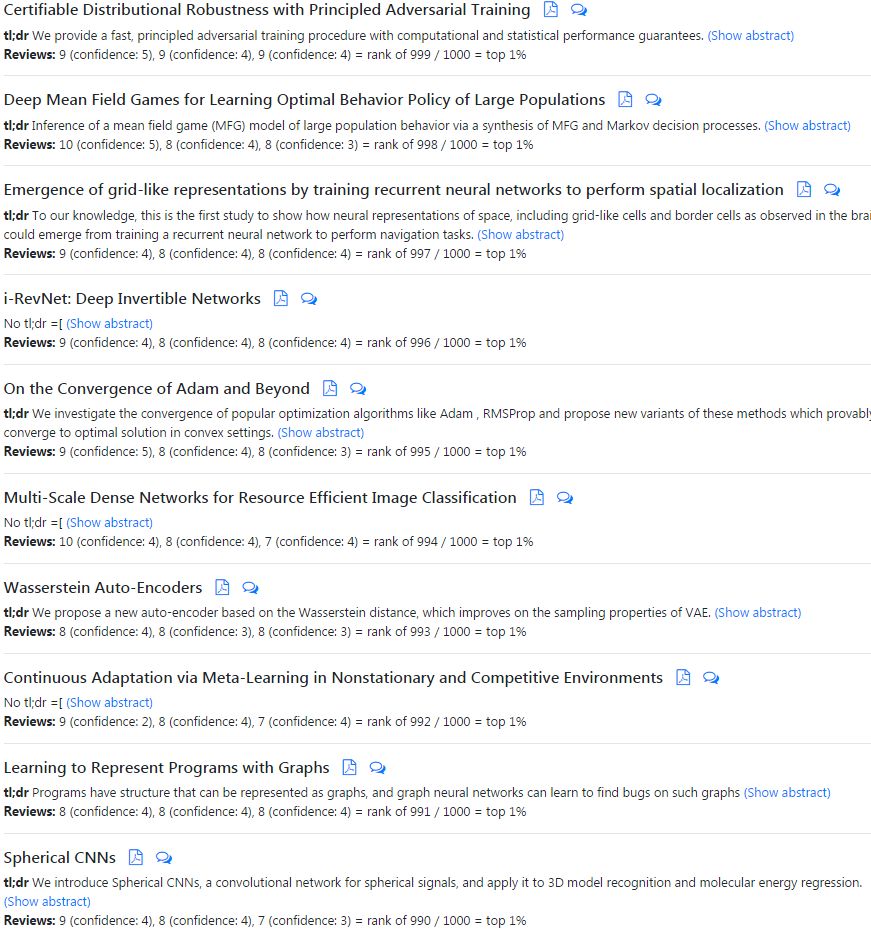

以下是评分排名较前的一些论文:

专知此前报道的论文 Certifiable Distributional Robustness with Principled Adversarial Training(利用分布鲁棒优化方法应对对抗样本干扰), 到目前为止仍然获得了最高的评分(9;9;9),在Oral Papers中,详细请查看:

【ICLR2018 最高分论文】利用分布鲁棒优化方法应对对抗样本干扰

【摘要】由于神经网络容易受到对抗样本的干扰,因此研究人员提出了许多启发式的攻击和防御机制。我们采用分布鲁棒优化的观点,保证对抗输入干扰下网络的性能。通过考虑拉格朗日惩罚公式在Wasserstein ball的源数据分布上的干扰,我们提供了一个训练过程,增强了训练数据在最坏情况干扰下的模型参数更新。对于光滑损失,我们的方法在保证中等程度的鲁棒性的同时,具有很小的计算或统计成本。此外,我们的统计保证我们的整体损失具有鲁棒性。我们达到或超越了监督和强化学习任务中的启发式方法。

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域26个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!

点击“阅读原文”,使用专知