超越ResNet:Res2Net;目标检测最新网络:FCOS ;何恺明最新论文:RandWire-WS

点击上方“CVer”,选择加"星标"或“置顶”

重磅干货,第一时间送达

前戏

昨天(2019-04-03) arXiv上放出了很多优质论文:各种顶会paper和顶会“种子”paper。这里为了节省篇幅,放大重点,Amusi做了论文精选。本文要速递介绍的这三篇论文,我觉得都是相当具有影响力的paper,相信对你当前的研究会有很大帮助。大家一定要耐心看完,放心点赞!

Res2Net

FCOS

RandWire-WS

Res2Net

《Res2Net: A New Multi-scale Backbone Architecture》

arXiv: https://arxiv.org/abs/1904.01169

github: 即将开源

作者团队:南开大学 & 加州大学美熹德分校 & 牛津大学

注:2019年04月03日刚出炉的paper

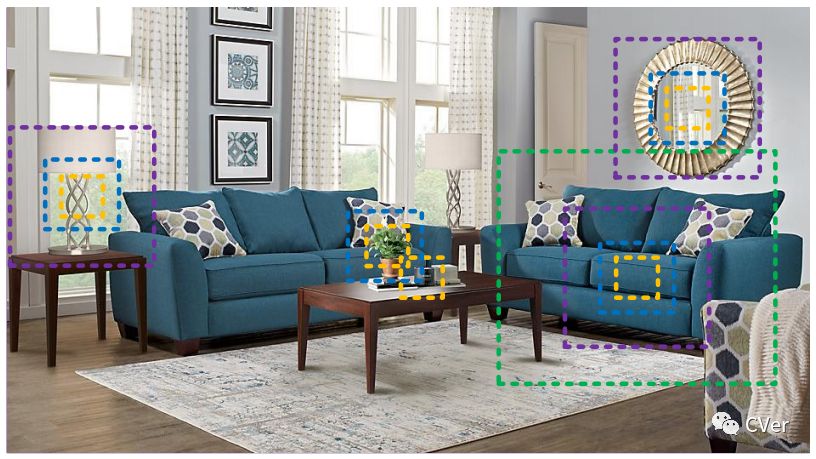

Abstract:在多个尺度上表示特征对于许多视觉任务非常重要。卷积神经网络(CNN) backbone 的最新进展不断展示出更强的多尺度表示能力,从而在广泛的应用中实现一致的性能提升。然而,大多数现有方法以分层方式(layer-wise)表示多尺度特征。在本文中,我们通过在一个单个残差块内构造分层的残差类连接,为CNN提出了一种新的构建模块,即Res2Net。Res2Net 以更细粒度(granular level)表示多尺度特征,并增加每个网络层的感受野(receptive fields)范围。所提出的Res2Net块可以融合到最先进的 backbone CNN模型中,例如ResNet,ResNeXt和DLA。我们在所有这些模型上评估 Res2Net 模块,并在广泛使用的数据集(例如CIFAR-100和ImageNet)上展示相对于基线模型的一致性能提升。关于代表性计算机视觉任务的进一步消融研究和实验结果,即目标检测,类激活 mapping 和显著目标检测,进一步验证了Res2Net相对于现有技术的基线方法的优越性。源码和训练模型将之后公开。

本文算法(Res2Net)

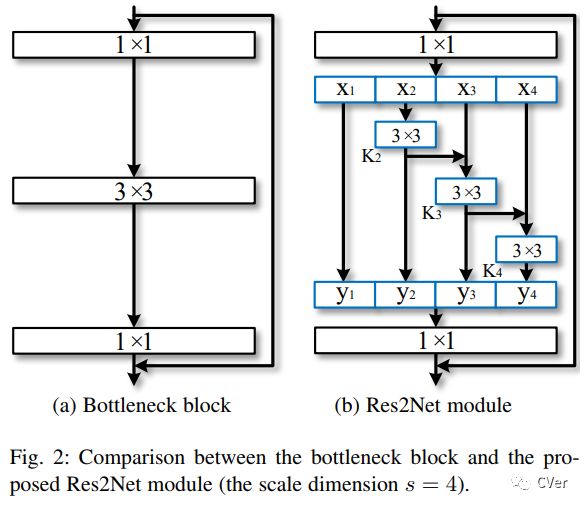

下左图是ResNet网络,右图是Res2Net,可以看出后者明显在残差单元(residual block)中插入更多带层级的残差连接结构(hierarchical residual-like connections)。

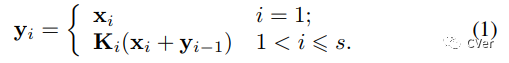

X、Y和K的关系:

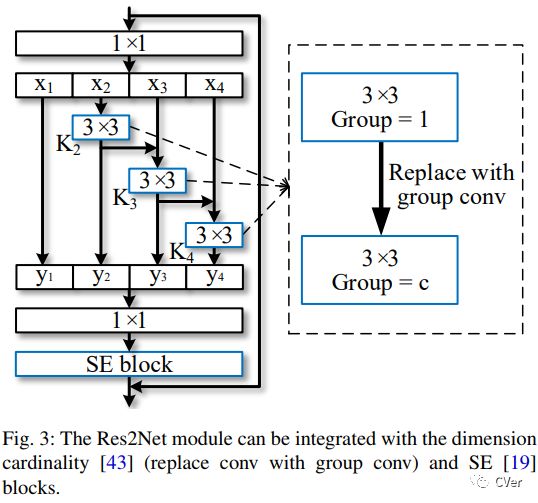

更有意思的是,Res2Net具有很强的"可玩性",可以用3x3的组卷积(group convolution)替代原3x3卷积,可以加入SE 单元(block)。

实验结果

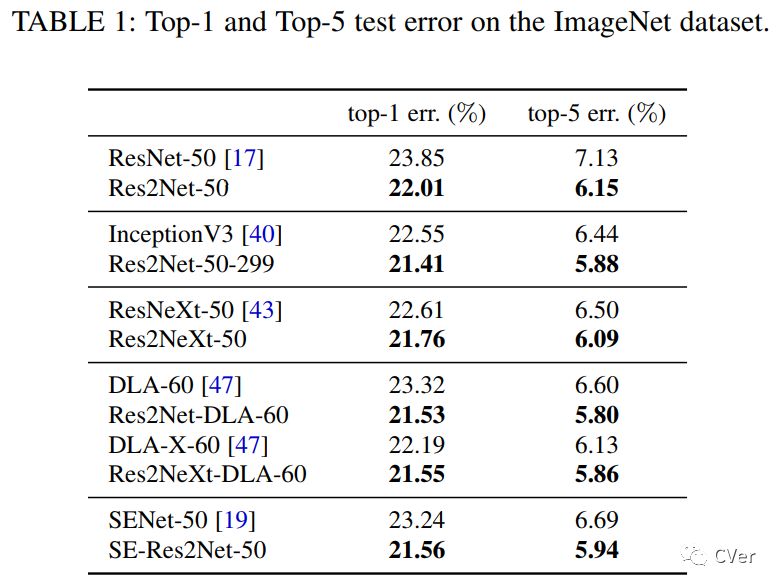

【0】在ImageNet数据集上的分类结果

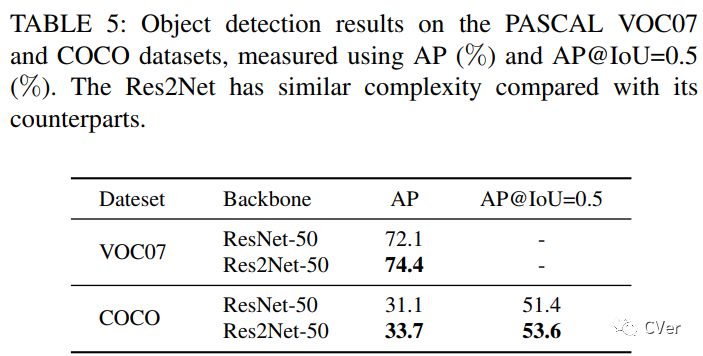

【1】在VOC和COCO数据集上的目标检测结果

注:Faster R-CNN为baseline

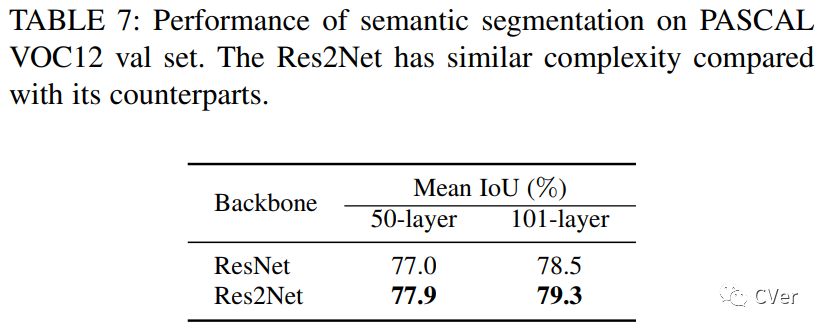

【2】在VOC上的语义分割结果

注:DeepLab v3+ 为baseline

FCOS

《FCOS: Fully Convolutional One-Stage Object Detection》

arXiv: https://arxiv.org/abs/1904.01355

github: None

作者团队:阿德莱德大学

注:2019年04月03日刚出炉的paper

Abstract:我们提出了一种全卷积的 one-stage 目标检测器(FCOS),以每像素预测方式解决目标检测,类似于语义分割。几乎所有最先进的目标检测器,如RetinaNet,SSD,YOLOv3和Faster R-CNN都依赖于预定义的锚框(anchor boxes)。相比之下,我们提出的检测器FCOS不需要锚框,即 proposal free。通过消除预定义的锚框,FCOS完全避免了与锚框相关的复杂计算,例如在训练期间计算重叠并且显著减少了训练内存。更重要的是,我们还避免了与锚框相关的所有超参数,这些参数通常对最终检测性能非常敏感。凭借唯一的后处理:非极大值抑制(NMS),我们的检测器FCOS优于以前基于锚框的one-stage探测器,具有更简单的优势。我们首次展示了一种更加简单灵活的检测框架,可以提高检测精度。我们希望提出的FCOS框架可以作为许多其他实例级任务的简单而强大的替代方案。

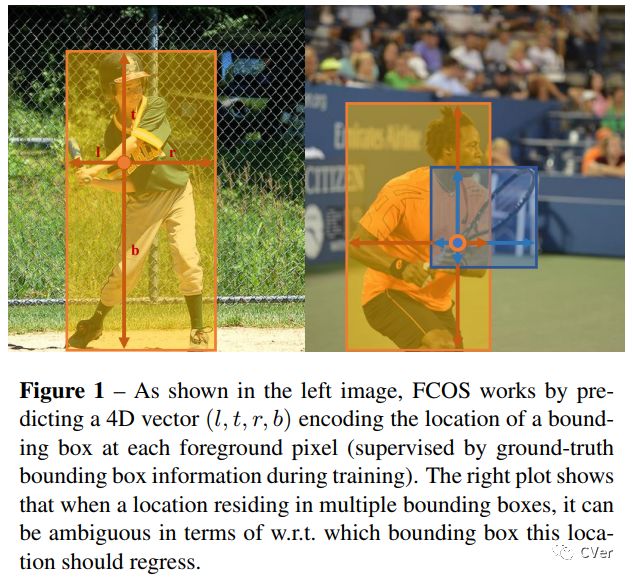

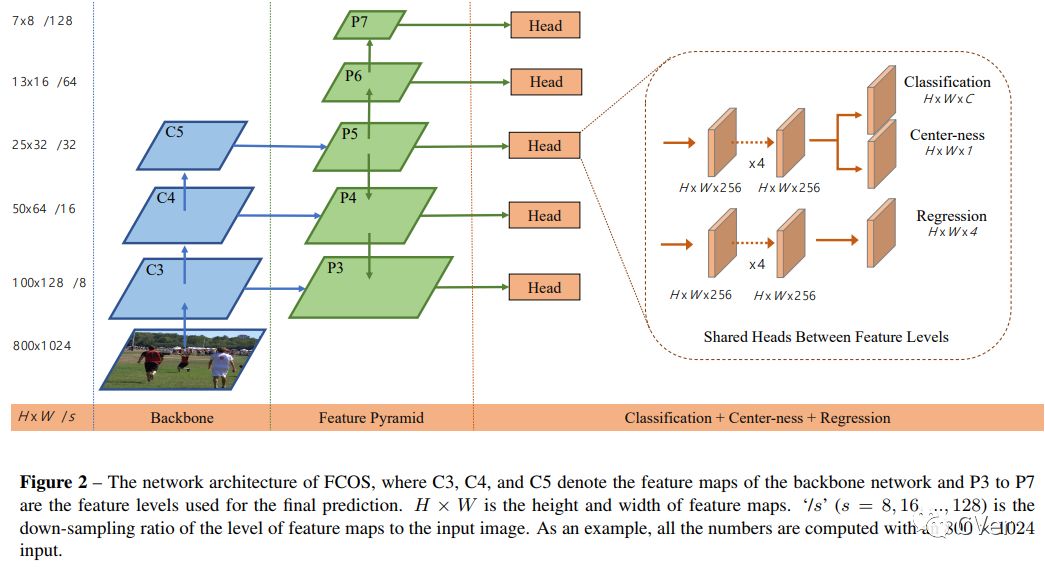

本文算法(FCOS)

下图是FCOS的网络框图,可以明显看到网络组合是:【Backbone】 + 【特征金字塔(Feature Pyramid)】+ 【Classification + Center-ness + Regression】

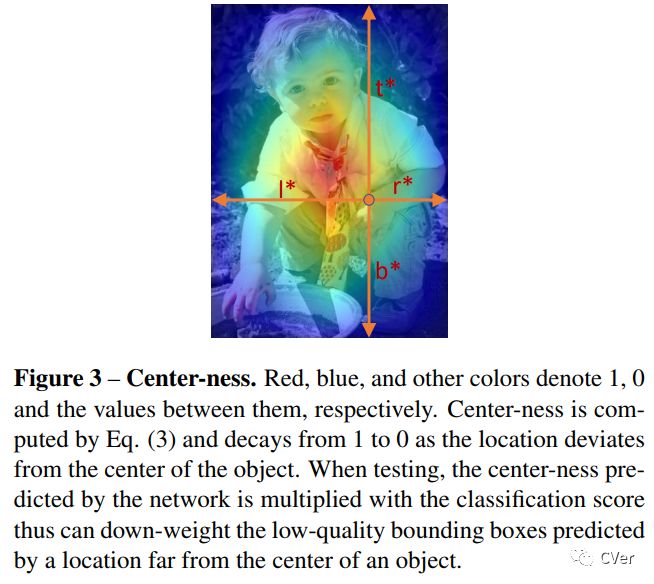

这里的 Center-ness 是全新的概念,也是论文的创新所在。另外敲重点,本文之所以独树一帜,是因为其 anchor-box free的思路

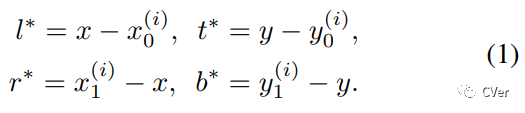

训练回归公式:

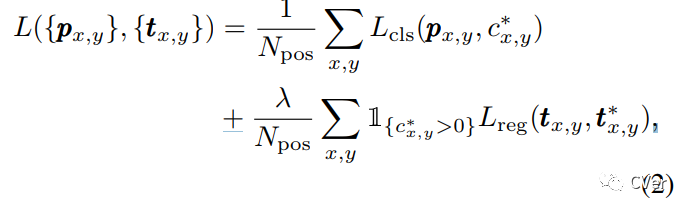

损失函数:

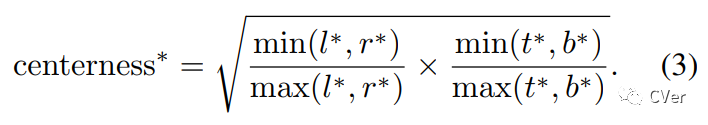

Center-ness:

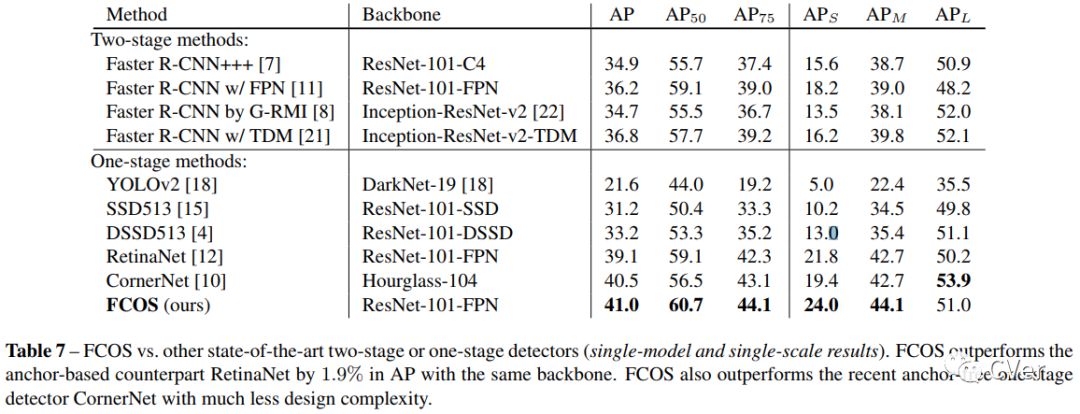

实验结果

在COCO数据集上,各种目标检测算法PK。FCOS已经超越 Two-stage的Faster R-CNN,还超越了 One-stage的YOLOv2、SSD、RetinaNet,已经很新的CornerNet。

吐槽一下:FCOS真的很强,但为啥不放速度比较呢?难道One-stage 目标检测已经不注重 mAP/Speed的 trade-off了么?

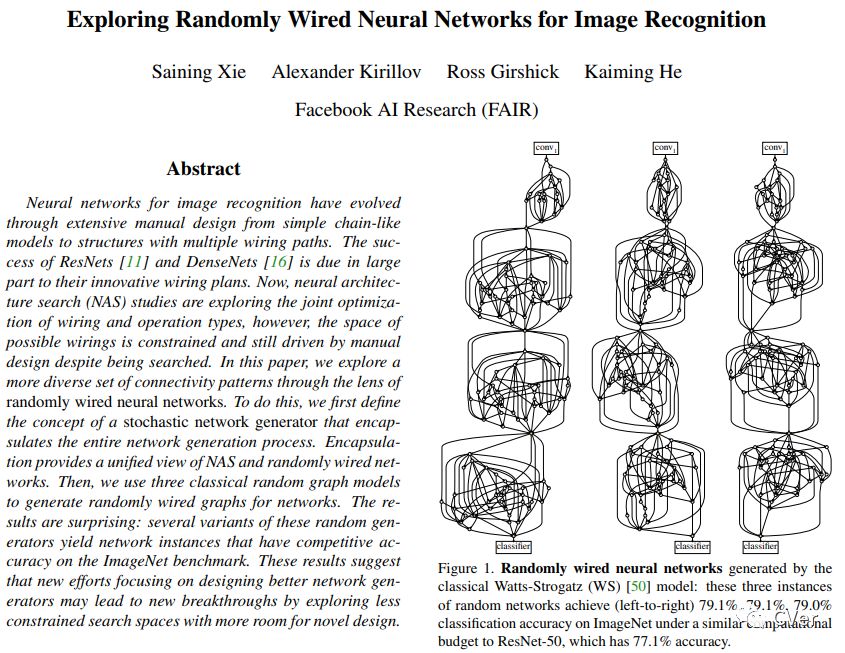

RandWire-WS

《Exploring Randomly Wired Neural Networks for Image Recognition》

arXiv: https://arxiv.org/abs/1904.01569

github: None

作者团队:Facebook(FAIR)

注:2019年04月03日刚出炉的paper

本文是何恺明团队的最新NAS方向的paper,特此分享给大家。

欢迎大家文末的微信交流群讨论上述三篇重磅paper!

推荐阅读

一文看尽21篇目标检测最新论文(腾讯/Google/商汤/旷视/清华/浙大/CMU/华科/中科院等)

CVPR2019 | 12篇目标检测最新论文(FSAF/GS3D/Libra R-CNN/Stereo R-CNN和GIoU等)

CVer学术交流群

扫码添加CVer助手,可申请加入CVer-目标检测交流群、图像分割、目标跟踪、OCR、超分辨率、SLAM、医疗影像、Re-ID和GAN等群。一定要备注:研究方向+地点+学校/公司+昵称(如目标检测+上海+上交+卡卡)

▲长按加群

这么硬的资料分享,麻烦给我一个好看

▲长按关注我们

麻烦给我一个好看!