![]()

作者 | Sebastian Ruder

编译 | 亚希伯恩

对于 AI 界而言,过去的一年可谓是“激流勇进”的一年,一方面,整个 AI 界的研究情绪高涨,推动了 AI 技术的迅猛发展;另一方面,迅猛发展的背后,技术的局限性也日益凸显,研究者们针对这些局限性也在积极探索,并各显身手地提出了不计其数的新方法和研究方向。

但能从中脱颖而出并产生较大影响力的方法和研究方向,又有哪些?值得在未来一年中继续深入探索的又有多少?

DeepMind研究员 Sebastian Ruder 博士基于他的研究工作,撰写了一份《2019年ML & NLP 领域十大研究热点》的总结报道。

这篇文章汇总了他认为 2019 年在ML 和 NLP 领域出现的十个最振奋人心和具有影响力的研究方向。

针对每个热点,他总结了在过去一年所取得的主要进展,并简述为何他认为其重要,并对未来做一个小小的展望。

通用无监督预训练

“中奖彩票”子网络

神经正切核

无监督多语言学习

更鲁棒的基准数据集

用于科学研究的ML和NLP

修复NLG中的解码错误

增强预训练模型

高效、长程的Transformer

更可靠的分析方法

一起来鉴赏~

一、通用无监督预训练

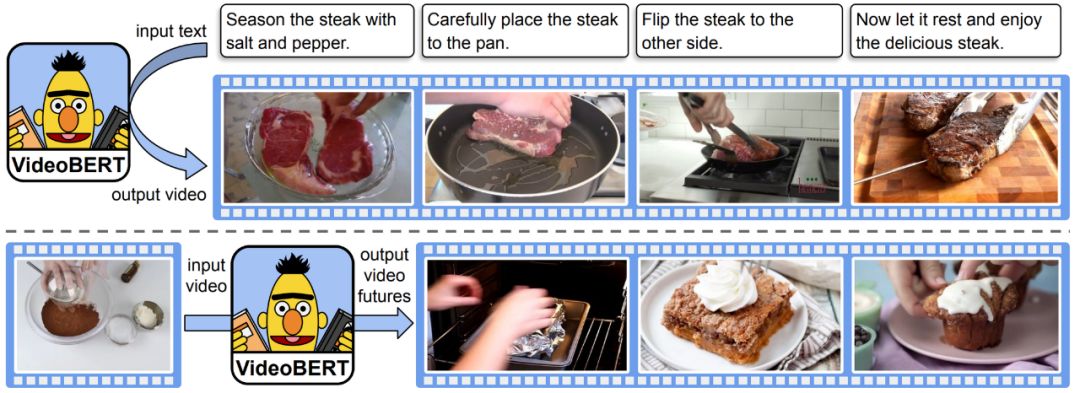

受到BERT (Devlin等人, 2019)及其变体大热的影响,过去一年中,无监督预训练是NLP 领域中的一个流行的研究方向。各种 BERT 变体用在了多模态的环境下,主要在涉及图像、视频以及文本环境(如下图所示)。

![]()

VideoBERT(Sun等人,2019年),一种最新的BERT多模态变体,根据配方(上面)生成视频“令牌”,并根据视频令牌(下面)预测不同时间尺度的未来令牌。

无监督预训练也开始“入侵”以前由监督方法占主导地位的领域。比如:

在生物学中,已有研究者在蛋白质序列上预训练Transformer语言模型(Rives等人,2019);

在计算机视觉中,也有研究者利用包括CPC(Hénaff 等人,2019),MoCo(He等人,2019)和PIRL(Misra&van der Maaten,2019)以及 BigBiGAN 生成器( Donahue&Simonyan,2019)在内的自监督方法提高 ImageNet 上的样本效率和改善图像生成;

在语音方面,使用多层CNN(Schneider等人,2019)或双向CPC(Kawakami等人,2019)所学得的表示,在更少训练数据下的表现优于当前最好模型。

无监督预训练可以在带有更少标记样本的数据上训练模型,这为以前无法满足数据需求的许多不同领域中的应用提供了新的可能性。

无监督预训练仍有很大的进步空间,尽管迄今为止它在单个领域都取得了很大进步,未来将重点放在如何更紧密地集成多模态数据,将是一个有趣的问题。

二、 “中奖彩票”子网络

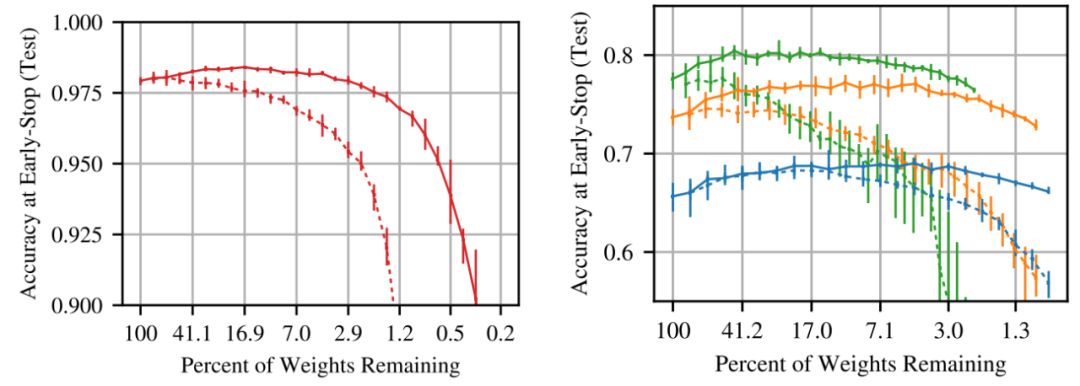

Frankle 和 Carbin 在2019 年的研究中发现了“中奖彩票”现象,即一个随机初始化、密集前馈网络中的一些子网经过极好的初始化,以至于单独训练这些子网就可达到与训练整个网络类似的准确率,如下图所示:

![]()

在不同的剪枝率下测试中奖彩票子网络(实线)与随机采样子网(虚线)的准确性(Frankle&Carbin,2019)。

虽然最初的剪枝程序仅适用于小型视觉任务,但后来的工作(Frankle等人,2019)在训练的早期而非初始化时应用修剪,这使得剪枝程序可以找到更深层模型的小型子网。Yu等人,(2019)也在NLP和RL模型中发现了LSTM和Transformer的“中奖彩票”初始化。

尽管“中奖彩票”仍然很难找,但好消息是这些“中奖彩票”似乎在不同数据集和优化器之间具有可转移性(Morcos等人,2019)。

现今神经网络变得越来越大,用于训练和预测的成本也越来越高。若能识别出具有可比性能的小型子网,便可以用更少的资源进行训练和推理,从而可以加快模型的迭代速度,并为设备上计算和边缘计算提供新的应用场景。

目前找到“中奖彩票”的代价仍然太高,无法在计算资源匮乏环境下提供实际的好处。修剪过程中不易受噪声影响且更鲁棒的一次性修剪方法或可缓解这种情况。

研究使“中奖彩票”特别的原因,或许还能帮助我们更好地理解神经网络的初始化以及其学习动力学。

三、 神经正切核

这个研究方向可能有点反直觉,具体来说就是无限宽的神经网络比窄的神经网络更容易从理论上进行研究。

研究表明,在无限宽的情况下,神经网络可以近似为带有神经正切核 (Neural Tangent Kernel ,NTK; Jacot等人, 2018)的线性模型。下图是其训练过程的动态图示:

![]()

具有不同 α 因子的 NTK 线性模型的动态学习过程, NTK 可视化为椭圆形(来源:Rajat的博客)。

然而在实践中,这些模型的表现不如有限深度模型(Novak等人,2019; Allen-Zhu等人,2019;Bietti&Mairal,2019),这限制了将新发现应用于标准方法。

但最近的工作(Li 等人,2019;Arora 等人,2019)已大大缩小了与标准方法的性能差距(具体请参阅Chip Huyen针对其他相关的NeurIPS 2019论文写的博文,https://huyenchip.com/2019/12/18/key-trends-neurips-2019.html)。

NTK也许是我们分析神经网络理论行为的最强大的工具,尽管它有其局限性,即实际的神经网络仍然比 NTK 对应的方法的表现更好。

虽然到目前为止该研究方向理论上的见解还没有转化为经验上的收获,但这可能有助于我们打开深度学习的黑匣子。

与标准方法的差距,似乎主要由于此类方法的有限宽度所导致,这些可能会在将来的工作中体现出来。这还将有望帮助将无限宽度限制下的一些理论上的见解转换得更符合实际设置。

最终,NTK 或可为我们阐明神经网络的训练动力学和泛化行为。

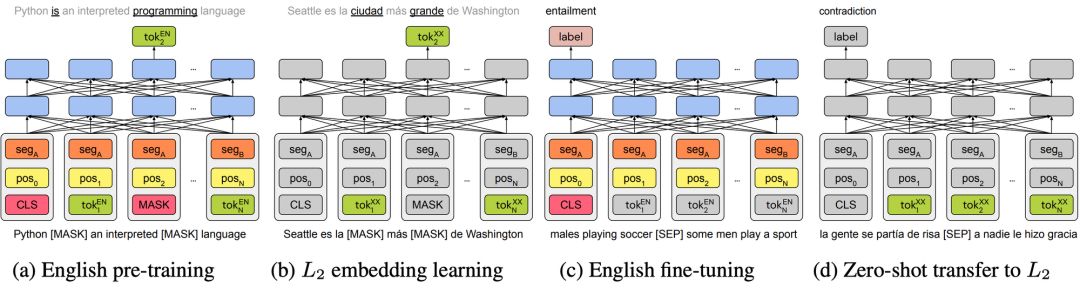

四、无监督多语言学习

多年来,跨语言表示主要集中在单词级别上的表示。在无监督预训练的基础上,过去的一年见证了诸如多语言BERT,XLM(Conneau&Lample,2019)和 XLM-R(Conneau等人,2019)等跨语言模型的深入发展。

虽然这些模型没有使用任何明确的跨语言信号,但它们即便在没有共享词汇或联合训练情况下实现的跨语言的泛化效果,依旧令人惊讶(Artetxe 等人,2019; Karthikeyan等人,2019; Wu等人,2019 )。

![]()

Artetxe等人(2019)的单语种迁移方法的四步骤。

这些深度模型还带来了无监督 MT 的改进(Song 等人,2019; Conneau&Lample,2019),在前年(2018年)取得了长足的进步基础上,在去年又从统计和神经方法的更原则性结合中,获得了改进( Artetxe 等人,2019)。

另一个令人振奋的进展则是,从现成的预训练英语表示中引伸出深层多语言模型(Artetxe等人,2019; Tran,2020),如下图所示。

即用型跨语言表示使训练模型所需的非英语语言样本更少。此外,若可以使用英语标记的数据,则这些方法可实现几乎免费的零样本转移。最终,这些方法可以帮助我们更好地理解不同语言之间的关系。

目前尚不清楚为什么这些方法在没有任何跨语言监督的情况下如此有效。更好地了解这些方法的工作方式,将使我们能够设计出功能更强大的方法,还有可能揭示出关于不同语言结构的一些见解。

另外,我们不仅应该专注于零样本转移,还应该在目标语言中考虑小样本学习问题。

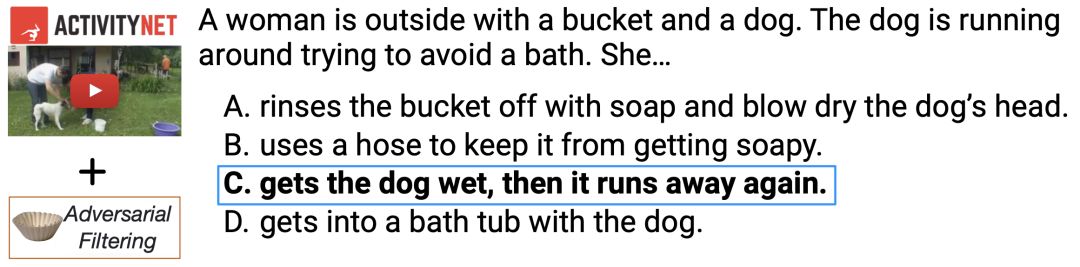

五、更鲁棒的基准数据集

当下的发展,定有些乌七八糟的事情。

—Nie et al. (2019) ,引自 Shakespeare《哈姆雷特》(There is something rotten in the state of Denmak,丹麦国里,定有些乌七八糟的事)

针对最近新开发出来的 NLP 数据集如 HellaSWAG (Zellers et al., 2019) ,当前最先进的模型也难以应对。

![]()

来自HellaSWAG数据集的多项选择句补全示例即使对于最新的模型也很难回答。大多数困难的例子都位于一个复杂的“戈尔德洛克区”,大致由三个上下文句子和两个生成的句子组成(Zellers等人,2019)。

研究者需要人工过滤样本,仅明了地保留那些当前最先进模型处理失败的样本(请参阅下面的示例)。可以重复多次“人在回环”的对抗管理过程,来创建对当前方法更具挑战性的数据集,例如在最近提出的的 Adversarial NLI(Nie等人,2019)基准测试中,就可以实现这一点。

许多研究人员已经观察到,当前的NLP模型并没有学到预期学到的内容,而是采用浅层启发并结合数据中的表层线索的方法(又称为“聪明汉斯时刻”)。随着数据集变得更加鲁棒难学,我们希望(能迫使)模型最终去学习数据中真正的潜在关系。

随着模型变得更好,大多数数据集将需要不断改进,否则就会很快过时。专用的基础设施和工具对于促进此过程很有必要。

此外,应在数据集上先运行合适的基准方法,例如,包括使用不同数据变体(例如输入不完整)的简单方法和模型,以使数据集的初始版本尽可能鲁棒。

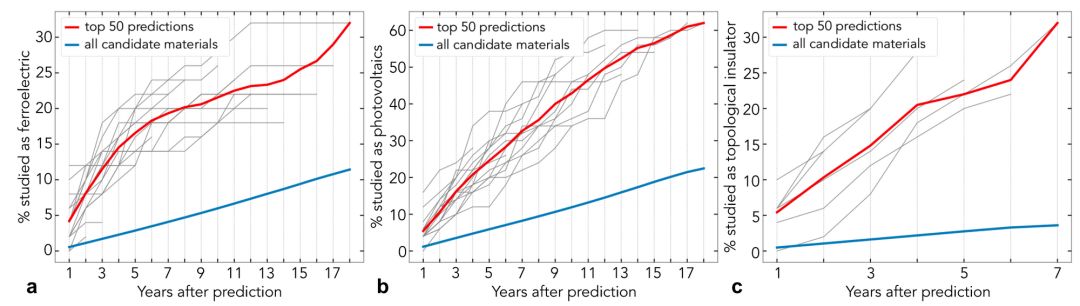

六、用于科学研究的 ML 和 NLP

机器学习已在基础科学问题上取得了一些重大进展。例如,有研究(Pfau等人,2019)将深层神经网络应用于蛋白质折叠和多电子Schrödinger方程。

在自然语言处理方面,即便是一些标准方法,在结合领域专业知识后所产生的影响也能令人兴奋。其中有一项研究使用词嵌入技术来分析材料科学文献中的潜在知识(Tshitoyan等人,2019),以将其用于预测材料是否具有某些特性(请参见下图)。

![]()

使用在不同时间段的摘要上训练得到的词嵌入预测将在未来的摘要中研究哪些材料作为铁电材料(a),光伏材料(b)和拓扑绝缘体(c ),与所有候选材料相比,更有可能对前50个预测材料进行研究(Tshitoyan等人,2019)。

在生物学中,许多数据(例如基因和蛋白质)本质上是序列数据。因此,自然可将LSTM和Transformers等NLP方法用于蛋白质分类(Strodthoff等人,2019; Rives等人,2019)。

科学可以说是ML最有影响力的应用领域之一。解决方案可对许多其他领域产生重大影响,并且有助于解决实际问题。

从对物理问题中的能量建模(Greydanus等人,2019)到求解微分方程(Lample&Charton,2020),ML方法一直在科学的新应用中不断扩大。看看2020年在哪种问题上的应用将会产生最大的影响也是挺有趣的。

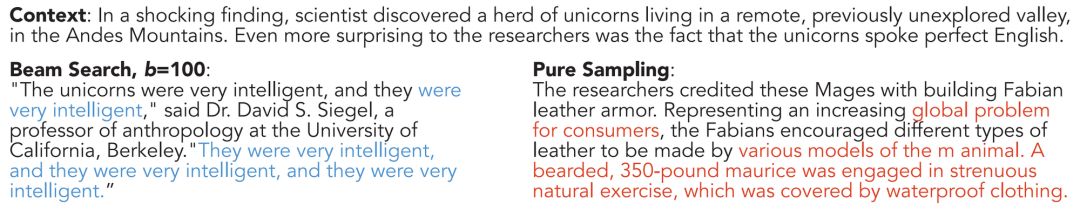

七、修复 NLG 中的解码错误

尽管功能越来越强大,但自然语言生成(NLG)模型仍然经常产生重复或胡言乱语,如下图所示。

事实表明,这主要是最大似然训练的结果。我很高兴看到已经有一些旨在改善这一点的研究工作,与此同时,在建模方面也取得了一些进展。这种改进或者通过采用新采样的方法获得,例如核采样(Holtzman等人,2019),或者通过使用新的损失函数获得(Welleck等人,2019)。

![]()

GPT-2使用光束搜索和纯(贪婪)采样产生的重复(蓝色)和胡言乱语(红色)(Holtzman等人,2019)。

另一个令人惊讶的发现是,更好的搜索不会带来更好的生成:当前模型在某种程度上依赖于不完善搜索和波束搜索错误。在机器翻译的情况下,精确搜索通常会返回空翻译(Stahlberg&Byrne,2019)。这表明搜索和建模方面的进步必须齐头并进。

自然语言生成是NLP中最普遍的任务之一。在 NLP 和 ML 研究中,大多数论文都集中在改进模型上,而流程中的其他部分通常被忽略。

对于NLG,需要注意的是,我们的模型仍然存在缺陷,并且可以通过修复搜索或训练过程来改善输出。

尽管有更强大的模型以及迁移学习在NLG的成功应用(Song等人,2019; Wolf等人,2019),模型预测仍然存在许多瑕疵,识别和理解此类瑕疵的成因,将是未来重要的研究方向。

八、增强预训练模型

在过去一年,我很高兴看到研究者为预训练模型提出了增加新功能的方法。一些方法用知识库增强了预训练模型,以改善实体名称建模(Liu等人,2019)和事实回忆(Logan 等人,2019)。其它研究则使预训练模型能够通过访问许多预定义的可执行的程序,来执行简单的算术推理(Andor 等人,2019)。

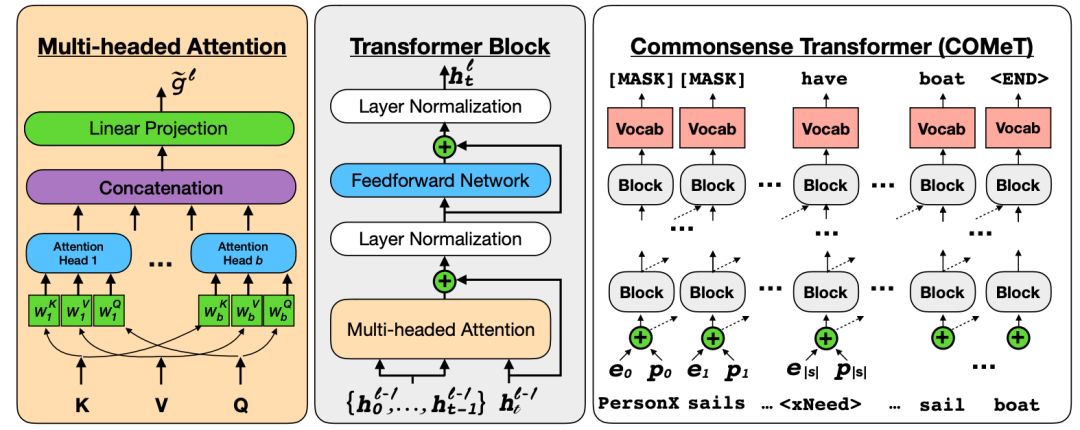

由于大多数模型具有较弱的归纳偏差并可以从数据中学习大多数知识,因此增强预训练模型的另一种方法是增强训练数据本身,例如捕捉常识(Bosselut等人,2019),如下图所示:

![]()

具有多头注意的标准Transformer。经过训练的模型可以根据给定的主题和关系来预测知识库三元组的对象(Bosselut等人,2019)。

2、为什么重要?

模型正变得越来越强大,但是模型无法从文本中学到很多东西。特别是在处理更复杂的任务时,可用数据可能十分有限,以至于无法使用事实或常识来学得显式的推理,并且可能经常需要更强的归纳偏差。

随着将模型应用于更具挑战性的问题,对组合进行修改将变得越来越有必要。将来,我们可能会结合功能强大的预训练模型和可学习的组合程序(Pierrot等人,2019)。

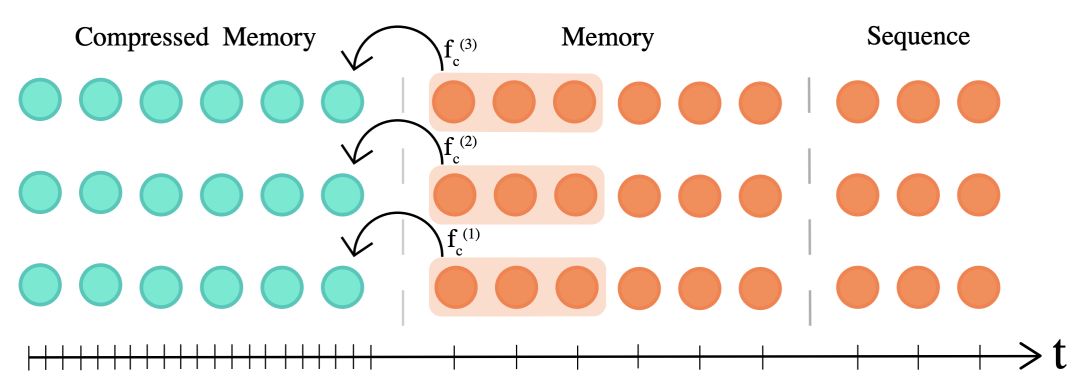

过去一年中,Transformer 架构实现了一些改进(Vaswani等人,2017)。例如Transformer-XL(Dai等人,2019)和Compressive Transformer(Rae等人,2020)使该架构能够更好地捕获长程依赖关系。

![]()

压缩的Transformer将(细粒度内存的)过去的激活压缩为一个更粗糙的压缩内存(Rae等人,2020)。

与此同时,许多方法试图通过使用不同的(通常是稀疏的)注意力机制来提高 Transformer 的效率,例如利用自适应稀疏注意力(Correia等人,2019),自适应注意力跨度(Sukhbaatar等人,2019),乘积键注意力( Lample等人,2019),以及局部敏感哈希(Kitaev等人,2020)等方法,来提高 Transformer 效率。

在基于Transformer 的预训练方面,出现了更有效的变体,例如使用参数共享的ALBERT(Lan等人,2020)和使用了更有效的预训练任务的ELECTRA(Clark等人,2020)。不过,也有一些预训练模型虽然不使用Transformer,但是更加有效,例如一元文件模型 VAMPIRE(Gururangan等人,2019)和基于QRNN的MultiFiT(Eisenschlos等人,2019)。

该领域的另一个趋势是,将大型 BERT 模型提炼成较小的模型(Tang等人,2019; Tsai等人,2019; Sanh等人,2019)。

Transformer 架构自提出以来,一直极具影响力。它是NLP中大多数最新模型的组成部分,并且已成功应用于许多其他领域(请参见第1和第6节)。因此,对 Transformer 体系结构的任何改进都有可能产生强烈的“波纹效应”。

从业者从 Transformer 取得的以上改进中获益可能还需要一段时间,但是鉴于预训练模型的普遍性和易用性,这段时间也不会太长。

总体而言,强调效率的模型架构有希望继续成为关注的焦点,稀疏性则是关键趋势之一。

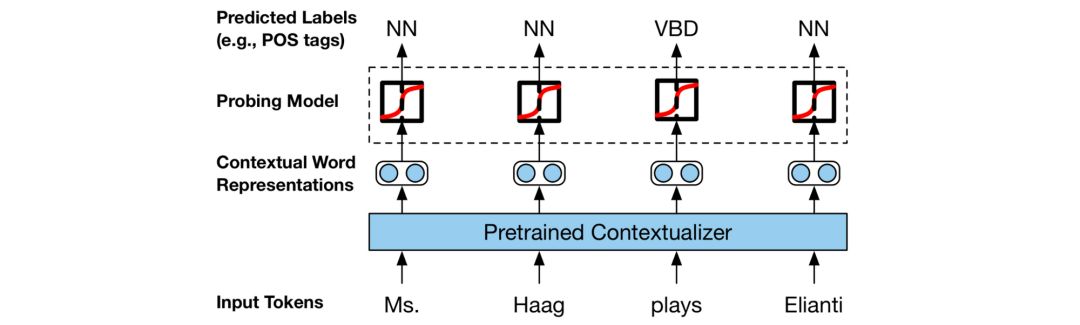

过去的一年中,ML 和 NLP 研究的主要趋势之一是,分析模型的论文数量在增加。

实际上,过去的一年中我最喜欢的几篇论文,就是这类分析模型的论文。2019 年早些时候,Belinkov 和 Glass 曾针对分析方法做了一份非常出色的调查报告。

在我的印象中,过去一年首次出现很多致力于分析单个模型 BERT 的论文的现象(此类论文被称为 BERTology)。在这种情况下,旨在了解模型是否通过预测某些属性来捕获形态、语法等的探针,已成为一种常用工具(参见下图)。

![]()

用于研究表示中语言知识的探针的设置(Liu等人,2019)。

我特别赞赏使探针更可靠的论文(Liu 等人,2019 ; Hewitt&Liang,2019)。而可靠性也正是对话领域发展道路上关于注意力是否能提供有意义解释的研究主题(Jain&Wallace,2019; Wiegreffe&Pinter,2019; Wallace,2019)。

最近ACL 2020 上关于 NLP 模型的可解释性和模型分析的Track 论文,就是人们对分析方法的持续兴趣的最好例证。

实际上,当前最先进的分析方法使用起来往往是一个黑匣子。为了开发更好的模型并在现实世界中应用它们,我们需要了解为什么模型会做出某些决定。然而,我们目前用于解释模型预测的方法仍然十分有限。

我们需要做出更多的工作来解释可视化范围之外的预测,因为这些预测通常是不可靠的。这个方向上的一个重要趋势是,更多数据集正在提供人为解释(Camburu等人,2018; Rajani等人,2019; Nie等人,2019)。

via

https://ruder.io/research-highlights-2019/

![]()

![]()

![]() 点击“阅读原文” 前往 AAAI 2020 专题页

点击“阅读原文” 前往 AAAI 2020 专题页