一个1024的MLP,击败了几乎所有的GNN模型

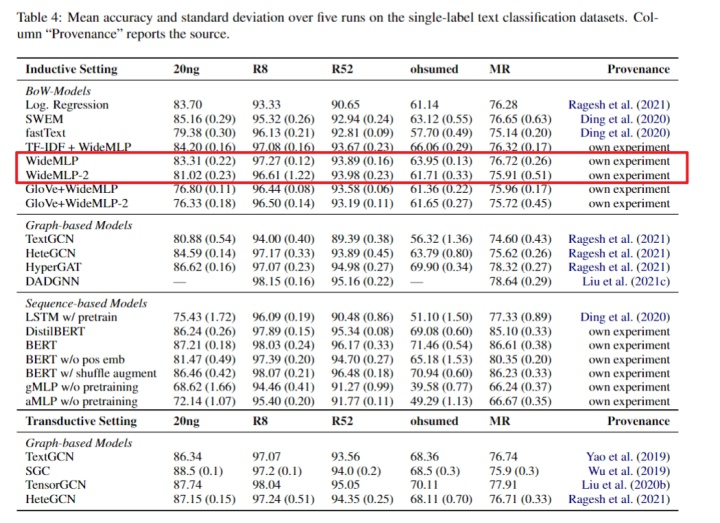

近些年,一些NLP研究者尝试利用GNN来做一些NLP相关的任务。但是,ACL2022一篇论文的实验结果:一个1024的MLP,击败了几乎所有的GNN模型。

上述结论来自"Bag-of-Words vs. Graph vs. Sequence in Text Classification: Questioning the Necessity of Text-Graphs and the Surprising Strength of a Wide MLP"

文本分类这个问题上套各种GNN的工作,基本就是灌水

这么没有挑战性的任务,就像北京市中考试卷

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年11月30日

Arxiv

0+阅读 · 2022年11月28日

Arxiv

13+阅读 · 2018年9月7日