ECCV 2020 Oral | AP3D:解决3D Conv中的表观破坏问题

点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达

本文作者:谷欣乾

https://zhuanlan.zhihu.com/p/163820901

本文已由原作者授权,不得擅自二次转载

近期产出的一篇新的工作:Appearance-Preserving 3D Convolution for Video-based Person Re-identification。针对3D卷积在时间维度上存在表观不对齐时的表观破坏问题,提出了一种简单高效的解决方案,使得在建模时序信息时可以维持表观表示的质量。运气比较好,中了ECCV2020 Oral。在这里做一个简单介绍,同时夹杂了一些做这个工作时的心路历程。代码也已经开源。

文章:https://arxiv.org/abs/2007.08434

代码:https://github.com/guxinqian/AP3D

背景

和image-based re-id相比,video-based re-id主要增加了多帧图像以及时序信息。主流的解决方法一般分为两类:如何建模时序信息或者如何做多帧特征的融合和匹配。之前网上有一些论调觉得video re-id的研究意义不大,基于image的方法在video re-id数据集上随便跑一跑都比顶会文章结果高。这主要是因为18年以前video re-id文章基本都是手工设计的浅层网络,而同时期image re-id的文章基本都已经统一成了resent50,直接这样对比是不公平的。从近两年video re-id的文章来看,backbone统一成resnet50以后,一个好的时序信息建模方式还是可以带来很可观的性能提升的。

回到这篇文章的背景,这要从18年暑假说起。当时把image re-id的很多trick总结了一下,写了一个video re-id的baseline,并对能想到的超参几乎都做了一遍调优。之后在这个baseline上尝试了很多通用视频分类的方法,比如3D Conv,Non-local。其中,Non-local直接搬过来就可以很稳定的涨点,但是3D Conv再怎么调都和baseline差不太多,有时候还会跑出比baseline还低的结果。当时I3D, P3D之类的几个方法,还有包括加在那个stage,加多少,时序的kernel size取多少都有尝试,但是得到的结论都是相似的。一开始有一点百思不得其解。在这个问题放了一年多以后,和同学闲聊时偶然想到了可能是re-id样本的采集方式和re-id问题中对识别起主导作用的是表观特征所导致。

动机

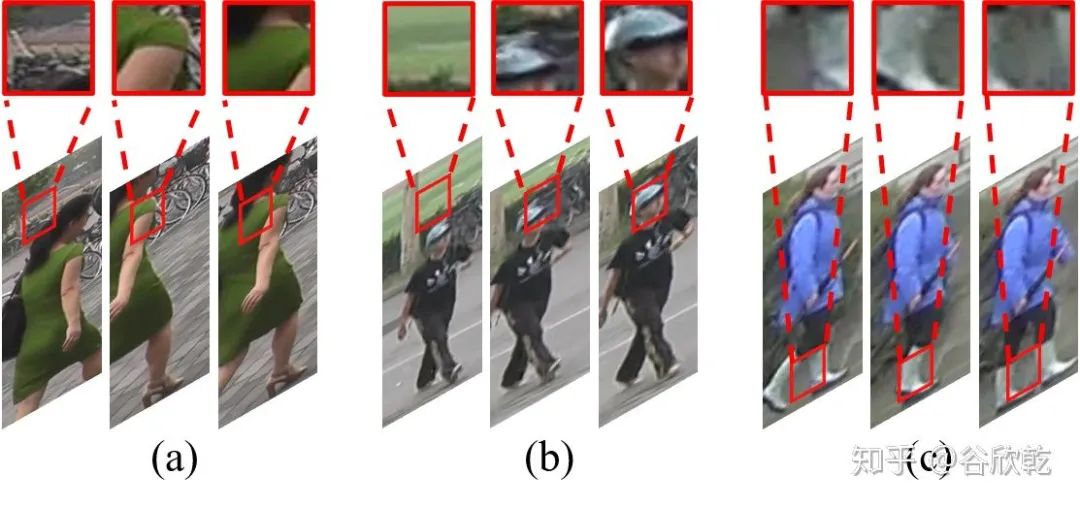

不同于大多数视频分类问题,video re-id的数据来源于检测算法得到的bounding box (如上图),而非监控视频原始帧。这就导致了当检测结果存在误差时(检测框过小或者过大)相邻帧之间的表观会对不齐,比如图(b)中相连三帧红框框住的区域分别对应背景、帽子以及整个头部。即使检测结果相对准确时,由于人的姿态变化,不对齐现象也会不可避免,如图(c)。有人可能会有疑问:正常视频分类里相邻帧或者采样跨度较大时,视频中很多目标也是不对齐的。3D Conv在这种情况下刚好可以捕捉运动的motion,最终表现在性能上也会有所提升,为什么单独拿video re-id中的不对齐来说事?这就涉及到当前video re-id的第二个和大多数视频分类问题的不同点。由于目前的video re-id数据集构建还不涉及换衣服问题,所以在识别过程中占主导作用的还是表观特征,而非motion特征。当采样帧间存在表观不对齐时,3D Conv就会把来自不同部位的特征卷成一个值,这在一定程度上会对表观特征造成破坏。这也就可以解释为什么3D Conv在video re-id问题上不work了。

方法

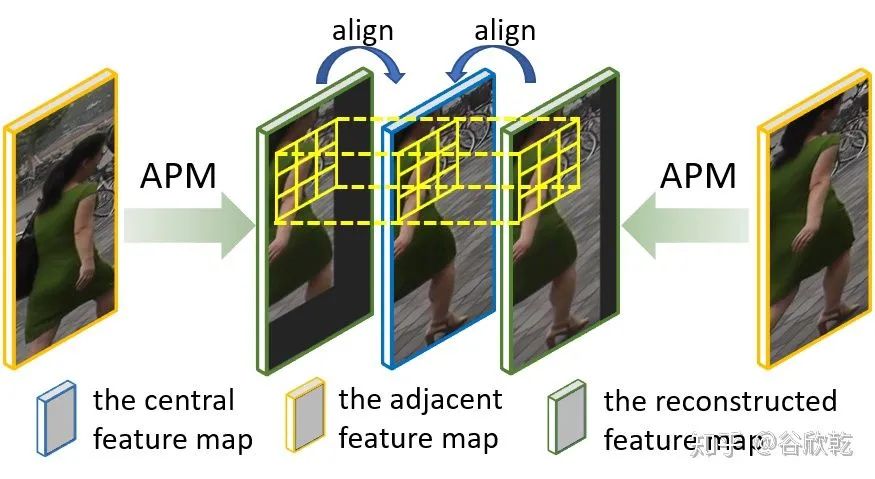

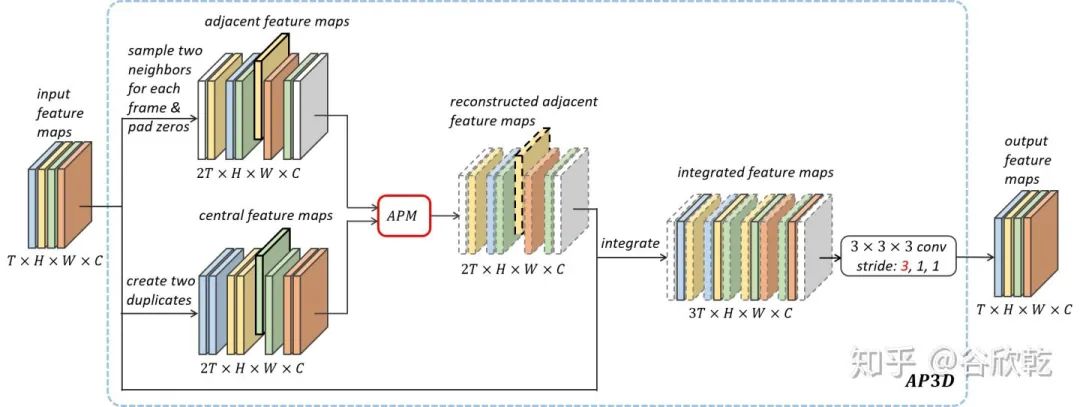

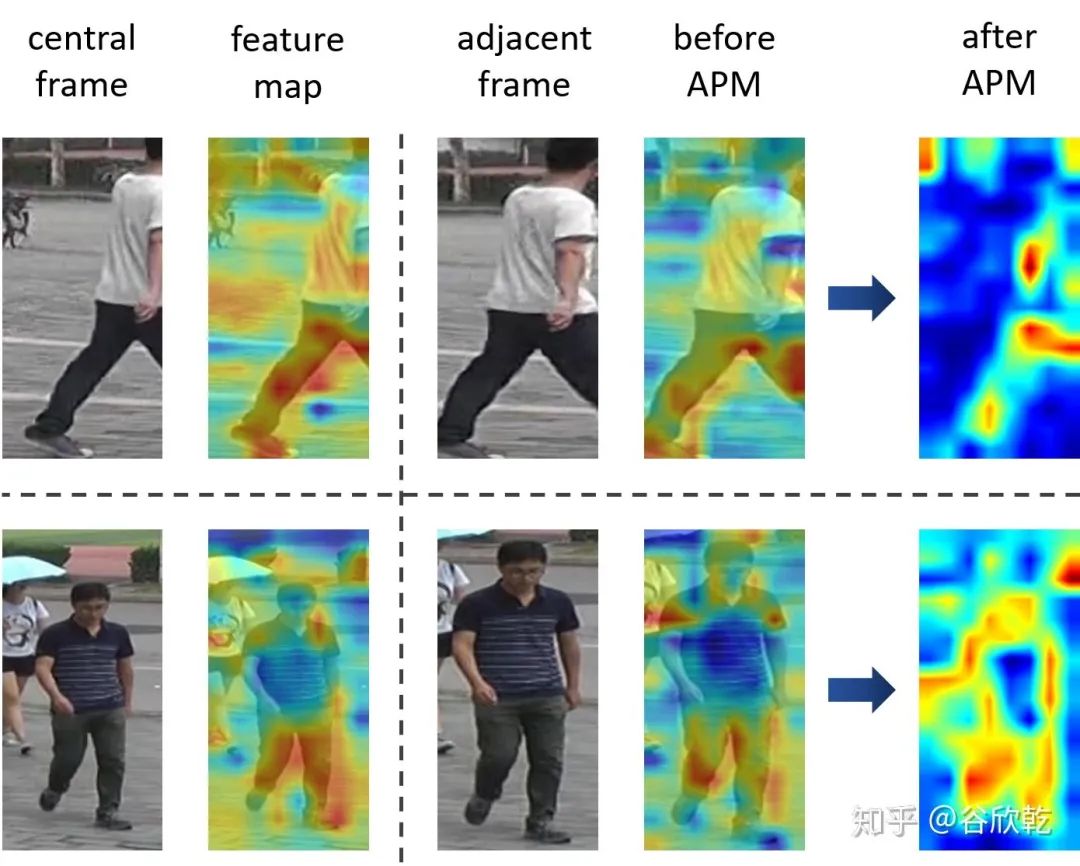

问题找到之后,一个很直接的解决方案就出现了:既然存在不对齐,那对齐之后再做Conv就好了。如上图,APM是Appearance-Preserving Module的简称。它的作用是对近邻帧做重建,保证重建后的特征图和中间帧的特征图表观对齐,这个过程可以看做是相邻帧特征图对中心帧特征图的配准。接下来再用3D Conv进行时序建模时就不会破坏表观特征了。我们将整个过程命名为了Appearance-Preserving 3D Convolution(AP3D)。下图是AP3D的前向传播过程,输入特征图的每一帧都被当做中心帧,采集相应的近邻帧之后用APM做特征图配准。接着将配准后的特征图和原始输入进行整合,然后进行3D Conv得到输出。注意到由于整合后的特征图时间维度变为了原始输入的3倍,3D Conv的时序stride也设置成了3,这样就能保证输入输出维度不变。

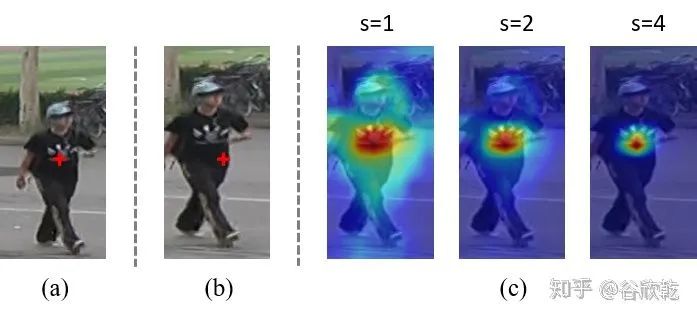

我们回到APM的设计。一开始我们设想了三种解决方案:一是用Deformable Conv去学习中心帧每个pixel在相邻帧中的偏移;二是用STN去学习近邻帧到中心帧的仿射变换参数;三是用graph matching的方法去完成配准。最终第三种方法的实验效果更好,因此选择了这一种。它的原理也非常简单,就是通过计算两帧间cross-pixel的余弦相似性来定位中心帧每一个点在近邻帧中的位置。如下图,(a)是中心帧,(b)是它的近邻帧,两帧中标记部位原本是不对齐的。我们计算了中心帧标记部位特征和近邻帧中所有位置特征的余弦相似性,乘了一个缩放系数s之后用softmax做了归一化并可视化如图(c)。可以看到当s取4时,可以精确定位到相同表观对应的位置。

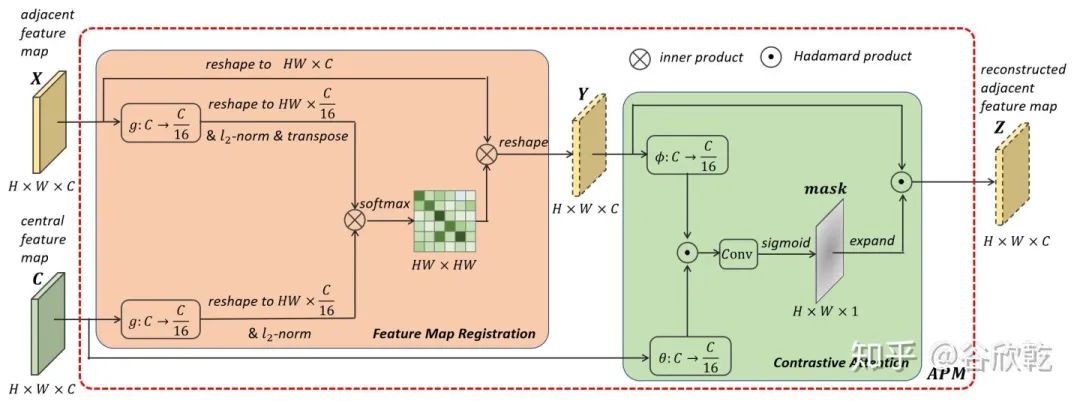

因此我们就将归一化后的相似性作为权重,将近邻帧中所有位置的特征进行加权求和,最终得到配准后近邻帧特征图对应位置的特征。该过程的矩阵计算形式如下图中Feature Map Registration所示。为了节省计算开销,我们将特征进行了降维,降到原来的1/16。

这里还有一个问题需要注意,就是当检测给出的bounding box较小时,可能有些帧的某些身体部位是缺失的。在这种情况下,加权求和的形式还是会计算出一个特征填充到中心帧对应位置。这种错误配准会在后续的计算中产生误差。为了防止这种误差传播,我们将配准后的特征图和中心特征图对应位置特征进行了比较,计算的出一个mask值乘到配准后的特征图上。这个过程就是上图中的Contrastive Attention。

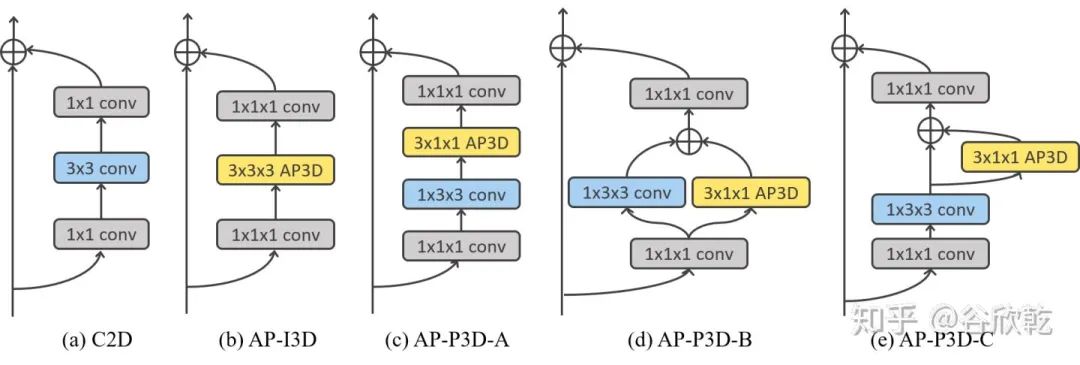

AP3D也很容易和现有的方法如I3D和P3D整合。如下图,直接将其中的时序卷积进行替换就能得到对应的AP3D版本。

实验

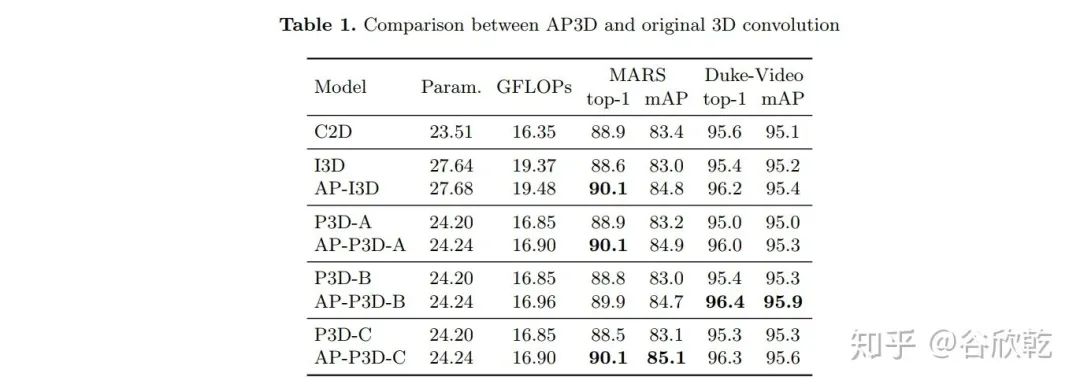

baseline为resnet50的C2D版本。可以看到原始I3D和P3D和C2D相比性能差不太多,有时候甚至会更低。将原始的3D Conv替换为AP3D后,在增加有限计算量的情况下,性能提升很明显,在MARS上有接近1%的top-1提升和2%的mAP提升。

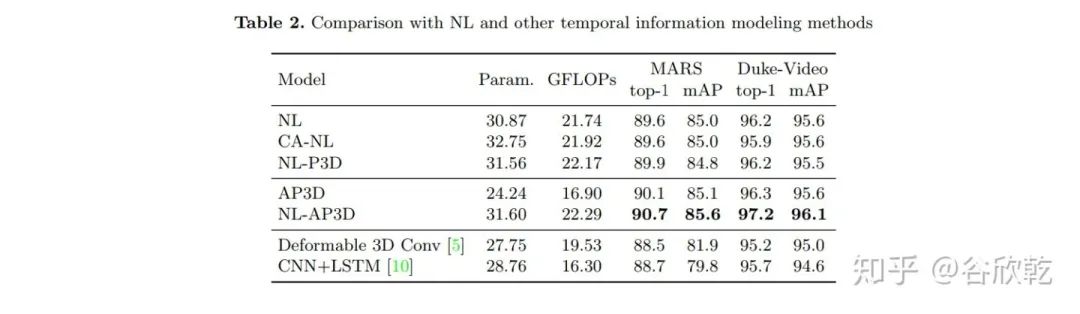

和同属于基于图的方法的Non-local对比的话性能差不太多,AP3D稍有优势。

为了公平,还对比了加了Contrastive Attention的NL。因为CA的设计主要针对配准不精确,NL的本质是像素作为节点的时空图上的GCN,并非graph matching,所以也不存在配准不精确问题,实验结果上也没有提升。

表中AP3D和NL都是添加或者替换5层的结果,单独一个结构添加10层都会出现过拟合。AP3D 和NL融合后还有进一步提高。

Deformable 3D Conv和CNN+LSTM的结果还不如C2D。

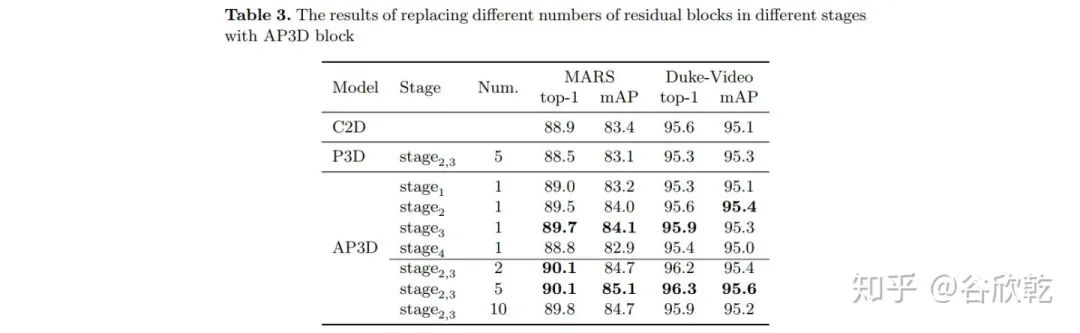

stage2,3替换效果最好。替换数量上5层比较好。

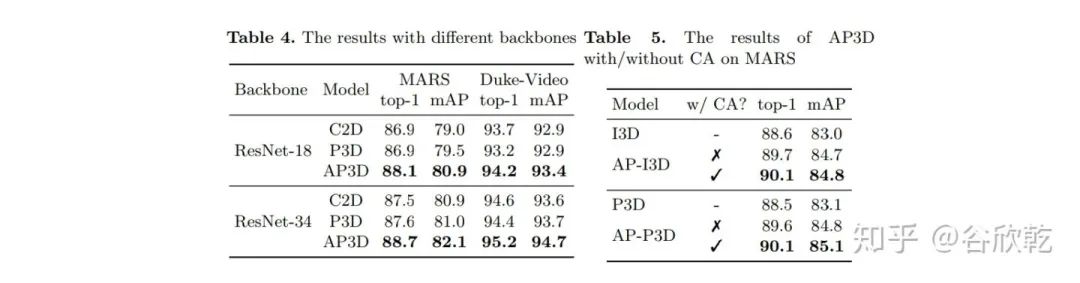

这是不同结构和有无contrastive attention的对比。

这是可视化stage3中的特征图。由于是中间层,噪声相对比较多,还是存在一些背景区域的高亮。但是可以清楚地看到配准后的特征图高亮区域和中心帧的前景重合度很高。

总结

发现了时间维度上存在表观不对齐时,普通3D Conv的表观破坏问题

提出了AP3D来解决此问题,先做特征图配准,再做3D Conv

方法简单,性能提升显著,代码也已开源

下载1

在CVer公众号后台回复:PRML,即可下载758页《模式识别和机器学习》PRML电子书和源码。该书是机器学习领域中的第一本教科书,全面涵盖了该领域重要的知识点。本书适用于机器学习、计算机视觉、自然语言处理、统计学、计算机科学、信号处理等方向。

PRML

下载2

在CVer公众号后台回复:CVPR2020,即可下载CVPR2020 2020代码开源的论文合集

在CVer公众号后台回复:ECCV2020,即可下载ECCV 2020代码开源的论文合集

重磅!CVer-论文写作与投稿交流群成立

扫码添加CVer助手,可申请加入CVer-论文写作与投稿 微信交流群,目前已满2000+人,旨在交流顶会(CVPR/ICCV/ECCV/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI等)、SCI、EI等写作与投稿事宜。

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如论文写作+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加微信群

▲长按关注CVer公众号

整理不易,请给CVer点赞和在看!