利用 AutoML 进行大规模图像分类和对象检测

文 / Google Brain 团队研究科学家 Barret Zoph、Vijay Vasudevan、Jonathon Shlens 和 Quoc Le

几个月之前,我们推出了 AutoML 项目,这是一种实现机器学习模型设计自动化的方式。尽管我们发现 AutoML 能够设计出性能可与人类专家设计的神经网络相媲美的小型神经网络,但这些成果仍被限制在 CIFAR-10 和 Penn Treebank 一类的小型学术数据集方面。我们对这种方法在更大、更具挑战性的数据集(例如 ImageNet 图像分类和 COCO 对象检测)上的表现充满好奇。在学术竞赛中,人类已经发明了许多最先进的机器学习架构来处理这些数据集。

在学习可转移的架构来实现可扩展的图像识别 (Learning Transferable Architectures for Scalable Image Recognition) 论文中,我们将 AutoML 应用到 ImageNet 图像分类和 COCO 对象检测数据集中 - ImageNet 和 COCO 是计算机视觉领域两个最受认可的大规模学术数据集。这两个数据集对我们来说是一项非常大的挑战,因为它们要比 CIFAR-10 和 Penn Treebank 数据集大许多数量级。例如,单单将 AutoML 直接应用到 ImageNet 中就需要对我们的方法进行数月的训练。

为了能够将我们的方法应用到 ImageNet,我们对 AutoML 方式做了两点调整,让它可以更容易地处理大规模数据集:

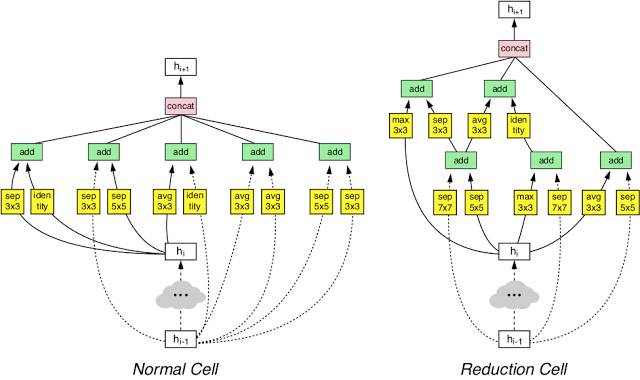

我们重新设计了搜索空间,以便 AutoML 找到最佳层并灵活进行多次堆叠来创建最终网络。

我们在 CIFAR-10 上执行了架构搜索,并将学到的最好架构转移到 ImageNet 图像分类和 COCO 对象检测中。

通过这种方法,AutoML 能够找到在 CIFAR-10 以及 ImageNet 分类和 COCO 对象检测上都有优异表现的最佳层。这两个层组合形成一种新的架构,我们称之为“NASNet”。

▲ 我们的 NASNet 架构由两种类型的层组成:正常层(左)和还原层(右)。这两种层都由 AutoML 设计。

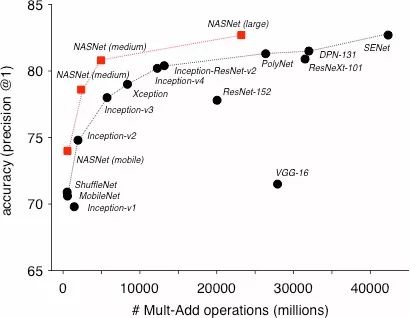

在 ImageNet 图像分类上,NASNet 在验证集上的预测准确率达到了 82.7%,超过了我们之前构建的所有 Inception 模型。此外,NASNet 的准确率比之前公布的所有结果提升了 1.2%,与 arxiv.org 上报告的最佳未公布结果不相上下。NASNet 还可以调整规模,生成一系列可以实现较高准确率的模型,同时将计算开销控制在非常低的水平。例如,小版本的 NASNet 可以实现 74% 的准确率,比面向移动平台的同等规模最先进模型提升了 3.1%。大型 NASNet 则可实现最高的准确率,同时将 arxiv.org 上最佳报告结果(即 SENet)的计算开销减半。

▲ NASNet 与人类发明的各种规模的最先进模型在 ImageNet 图像分类中的准确率。

我们还将学到的特征从 ImageNet 转移到对象检测。在实验中,将在 ImageNet 分类中学到的特征与 Faster-RCNN 框架相结合超过了 COCO 对象检测任务之前公布的最佳预测性能,无论检测任务在最大的模型上执行,还是在针对移动设备优化的模型上执行,结果都是如此。我们最大的模型的平均准确率 (mAP) 达到了 43.1%,比之前公布的最佳结果提升了 4%。

▲ 结合使用 Faster-RCNN 和 NASNet 的示例对象检测。

我们认为,NASNet 在 ImageNet 和 COCO 上学到的图像特征可重用于许多计算机视觉应用。因此,我们在 Slim 和对象检测 TensorFlow 代码库中将 NASNet 开源,方便大家使用它在图像分类中进行推理,以及进行对象检测。我们希望更广大的机器学习社区能够利用这些模型开展构建工作,解决我们还未想到的众多计算机视觉问题。

特别感谢 Jeff Dean、Yifeng Lu、Jonathan Huang、Vivek Rathod、Sergio Guadarrama、Chen Sun、Jonathan Shen、Vishy Tirumalashetty、Xiaoqiang Zheng、Christian Sigg 和 Google Brain 团队对这个项目的大力帮助。

查看全文及文中链接,请戳文末“阅读原文”。

推荐阅读:

Google发布TensorFlow Lattice,先前知识推动灵活性提升