「图神经网络东」最新2022综述

中国石油大学《图神经网络最新》综述论文

近几年来,将深度学习应用到处理和图结构数据相关的任务中越来越受到人们的关注.图神经 网络的出现使其在上述任务中取得了重大突破,比如在社交网络、自然语言处理、计算机视觉甚至生命 科学等领域得到了非常广泛的应用.图神经网络可以把实际问题看作图中节点之间的连接和消息传播 问题,对节点之间的依赖关系进行建模,从而能够很好地处理图结构数据.鉴于此,系统综述了图神经网络模型以及应用.首先从谱域、空间域和池化3方面对图卷积神经网络进行了阐述.然后,描述了基于注意 力机制和自编码器的图神经网络模型,并补充了一些其他方法实现的图神经网络.其次,总结了针对图 神经网络能不能做大做深等问题的讨论分析.进而,概括了图神经网络的4个框架.还详细说明了在图 神经网络在自然语言处理、计算机视觉等方面的应用.最后,对图神经网络未来的研究进行了展望和总 结.相较于已有的图神经网络综述文章,详细阐述了谱理论知识,并对基于谱域的图卷积神经网络体系 进行全面总结.同时,给出了针对空间域图卷积神经网络效率低的改进模型这一新的分类标准.并总结 了针对图神经网络表达能力、理论保障等的讨论分析,增加了新的框架模型.在应用部分,阐述了图神经 网络的最新应用.

https://crad.ict.ac.cn/CN/10.7544/issn1000-1239.20201055

在过去几年,深度学习已经在人工智能和机器 学习上取得了成功,给社会带来了巨大的进步.深度 学习的特点是堆积多层的神经网络层,从而具有更 好的学 习 表 示 能 力.卷 积 神 经 网 络 (convolutional neuralnetwork,CNN)的飞速发展更是将深度学习 带上了一个新的台阶[1G2].CNN 的平移不变性、局部 性和组合性使其天然适用于处理像图像这样的欧氏 结构数据的任务中[3G4],同时也可以应用于机器学习 的其他各个领域[5G7].深度学习的成功一部分源自于 可以从欧氏数据中提取出有效的数据表示,从而对 其进行高效的处理.另一个原因则是得益于 GPU 的 快速发展,使得计算机具有强大的计算和存储能力, 能够在大规模的数据集中训练和学习深度学习模 型.这使得深度学习在自然语言处理[8]、机器视觉[9] 和推荐系统[10]等领域都表现出了良好的性能.

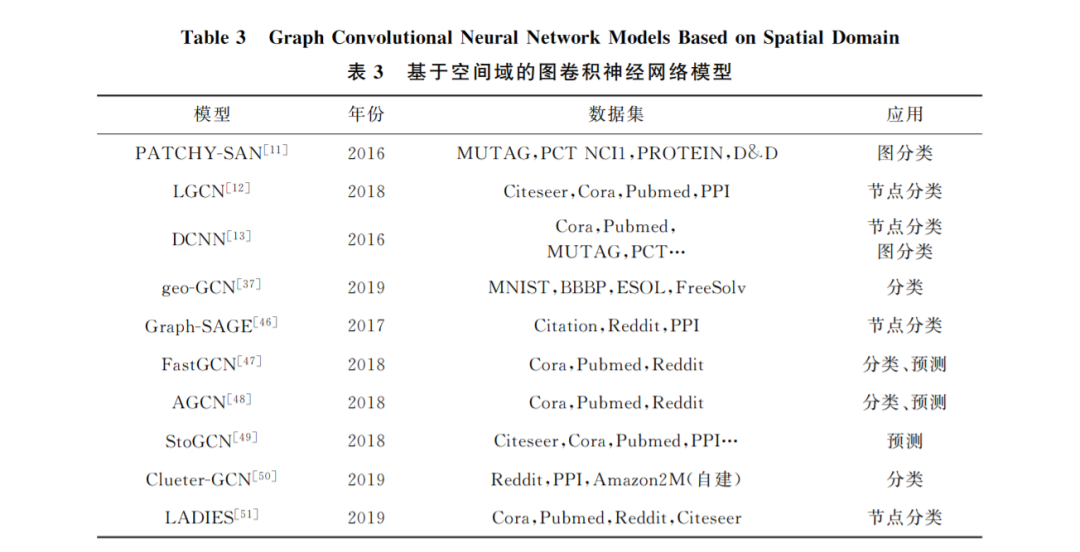

但是, 现有的神经网络只能对常规的欧氏结构 数据进行处理.如图1(a)欧氏数据结构,其特点就是 节点有固定的排列规则和顺序,如2维网格和1维 序列.而当前越来越多的实际应用问题必须要考虑 非欧氏数据,如图1(b)非欧氏数据结构中节点没有 固定的排列规则和顺序,这就使得不能直接将传统 的深度学习模型迁移到处理非欧氏结构数据的任务 中.如若直接将 CNN 应用到其中,由于非欧氏数据中心节点的邻居节点数量和排列顺序不固定,不满 足平移不变性,这就很难在非欧氏数据中定义卷积 核.针对图神经网络(graphneuralnetwork,GNN) 的研究工作,最开始就是在如何固定邻居节点数量 以及如何给邻居节点排序展开的,比如 PATCHYG SAN [11],LGCN [12],DCNN [13]方法等.完成上述2项 工作之后,非欧氏结构数据就转化为欧氏结构数据, 然后就可以利用 CNN 处理.图是具有点和边的典型 非欧氏数据,在实际中可以将各种非欧氏数据问题 抽象为图结构.比如在交通系统中,利用基于图的学 习模型可以对路况信息进行有效的预测[14].在计算 机视觉中,将人与物的交互看作一种图结构,可以对 其进行有效地识别[15]。

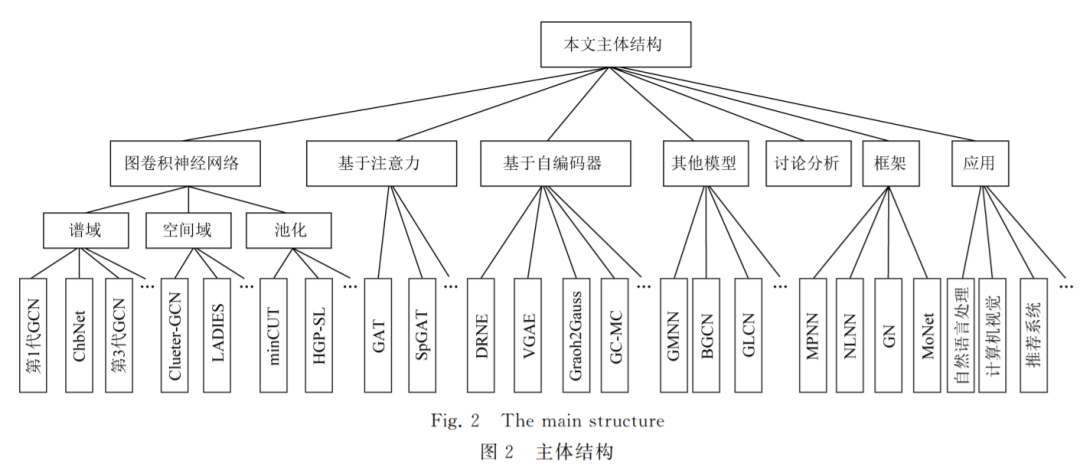

近期已有一些学者对图神经网络及其图卷积神经网络分支进行了综述[16G19].本文的不同之处在于,首先由于经典模型是很多变体模型的基石,所以给 出了经典模型的理论基础以及详细推理步骤.在1.2 节基于空间方法的图卷积神经网络中,多用图的形 式列出模型的实现过程,使模型更加通俗易懂.文献 [16G19]并未对目前广大学者热点讨论的问题进行 总结,所以在第5节针对图神经网络的讨论部分,首 次列出了目前研究学者对 GNN 的热点关注问题, 比如其表达能力、过平滑问题等.然后,在第6节中 总结了图神经网络新框架.同时,针对图神经网络的 应用,在第7节中较全面地介绍了 GNN 的应用场 景.最后,列出了图神经网络未来的研究方向.在图2 中列出了本文的主体结构.

研究图神经网络对推动深度学习的发展以及人 类的进步具有重大意义.首先,现实中越来越多的问 题可以抽象成非欧氏结构数据,由于图数据的不规 则性,传统的深度学习模型已经不能处理这种数据, 这就亟需研究设计一种新的深度神经网络.而 GNN 所处理的数据对象就是具有不规则结构的图数据,GNN 便在这种大背景下应运而生[20G21].然后,图数 据的结构和任务是十分丰富的.这种丰富的结构和 任务也正是和人们生活中要处理的实际问题相贴合 的.比如,图数据有异质性以及边的有向连接特性, 这和推荐系统中的场景完全类似.图数据处理任务 中节点级别、边级别以及整图级别也同样可以应用到深度学习的各个应用场景中.所以,GNN 的研究 为解决生活中的实际问题找到了一种新的方法和途 径.最后,GNN 的应用领域是十分广泛的,能够处理 各种能抽象成图数据的任务.不管是在传统的自然 语言处理领域[22G24]或者图像领域[25G26],还是在新兴 的生化领域[27G28],GNN都能表现出强大的性能.

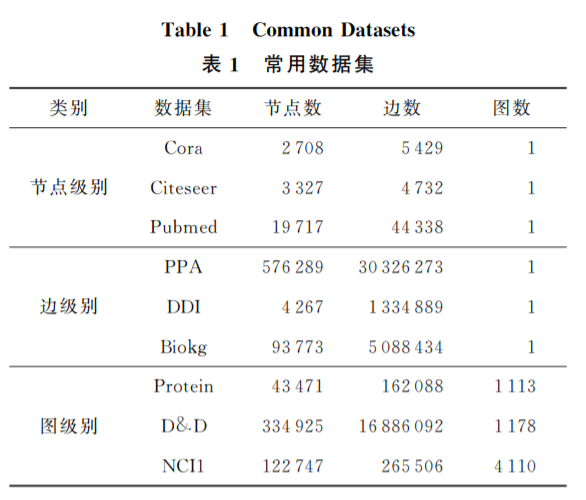

现实生活中越来越多的实际处理任务都可以抽 象成图结构数据,应用场景是非常多的.图中包含节 点、边和整个图结构.GNN 的处理任务也主要从节 点级别、边级别和整个图级别出发.在节点级别可以 完成针对节点的分类,比如在引文数据集中,可以完 成对相似论文的分类任务[29].边级别可以完成链路 预测任务,比如推荐系统中用户对电影是否感兴趣 等[30].而图级别则可以完成对整个图属性的预测, 比如在生化预测任务中,可以实现对某个分子是否 产生变异进行预判[31].针对不同的处理任务,常用 的数据集如表1所示:

1 图卷积神经网络

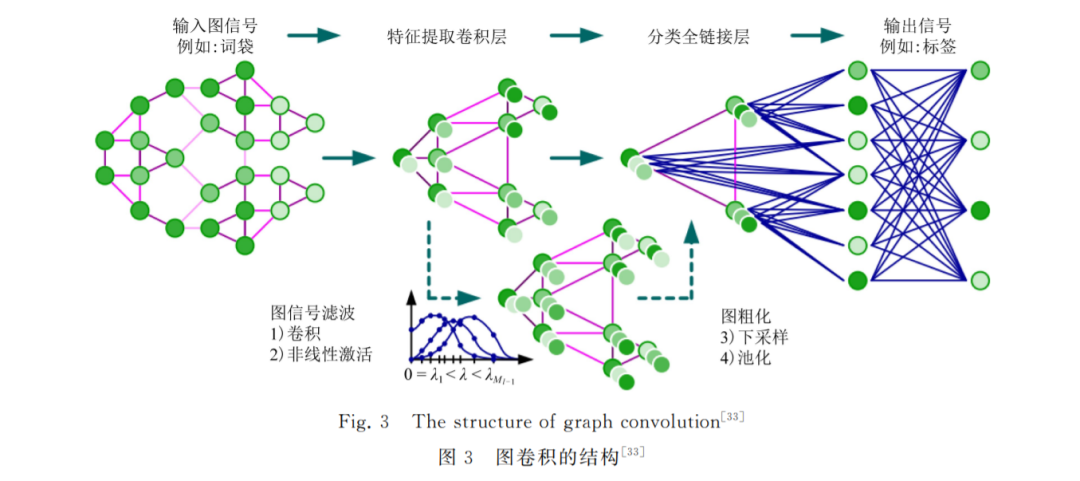

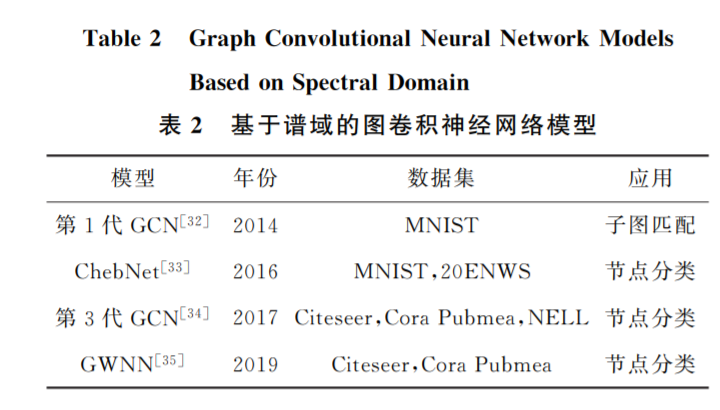

CNN 已经在图像识别、自然语言处理等多个领 域取得了不俗的成绩,但其只能高效地处理网格和 序列等这样规则的欧氏数据.不能有效地处理像社 交多媒体网络数据、化学成分结构数据、生物蛋白数 据以及知识图谱数据等图结构的非欧氏数据.为此, 无数学者经过不懈努力,成功地将 CNN 应用到图 结构的非欧氏数据上,提出了图卷积神经网络(graph convolutionalnetwork,GCN).GCN 是 GNN 中一 个重要分支,现有的大多数模型基本上都是在此基 础上变化推导而来.下面我们将按照从基于谱方法、 空间方法和池化3方面对 GCN 进行总结和概括.

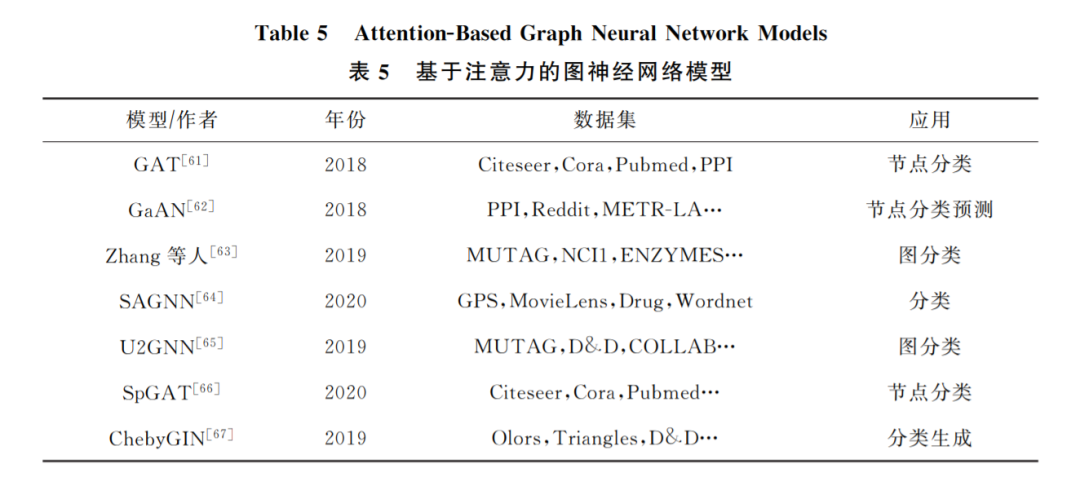

2 基于注意力实现的图神经网络

注意力机制在处理序列任务已经表现出强大的 能力[60],比如在机器阅读和学习 句 子 表 征 的 任 务 中.其强大的优势在于允许可变大小的输入,然后利 用注意力机制只关心最重要的部分,最后做出决策处理.一些研究发现,注意力机制可以改进卷积方 法,从而可以构建一个强大的模型,在处理一些任务 时能够取得更好的性能.为此,文献[61]将注意力机 制引入到了图神经网络中对邻居节点聚合的过程 中,提出了图注意力网络(graphattentionnetworks, GAT).在传统的 GNN 框架中,加入了注意力层,从 而可以学习出各个邻居节点的不同权重,将其区别对待.进而在聚合邻居节点的过程中只关注那些作 用比较大的节点,而忽视一些作用较小的节点.GAT 的核心思想是利用神经网络学习出各个邻居节点的 权重,然后利用不同权重的邻居节点更新出中心节 点的表示。

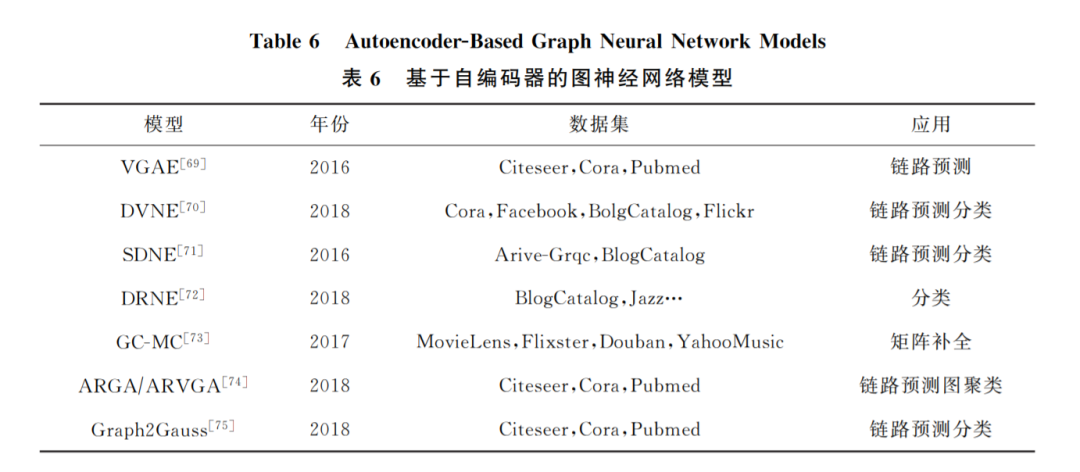

3 基于自编码器实现的图神经网络

在无监督学习任务中,自编码器(autoencoder, AE)及其变体扮演者非常重要的角色,它借助于神 经网络模型实现隐表示学习,具有强大的数据特征 提取能力.AE 通过编码器和解码器实现对输入数 据的有效表示学习,并且学习到的隐表示的维数可 以远远小于输入数据的维数,实现降维的目的.AE 是目前隐表示学习的首选深度学习技术,当我们把 具有某些联系的原始数据(X1,X2,…,Xn)输入到 AE中进行重构学习时,可以完成特征提取的任务. 自编码器的应用场景是非常广泛的,经常被用于数据去噪、图像重构以及异常检测等任务中.除此之 外,当 AE被用于生成与训练数据类似的数据时, 称之为生成式模型.由于 AE具有上述优点,一些学 者便将 AE 及其变体模型应用到图神经网络当中 来.文 献 [69]第 1 个 提 出 了 基 于 变 分 自 编 码 器 (variationalautoencoder,VAE)的变分图自编码器 模型 (variationalgraphautoencoder,VGAE),将 VAE应用到对图结构数据的处理上.VGAE利用隐 变量学习出无向图的可解释隐表示,使用了图卷积 网络编码器和一个简单的内积解码器来实现这个模 型.

4. 未来研究展望 GNN

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“G34” 就可以获取《图神经网络综述》专知下载链接