【导读】图学习是当前研究的焦点。深度图学习在商业和科学领域都取得了显著的进展,从金融和电子商务,到药物和先进材料的发现。尽管取得了这些进展,但如何确保各种深度图学习算法以对社会负责的方式运行并满足监管要求成为一个新兴问题。腾讯等10家机构20位作者《可信赖图学习》综述论文,54页pdf全面阐述图学习可靠性、可解释性与隐私保护,非常值得关注!

深度图学习在商业和科学领域都取得了显著的进展,从金融和电子商务,到药物和先进材料的发现。尽管取得了这些进展,但如何确保各种深度图学习算法以对社会负责的方式运行并满足监管要求成为一个新兴问题,特别是在风险敏感的领域。可信图学习(Trusted graph learning, TwGL)旨在从技术角度解决上述问题。与传统的图学习研究主要关注模型性能不同,TwGL考虑了图学习框架的可靠性和安全性,包括但不限于鲁棒性、可解释性和隐私性。在这项综述中,我们从可靠性、可解释性和隐私保护三个维度,全面回顾了TwGL领域的最新领先方法。我们给出了现有工作的一般分类,并对每个类别的典型工作进行了回顾。为了对TwGL的研究提供更深入的见解,我们提供了一个统一的视角来审视以往的工作,并建立它们之间的联系。本文还指出了TwGL未来发展中有待解决的一些重要的开放性问题。

https://www.zhuanzhi.ai/paper/f188a74e0d1be9e8635d418e98042fe

引言

近年来,基于图神经网络(GNNs)的深度图学习(DGL)已成为一种强大的图表示学习范式。在过去的几年中,DGL正成为一个活跃的前沿领域,研究呈指数级增长。DGL凭借其在图结构数据建模方面的优势,在金融(如欺诈检测和信用建模)[28,144,9,67]、电子商务(如推荐系统)[126,85]、药物发现和先进材料发现[41,134,100,82,83]等许多重要领域取得了显著进展。

尽管在深度图学习领域已经取得了相当大的进展,但在许多实际应用中,尤其是在风险敏感和安全关键的场景,如金融和生物信息学中,与GNN相关的可信性水平仍存在许多挑战[100]。这些挑战是真实存在的,需要复杂的解决方案,因为在当前快速发展的作品中,DGL模型的许多不值得信任的方面已经通过对抗性攻击[19,13]、固有偏见或不公平[157]以及缺乏可解释性[152]和隐私保护[16]暴露出来。针对这些挑战,各种人工智能(AI)伦理方面的新兴法律法规,如欧盟通用数据保护法规(GDPR)[91],促使不同的公司开发值得信赖的算法,以满足隐私、可解释性和公平性等监管合规要求。

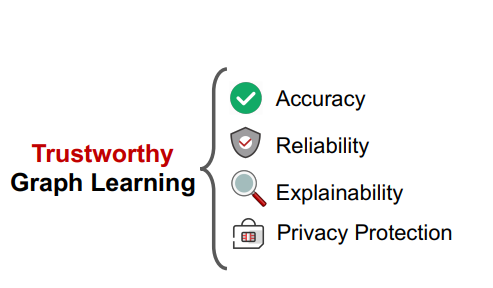

近年来,一个新的研究趋势是研究如何构建可信的算法,并确保它们的行为具有社会责任感。可信图学习(trusted Graph Learning, TwGL)是一个新兴的领域,旨在从技术角度解决图数据的可信问题,已成为深度图学习领域关注的焦点。与传统的图学习研究主要关注如何开发精确模型不同,TwGL考虑了模型性能之外的图学习问题的各种可靠性和安全性方面。在图1中,我们总结了可靠TwGL的四个关键维度,即准确性、可靠性、可解释性和隐私保护。

具体描述如下:1) 准确性或实用性:预测准确性是一个可信模型的基本能力。值得信赖的GNN期望产生尽可能准确的输出,与地面的真实情况一致; 2) 可靠性: 值得信赖的GNN应该具有弹性和安全性。换句话说,它们必须对不同的潜在威胁具有健壮性,例如固有噪声、分布转移和敌对攻击;** 3) Explainability**。理解图学习模型是开发可信GNN的另一个重要方面。模型本身必须能够对预测进行解释,从而帮助人类增强理解,做出决策并采取进一步的行动; 4) 隐私保护: 需要值得信赖的GNN保证模型的充分隐私和数据隐私。

动机和贡献。DGL模型的可信度是一个不可避免的问题,当它们进入现实世界的应用时,在学术界和工业界都提出了各种开放的、未探索的和未知的挑战。因此,需要对DGL模型的各个方面进行仔细考虑,以实现可信度。为了促进TwGL领域的研究,迫切需要从一个统一的角度对当前的工作进行全面的调研。在本次综述中,我们从稳健性、可解释性和隐私保护四个关键维度全面概述了TwGL领域的现有成就。对于每个部分,我们给出了现有工作的一般分类,并回顾了每个类别的典型工作。为了对TwGL的研究提供更深入的见解,我们提供了一个统一的视角来检查以前的工作,并建立它们之间的联系。本文还指出了TwGL未来发展中有待解决的一些重要的开放性问题。

概述。在本文中,我们汇集了TwGL最先进和最重要的工作。本文的组织结构如下:在第2节中,我们全面回顾了针对三种威胁的可靠DGL的最新进展,包括固有噪声、分布转移和对抗性攻击。在第3节中,我们提供了最先进的GNN解释方法的详细技术概述。在第4节中,我们还讨论了DGL模型的隐私保护问题。对于每个部分,我们总结了未来研究的几个挑战和机遇。最后,我们在第5节中对可信图学习的进一步研究成果进行了总结。

Reliability 可靠性

近年来,基于图神经网络(GNNs)的深度图学习(DGL)在许多重要领域取得了显著进展,包括金融等业务场景(如欺诈检测和信用建模)[28,144,9,67],电子商务(如推荐系统)[126,85],药物发现与先进材料发现[41,134,100,82,83]。尽管取得了进展,但将各种DGL算法应用到实际应用中会面临一系列可靠性威胁。在较高的层次上,我们将这些威胁分为三个方面,即固有噪声、分布转移和对抗性攻击。固有噪声是指图结构、节点属性、节点/图标签中的不可约噪声。分布转移是指训练分布和测试分布之间的转移,包括域泛化和亚种群转移。对抗性攻击是一种操纵性的人类行为,其目的是通过精心设计的模式或对原始数据的扰动导致模型错误行为。典型的例子包括对抗性样本[171]和后门触发器[135]。图2可视化地展示了在深度图学习的典型过程中,不同的威胁是如何发生的。相比之下,在数据生成过程中,由于采样偏倚或环境噪声等原因,往往会在没有人为刻意设计的情况下产生固有噪声或分布偏移,而恶意攻击则是在数据生成阶段之后,故意设计的。表1进一步提供了每个威胁的正式描述,并总结了一些典型的相关工作。 为了提高DGL算法在上述威胁下的可靠性,从优化策略设计和不确定性量化等不同角度开展了大量工作。在本节中,我们将探讨这一研究方向的最新进展。我们在图3中概述了可靠的深度图学习。

Explainability 可解释性

图神经网络(GNNs)[63]的出现使图结构数据的深度学习发生了革命性的变化。GNN在社会网络分析[101,9]、生物化学[150]、计算机视觉[66]、金融[23]等多个领域都取得了优异的表现。尽管它们取得了巨大的成功,但由于它们的决策很少被理解,因此通常被视为黑盒[14579],这导致人们越来越关注gnn的可解释性。在没有对其预测进行解释的情况下,很难完全信任基于GNN的模型,从而限制了其在高风险场景(如临床诊断[56,147]、法律领域[142]等)中的应用。因此,开发提高GNN透明度的解释技术势在必行。近年来,人们提出了多种方法来揭示影响GNN预测的不同方面的知识。通常,他们强调输入图的重要模式,如节点[52,96]、边[145,79]和子图[148,153],这些对模型预测至关重要。在图4中,我们提供了gnn可解释性的概述。这些解释方法可以分为两类: post - thoc方法和自解释方法,根据解释方法是否在体系结构上内置在图模型中。

Privacy 隐私

图学习最近的成功通常是建立在大规模图数据的基础上。然而,在实践中,各种数据法规(如GDPR[]和CCPA[])和来自公众的隐私问题已经成为阻止组织与他人共享自己的图形数据的主要问题。这里我们以构建电子商务推荐系统为例。在这种情况下,所有用户和条目都可以形成一个大图表,其中一个链接表明用户是否对某个特定条目感兴趣。在这种情况下,用户的特性通常分布在不同的组织中。例如,用户的存款和贷款总是存储在金融机构(如微众银行、蚂蚁金服),而购物历史总是存储在电商机构(如京东、阿里巴巴)。如果我们进一步考虑用户之间的社交联系,这些数据通常存储在诸如微信这样的社交网络部门中。从上面的例子中我们可以看到,用户-项目图被展示为一个大型异构图,子图由不同的组织或部门持有,即“数据孤岛”。这个问题对将图学习应用到现实世界的场景提出了严峻的挑战。

为了解决这一问题,人们努力构建隐私保护图学习(privacy-preserving graph learning, PPGL)[95, 53, 17, 46, 165],旨在建立保护用户数据隐私的图学习框架。在本次综述中,我们将以往的PPGL研究工作分为三个方向,即联邦图学习、隐私推理攻击和私有图学习。具体来说,联邦图学习(FGL)旨在提供一个通用的分布式学习范式,使多个组织能够联合训练一个全球模型,而无需共享自己的原始数据。虽然FGL为原始数据提供了保护,但大多数工作仍然需要共享中间数据,如梯度或隐藏的特征,这些数据也可能包含一些敏感信息。这些信息可以通过一些特定的隐私推断攻击来重建,这是本节的第二部分。此外,我们回顾了一些最近的私有图学习工作,这些工作旨在使用密码技术来防止上述攻击