如何构建可信GNN?最新综述来了!可信图神经网络:维度,方法,趋势

前言

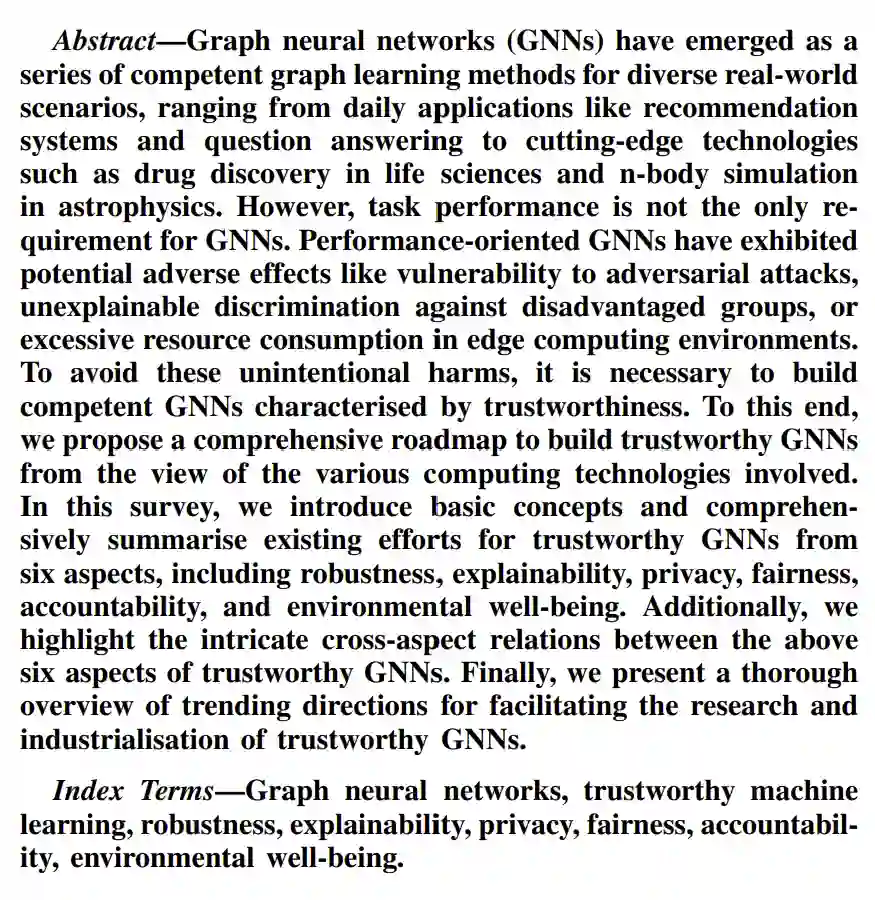

近年来,构建可信人工智能系统已经成为了世界各国的普遍共识 [2][3]。如何全面地建立起可信图神经网络已经成为了一个亟待解决的重大问题。该文是由Monash团队(Shirui Pan, Xingliang Yuan,Bang Wu, He Zhang)联合Hanghang Tong (UIUC) 以及Jian Pei (SFU,即将入职Duke)对可信图神经网络的最新综述(双栏36页,299篇文献)。

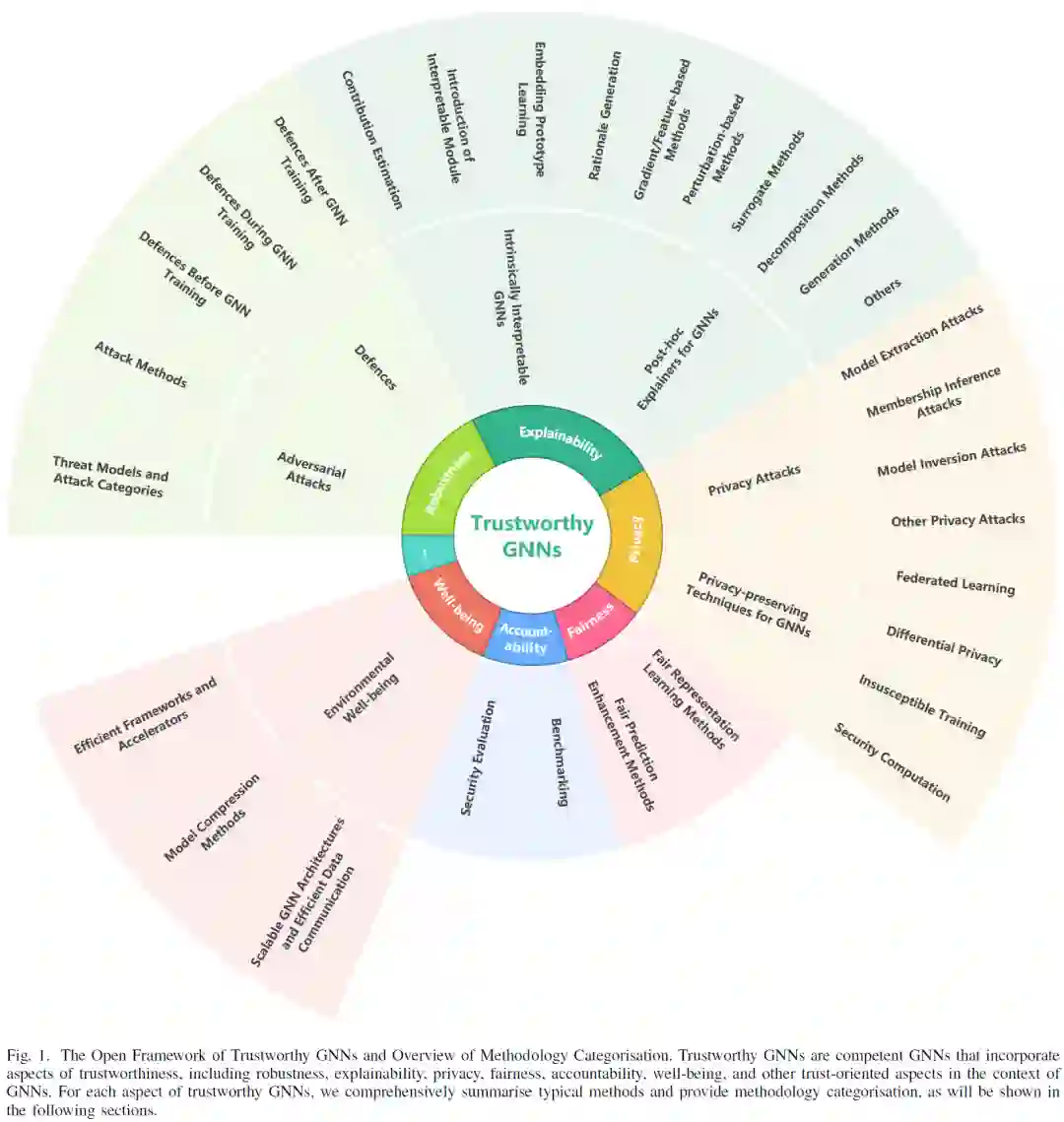

该综述从研究背景与特点出发,提出了一个可信图神经网络的开放框架,着重阐述了“可信GNN”的六大维度(鲁棒性、可解释性、隐私、公平性、问责、环境福祉)及其技术方法。同时,该综述探讨了不同可信维度之间的交互关系,并提出了可信图神经网络未来的研究方向,为建立起可信图神经网络描绘了一幅细致而全面的技术路线图。

单位丨Monash University

全文链接:https://arxiv.org/pdf/2205.07424.pdf

Github: https://github.com/Radical3-HeZhang/Awesome-Trustworthy-GNNs

图作为一种具有极强表示能力的数据类型,通过描述实体特征和刻画实体之间的关系,已经被广泛应用于描述生物学、化学、物理学、语言学和社会科学等诸多领域的数据。近年来,图神经网络技术的蓬勃发展已经革命性地提升了各种图计算任务的性能,并促进了其在现实生活中的广泛应用。

在日常生活中,图神经网络通过考虑用户与用户/服务内容之间的交互关系,可以在信息流媒体、在线购物、社交软件等消费应用中为用户提供个性化搜索与推荐服务。在科学前沿中,通过使用图数据来表示复杂的系统,研究者们可以使用图神经网络来发现天体运动背后隐藏的规律。通过将其应用于虚假新闻检测与新冠药物研发,图神经网络大大提升了我们的社会福祉。

虽然研究者们已经从很多角度(如自监督学习,提升模型深度等)设计出了进一步提升图神经网络性能的方法,但是在一些关键领域中任务性能不是设计图神经网络的唯一目标。例如,基于图神经网络的异常检测系统需要对恶意攻击具有鲁棒性,基于图神经网络的信用评分系统不应该因为用户的年龄、性别等因素拒绝其贷款申请,基于图神经网络的药物发现应用应向研发人员提供其结果的全面解释。

基于上述需求,人们愈发渴望基于图神经网络系统是可信的。在这样的背景下,这篇综述旨在总结“可信图神经网络(Trustworthy GNNs)”的最新进展,为相关研究人员和从业人员提供技术路线图,并为可信图神经网络的未来研究与产业化发展提供方向。

这篇综述的主要贡献有:1)以包含诸多可信维度的开放框架描述了可信图神经网络,并提出了图神经网络与其他常见人工智能技术(如CNN)在可信研究中的典型差异;2)针对图神经网络的不同可信维度,对现有方法进行了综合且全面的总结;3)提出了不同可信维度之间的关系对于构建可信图神经网络系统至关重要,并从方法和成效两个层面总结了已有的研究工作;4)通过将可信图神经网络的概念作为一个整体,提出了未来的潜在研究方向。

为了便于读者理解,本文首先对以下核心概念进行介绍。

图数据(graph data):图

图神经网络(GNNs):图神经网络是一系列可用于图数据上计算任务(如节点分类、链接预测、图分类)的神经网络的总称。图神经网络中的一个典型运算步骤是消息传播(message passaging)。在消息传播的过程中,图神经网络通过聚合所有邻居节点的信息来更新当前节点的表示。在与其他运算结合(如非线性激励)的基础上,经过多次表示更新迭代后,图神经网络可以计算得到相应的数据表示。

可信(trustworthiness):可信用于形容一个系统是值得被信任的,它描述了信任发起者(the trustor)与信任接收者(the trustee)之间的信任(trust)关系。在可信图神经网络的上下文中,信任接收者(the trustee)是图神经网络系统,信任发起者(the trustor)可以是用户,开发者,监管部门甚至整个社会。

可信图神经网络(Trustworthy GNNs)被定义为兼顾可信和卓越性能的图神经网络,这些可信维度包含但不限于图神经网络的鲁棒性、可解释性、隐私、公平性、责任和福祉。原文定义如下:“In this survey, we define trustworthy GNNs as competent GNNs that incorporate core aspects of trustworthiness, including robustness, explainability, privacy, fairness, accountability, well-being, and other trust-oriented characteristics in the context of GNNs.”

该综述在第一章主要介绍了研究背景、可信图神经网络的定义、不同可信维度的定义、度量和研究差异、与已有综述的关系及其主要贡献。在第二章,它介绍了图神经网络的基本概念和计算任务。在第三至八章,它分别从鲁棒性(robustness)、可解释性(explainability)、隐私(privacy)、公平性(fairness)、问责(accountability)、环境福祉(environmental well-being)这六个方面介绍、总结了典型的技术方法并讨论了未来的研究方向。在第九章,这篇综述从方法和成效两个层面,总结了上述六个可信维度之间的复杂关系。最后,综述的第十章将可信图神经网络看成一个整体,为全面构建可信图神经网络系统提出了未来研究与产业化的五个方向。

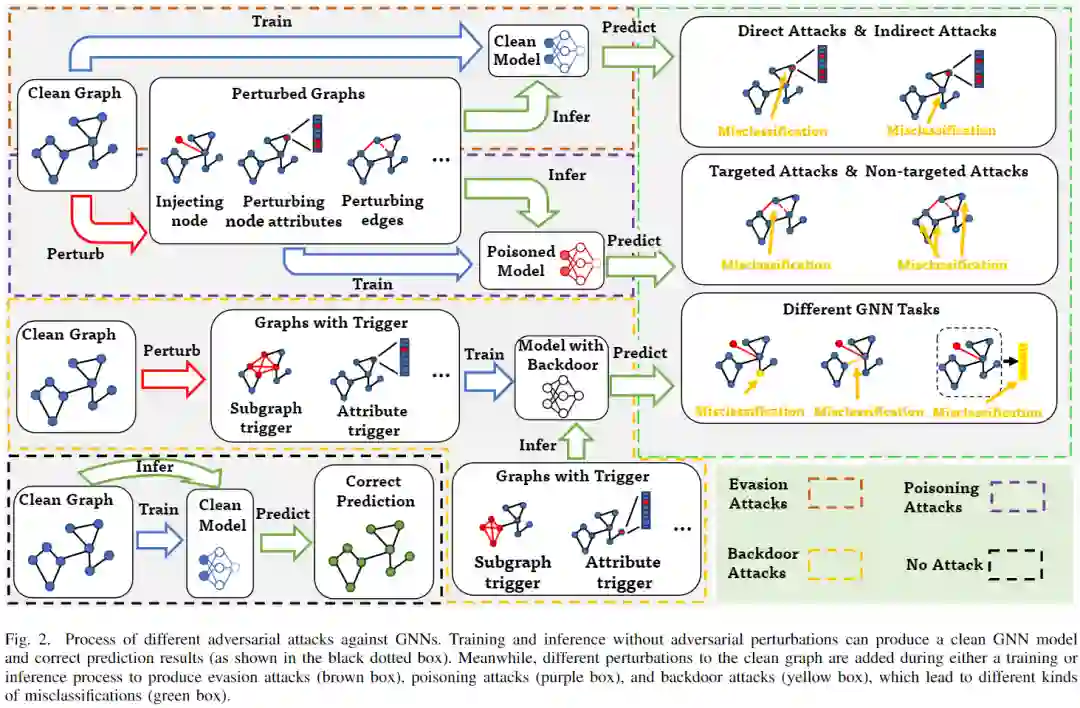

鲁棒性是指图神经网络面临干扰时保持稳定预测结果的能力。图神经网络的预测结果可以被多种扰动(尤其是各类针对图神经网络的攻击)所影响。这给图神经网络在这给图神经网络在银行金融系统的欺诈侦测、自动驾驶系统的交通预测及规划等涉及人身财产安全的场景中的应用带来了较为严峻的挑战。因此,针对鲁棒性的研究是可信图神经网络中不可或缺的关键环节。

该综述总结了目前图神经网络鲁棒性研究的相关工作,并分别介绍了对抗攻击、防御的分类和一些典型方法。其中,对抗攻击的分类源自对攻击威胁模型(threat model)的分析,如下图所示;对防御的分类则更多基于该技术的具体执行阶段(target phase)。

在介绍不同类别的方法时,作者对这些方法的特点与用于其他常见的人工技术(如CNN)的方法的差异进行了讨论。例如,具体扰动操作类型(perturbation operations)和攻击者目的(attack goals)的不同分类和名称变化。

此外,作者还对这些攻击、防御方法的适用性进行了讨论和总结。例如,对不同类型的防御方法,作者从应用阶段(stage of application)、模块化(modularity)、部署的兼容性(deployment compatibility)三个角度进行了比较和分析。

最后,该综述根据目前现状提出了未来的两个研究方向,分别是制定标准化的鲁棒性评估方法(robustness evaluations)和提高现有防御方法的可扩展性(defence scalability)。

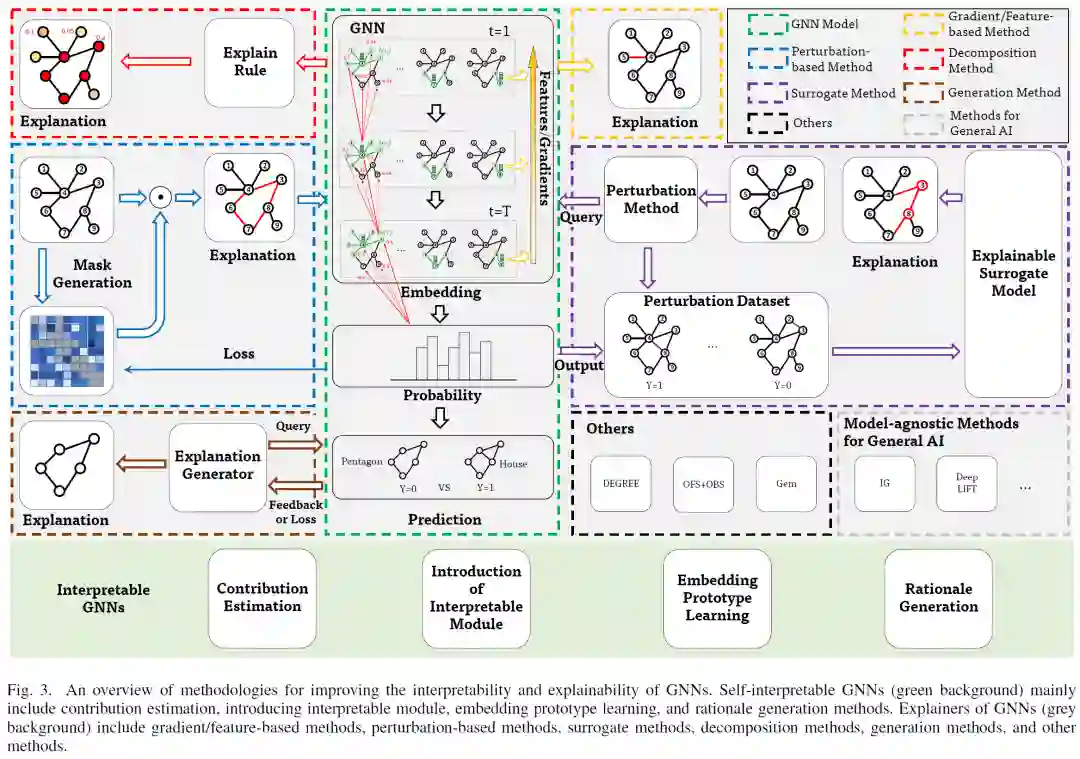

可解释性是指使图神经网络的预测结果可以被人理解的能力。如果其预测结果不能够被人所理解,那么人们就不会信任图神经网络。信任的缺失会进一步限制其在涉及公平(如信用风险预测)、信息安全(如芯片设计)、生命安全(如自动驾驶)的场景中的应用。因此,可信的图神经网络系统需要对其预测结果做出解释。

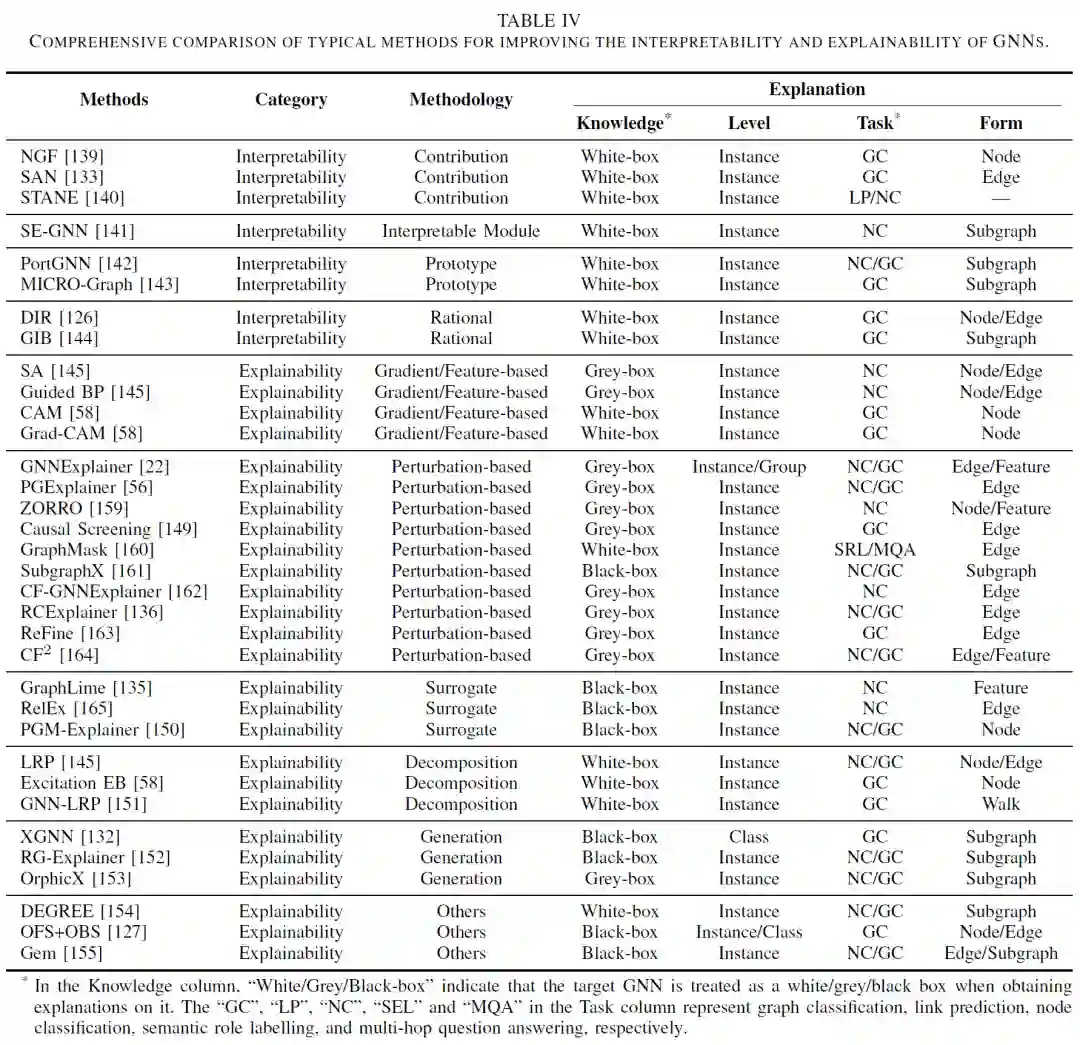

在介绍了解释形式、解释方法的类别等基本概念后,该综述将涉及图神经网络可解释性的工作分成了自解释(interpretable GNNs)和事后解释(post-hoc explainers)两类。自解释(Interpretable GNNs)主要包含了贡献估计(contribution estimation)、引入可解释模块( introduction of interpretable module)、嵌入空间原型学习(embedding prototype learning) 和依据生成方法(rationale generation methods)。事后解释(post-hoc explainers)主要包含了基于梯度/特征的方法(gradient/feature-based methods)、基于扰动的方法(perturbation-based methods)、代理模型方法(surrogate methods)、分解方法(decomposition methods)、生成方法(generation methods)和其他方法(other methods)。

该综述在介绍了典型方法的原理后,对这些方法进行了全面的比较,如下表所示:

此外,该综述从自解释与事后解释(interpretability and explainability)、提供解释时所需的背景知识(white/grey/black-box knowledge)、获得解释的推理原理(reasoning rationale)、其他局限性(other limitations)这四个方面对当前的工作进行了总结。最后,该综述提出建立严格的模型不可知的解释方法(strictly model-agnostic methods)和用于真实应用的评估基准(evaluation benchmark for real applications)是图神经网络的可解释性未来研究的两个方向。

隐私也是构建可信图神经网络时不可忽略的可信维度。在构建和维护可信图神经网络系统的过程中,模型本身或者图数据等敏感、隐私的信息都面临被泄漏的风险。因此,该综述首先对当前隐私数据泄漏相关的研究进行了总结,然后介绍了多种隐私保护方法。

针对隐私泄露问题,该综述从当前隐私攻击的威胁模型入手,首先介绍了潜在威胁的目标和能力,然后介绍了模型提取(model extraction attack)、成员推断(membership inference attack)、模型逆向(model inversion attack)这三个常见的隐私攻击和其他场景中存在的隐私泄露隐患。

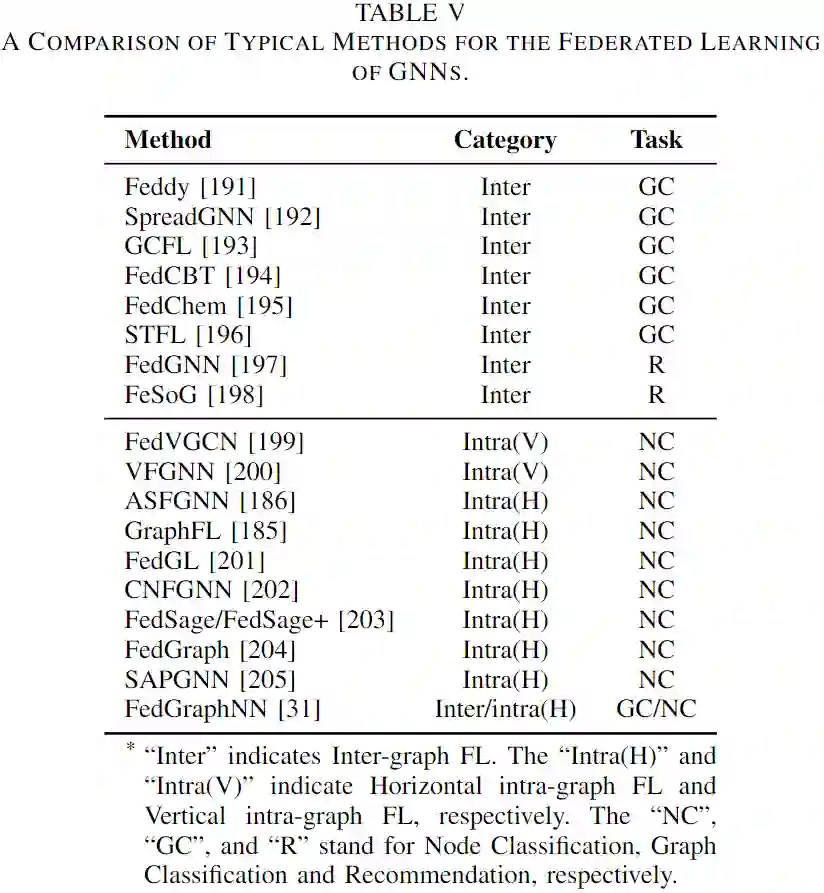

随后,该综述介绍了在图神经网络场景下的联邦学习(federated learning)、差分隐私(differential privacy)、脱敏训练(insusceptible training)、安全计算(security computation)这四种隐私保护技术。此外,作者在对上述技术进行了分类介绍后,还对它们的具体应用场景和隐私保护结束所带来的隐私保护、模型精度、实行效率之间的权衡问题进行了讨论。

在章节末尾,针对当前研究的现状,作者认为目前对梯度信息导致的泄漏(leakage from gradient)隐患、隐私攻击的防御手段(defence against privacy attacks)的研究仍绠短汲深,未来还需要进一步地关注和探索。

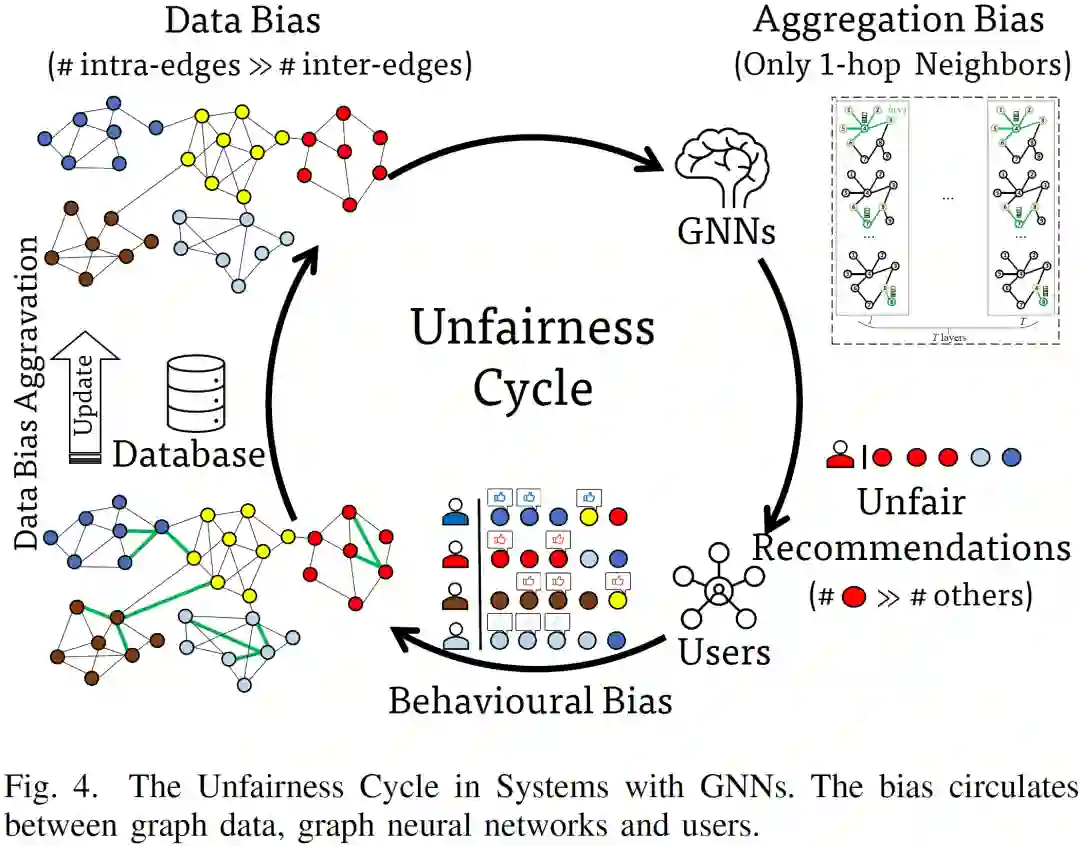

通过保护弱势群体或者个人的关键利益,公平的系统可以赢得人们的信任。公平的图神经网络系统意味着其预测结果中排除了对于某些群体或者个人的偏见。当前,图神经网络主要以数据驱动的方式来完成图计算任务。然而,图神经网络中的消息传播机制可能会进一步放大已经存在于数据中的偏见。此后,由于个人喜好或者行为偏差等因素,人们在与图神经网络服务交互的过程中将进一步加深图数据中的偏见。

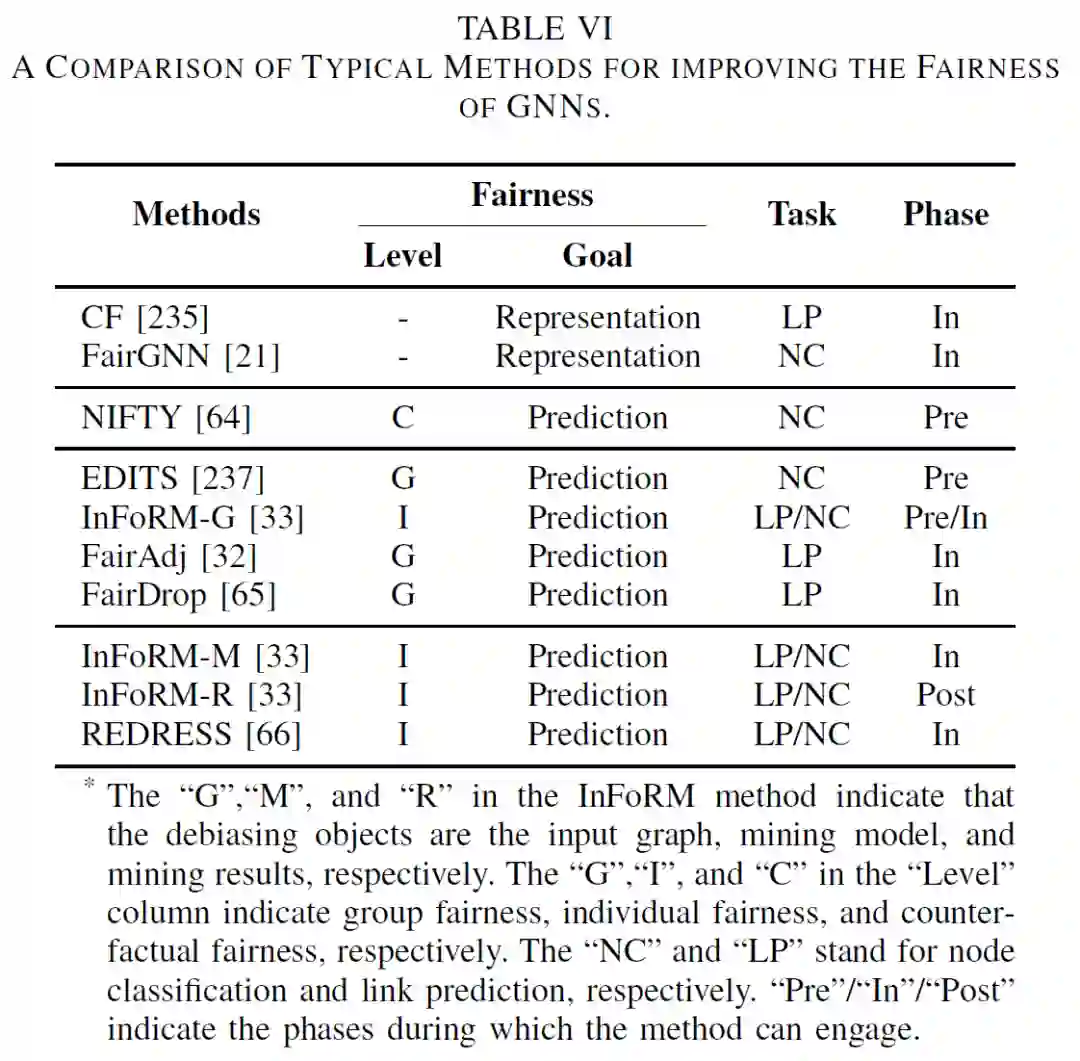

在介绍了公平性定义(group fairness,individual fairness, counterfactual fairness)、使用阶段(pre-processing, in-processing, post-processing)等基本概念后,该综述将当前的用于图神经网络公平性研究的方法分成了公平表示学习方法(fair representation learning methods)和公平预测增强方法(fair prediction enhancement methods)。在介绍完这些方法的基本原理后,对这些方法进行了全面的比较,如下表所示。

最后,该综述提出探讨公平性的定义与评估(fairness definition and evaluation)、对任务性能的影响(influence on task performance)、解释不公平的来源(revealing unfairness)是未来图神经网络公平性研究中需要重点关注的研究方向。

随着愈加广泛的应用场景和复杂的系统结构的出现,个人、企业和政府机构都对可信图神经网络中的有效问责提出了更高的要求。近年来,中、美、欧的企业和政府机构关于如何构建人工智能的问责框架提出了各自的规划和指导意见。该综述基于上述内容,归纳了对图神经网络问责框架的三个要求:

(1) 应当设计合理的评估和认证机制(assessment and certification processes),并使其伴随整个图神经网络系统的开发和运行周期;

(2) 应当保证开发和运行过程的可审计性(assurance of auditability);

(3) 应当建立足够的协调和反馈机制,以方便人类对系统实施干预(adjusting)、补救(remediating)等措施,并可以对不当行为进行惩罚(punishing)。

随后,该综述介绍了当前可用于构建可信图神经网络系统中问责框架的两大类工作:基准化分析(benchmarking)和安全性评估(security evaluation)。

该综述根据图神经网络不同的开发阶段—模型设计(architecture design)、模型训练(model training)、模型验证(model validation)—对基准化分析的研究进行了介绍。对于安全性评估,作者主要介绍了验证系统完整性(integrity verification)的相关研究,并根据验证对象的不同分别介绍了数据完整性(data integrity)、程序完整性(procedure integrity)的验证。

最后,该综述为可信图神经网络的问责提出了三个研究方向。第一,提供针对更多不同性质逾矩行为的检测(violation detection);第二,覆盖全过程的程序完整性检测和全部件的数据完整性检测;第三,继续提高系统的可审计性和建立更多的协调反馈机制。

可信图神经网络应当符合其部署环境的社会价值观。当前,全球变暖是人类社会亟需解决的重大环境问题,实现碳中和的雄伟目标需要各行各业的共同努力。为了降低图神经网络系统的环境影响,在介绍了节点数每焦耳等相关的度量后,该综述总结了提升图神经网络效率的多种方法。

(1) 可扩展的图神经网络和高效的数据通信:随着图数据的爆炸性增长,大规模数据集对于图神经网络的高效运行提出了挑战。为了应对这一挑战,当前的技术主要包含了采样方法(sampling method)、可拓展架构(scalable architectures)、产业应用(industrial applications)、高效数据通信(efficient data communication)等。

(2) 模型压缩技术:随着技术的发展,研究人员提出了更深和更复杂的图神经网络模型来提升其性能。然而,这些模型的规模限制了其在只具备有限计算资源的边缘计算设备上的部署。因此,模型压缩技术是解决这一挑战的一个有效方法。相关的技术包含了知识蒸馏(knowledge distillation)、模型剪枝(model pruning)、减少参数规模(reducing parameter size)、模型量化(model quantisation)等。

(3) 开发框架与加速器:图数据的不规则性、模型中稀疏与稠密计算的相互交替、模型与应用的多样性等特点使得图神经网络系统需要使用专门设计的框架与加速器来提升其效率。为了解决这一问题,当前的方法主要有软件框架(SW frameworks)、硬件加速器(HW accelerators)、效率瓶颈分析(analysing the efficiency bottleneck)、软硬件协同设计(SW-HW co-design)等。

最后,该综述提出探索高效的图神经网络(exploration of efficient GNNs)和研究用于图神经网络的加速器(accelerators for GNNs)是未来促进图神经网络环境福祉的两个研究方向。

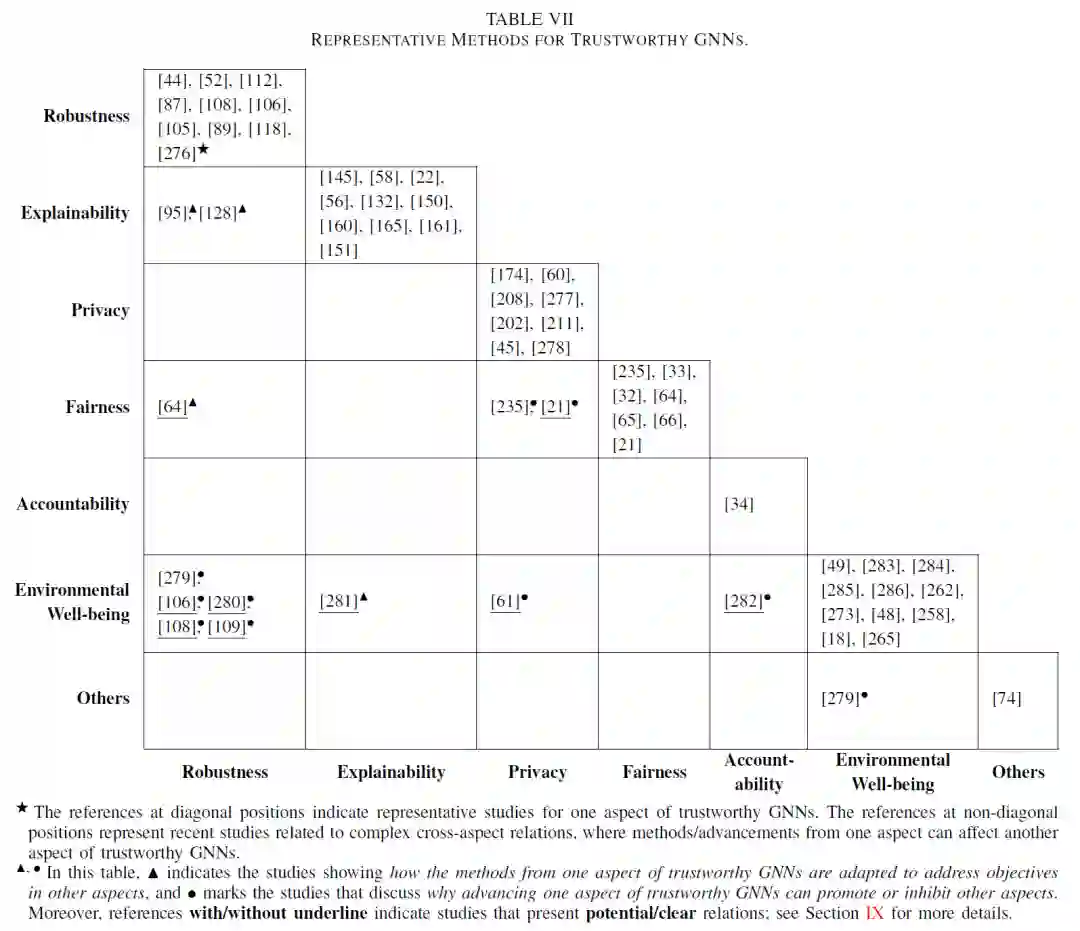

当前促进图神经网络可信性的研究主要集中在上述六个维度中的一个,该综述提出构建可信图神经网络不能忽视上述六个可信维度之间的关系,并从如下两个角度对此进行了总结:

1) 来自可信图神经网络中一个维度的方法如何被用于解决其他维度的研究问题(how the methods from one aspect of trustworthy GNNs are adapted to address objectives in other aspects)。

2) 为什么促进可信图神经网络的一个维度可能会促进或者抑制其他可信维度(why advancing one aspect of trustworthy GNNs can promote or inhibit other aspects)。

针对潜在的研究热点,该综述将可信图神经网络看作一个整体并分析了当前方法的局限性。为了填补当前的研究空白,推动可信图神经网络的产业化,该综述提出了如下五个研究方向:

A. 拥抱可信设计理念(shift to trustworthy GNNs)

构建可信的图神经网络需要研究人员与图神经网络从业人员全面拥抱可信理念,在设计图神经网络时不仅要考虑其任务性能,更需要将可信的理念引入到图神经网络的设计哲学中。已有的一些工作在设计中兼顾了可解释性和公平性,这大大提升了图神经网络的可信性。此外,解决在转向可信图神经网络的过程中面临的一系列开放性问题,如在具体应用中对不同可信维度(如自动驾驶中的鲁棒性和环境福祉)进行平衡和取舍,也是一个具有挑战性的研究方向。

B. 探索其他可信维度(other aspects of trustworthy GNNs)

可信图神经网络所包含的内容实际上超过了该综述介绍的六个维度。例如,泛化能力(generalisation)也被认为是可信系统的一个重要维度。当前一些研究探究了图神经网络外推(extrapolation)与其使用的激活函数之间的关系,这些工作丰富了可信的内涵并促进了可信图神经网络的构建。此外,该综述提出,妥善处理可信系统相关的设计原则(如国家新一代人工智能治理专业委员会发布的《新一代人工智能治理原则——发展负责任的人工智能》)也是可信图神经网络在未来发展中的重要研究内容。

C. 研究多样相互关系(diversified relations)

该综述只涉及了可信图神经网络不同维度之间复杂关系的一部分。探索其他相互关系(如可解释性和公平性)对于全面理解和构建可信图神经网络系统至关重要。此外,这些关系不仅复杂而且存在于多个层面。比如,反事实公平(counterfactual fairness)与鲁棒性(robustness)在概念上具有相似性。因此,从概念、方法、成效等不同的层次探讨可信图神经网络的不同维度之间的相互关系也是一个有前景的研究方向。

D. 设计模型不可知方法(model-agnostic methods)

当前,很多提升图神经网络可信性的方法需要使用专门设计的图神经网络架构。如果不能访问或者修改目标网络架构(如使用云服务),这些方法将无法使用。这大大降低了这些可信性增强方法在现实场景中的实用性。相比之下,模型不可知方法能够以即插即用的方式灵活地被应用到图神经网络系统中。此外,这类方法也能够以功能模块的形式被组合使用。因此,设计模型不可知的方法将大大提升其实用性并促进可信图神经网络的构建。

E. 建立可信技术生态(technology ecosystem for trustworthy GNNs)

作为一个蓬勃发展的领域,可信图神经网络的发展离不开技术生态的支持。这里的技术生态包含但不限于工具包(tools)、数据集(datasets)、评估度量(metrics)、评估流程(pipelines)。由于图数据的自身特性,当前的一些工具包(tools)如IBM的AI360可能无法直接用于图神经网络的评估。例如,节点之间边的存在打破了节点上的独立同分布(IID)假设,这就导致研究图神经网络公平性时需要考虑节点之间的相互依赖。此外,由于应用场景的多样性,构建可信图神经网络也需要适用于不同任务和场景的数据集、度量、评估标准、软件平台等配套技术设施。因此,建立相应的技术生态是可信图神经网络的研究和产业化中的关键一步。

参考链接:

[1] Trustworthy AI: A Computational Perspective. https://arxiv.org/abs/2107.06641

[2] Governance Principles for the New Generation Artificial Intelligence--Developing Responsible Artificial Intelligence. https://www.chinadaily.com.cn/a/201906/17/WS5d07486ba3103dbf14328ab7.html

[3] The montreal declaration of responsible ai. https://www.montrealdeclaration-responsibleai.com/the-declaration