CODE: 基于对比学习和对抗微调的无监督专家链接框架 | 论文荐读

作者:

Bo Chen, Jing Zhang, Xiaokang Zhang, Xiaobin Tang, Lingfan Cai, Hong Chen, Cuiping Li, Peng Zhang, and Jie Tang. CODE: Contrastive Pre-training with Adversarial Fine-tuning for Zero-shot Expert Linking. In Proceedings of the 36rd AAAI Conference on Artificial Intelligence (AAAI'22).

Paper:

http://keg.cs.tsinghua.edu.cn/jietang/publications/AAAI22-Chen-et-al-CODE.pdf

Code & Data:

https://github.com/allanchen95/CODE

专家发现是线上学术平台 Expertise Finder, Linkedin,AMiner 等所提供的一个热门服务,它可以帮助政府或者相关企业寻找合适的研究专家,专业顾问以及项目候选人等。专家发现服务的质量取决于平台专家信息来源的多样性以及专家画像的完整性,但现有的学术平台往往只拥有单一来源的专家信息,例如:Google Scholar 和 AMiner 拥有专家的学术信息,Linkedin 拥有专家的专业技能和背景信息,学术新闻拥有专家的动态科研信息等。故为了提供高质量的专家发现服务,本文以 AMiner 为平台,致力于将多种外源专家信息链接到 AMiner 相应的专家实体,以获取完整的专家画像。

不同源之间的专家链接与传统的实体链接有些类似,但实体链接大多需要大量标签数据进行监督学习。但由于外部源具有异构性,可包含结构化,半结构化甚至非结构化信息,故无法有效获取大量的标签。所以本文研究(1)如何在无监督数据的情境下,训练出高效的专家链接模型;此外,考虑到外部源与 AMiner在模式,语法、话题等方面的领域差距,故需要进一步在外部源中对专家链接模型进行微调,增加其鲁棒性,但(2)如何在标签稀缺的情境下对模型进行微调也是一个挑战。

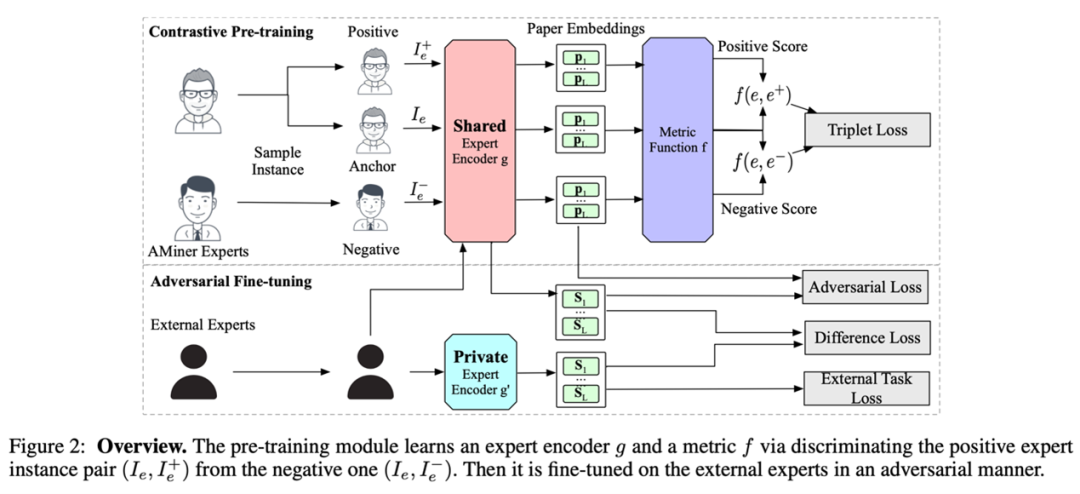

本文提出了 CODE(Contrastive Pre-training with Adversarial Fine-tuning for Zero-shot Expert Linking),该模型由基于对比学习的预训练模块(Contrastive Pre-training)和基于对抗的微调模块(Adversarial Fine-tuning)组成(如上图所示),用来解决在无监督场景下链接外部源专家信息至 AMiner 对应专家实体的任务。CODE 首先在 AMiner 源中利用对比学习进行预训练,以获得基础的专家链接模型。具体地,CODE 以专家辨别(Expert Discrimination)作为预训练任务,通过采样专家的论文子集作为专家实例(Expert Instance),并使用对比学习使得从同一专家中采样出的实例对(Positive Pair)的语义距离比从不同专家中采样出的实例对(Negative)相比更近,以学习专家链接模型。专家链接模型由一个基于 Bert 的专家编码器(Bert-based Encoder)以及基于交互的度量函数(Interaction-based Metric)组成。其中基于Bert的专家编码器可广泛应用于多种外部源,而基于交互的度量函数可捕捉细粒度的匹配信息。通过预训练获得专家链接模型后,CODE 需要进一步在不同外部源中进行微调,CODE 采用对抗微调的方式,其目的是为了尽可能地保留外部源中与 AMiner 相似的通用特征,而摒弃不同源中的独特特征。经过微调后,CODE 拥有更好的鲁棒性,进而高效地将外部源专家信息链接至对应的 AMiner 专家实体。

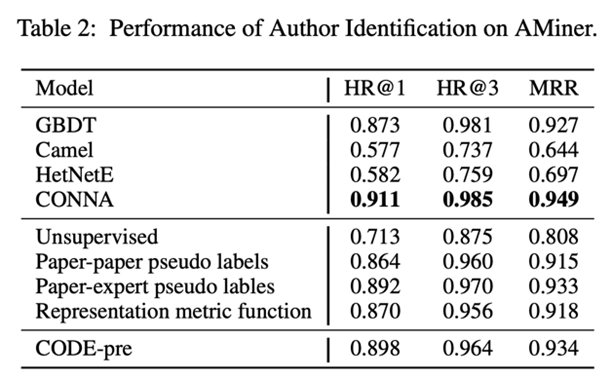

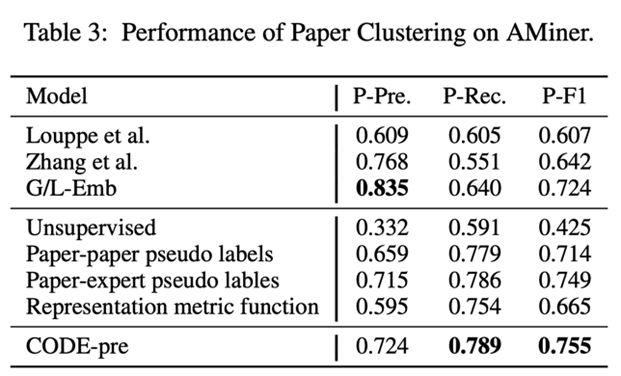

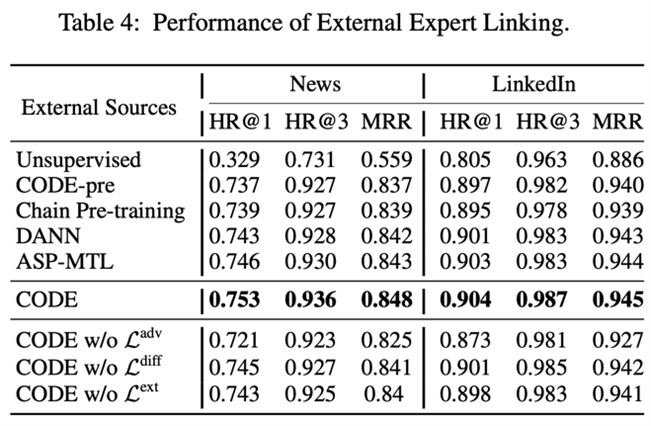

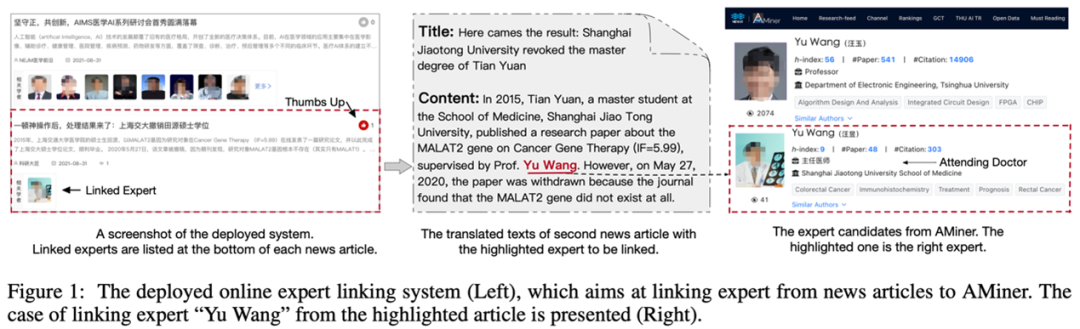

预训练后的 CODE-pre 在 AMiner 的两个评测任务:论文聚类(Paper Clustering)以及作者消歧(Author Identification)上都有着不错的效果,体现出 CODE-pre 的鲁棒性;(2)微调后的 CODE 在 Linkedin 以及 News 两个外部源与 AMiner 的链接任务中取得比 CODE-pre 以及传统对抗学习的基线模型更好的效果,进一步体现出对抗微调的有效性;(3)CODE 已经被部署至 AMiner 专家发现服务中

(https://aminer.top3-talent.com/homepage)

,用于将学术新闻中的专家信息链接至 AMiner 对应的专家主页中。

更多实验分析与结论可点击文末【阅读原文】了解。

本文提出了一个由基于对比学习的预训练模块和基于对抗的微调模块组成的专家链接模型 CODE,用来解决在无监督场景下链接外部源专家信息至 AMiner 对应专家实体的任务。其中,基于对比学习的预训练模块通过专家分辨的预训练任务,以学习通用的专家链接模型;基于对抗的微调模块以对抗的方式使预训练的专家链接模型适应多种外部源的分布。实验结果表明了 CODE 模型的优越性。在未来,我们计划将 CODE 推广到更多的外部源链接中。

点击【阅读原文】查看paper