RASNet 论文笔记

一、背景

(1)、目标的表观特征和语义特征各有优缺点,都很重要

(2)、现有的基于深度学习的目标跟踪方法面临很多问题。比如,离线训练的深度特征提取器在跟踪时不能很好的适应特定的跟踪目标;但若在跟踪时实时提取特征更新特征提取器,就很容易出现过拟合问题,且计算量大不能实现实时跟踪

出于对这些问题的考虑,作者提出了RASNet(Residual Attentional Siamese Network)

二、贡献

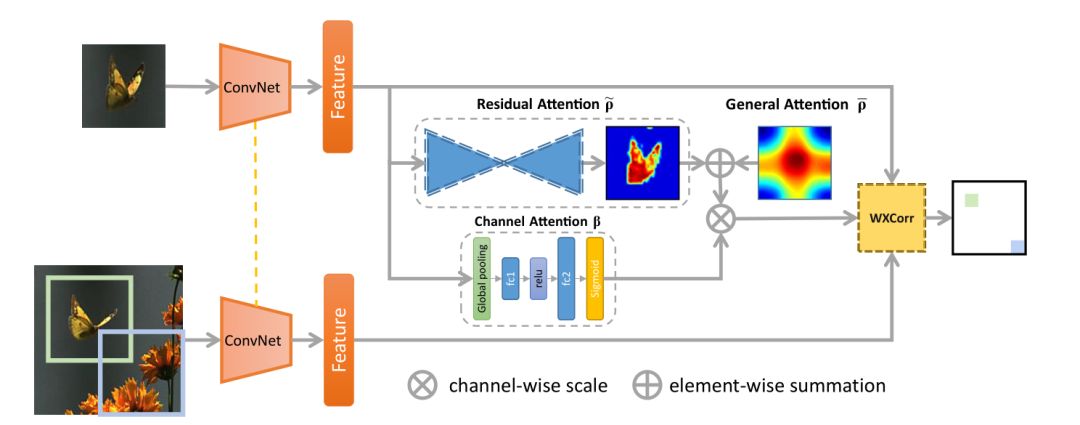

首先, 这篇文章提出了一个名为RASNet的端到端的网络,它在基本的双胞胎网络中加入了三种attention mechanisms,分别为:

· general attention

· residual attention

· channel attention

并在结合双胞胎网络两支的时候提出了一种weighted cross correlations(加权交叉相关)方法。

(1)、提出了一个端到端的、为目标跟踪任务设计的深度框架,利用了很多最近流行的方法,如Hourglass structure,residual skip connection。还有作者提出的weighted cross correlations方法

(2)、在RASNet中引入了不同的attention机制,明显减轻了离线训练的网络在进行跟踪时不能适应跟踪目标 和 深度学习方法在线跟踪时容易过拟合的问题。

(3)、基于深度学习的跟踪方法中达到80FPS,跟踪效果好。

三、网络结构

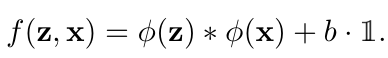

一般的双胞胎网络得到响应如下式:

这样的式子有两个缺点,即它其实既比较了目标的表观特征又比较了目标的语义特征

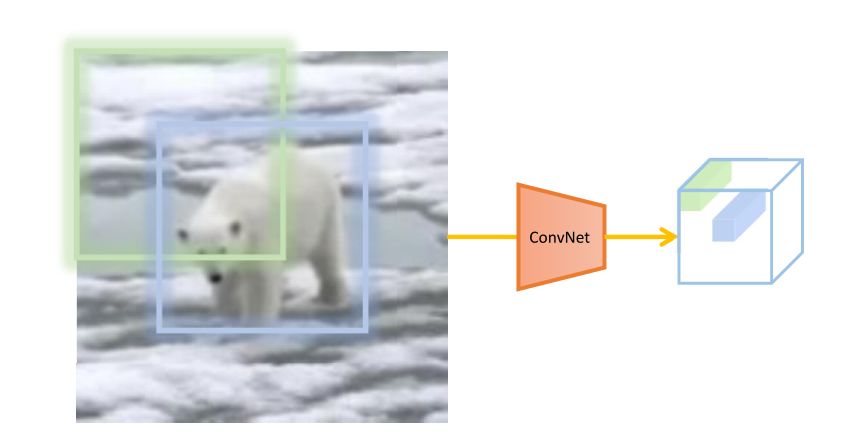

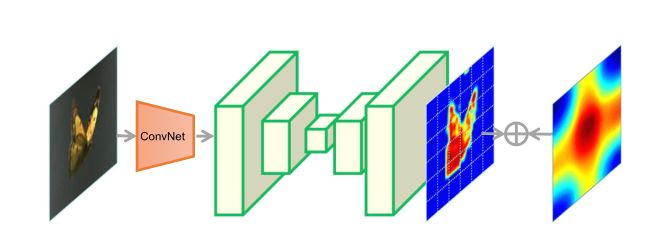

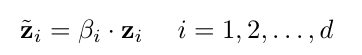

这样做的意义是,特征中每一个成分在双胞胎网络中做互相关操作时的重要性是不一样的。如下图所示,蓝色框内的目标比绿色框内的目标在互相关操作中应该有更强的作用。

但跟踪中一般是图像中心位置的目标更重要,而且

(1)、 Dual Attention

general attention和residual attention结果直接相加得到dual attention。其中general attention描述了所有训练样本的共性,类似一个普通的高斯分布。residual attention描述了训练样本和当前跟踪目标的不同。

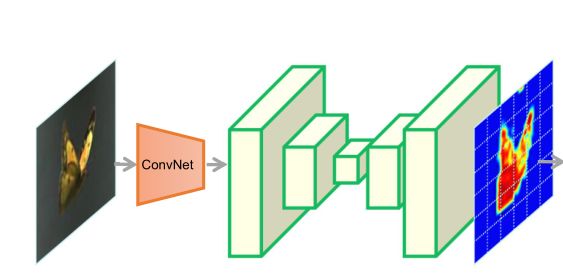

(2)、Channel Attention

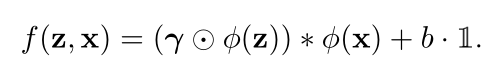

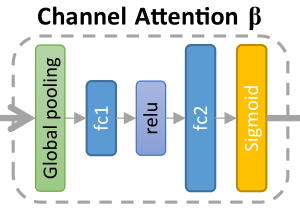

每一个卷积特征通道往往能对应一种特定的直观形象。因此通道的重要性也不同。channel attention可以理解为,为不同的上下文选择语义属性的操作。意义在于,当目标表观不停变换时,深度网络仍能保持一定的适应能力。学习起来也非常简单,如下式:

(3)、训练

整个网络在一个ILSVRC15的视频目标检测数据集上离线训练。

general attention初始化就是一个矩阵。

residual attention使用一个沙漏型的网络训练,如下图

channel attention如下图

为了适应尺度变化,在跟踪时规定了三种尺度,得到的三个响应图中取响应最大的。

四、实验

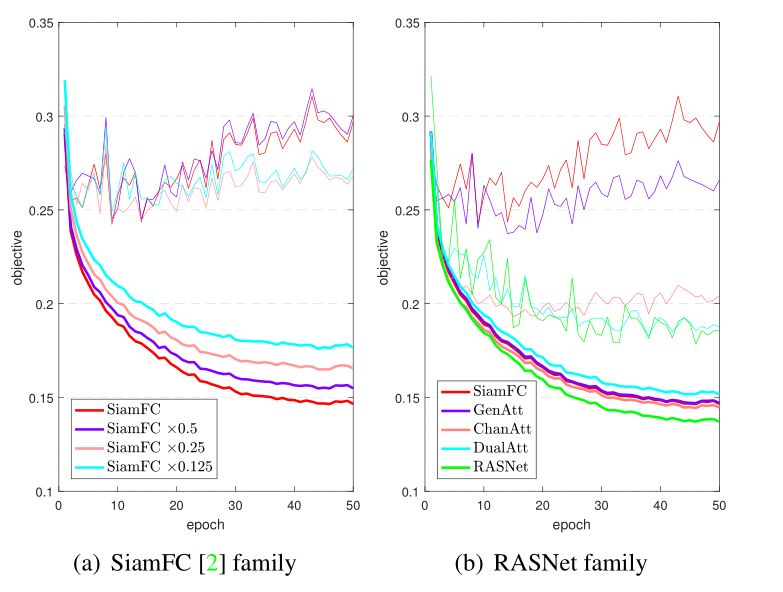

1. 作者跟SiamFC方法了对比

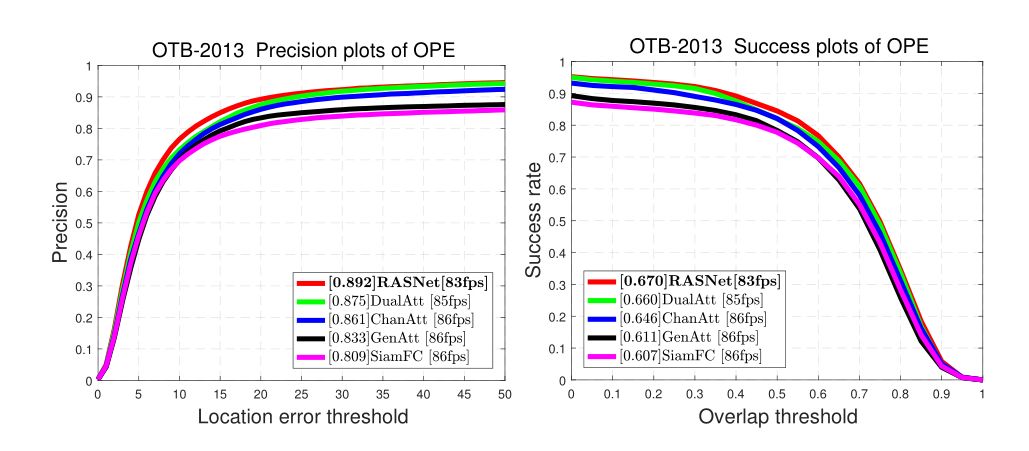

2. 在OTB-2013上验证了各个部分的有效性

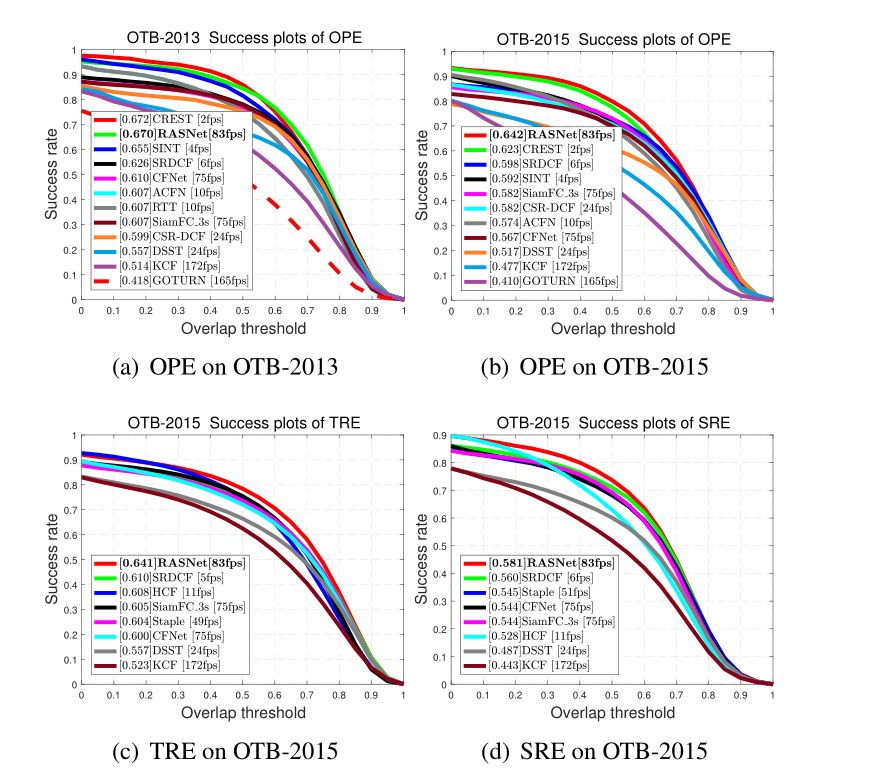

3.在OTB2013和OTB2015以及VOT2015和VOT2017上做了实验

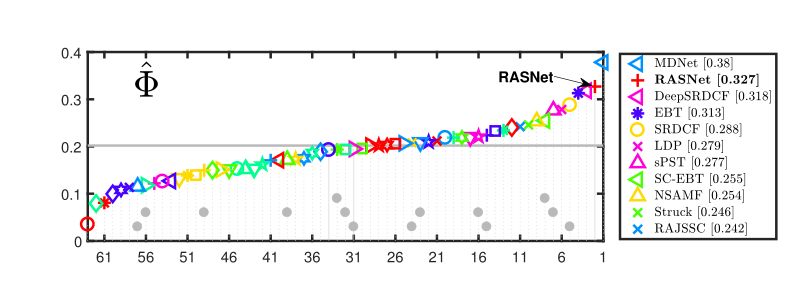

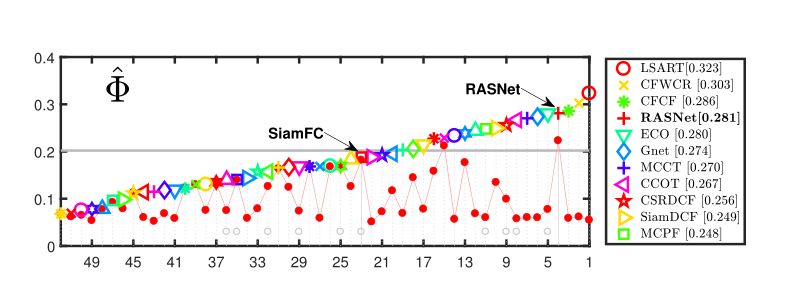

VOT2015

VOT2017