论文浅尝 | 神经网络是如何外推的:从前馈神经网络到图神经网络

笔记整理 | 王泽元,浙江大学在读硕士,研究方向为图神经网络,对比学习。

什么是外推?指从已知数据的孤点集合中构建新的数据的方法。与插值(interpolation)类似,但其所得的结果意义更小,而且更加受不确定性影响。

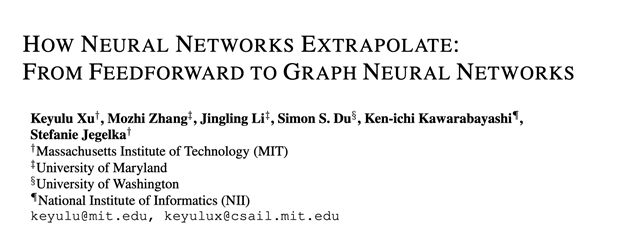

第一张图展示了原始数据的分布;现在我们对原始数据进行线性拟合得到图二,其中蓝色部分就是插值所得到的结果,红色部分就被称为外推所得到的结果;从图三可以看出外推的点相比插值所得到的点,其误差会更大

作者发现前馈神经网络在学习简单多项式的时候外推的表现不好,而图神经网络在比训练集大很多的网络上完成有挑战的任务如预测物理系统的演化时间、学习图算法、解决数学问题中表现的很好。作者对这种差别进行深入研究,研究通过基于梯度下降训练的神经网络是如何外推的,它们在训练集之外学到了什么。经过分析,明确了在什么情况下多层感知机和图神经网络可以外推出良好的结果,并且提供了一个假设:外推的成功依赖于对模型架构和输入的非线性编码

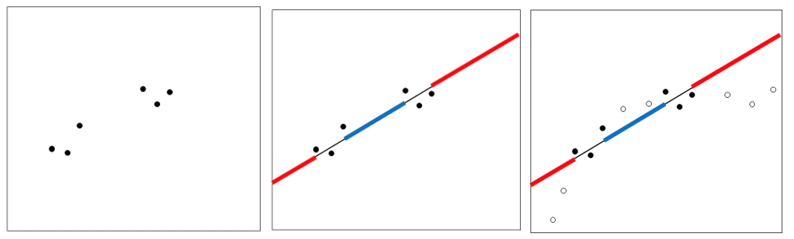

作者首先在多层感知机上进行外推实验下面四张图是文章在让两层的多层感知机上训练得到的结果。其中蓝色是训练数据、灰色是需要拟合的数据、黑色是多层感知机训练的数据。可以看出来在训练集之外,多层感知机预测的结果将会快速的收敛到线性方程

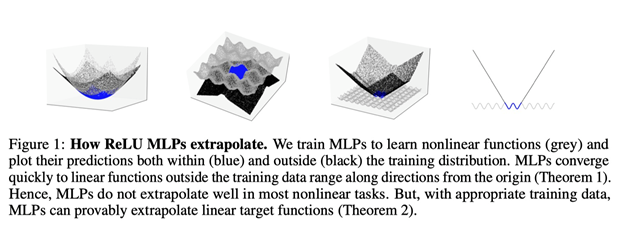

但是仅是需要拟合的数据是线性的并不能让多层感知机拟合的效果变好,还需要添加一个条件:训练集的数据分布需要涵盖所有方向。左图展示的如果涵盖的方向有差别会产生什么效果,右图定量的分析了不同训练集分布会产生的误差。fix1指将一维设为常数、negd指的是限制n维为负数、all指涵盖所有数据。可以看出数据涵盖的越全面,得到的误差就会越小

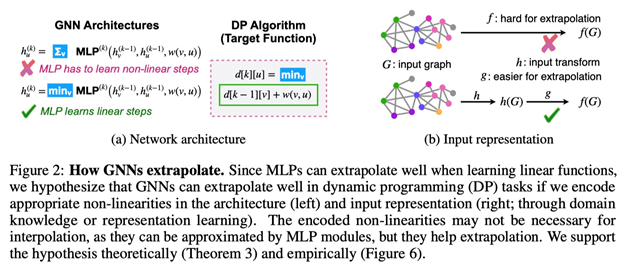

文章之后分析了GNN,文章先让图神经网络学习动态规划算法,可以看到学习的动态规划算法中间有一个非线性操作min,经过实验发现,使用min作为aggregator操作的效果比其他操作效果更好。至此文章提出了线性算法对齐的假设,及我们使用min操作对齐动态规划的dp操作,图神经网络中的多层感知机就可以对齐动态规划中的线性操作。因此图神经网络可以获得良好的外推效果。

由此推论我们可以得到,在一些图神经网络任务中目标方程分解为线性方程和非线性方程,我们可以先对输入进行非线性操作,多层感知机去拟合线性部分。这样做就可以得到好的外推效果

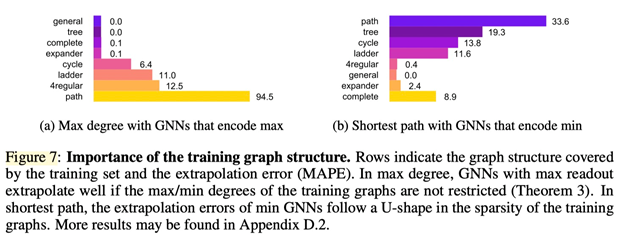

文章还发现不同的图的拓扑结构会影响不同任务的外推效果。在寻找最大节点任务中,对于没有节点度数限制的图表现的效果会更好。环、阶梯图、正则图、路径这种有度数限制的图会导致外推失败。在寻找最短路径任务中,过密或过于稀疏的图都会对外推造成影响。但是文章未对这些现象做出过多解释,需要对图的深入研究才能回答这些问题。

欢迎有兴趣的同学阅读原文。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。