SFFAI分享 | 黄怀波 :自省变分自编码器理论及其在图像生成上的应用

关注文章公众号

回复"黄怀波"获取PDF资料

导读

生成模型一直是机器学习和计算机视觉领域的重要研究方向。以生成对抗网络(GANs)和变分自编码器(VAEs)等为代表的深度生成模型已经成为当前人工智能研究的热点问题和重要前沿方向。目前的各种深度生成模型都各有其优点和缺点,比如生成对抗网络的训练稳定性和模式崩溃(mode collapse)问题等,变分自编码器生成图像比较模糊等。针对这些问题,我们提出了一种新的生成模型——自省变分自编码器,用于实现稳定训练和生成高分辨率真实图像。

作者简介

黄怀波,中国科学院自动化研究所在读博士,本科和硕士分别毕业于西安交通大学和北京航空航天大学,目前主要研究兴趣在生成模型的改进和应用。欢迎感兴趣的小伙伴一起交流讨论。

背景

生成模型是利用一个已知的概率分布来拟合给定的数据样本。其本质是对数据分布先验知识的学习,一般具有推理(Inference)、采样(Sampling)和密度估计(DensityEstimation)等功能。对于比较简单的分布,可以采用概率PCA等线性模型来进行学习;而对于比较复杂的数据分布,现在一般通过深度生成模型来对分布进行建模和学习。

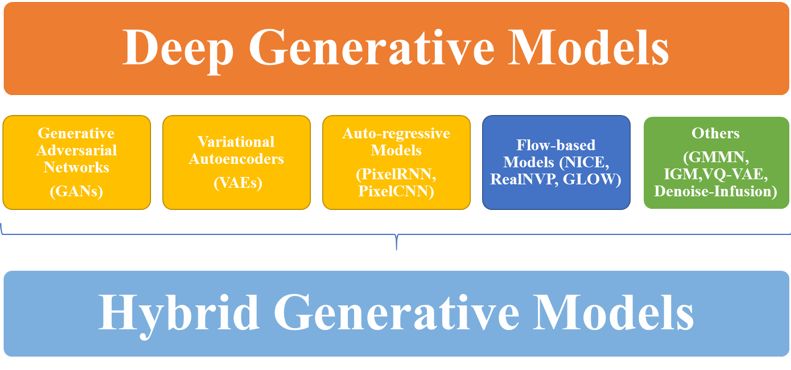

如图1所示,目前主流的深度生成模型主要包括生成对抗网络(GANs)、变分自编码器(VAEs)、自回归模型(Auto-regressiveModels)、流模型(Flow-basedmodels)和其他一些模型。在这些模型中,目前研究最多和应用最广的是生成对抗网络和变分自编码器这两种模型。生成对抗网络通过生成器和判别器之间进行对抗来生成跟真实分布非常接近的样本。它的优点是生成的图像真实清晰,在计算机视觉等任务中应用广泛;缺点是训练不稳定和容易出现模式崩溃的问题。变分自编码器模型通过优化一个变分下界函数来实现输入样本的重构和隐层代码上的先验约束。其训练稳定,能够进行推理和近似密度估计,但是生成的样本非常模糊。虽然很多研究者针对这些问题对生成对抗网络和变分自编码器模型进行了很多改进,但是如何以简单有效的方式训练和生成高分辨率真实图像仍然是一个非常具有挑战的问题。

图1 主流的深度生成模型

自省变分自编码器模型

当前主流的生成高分辨率图像的方法是将高分辨率图像进行分解,分多个阶段,先合成低分辨率图像,再逐渐放大合成高分辨率图像。典型代表是LapGAN或者StackGAN,以及英伟达在ICLR18上的工作PGGAN。这种多阶段训练的方式增加了模型的复杂度,增加了复现文章结果的难度。为此,我们提出了一种新的深度生成模型——自省变分自编码器,能够以简单有效的方式直接合成高清真实图像。

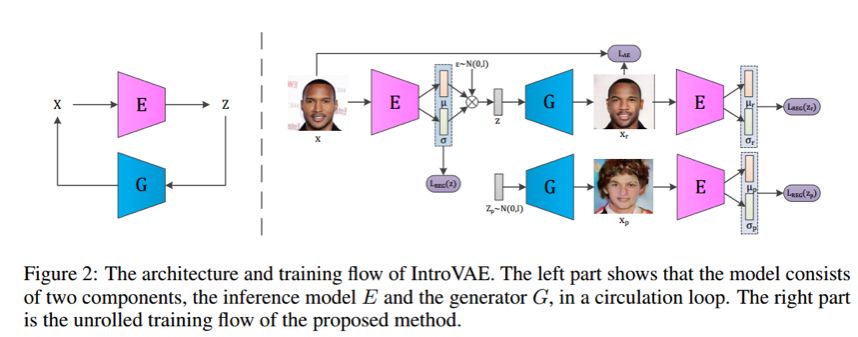

自省变分自编码器模型基于传统的变分自编码器模型。在变分自编码器模型中,优化函数包括两个方面,一个重建损失函数用于重构输入样本,一个KL散度函数用于对隐变量添加先验约束。借鉴生成对抗网络,我们将对抗引入了变分自编码器的训练中。在训练编码器的时候,使得真实样本的隐变量接近先验分布,生成样本的隐变量偏离先验分布;在训练生成器的时候,则要生成样本的隐变量接近先验分布。我们保留了重建损失函数,在训练过程中编码器和生成器既要对抗又要协作。

对于真实样本来说,我们方法的训练目标跟传统变分自编码器完全一致,这极大的稳定了模型训练。对于生成样本来说,对抗的引入则提高了样本的质量,克服了变分自编码器生成结果模糊的问题。实验表明,我们的方法能够稳定合成高分辨率真实图像,比如1024x1024大小的人脸图像,256x256大小的卧室、教堂、狗等自然图像。不仅在图像质量上,而且在量化指标上我们也取得了无条件生成(unconditionalgeneration)上当前最好的结果。

LSUNBEDROOM上训练,生成的256x256卧室图像

LSUNCHURCHOUTDOOR上训练,生成的256x256教堂图像

ImageNet上训练,生成的256x256狗图像

Take Home Message

我们方法目前仍然有一些局限性,主要是对于高分辨率图像训练时间仍然非常漫长(比如1024x1024的图像需要3周左右的时间)和对于自然图像来说生成结果仍然有继续提升的空间。另外,在条件生成领域,谷歌最近提出的BigGAN模型可以达到非常的量化指标。但是,除了使用了很多之前文章的trick外,BigGAN的性能提升主要依赖于大的batch-size和模型参数,训练平台TPU当前对大多数研究者来说仍然不现实。在大多数研究者计算资源有限的情况下,设计更加简单更加容易训练的模型仍然是一个值得继续研究的方向。

Reference

[1] Van Oord, Aaron, Kalchbrenner, Nal, andKavukcuoglu, Koray. Pixel recurrent neural networks. In ICML, pp.1747–1756, 2016.

[2] Denton, Emily L, Chintala, Soumith, Fergus, Rob, et al. Deep generativeimage models using a laplacian pyramid of adversarial networks. In NIPS,pp. 1486–1494, 2015.

[3] Dinh, Laurent, Sohl-Dickstein, Jascha,and Bengio, Samy. Density estimation using real NVP. In ICLR,2017.

[4] Goodfellow, Ian, Pouget-Abadie, Jean,Mirza, Mehdi, Xu, Bing, Warde-Farley, David, Ozair, Sherjil,

Courville, Aaron, and Bengio, Yoshua. Generative adversarial nets. In NIPS,pp. 2672–2680, 2014.

[5] Karras, Tero, Aila, Timo, Laine, Samuli, and Lehtinen, Jaakko. Progressivegrowing of GANs for improved quality, stability, and variation. In ICLR,2018.

[6] Kingma, Diederik P and Welling, Max.Auto-encoding variational bayes. In ICLR, 2014.

[7] Li, Yujia, Swersky, Kevin, and Zemel, Rich. Generative moment matchingnetworks. In ICML, pp.1718–1727, 2015.

[8] Wang, Ting-Chun, Liu, Ming-Yu, Zhu, Jun-Yan, Tao, Andrew, Kautz, Jan, andCatanzaro, Bryan. Highresolution image synthesis and semantic manipulation withconditional GANs. In CVPR, 2018.

[9] Zhang, Zizhao, Xie, Yuanpu, and Yang, Lin. Photographic text-to-image synthesiswith a hierarchicallynested adversarial network. arXiv preprintarXiv:1802.09178, 2018.

[10] Kingma D P, Dhariwal P. Glow:Generative flow with invertible 1x1 convolutions[J]. arXiv preprintarXiv:1807.03039, 2018.

[11] Brock A, Donahue J, Simonyan K. LargeScale GAN Training for High Fidelity Natural Image Synthesis[J]. arXiv preprintarXiv:1809.11096, 2018.

[12] Le Tan D K, Le H, Hoang T, et al.DeepVQ: A Deep Network Architecture for Vector Quantization. In CVPR, 2018:2579-2582.

[13] J. Lazarow, L. Jin, and Z. Tu,“Introspective Neural Networks for Generative Modeling,” In ICCV, 2017, pp.2793–2802.

[14] Bordes F, Honari S, Vincent P.Learning to Generate Samples from Noise through Infusion Training. In ICLR,2017.

SFFAI讲者招募

为了满足人工智能不同领域研究者相互交流、彼此启发的需求,我们发起了SFFAI这个公益活动。SFFAI每周举行一期线下活动,邀请一线科研人员分享、讨论人工智能各个领域的前沿思想和最新成果,使专注于各个细分领域的研究者开拓视野、触类旁通。

SFFAI目前主要关注机器学习、计算机视觉、自然语言处理等各个人工智能垂直领域及交叉领域的前沿进展,将对线下讨论的内容进行线上传播,使后来者少踩坑,也为讲者塑造个人影响力。

SFFAI还将构建人工智能领域的知识树(AI Knowledge Tree),通过汇总各位参与者贡献的领域知识,沉淀线下分享的前沿精华,使AI Knowledge Tree枝繁叶茂,为人工智能社区做出贡献。

这项意义非凡的社区工作正在稳步向前,衷心期待和感谢您的支持与奉献!

有意加入者请与我们联系:wangxl@mustedu.cn

历史文章推荐: