PK朱广权的手语数字人,现在要到医院银行上岗了

明敏 发自 凹非寺

量子位 | 公众号 QbitAI

还记得冬奥会期间和朱广权battle的AI手语主播吗?

现在,这样的手语数字人不仅要在小荧屏上工作,还能到火车站、银行、医院这些公共场所上岗了。

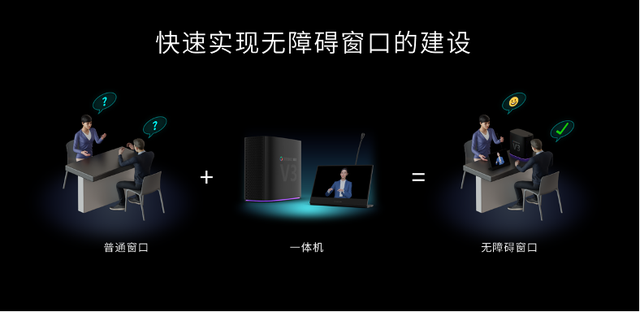

喏,通过这样一台看似普通的机器,AI手语数字人就能实时将语音或文字转化为手语,让听障人士与窗口工作人员无障碍沟通,词准率在96%以上。

这就是百度智能云曦灵刚刚推出的AI手语一体机,它能够直接部署在各种服务窗口,成为工作人员的实时翻译官。

其背后支持平台——AI手语平台也同步发布,它能进行实时手语直播,还可搭载在各类 APP、网站、小程序中,生成手语合成视频。

在发布会现场,我就感受了一下这位AI手语主播的功底:

这手速,amazing~

线下虚拟手语翻译官来了

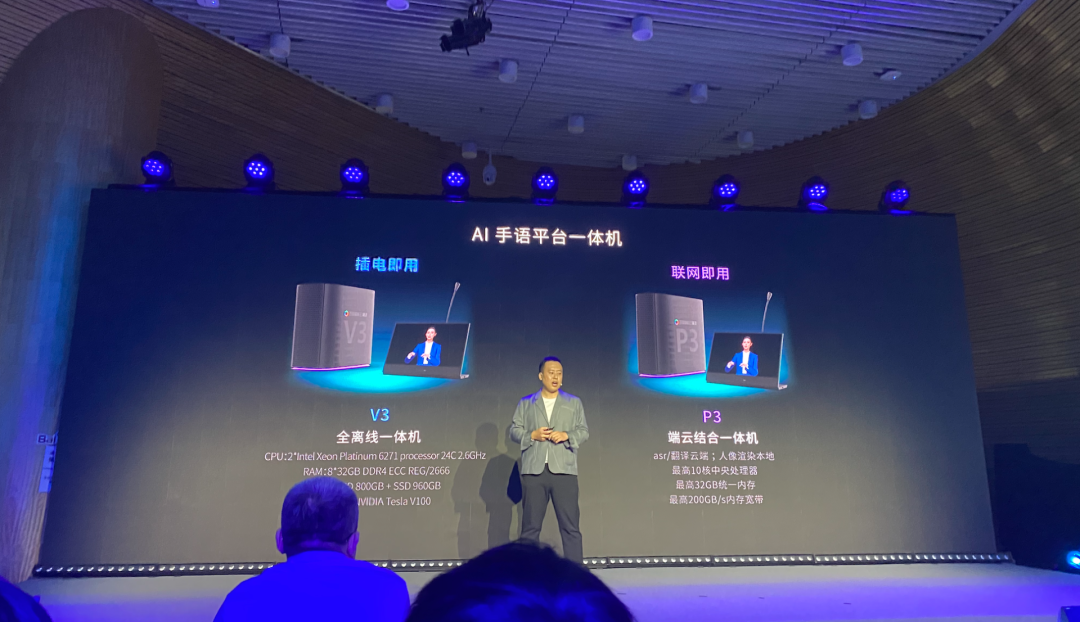

此次推出的AI手语一体机,共有两个型号:V3和P3。

其中,全离线一体机 V3型号支持插电即用,可实现秒级部署;

端云结合一体机 P3型号联网可用,能实现分钟级部署。

也就是说,这个一体机能够充当工作人员的翻译官,实时把信息传递给前来办理业务的听障人士。

在发布会现场,百度还透露,不只是单向将语音转化为文本,在如何将手语转化为文本或语音的问题上,百度也在积极开展研究。

而能够搞定银行、医院、火车站等场景下的手语翻译,核心技术来自百度智能云曦灵的AI手语平台。

它主要包含以下4方面功能:

视频手语合成、直播手语合成、文本转手语、语音转手语。

以直播情况来举例,平台可以直接接入直播地址,读取语音后转换为手语。

当然也能读取语音进行翻译,类似于微信语音输入后转文字。

这背后的流程主要可以分为3步:

首先,要通过语音识别引擎将输入的语音或视频转换为汉语文本;

然后,翻译引擎要将其进一步转换为手语码;

最后根据手语码,数字人动作融合算法来完成最后的视频合成。

整个过程中还需要保障语音识别清晰度、手语翻译准确度及精炼度、手语动作流畅度。

识别清晰度方面,百度使用了SMLTA语音识别算法模型。

该模型是一个流式多级的截断注意力模型,它使用CTC(一种语音识别算法)的尖峰信息对连续语音流进行截断,然后在每一个截断的语音小段上进行当前建模单元的注意力建模。

也就是把原来的语音中整句Attention建模,变成了局部语音小段的Attention的建模。

最终实现了在手机端近场语音识别率98%以上的效果。

百度表示,基于百度自研的深度学习算法,还可针对诸如旅游、医院、司法等不同领域的词准率进行针对性训练,词准率可达96%。

翻译准确度及精炼度上,百度研发了首个基于神经网络的精炼度可控手语翻译模型。

这是一个能将中文文本准确翻译成手语符号的模型,并且可以在保证手势准确度的情况下,进一步缩短译文长度,让文本信息能够及时转化为手语。

为此,百度还在专业手语专家指导下建设了大规模自然手语翻译语料库,使得模型可以从真实数据中学习手语翻译知识,从而生成符合听障人群习惯的自然手语。

最后则是手语流畅度方面。

AI手语平台通过“动作融合算法”,基于《国家通用手语词典》规范精修近11000多个手语动作,让每一个动作都更接近真人手语表达。

再配合4D扫描技术训练,最终AI手语数字人口型生成准确度可达98.5%。

百度介绍,只需几小时的部署,AI手语平台即可在视频、直播、文本、语音等应用场景中添加手语翻译,可搭载在各类 APP、网站、小程序中。

让特殊人群“更加平等享受资讯”

目前我国听力语言残疾人达到2780万以上,而专业的手语翻译不足1万人,巨大的需求缺口亟待补足。

尤其像在医院、车站等场景下,需要工作人员和听障人士无障碍实时沟通、准确传递信息。

或许有人想问,那用文字不就行了吗?

实际上,由于种种现实因素的制约,比起文字,手语对听障人士而言更加亲切,也能更快速地传递信息。

手语翻译对于特殊人群而言,也是一个“更加平等享受资讯”的窗口。

发布会上,百度集团副总裁吴甜表示:

人工智能呈现融合创新和降低门槛的新特点,综合运用多技术的数字人带来新体验,AI加持使数字人制作和运营成本与门槛降低,AI手语平台将让更多听障人士享受科技带来的便利。

— 完 —

本文系网易新闻•网易号特色内容激励计划签约账号【量子位】原创内容,未经账号授权,禁止随意转载。

直播报名 | AI+边缘计算赋能传统企业

在信息化浪潮下,传统企业如何综合利用人工智能、边缘计算等技术勇立潮头,智慧发展?

3月8日19:30,「量子位·视点」CEO/CTO系列分享活动邀请了江行智能CTO樊小毅博士,将围绕AI+边缘计算如何助力碳中和目标、典型应用和未来展望等内容,直播分享个人见解。扫码可报名:

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

一键三连「分享」「点赞」和「在看」

科技前沿进展日日相见 ~