《深度学习在增强型无线通信系统设计中的应用》贝尔实验室 - 里昂大学2022最新168页博士论文

摘要

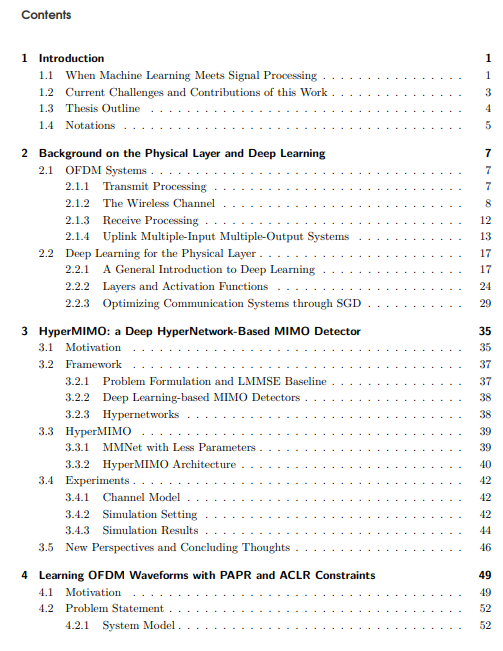

1 简介

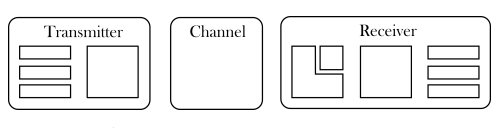

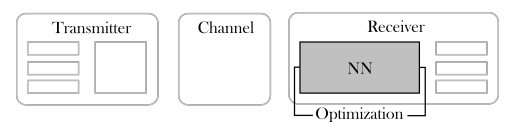

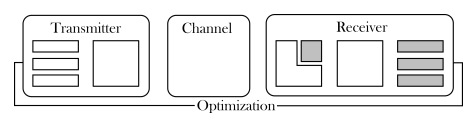

1.1 当机器学习遇上信号处理

1.2 当前的挑战和这项工作的贡献

1.3 论文大纲

1.4 符号

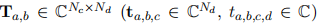

表示将张量

表示将张量

沿前两个(三个、四个)维度切片形成的矩阵(向量、标量)。符号T(k)表示手头的数量只考虑第k个用户,而v-a对应的是去除第a个元素的向量v。||M||F表示M的Frobenius规范。Card(S)表示一个集合S中的元素数,vec(-)是矢量化操作符,和分别是元素的乘积和除法。

沿前两个(三个、四个)维度切片形成的矩阵(向量、标量)。符号T(k)表示手头的数量只考虑第k个用户,而v-a对应的是去除第a个元素的向量v。||M||F表示M的Frobenius规范。Card(S)表示一个集合S中的元素数,vec(-)是矢量化操作符,和分别是元素的乘积和除法。

分别表示转置、共轭转置和元素间共轭算子。I(x; y)和P(x, y)分别代表x和y的相互信息和联合条件概率。IN是N×N的身份矩阵,1N×M是N×M的矩阵,其中所有元素都设置为1。最后,虚数单位为j,这样

分别表示转置、共轭转置和元素间共轭算子。I(x; y)和P(x, y)分别代表x和y的相互信息和联合条件概率。IN是N×N的身份矩阵,1N×M是N×M的矩阵,其中所有元素都设置为1。最后,虚数单位为j,这样

。

。

专知便捷查看

便捷下载,请关注专知人工智能公众号(点击上方蓝色专知关注)

后台回复“DLEWC” 就可以获取《《深度学习在增强型无线通信系统设计中的应用》贝尔实验室 - 里昂大学2022最新168页博士论文》专知下载链接

登录查看更多