摘要

全球对学习第二语言(L2),特别是英语的需求不断增长,导致人们对自动口语评估产生了浓厚的兴趣,无论是用于计算机辅助语言学习(CALL)工具,还是用于对正式资格认证的候选人进行评分。本论文介绍了对非母语英语自发语音的自动评估的研究,以期能够向学习者提供有意义的反馈。自动口语评估的挑战之一是,除了通常提供的整体分数外,还要对考生的口语能力的特定方面或观点给予反馈。另一个挑战是在单词或语篇层面上检测发音和其他类型的错误,并将它们以有用的方式反馈给学习者。

通常很难获得准确的训练数据,因为不同的观点有不同的分数,而且,由于考官通常被训练为给出整体的分数,单一观点的分数可能存在一致性问题。相反,整体分数可用于各种标准评估任务,如Linguaskill。因此,我们进行了一项调查,研究是否可以从只使用整体分数训练的系统中获得与说话人能力的特定观点相关的评估分数。

端到端的神经系统被设计成具有调整到单一观点的结构和输入形式,特别是发音、节奏、语调和文字的每一个观点。通过在大量的候选数据上训练每个系统,个人观点的信息应该可以被提取。对每个系统的预测之间的关系进行评估,以检查它们是否实际上提取了关于说话人的不同信息。研究了三种结合系统来预测整体分数的方法,即对它们的预测进行平均化,对它们的中间表征进行串联和处理。结合起来的评分器相互之间以及与基线方法进行了比较。

当所涉及的语音是自发的,特别是考虑到人类对发音错误的注释不一致所带来的挑战,错误检测和错误倾向诊断的任务变得特别具有挑战性。我们提出了一种解决这些问题的方法,即区分词汇错误和口音错误,前者是指说话者不知道某个特定单词是如何发音的,后者是指候选人的讲话表现出一致的电话替换、删除和插入的模式。我们分析了三个由多个母语国家的人发表的非母语英语语音的注释语料,调查了人类注释的一致性,并提出了一种检测个别口音和词汇错误以及在说话人层面诊断口音错误倾向的方法。

第一章 简介

全世界有超过10亿人在学习英语[99],每年有数百万人参加评估。不断增长的需求导致合格的教育者和评估者日益短缺,再加上有效的在线平台越来越多,导致了计算机辅助语言学习(CALL)市场的快速增长[263]。有效的CALL系统的核心是能够自动评估用户的语言能力并提供有用的反馈。因此,毫不奇怪,人们对开发语音处理和机器学习技术有相当大的兴趣,用它来改进工具,以及使昂贵和耗时的口语能力评估过程自动化[100]。

这项工作的范围是研究新的统计技术,根据非英语母语者的语音录音自动评估他们的能力,并提供有用的反馈,以帮助他们提高能力。由于采取的是统计学方法,在本论文中,如果听众会认为说话者是熟练的,那么他们就会被认为是熟练的。因此,一个系统被认为越是接近人类注释者的反馈,就越能评估其熟练程度,而人类注释者本身已经证明了与自己和其他听众的一致性。基于录音的熟练度反馈被认为是更有用的,因为输入的语音越能代表说话者在正常交流中会产生的语音,所以自发的语音比阅读的语音更受欢迎。所研究的主要反馈形式是整体的熟练程度等级,针对熟练程度的特定观点(如发音、节奏等方面)的等级,以及对发音错误类型和位置的反馈。

鉴于输入音频和诸如熟练程度这样的概念之间的精确关系非常复杂、非线性,而且在很大程度上是未知的,调查主要集中在应用深度学习技术来实现基于人类注释数据训练的表征性学习(见第四章的讨论)。最后,这项工作主要集中在语音比书写更特殊的能力方面,即发音和音调。

对口语能力进行统计自动评估的主要挑战之一是公开可用的数据数量有限且变化较大。几乎所有公开的数据都是基于读过的语音,而读过的语音已经被证明与更能代表正常对话的自发语音有很大的不同(见第二章介绍中的讨论和第3.6节)。现有的对发音和其他类型的错误进行词标注释的数据源,其注释者之间的一致性很低(见§3.6和§7.3的讨论)。

整体评分数据的语料库确实存在,但由于它们主要来自于考试和/或语言教学的背景,几乎不可能公开这些数据。在本研究中,我们有可能从剑桥评估公司获得这样一个非公开的跨L1注释数据的语料库。正如这类语料库的主要情况一样,说话者是被整体评分的,而不是根据个人的熟练程度来评分的(见第2.1节的讨论),而且操作评分者之间的评论员之间的一致性相对较低。

鉴于上述限制,文献中的错误检测方法主要集中在已读语音而非自发语音上,在以向学习者提供有用反馈的方式区分不同类型的错误方面能力有限,并受制于训练和/或评估数据的潜在不一致性,其原因没有得到充分探讨(见第三章的讨论)。

对说话人进行整体评分的方法(见第二章的讨论)也同样集中在阅读语音而不是自发语音上。单视角评分受限于单视角人类注释的可用性,由于缺乏普遍接受的单视角评分标准,这些注释存在着不一致的问题,并且一直专注于基于手工制作的特征的方法,这些特征是可解释的,但充满了假设,提取信息的方式不能针对不同的任务进行调整,并粗略地抛弃了潜在的有用信息。整体分级的方法是使用与不同的单一视图相对应的手工制作的特征或端到端方法,这些方法可以灵活地调整到个别任务,但缺乏可解释性,并且难以推广到与它们所训练的不同的数据。

为了应对上述挑战,本论文在两个主要领域做出了贡献。首先,在能力分级领域(见第5章和第6章),通过利用和设计包含领域知识的端到端网络,对提取的信息进行约束,使其只表征所需的观点,从而引入了一种新的方法,对说话人的单观点进行分级。这种方法结合了手工制作的特征和黑盒端到端方法的优点。这些系统还被设计成可以在整体等级上进行训练,但产生单一视图的预测,从而解决了数据可用性和一致性问题。基于这种方法的系统被介绍给发音、节奏和音调的观点。进行了新的研究,将这些系统的性能与其他方法进行了比较,并研究了它们在对整体成绩进行训练时预测的单视图成绩是否具有预期的单视图能力的特性。还提出了一种基于结合这些端到端单视图系统的整体评分的新方法,并与基线进行比较。

在发音错误检测领域(见第7章),首先对人类词级注释的质量以及错误注释与语音转录数据集中的注释不足现象进行了新的研究。在将发音错误分为词汇错误和不同类型的口音错误的基础上,提出了一种新的方法来检测自发语音中的发音错误,并对文献中常见的读音方法进行了修改(扩展识别方法)。还从文献中收集了大量L1的英语常见口音错误,以建立一个框架,可以预测英语中任何单词的候选错误发音的详尽列表。这个新颖的系统可以检测出某一特定单词出现特定类型错误的概率,并在单词层面产生单独的词汇错误反馈,但在语篇或说话人层面产生口音错误反馈。对该系统的性能以及检测到的发音错误的数量和总体熟练程度等级之间的关系进行了新的研究。

在做出上述贡献时,本论文的工作具体回答了九个主要的研究问题(见第5、6和7章)。

-

在对非母语人士的熟练程度进行评分的任务中,深度学习方法是否比其他机器学习方法(特别是高斯过程)具有更高的准确性和通用性?

-

单视图端到端神经评分器(即端到端神经系统受其输入和结构的限制,以特定的视图为基础进行评分)在单视图能力评分的任务中,能否提供比基于手工制作的特征的方法更好的准确性和通用性?

-

单视图端到端神经评分器是否可以解释其分配等级的原因?

-

单一视图的端到端神经评分器在接受整体评分训练时,是否仍能有效地根据这些视图进行评分?

-

基于多个单视图端到端神经评分器组合的系统,在整体评分任务中的准确性是否优于基于串联单视图手工制作的特征和基于整体评分的端到端训练的神经系统?

-

语音转录的方法(要求注释者详尽地转录说话者的每个单词的发音方式)是否比发音错误注释的方法(要求注释者标记录音中哪些单词含有发音错误)更能捕捉到非母语者在自发讲话中的发音错误?

-

口音错误(由于说话者在其讲话中系统地插入、删除或替换电话而造成的错误)与词汇错误(由于说话者不知道基于其拼写的特定词汇的正确发音而造成的错误)是否有区别,是否能够被单独检测出来?

-

一个基于从格子路径可能性中计算出的词级概率的系统,通过对具有多种候选发音的自发非母语语料的强制对齐,可以用来准确地检测出说话人的个别词汇错误,以及说话人犯不同类型口音错误的总体趋势吗?

-

错误检测系统检测到的发音错误的数量是否可以预测其整体的熟练程度等级?

本论文报告的原创性工作延续了Kyriakopoulos等人(工程硕士毕业报告)[151]中关于使用基于电话距离的新型特征提取方式进行两阶段发音评估的工作(在§2.3.2中被引为以前的工作)。本论文的部分原创性工作已经在研究过程中撰写的一些出版物中报道,其中大部分在本论文的相应章节中被引用参考[147, 152, 277, 153, 154]。

本论文所报告的工作属于剑桥大学ALTA(自动语言教学和评估)研究所工程系分支的框架,其目标是开发基于自发和非自发口语的自动评估和向非英语母语者提供反馈的技术。数据和资金由剑桥大学的剑桥评估公司提供。

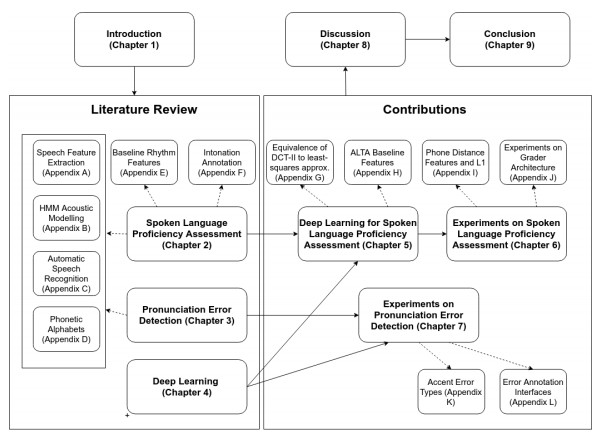

本论文的结构如图1.1所示。第二章和第三章分别回顾了关于口语分级和发音错误检测的文献。第四章回顾了更广泛的文献中的深度学习技术,这些技术将被应用到本论文的自动评估领域。利用这些技术,第5章提出了一个新颖的单视角和整体评分的框架,第6章报告了在此基础上进行的实验。最后,第七章介绍了在发音错误检测领域进行的新颖工作。第八章讨论了第六章和第七章结果的影响和局限性,以及未来工作的途径,第九章总结了与上述研究问题相关的结论。

图1.1 本论文的结构