【AAAI2021】通过知识到文本转换来测试知识增强的常识性问题回答

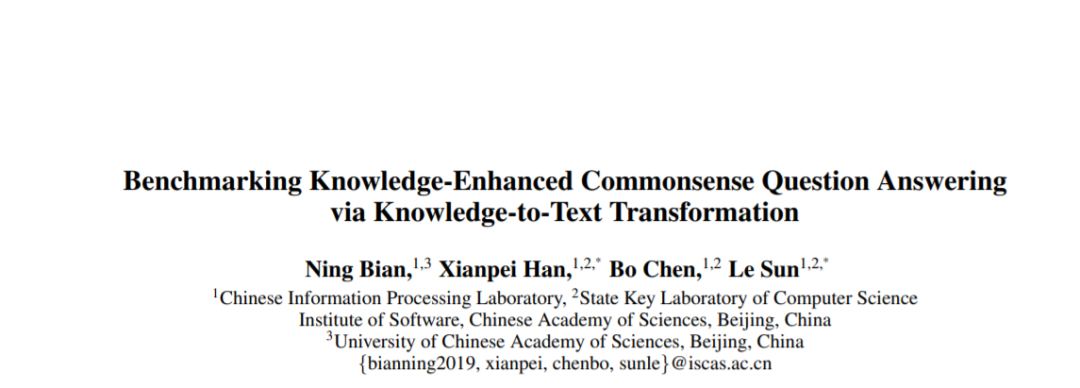

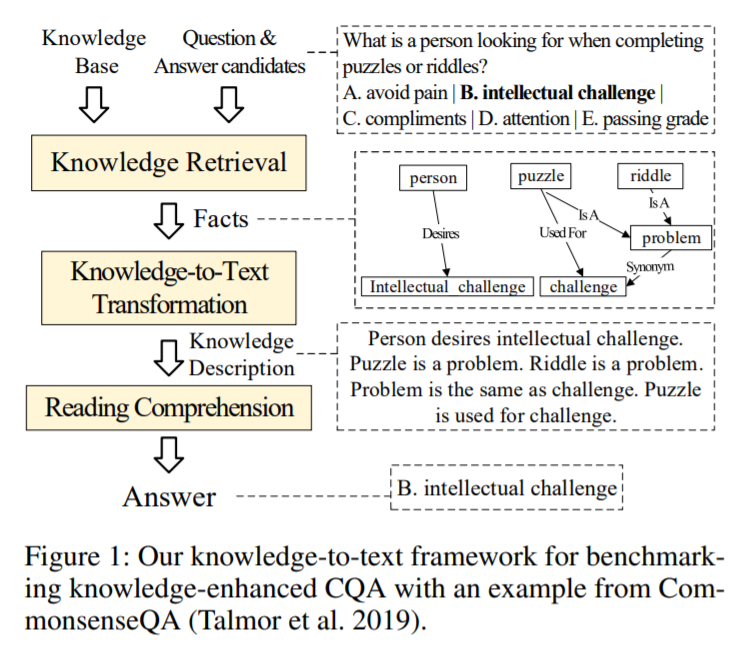

本文提出了一个简洁而有效的基于知识到文本转换的常识问答模型框架,在多个标准的常识问答数据集上进行了深入的测试和分析,并为知识增强的常识问答提供了高性能的基准模型。实验显示:①基于知识到文本转换的常识问答模型是有效且鲁棒的;②融合外部知识对于常识问答任务依然有较大潜力;③目前的常识问答模型还远不能充分发挥知识的潜力——与使用标准知识解释的模型相比,现有模型均有较大性能差距。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“KCQA” 可以获取《【AAAI2021】通过知识到文本转换来测试知识增强的常识性问题回答》专知下载链接索引

登录查看更多

相关内容

Arxiv

4+阅读 · 2020年2月27日

Arxiv

4+阅读 · 2018年3月16日