有些公司成立之初即引起轰动,有些公司的首次亮相却令人大跌眼镜,Genderify 属于后者。

![]()

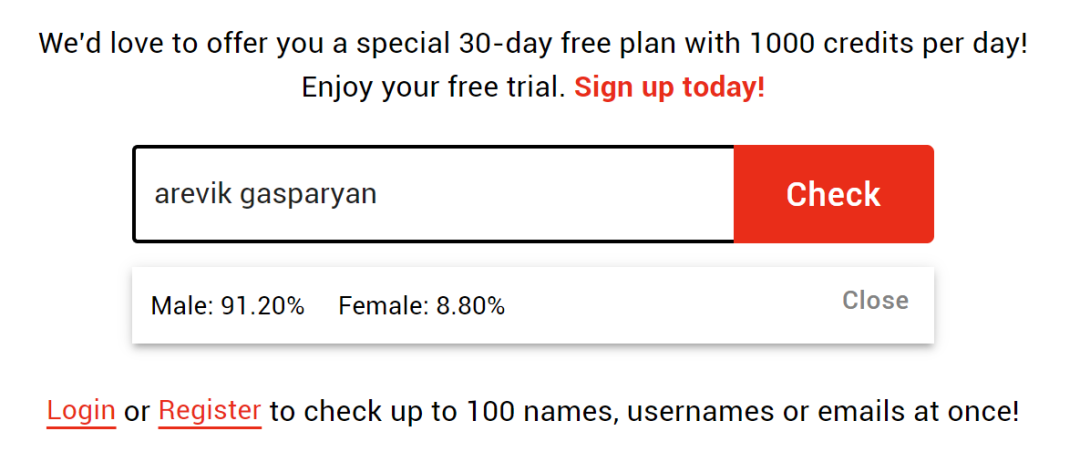

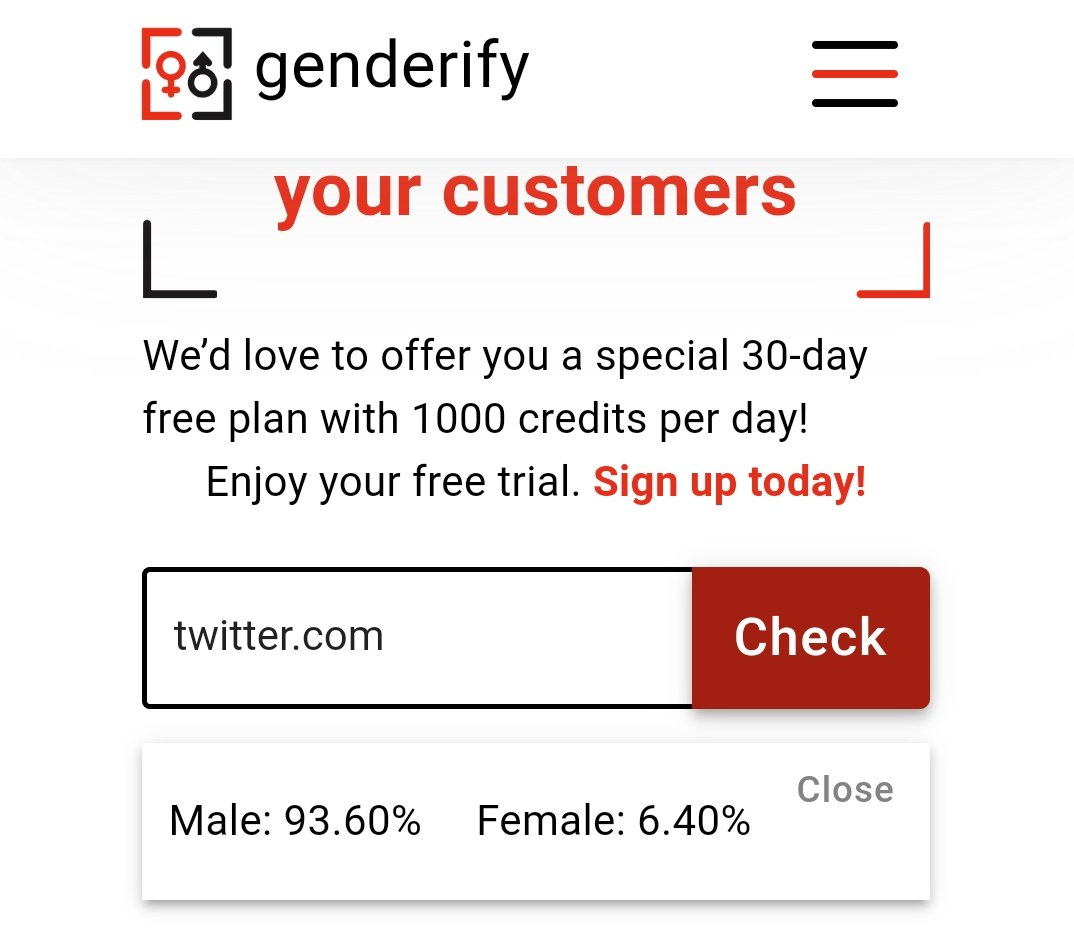

最近,一款名为「Genderify」的 AI 性别识别平台引起了大家的注意。这款产品宣称使用一种简单、快速、独特的 AI 技术,让用户直接输入名称或者电子邮件地址,即可获取性别判断结果。

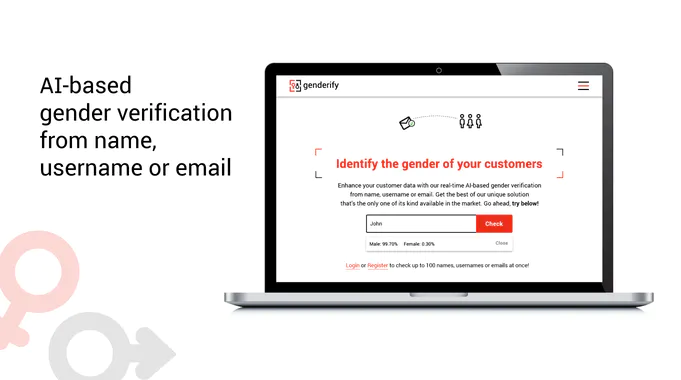

![]()

开发人员称,这款产品的目标在于帮助人们更好地了解性别特定(GenderSpecific)方面的需求。该技术也可轻松集成到现有系统内,例如注册表单、CRM 和 ERM 等。

因此,在这款产品上线的第一时间,很多用户就率先冲了上去,想要试用这个新功能。但没有想到,就这么猝不及防地翻车了。

如果在 Genderify 中输入 Meghan Smith,评估结果为「男性 39.6%,女性 60.4%」;将名称更改为「Dr. Meghan Smith」,结果变为「男性 75.9%,女性 24.10%」。

「Meghan Smith」是女性,但「Dr. Meghan Smith」就变成了男性?同时,以「Dr」为开头的其他名字也会产生向男性倾斜的相似结果。

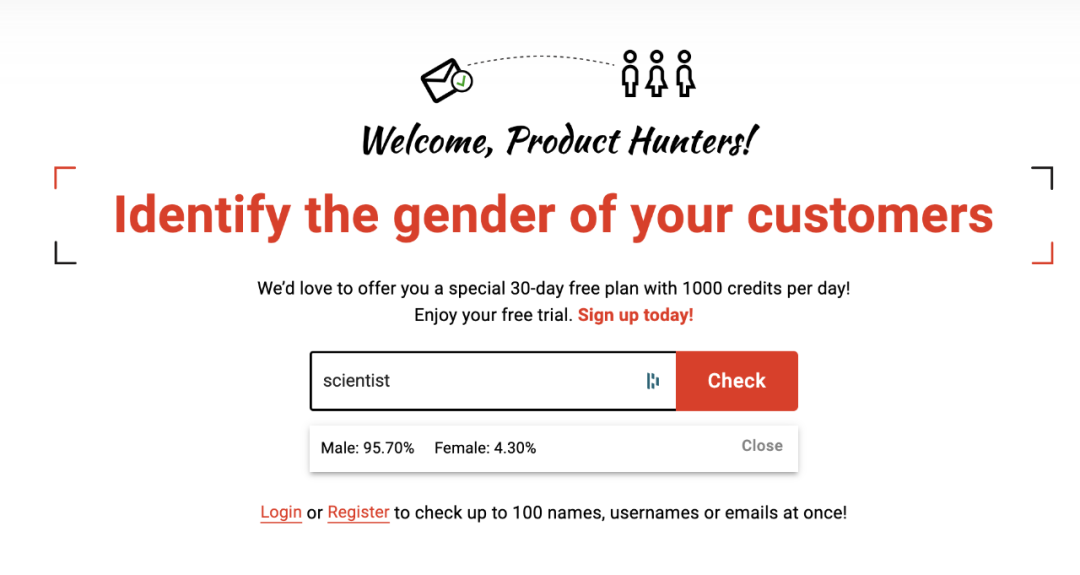

![]()

输入「scientist」,评估为男性的结果概率高达 95.7%:

![]()

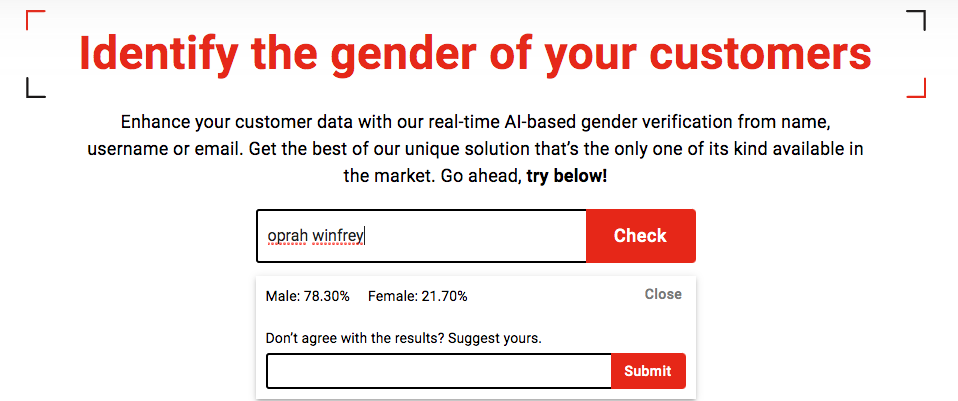

有人输入 Oprah,结果显示 78.3% 是男性,但人们最熟悉的「Oprah」是一名女性:脱口秀主持人 Oprah Winfrey。

![]()

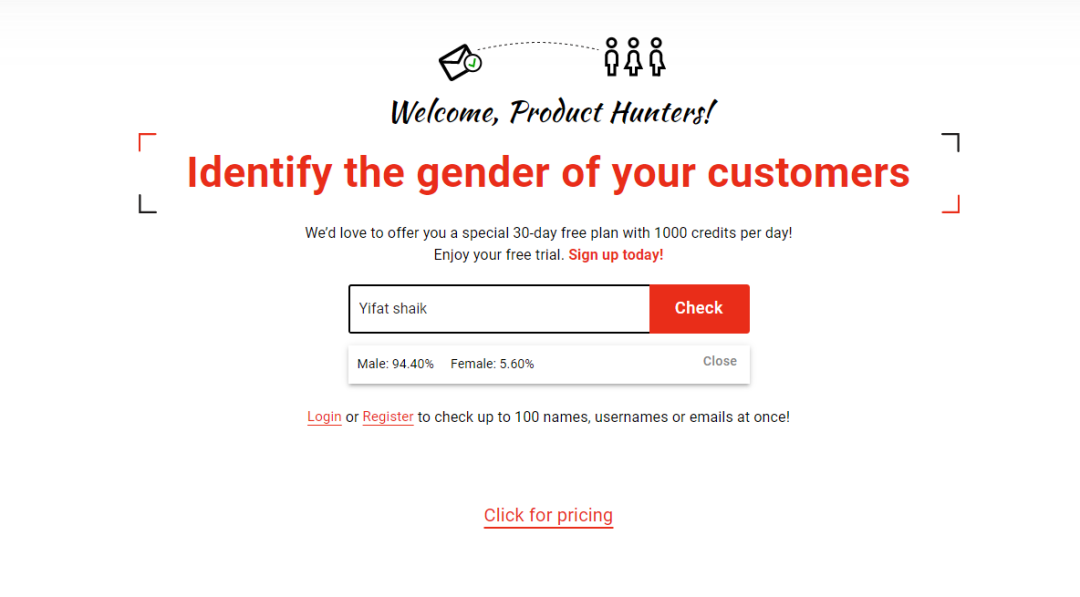

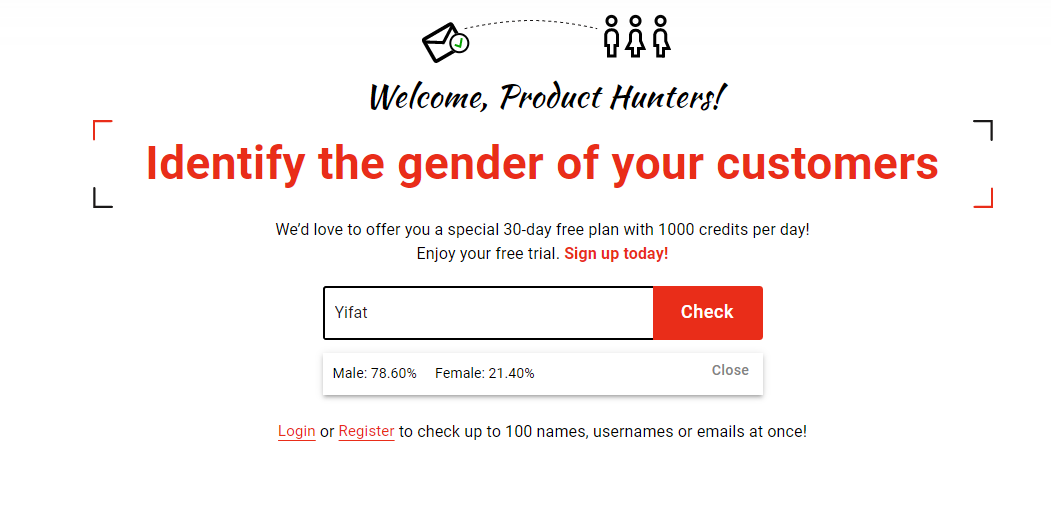

如果先是输入「Yifat shalk」,结果会显示 94.4% 为男性,再换成只输入「Yifat」的话,这个比例就降到了 78.6%。

![]()

![]()

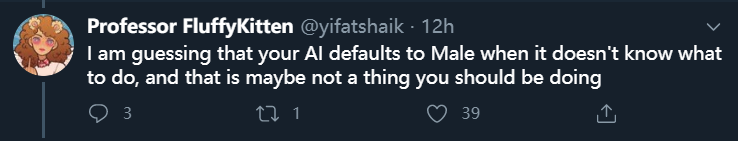

这位用户表示:「我感觉是,AI 在不知道该如何判断的时候,就会默认为男性。」这样的判断方法,约等于「不会的选择题就选 C」。

![]()

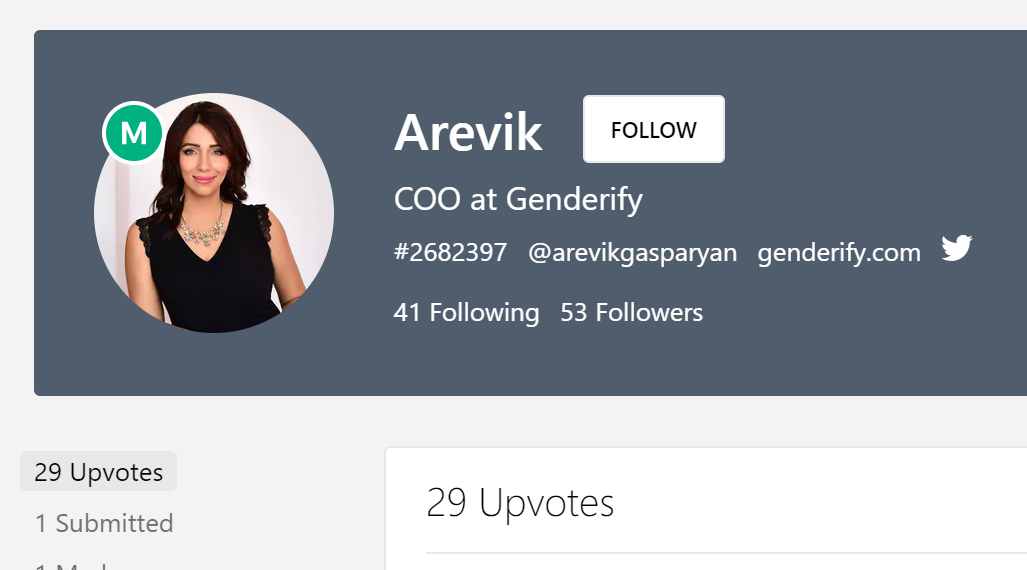

有人将 Genderify 首席运营官的名字填进检索框,结果依旧令人尴尬:无论怎么看,Arevik 都不会是一名男性,即使评估结果的比例高达91.2%。

![]()

![]()

![]()

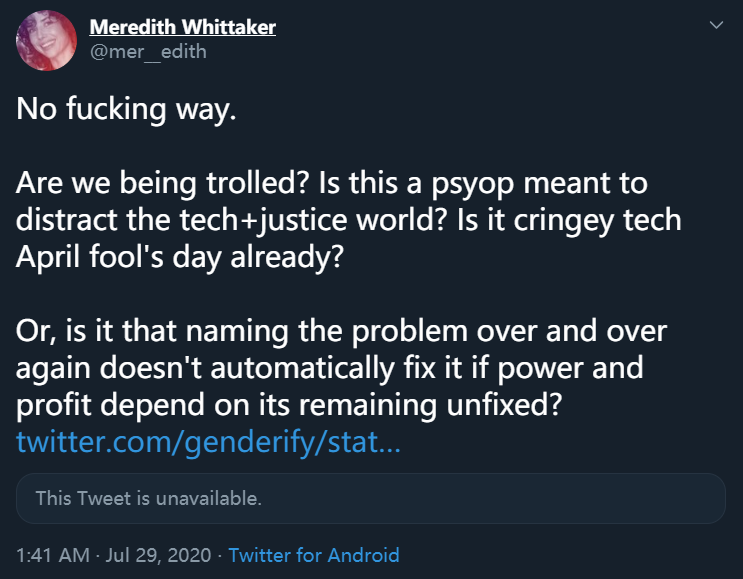

人工智能系统中的性别偏见并不是一个新鲜的话题,至少很多人都了解它的存在。但 Genderify 判断结果的离谱程度还是让业内震惊了。

人工智能社会影响研究机构、纽约大学 AI Now 的联合创始人 Meredith Whittaker 在推特上呼吁:「我们都被异化了吗?」

![]()

这种带有严重偏见的 AI 系统存在许多隐患,比如将该服务集成到医疗对话机器人中之后,算法对于用户性别判断的失误可能会导致完全偏离的医疗建议。尽管该产品的创造者 Arevik Gasparyan 只是将其定义为「助力营销数据分析」方面的工具。

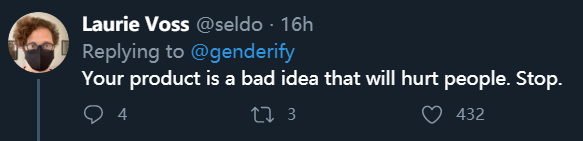

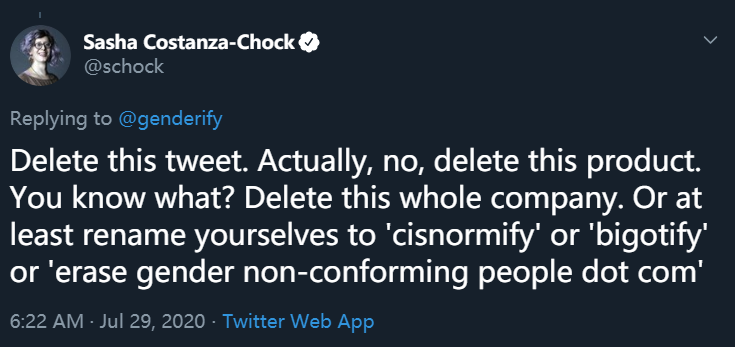

所以上线不久后,Genderify 就引发了社交媒体平台的强烈抗议。

![]()

![]()

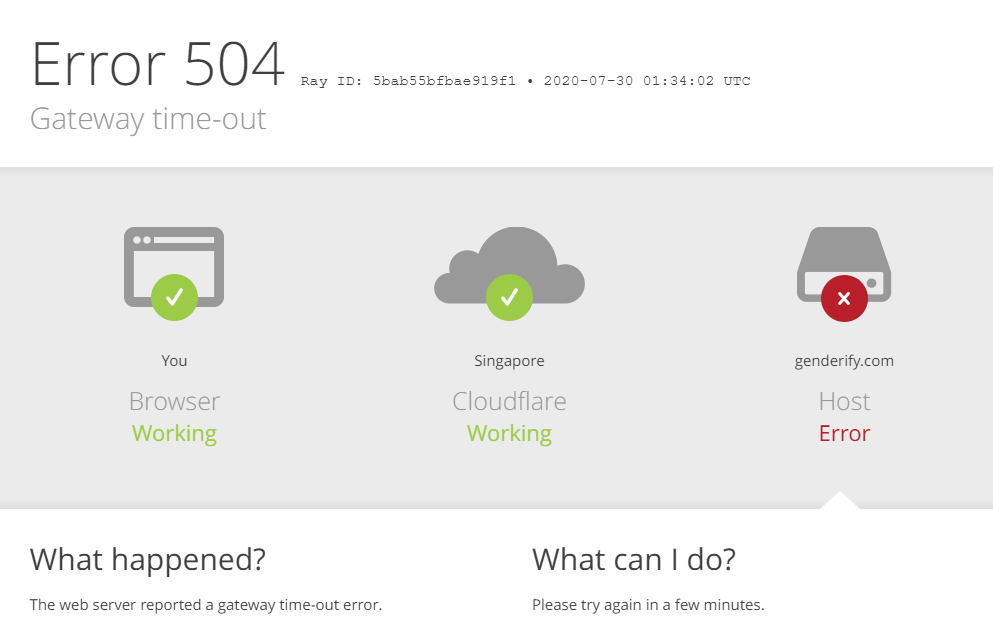

最终,Genderify 不得不选择关闭了网站,目前已无法访问。

![]()

![]()

上线 24 小时就下架,Genderify 的产品生命周期似乎也过于短暂了。

https://twitter.com/genderify/status/1282688200675401730

https://www.theverge.com/2020/7/29/21346310/ai-service-gender-verification-identification-genderify

Amazon SageMaker 是一项完全托管的服务,可以帮助开发人员和数据科学家快速构建、训练和部署机器学习 模型。SageMaker完全消除了机器学习过程中每个步骤的繁重工作,让开发高质量模型变得更加轻松。

现在,企业开发者可以免费领取1000元服务抵扣券,轻松上手Amazon SageMaker,快速体验5个人工智能应用实例。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com