顶风作案:这款使用Deepfake技术的APP,上线几小时即告下架

机器之心报道

机器之心编辑部

AI 算法「Deepfake」可以生成各种有关人物的逼真图像和视频,近几个月来让众多明星和政客遭殃,甚至已经让美国众议员着手制定监管法律。然而这些并没有阻止人们「作死」的步伐,最近的一款「人工智能 X 光 APP」又让 Deepfake 被推上了风口浪尖。

据 Motherboard 等美国媒体报道,一名程序员本周开发出了一款名为 DeepNude 的应用软件。它的功能说来简单:输入一张女性照片,该 APP 即可借助神经网络自动「脱掉」女性身上的衣服,从而展现其裸体。

DeepNude 只能处理女性照片,并且号称原图裸露的皮肤越多,处理效果就越好;而上传男性照片,最后得出的照片还是被替换成女性身体。这款 APP 基于加州大学伯克利分校研究者开发的开源算法 pix2pix,并使用 1 万张女性裸体照片进行训练。

本周四,DeepNude 已在官网上线,用户可在线上处理照片,同时可下载的 Windows 和 Linux 应用也在 6 月 23 日推出。这款 APP 有免费版和 50 美元付费版。使用免费版获得的图片会出现较大水印,付费版虽然不出现水印,但也会在图片左上角加上「FAKE」标签。

这款 APP 处理后的图像如美国众议员提出的《DEEPFAKES》法案中强制的那样,打上了明显的「FAKE」标签,即便如此也显得超出了人们的底线。

DeepNude 创建者表示其开发此款 APP 出于「好奇心」和「有意思」,但也希望从中获得经济回报。

此前,名为「deepfakes」的 AI 换脸技术就曾在网上引发热议,一名 Reddit 用户利用 AI 技术将明星脸「嫁接到」成人电影女主身上制作「假」色情视频,因而遭到众多平台的强烈抵制。

而 DeepNude 主要用于处理女性照片,因而在操作上更加简单,处理速度也更快。但是,如此侵犯女性隐私的 APP 会不会像「deepfakes」一样遭到抵制呢?

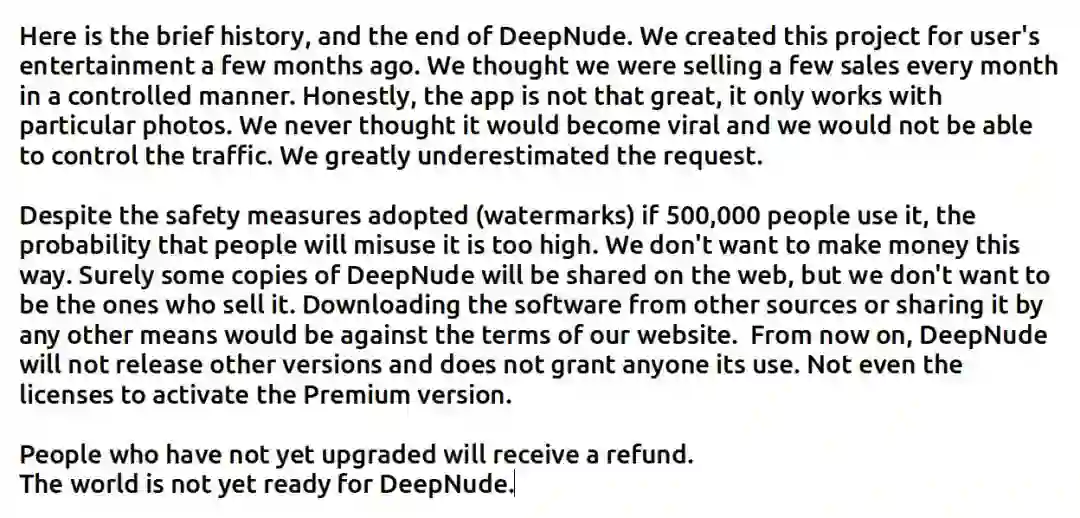

果不其然,与「deepfakes」的命运一样,在上线仅几小时后,这款利用 AI 创建女性裸体的 deepfake 应用软件就宣布下架了。但它下架的理由却并不是遭到大量抵制,而是因为流量过高!Excuse me??[手动狗头]

DeepNude 的创建团队在推特上表示,他们「大大低估了人们对该项目的兴趣」,人们滥用这款 APP 的可能性也太大了。

因此,他们宣布,DeepNude 将不再出售,之后也不会推出新版本。该团队还警告称不要在网上分享这款应用,否则会违反相关服务条款。但是,他们也承认,「肯定会有一些副本流出」。

DeepNude APP 的开发者发出公告表示传播深度学习处理过的图片并不是开发软件的本意,而那些付费购买但还没来得及升级的用户将会收到退款。

DeepNude 团队在宣布下架该 APP 的公告结尾称「这个世界还没有做好接受 DeepNude 的准备,总有一天,这款 APP 可以得到适当的使用。」

就这样,DeepNude 的闹剧结束了。

争议不断的 Deepfake 技术

Deepfake 的名称源自一位名叫「Deepfakes」的 reddit 用户,这个名字其实是「deep machine learning」和「fake photo」的缩写,是利用深度学习等 AI 技术合成虚假视频、照片等技术的统称。

该技术开始时主要应用于换脸,如我们熟悉的将《射雕英雄传》中朱茵的脸换成杨幂、将雷神、海王换脸为「金毛狮王」徐锦江等。

当然,还有很多人将其应用于制作成人视频或者名人的虚假视频。这些合成内容传到网上之后很难删除,给女性等群体造成了很大困扰。

另外,由于该技术有扰乱政坛、影响大选的可能,美国政府还专门提出了法案打击 deepfake 技术。

除了政策层面,有很多技术手段也可以帮助我们识别这些假视频、假照片。自 deepfake 技术出现以来,研究者已经开发了一些可以检测这些造假技术的算法,而且准确率也不断提高。但仅仅靠这些算法还是远远不够的……

检测算法作用有限

虽然现在已有检测 deepfake 的算法,其准确率能够达到 90% 以上。但光靠这些算法和软件还不够,它们只能解决部分问题。毕竟,deepfake 技术不断发展,哪怕检测算法再先进,也抵挡不了那些满怀恶意的人。说得难听点,只有千日做贼没有千日防贼的。

专家认为,就像电脑病毒或生化武器一样,来自 deepfake 的威胁已经成为了一个永久特征。虽然从政治角度来看,deepfake 是否会成为巨大的危险还存在争议,但它已经在损害女性的生活了。比如之前给情色视频主人公换脸的技术,以及现在给女性照片「一键脱衣」的 APP。

计算机视觉专家、南加州大学副教授 Hao Li 表示,任何 deepfake 检测器只能短暂地起作用。实际上,它们在某些时候根本不可能发现「AI fakes」。因此,需要采取不同类型的方法来解决这类问题。

Hao Li 所在的团队最近就设计了一种 deepfake 检测器。他和同事构建了一种能够发现 AI 对视频进行过编辑的算法,算法通过追踪每个人特有的面部微表情来做到这一点。

这些标记(微表情)被称为「软生物特征」,它们对 AI 来说太微妙了,目前还无法模仿。这些特征包括特朗普在回答问题前如何紧闭双唇,沃伦如何扬眉来强调某个观点。算法通过研究个人过去的镜头来学习识别这些动作,结果就是它能够在几种不同类型的 deepfake 方面达到至少 92% 的识别准确率。

不过,Li 表示这项技术可能没多久就没用了。因为 deepfake 技术也在不断发展,就像不断进化的病毒一样。

人工智能基金会(AI Foundation)的研究副总裁 Delip Rao 也表示,挑战远不止简单的检测。

例如,上周公布的 deepfake 检测算法据说可以达到 97% 的准确率(参见论文《Recurrent Convolutional Strategies for Face Manipulation Detection in Videos》)。但正如 Rao 所指出的,考虑到互联网平台的规模,这剩下的 3% 仍然具有破坏性。

「假设 Facebook 部署了这一算法,再假设 Facebook 每天要处理 3.5 亿张图像,即使是 3% 的错误率仍然会导致大量错误识别图像被放出,」Rao 表示。「来自模型的每个假阳性结果都是对用户信任的挑战。」

Rao 表示,开发可以识别假照片和视频的技术非常重要,但更大的挑战在于提高这些方法的有用性。社交平台还没有出台打击 deepfake 的明确政策,例如上周,Facebook 就决定保留其平台上的扎克伯格造假视频。全面禁止 deepfake 技术是不明智的。

Li 表示,「如果检测到人工修改内容,至少应该基于自动系统给视频打上标签。」不过,他还说道,假视频、照片被发现只是时间问题,「说到底,视频也只是像素的集合而已。」

Rao 和他 AI Foundation 的同事正致力于开发一种结合人类判断的方法,但其他人表示,比起识别虚假视频,他们认为验证真实的视频和图像才应该是起点。

参考内容:

https://www.vice.com/en_us/article/kzm59x/deepnude-app-creates-fake-nudes-of-any-woman

https://www.theverge.com/2019/6/27/18715235/deepfake-detection-ai-algorithms-accuracy-will-they-ever-work

https://mp.weixin.qq.com/s/DpGgK-c9u9xkesCTlBtdpA

市北·GMIS 2019全球数据智能峰会于7月19日-20日在上海市静安区举行。本次峰会以「数据智能」为主题,聚焦最前沿研究方向,同时更加关注数据智能经济及其产业生态的发展情况,为技术从研究走向落地提供借鉴。

本次峰会设置主旨演讲、主题演讲、AI画展、「AI00」数据智能榜单发布、闭门晚宴等环节,已确认出席嘉宾如下:

大会早鸟票已开售,我们也为广大学生用户准备了最高优惠的学生票,点击阅读原文即刻报名。